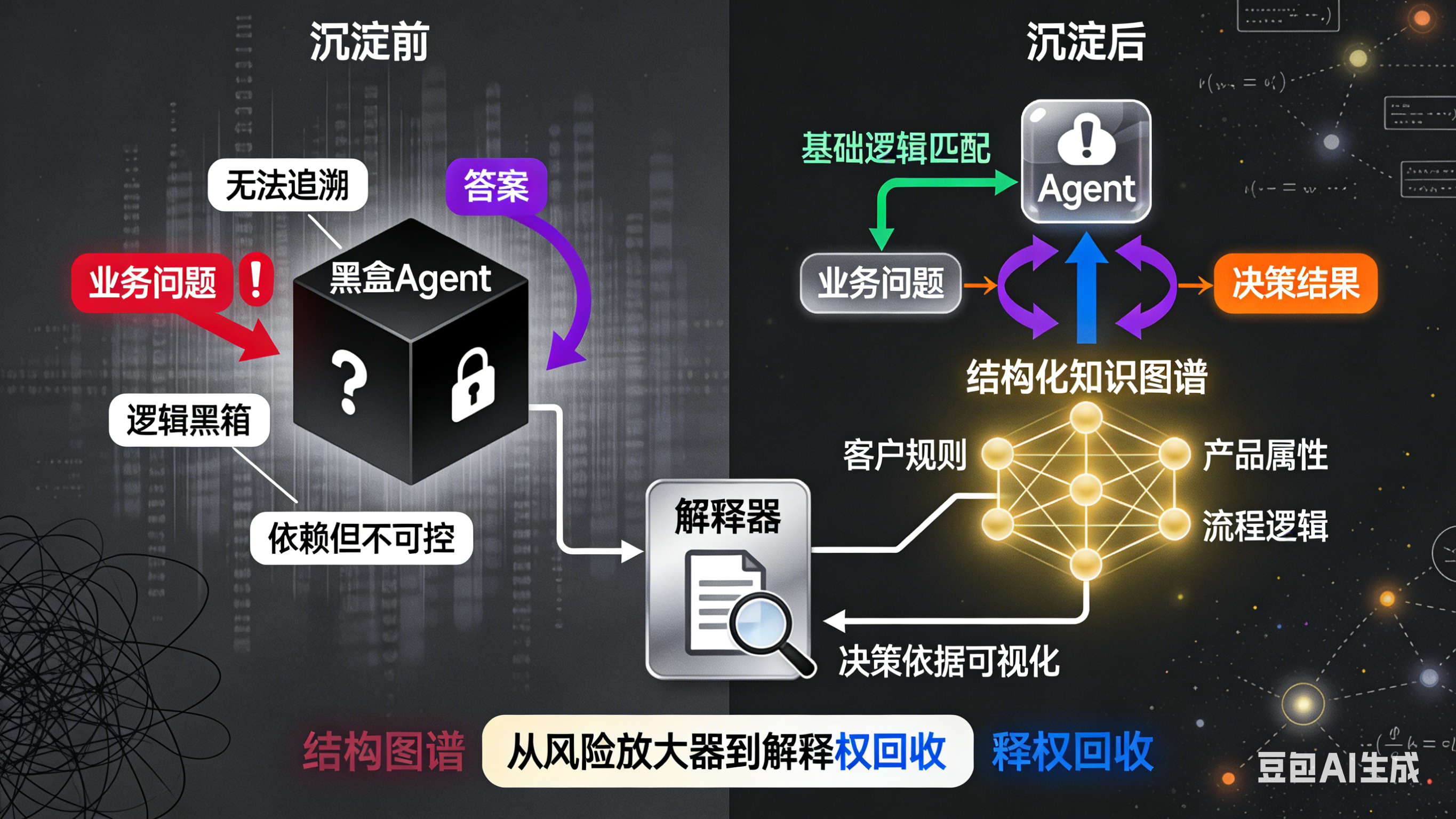

从智能体中抽取“业务知识图谱”:将其在大量对话中识别出的实体、关系与规则,反向沉淀为企业的结构化知识资产

摘要: 随着AI智能体(Agent)在实际业务中的广泛应用,其核心问题已从模型能力转向系统能否有效继承Agent积累的业务知识。当前困境在于:Agent在运行中不断“学习”业务逻辑,但系统却无法理解和沉淀这些知识,导致业务认知被“白白消耗”。传统知识图谱建设难以覆盖动态业务场景,而Agent可作为新型“知识来源”,通过结构化抽取高频实体、稳定规则等关键信息,反向构建可回溯、可验证的知识资产。这一过

我现在越来越清楚地意识到一件事:Agent 真正跑起来之后,最稀缺的东西,已经不是模型能力了。而是——系统是否还能理解、接管并继承它正在“学会”的东西。

在很多项目里,智能体每天处理成百上千次真实业务对话,识别概念、判断条件、选择路径、规避风险。它在“理解业务”,但企业本身,却并没有因此变得更懂自己的业务。这不是技术瓶颈,而是系统设计的问题。

一、Agent 跑得越久,系统反而越“失忆”

这是一个工程里非常普遍的现象。一开始,Agent 上线时:

-

Prompt 是新的

-

规则是新的

-

业务逻辑大家还记得

系统还能解释每一次行为。但三个月之后,你会慢慢发现:

-

Agent 的判断越来越“像个人”

-

行为路径越来越多

-

对话效果看起来不错

可一旦出问题:

-

你说不清它为什么这么判断

-

你也不知道这个判断是不是稳定的

-

更不知道这是不是已经变成系统依赖的一部分

于是系统进入一种很危险的状态:Agent 在积累经验,但系统在不断遗忘。遗忘规则从哪里来,遗忘哪些判断是高频的,遗忘哪些逻辑已经在事实中被反复验证。

二、我们其实在“白白消耗”大量业务认知

站在工程角度看,Agent 在对话中做的事情并不神秘。它无非是在反复完成几类动作:

-

识别业务实体(客户、订单、状态、资源、权限)

-

建立实体关系(依赖、约束、因果、优先级)

-

应用隐含规则(如果 A 且 B,则 C)

-

在不完整信息下做权衡决策

这些,本质上都是业务知识。区别只在于:以前是人脑在跑,现在是模型在跑。

但现在的问题是:这些知识,只被“用掉了”,却没有被“留下来”。每一次对话,其实都在为企业付出真实成本:用户时间、业务风险、决策责任。但最后沉淀下来的,往往只有一堆不可复用的对话日志。从系统角度看,这是极其浪费的。

三、反过来看待“知识图谱”

传统的业务知识图谱建设,大多是自上而下的:

-

先访谈专家

-

再整理文档

-

再建模

-

最后接系统

这种方式不是错,但在真实业务里,它有两个天然问题:

-

永远慢于业务变化

-

很难覆盖真实边界情况

而Agent的出现,实际上改变了一件非常关键的事情:业务知识,已经在“使用侧”被大规模验证过了。不是专家假设的,不是流程图里的,而是:

-

在真实对话中被反复触发

-

在真实异常中被迫使用

-

在真实结果中被验证或否定

从这一刻开始,我的视角发生了变化:Agent 更适合被当成“知识来源”,而不是单纯的“知识使用者”。

四、真正困难的不是“抽取”,而是“负责”

从技术角度讲:

-

抽实体

-

抽关系

-

抽规则

本身并不难。难的是另一件事:你敢不敢为这些被抽取出来的知识负责。在工程实践中,我越来越明确几个边界。

1. 不是所有“说过的话”,都配进入知识资产

Agent 生成了很多内容,但真正值得沉淀的,只是一小部分:

-

多次出现的稳定实体

-

在不同上下文中复现的判断逻辑

-

被结果反复验证过的规则路径

而不是:

-

即兴兜底话术

-

临时猜测

-

强依赖上下文的推断

知识图谱不是记忆系统,而是责任系统。一旦你把某个规则沉淀进去,系统就必须为它的存在负责。

2. 模型不能为“正确性”兜底

这是很多团队会踩的坑。模型可以提出候选认知,但它不能成为认知的最终裁判。在我认可的系统里,通常是:Agent 输出结构化候选实体 / 规则,然后系统做一致性和冲突检测,最后经过人或策略层做确认,才允许进入知识资产池。这一步很慢,但它决定了系统是否可长期运行。

3. 每一条知识,都必须允许“死亡”

这是最容易被忽略的部分。业务在变,规则必然会过期。所以我现在强制要求:

-

每条规则都有来源

-

都能看到命中频率

-

都有最近一次生效时间

-

都有失效评估策略

没有退出机制的知识沉淀,迟早会变成系统负债。

五、从Agent反向沉淀知识,本质是系统升级

当你真正开始做这件事,会发现一个很有意思的现象:很多所谓的“业务复杂”,并不是业务本身复杂。而是:

-

概念从未被统一定义

-

规则长期靠人脑补

-

冲突被经验默默吞掉

Agent 只是把这些问题暴露得更早、更明显。在这个过程中,它更像是一个:高频运行的业务探针。它不断撞上边界,不断触发例外,不断逼迫系统回答:

-

这个概念到底算不算?

-

这个条件到底优先级更高吗?

-

这个判断是不是稳定的?

而“反向抽取业务知识图谱”,真正做的事情是:把这些原本散落在对话中的认知,收回到系统层。

六、新的工作方式

这不是标准答案,只是我目前踩坑最少的一种做法。

-

先让 Agent 正常跑真实业务

-

不急着“建图谱”,只记录结构化行为

-

关注高频出现的实体与判断路径

-

对重复模式做离线分析

-

只把稳定结构作为候选知识

-

经系统或人确认后再沉淀

整个过程的关键词只有一个:可回溯。能知道它从哪里来,也能随时把它撤回去。

七、这件事真正的价值,不在 AI,而在工程

如果你做过复杂系统,你会知道:系统最怕的不是不够聪明,而是不知道自己在依赖什么。Agent 如果只是一个越来越聪明的黑盒,那它对企业来说,只会变成:风险放大器、成本累积器。而当你开始从 Agent 中反向沉淀业务知识,你做的其实是另一件事:把业务解释权拿回系统、把隐性经验变成显性结构、让系统在没有模型“灵感”时仍然能运转。

我越来越确信:Agent 的价值,不在于替代人思考,而在于逼迫系统把思考结构化。这也是为什么我始终坚持:AI 必须是生产力,而生产力,必须被工程接管。从智能体中抽取业务知识图谱,不是为了让 AI 更像人,而是为了让系统终于像一个系统。

更多推荐

已为社区贡献100条内容

已为社区贡献100条内容

所有评论(0)