机器学习038:强化学习【近端策略优化PPO】 -- 从“训狗”到“玩游戏”

PPO是一位“稳健的革新者”,它让AI智能体能够既大胆探索新策略,又稳健地优化现有能力,在复杂任务中实现高效学习。

今天我们要聊一个特别有趣且实用的技术——近端策略优化,英文简称PPO。

想象一下,你在训练一只可爱的狗狗学会新技能。一开始,狗狗可能完全不懂你的指令,但通过不断尝试和奖励,它慢慢学会了坐下、握手。PPO就像是一个智能的“训狗大师”,但它训练的不是真实的狗狗,而是我们的人工智能“智能体”,让它们学会在虚拟世界中完成任务,比如玩游戏、控制机器人,甚至协助我们做决策。

现在,让我们一起走进PPO的世界,看看这个聪明的“教练”是如何工作的!

一、PPO的分类归属:它是什么来头?

它是哪一类神经网络?

首先,我们要明确PPO在人工智能大家庭中的位置。

从功能用途来看,PPO属于强化学习算法。什么是强化学习?简单来说,就像教小孩学走路:小孩(智能体)通过尝试(行动),根据摔倒或走稳的反馈(奖励),调整自己的动作(策略),最终学会平稳行走。

从训练方式来看,PPO属于策略梯度方法的一种改进版本。你可以把它理解为“直接指导”型的教练:不告诉智能体每一步具体怎么走,而是指导它调整“行为风格”(策略),使其获得更多奖励。

作者、时间和背景

PPO由OpenAI的研究团队在2017年提出。当时,强化学习领域面临一个难题:如何让智能体既快速学习,又稳定进步?就像教学生,既要允许他大胆尝试,又不能让他养成难以纠正的坏习惯。

PPO就是为了解决这个“探索与稳定”的平衡问题而诞生的。它像一位既鼓励创新又注重基础的好老师,让智能体在学习过程中既敢于尝试新方法,又不会偏离正确方向太远。

二、底层原理:PPO是如何工作的?

核心类比:教你打篮球的智能教练

让我们用一个生动的比喻来理解PPO。

假设你正在学习打篮球,教练(PPO算法)要教你如何投篮。教练不会每次都手把手地教你每个动作,而是:

- 让你先尝试投篮(探索)

- 观察你的动作并打分(评估)

- 在“不过度改变”的前提下调整你的姿势(优化)

- 重复这个过程直到你成为投篮高手

这里的“不过度改变”就是PPO的核心思想:每次只对你的投篮姿势进行小幅调整,避免一下子改得太多让你无所适从。

核心设计:两个关键技巧

PPO有两个聪明的设计,让训练既高效又稳定:

1. 信任区域(Trust Region)

就像教练不会让你一下子完全改变投篮动作,PPO确保智能体每次更新策略时,新策略和旧策略不会相差太大。这样可以避免“学坏”或“忘记已学会的技能”。

2. 裁剪(Clipping)机制

这是PPO最巧妙的设计!想象一下教练给你的动作调整建议有一个“安全范围”,超出这个范围的建议会被“裁剪”掉。这确保了更新不会过于激进。

通俗版工作流程

让我们把这个过程说得更具体些:

-

观察与尝试:智能体在环境中行动(比如玩游戏),记录下“在什么情况下,做了什么动作,得到了什么奖励”

-

评估表现:算法计算每个动作的“性价比”——这个动作带来的长期回报有多好?

-

温和调整:PPO像细心的园丁修剪树枝,只对策略进行小幅优化。如果某个改进看起来“太好了,好得不真实”,它会被谨慎对待。

-

重复优化:不断重复上述过程,策略越来越优秀

公式背后的直观理解

虽然我们尽量避免复杂公式,但了解PPO的核心公式能帮助你更深入理解:

新策略 ≈ 旧策略 + 适度调整 × (动作的“性价比”)

这里的“适度调整”就是PPO的精髓:调整幅度被限制在一个安全范围内。数学上,PPO通过一个巧妙的裁剪函数实现这一点,确保更新不会破坏已经学到的好策略。

三、局限性:PPO不是万能的

就像任何工具都有适用场景一样,PPO也有它的局限性。了解这些能帮助我们更好地使用它。

1. 需要大量的“练习机会”

PPO需要智能体与环境进行大量交互来学习。就像篮球运动员需要成千上万次的投篮练习,PPO训练的智能体也需要大量的“尝试-反馈”循环。

为什么有这个局限? 因为PPO通过实际尝试来学习,不像有些方法可以通过观察别人来学习(模仿学习)。每一次策略更新都需要新的数据,这可能需要很长时间。

2. 对奖励设计很敏感

PPO的表现高度依赖“奖励函数”的设计——也就是我们如何告诉智能体什么行为是好的。

想象一下,如果你教孩子整理房间,只说“做得好”但不具体说明哪里做得好,孩子可能不知道重点是什么。同样,如果奖励设计不合理,PPO可能会学到一些我们不希望的行为。

3. 在某些任务上可能不是最优选择

对于特别简单或者特别复杂的任务,可能有比PPO更合适的算法:

- 简单任务:如果环境很简单,用更简单的算法可能更快

- 需要精确模仿的任务:如果已经有大量专家示范,模仿学习可能更有效

- 安全性要求极高的任务:PPO在训练初期会进行随机探索,这在某些危险环境中是不可接受的

四、使用范围:PPO擅长解决什么问题?

了解了PPO的能力和局限后,我们来看看它最适合在哪些场景中大显身手。

适合使用PPO的场景:

-

连续决策问题:需要做一系列决定才能达到目标的任务

- 例如:游戏通关、机器人控制、自动驾驶决策

-

环境可模拟的任务:可以在计算机中快速模拟的环境

- 例如:视频游戏、物理仿真、虚拟训练环境

-

中等复杂度的控制问题:既不太简单也不太复杂的任务

- 例如:机械臂控制、无人机飞行、能源管理系统优化

不适合使用PPO的场景:

-

数据收集困难或昂贵的环境

- 例如:真实的机器人实验(每次尝试都可能损坏设备)、医疗决策(涉及患者安全)

-

需要精确模仿人类专家的任务

- 例如:转录手写文字、复制艺术风格(这类任务更适合监督学习)

-

即时响应的简单任务

- 例如:图像分类、语音识别(这些有更专门、更高效的算法)

五、应用场景:PPO在现实世界中的精彩表现

现在,让我们看看PPO在现实生活中是如何发挥作用的!

案例1:智能游戏玩家

场景:训练AI玩《星际争霸》《Dota 2》等复杂游戏

PPO的作用:PPO是OpenAI训练游戏AI的核心算法之一。它让AI智能体学会在复杂环境中做出长期规划,比如何时进攻、何时防守、如何分配资源。这些AI已经达到了超越人类顶尖选手的水平!

简单理解:PPO就像是游戏AI的“战术教练”,通过无数次的自我对弈,逐渐发现制胜策略。

案例2:机器人灵活控制

场景:让机器人学会行走、抓取物体等复杂动作

PPO的作用:研究人员使用PPO训练机器人完成各种灵巧任务。在仿真环境中,PPO指导机器人尝试不同的动作组合,找到最稳定、最高效的运动方式,然后应用到真实机器人上。

简单理解:PPO是机器人的“动作指导师”,帮助它们从“笨拙的新手”变成“灵活的高手”。

案例3:个性化推荐系统

场景:视频平台(如YouTube、Netflix)的内容推荐

PPO的作用:PPO可以帮助优化推荐策略,不仅考虑用户当前的点击,还考虑长期观看满意度。比如,不一定推荐你立刻会点击的“标题党”视频,而是推荐那些能让你长期留在平台的优质内容。

简单理解:PPO是推荐系统的“长期策略顾问”,平衡即时满足和长期用户黏性。

案例4:自动驾驶决策

场景:自动驾驶汽车在复杂路况下的决策

PPO的作用:在模拟环境中,PPO可以训练自动驾驶系统做出安全高效的决策,如超车时机、路口通过策略等。它学习在各种情况下平衡安全性、舒适性和效率。

简单理解:PPO是自动驾驶的“虚拟驾校教练”,在无数模拟场景中培养车辆的“驾驶直觉”。

案例5:能源管理系统

场景:智能电网、数据中心冷却系统的优化

PPO的作用:PPO可以学习如何根据需求预测调整能源分配,或优化冷却系统运行策略,在满足需求的同时最大限度地节约能源。

简单理解:PPO是能源系统的“智能调度员”,通过学习找到最优的运行节奏。

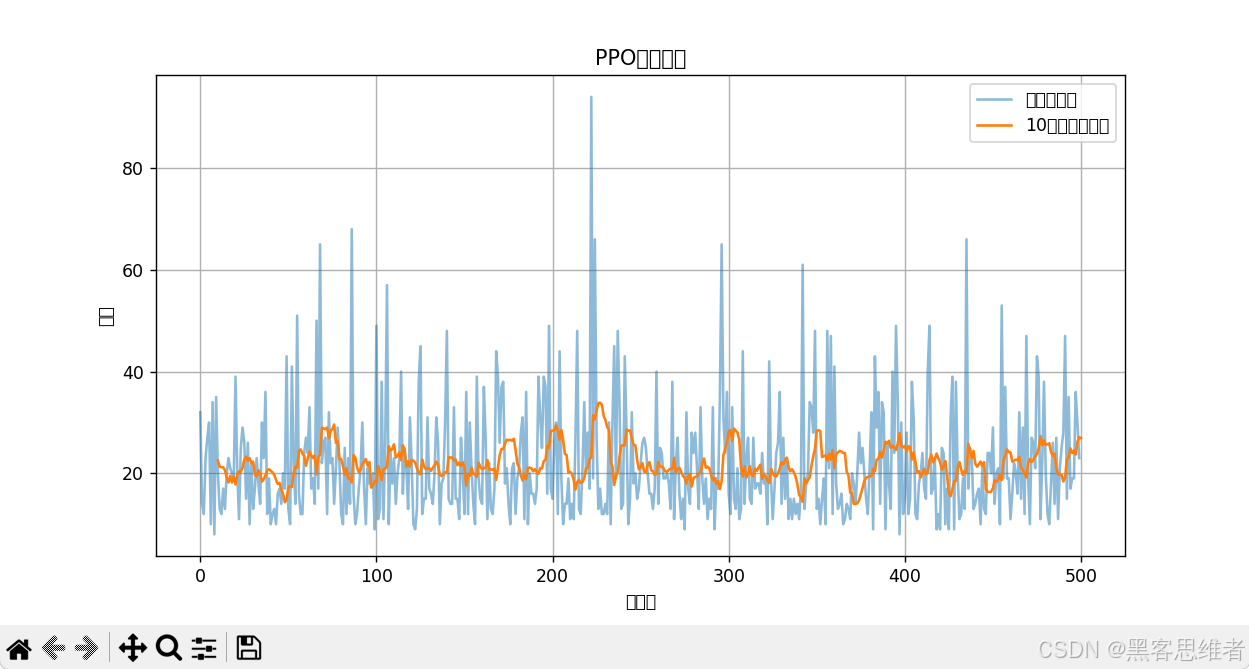

六、动手实践:用Python实现一个简单的PPO示例

理论说得再多,不如亲手试一试!下面是一个简化的PPO示例,用于训练一个智能体玩经典的“CartPole”游戏(平衡杆子)。

# 注:这是一个高度简化的教学示例,真实PPO实现更复杂

import gym

import numpy as np

class SimplePPOAgent:

def __init__(self, state_size, action_size):

# 初始化策略参数(这里极度简化,真实情况是神经网络)

self.policy_params = np.random.randn(state_size, action_size) * 0.1

def get_action(self, state):

# 根据当前策略选择动作

scores = np.dot(state, self.policy_params)

probabilities = np.exp(scores) / np.sum(np.exp(scores))

action = np.random.choice(len(probabilities), p=probabilities)

return action

def update_policy(self, states, actions, rewards):

# 简化的策略更新(真实PPO要复杂得多)

# 核心思想:增加带来高回报的动作的概率

for state, action, reward in zip(states, actions, rewards):

# 计算梯度(简化版)

scores = np.dot(state, self.policy_params)

probabilities = np.exp(scores) / np.sum(np.exp(scores))

# 策略梯度更新

for a in range(len(probabilities)):

if a == action:

# 增加这个动作的概率(如果回报是正的)

self.policy_params[:, a] += 0.01 * reward * state

else:

# 稍微降低其他动作的概率

self.policy_params[:, a] -= 0.01 * reward * state / (len(probabilities) - 1)

# PPO的关键:限制更新幅度(这里简化实现)

self.policy_params = np.clip(self.policy_params, -1.0, 1.0)

# 创建游戏环境

env = gym.make('CartPole-v1')

state_size = env.observation_space.shape[0]

action_size = env.action_space.n

# 创建PPO智能体

agent = SimplePPOAgent(state_size, action_size)

# 训练循环

for episode in range(100):

state = env.reset()

states, actions, rewards = [], [], []

# 收集一次游戏的数据

for step in range(200): # 最多200步

action = agent.get_action(state)

next_state, reward, done, _ = env.step(action)

states.append(state)

actions.append(action)

rewards.append(reward)

state = next_state

if done:

break

# 使用收集的数据更新策略

agent.update_policy(states, actions, rewards)

if episode % 10 == 0:

print(f"Episode {episode}, Steps: {len(states)}")

print("训练完成!")

env.close()

这个简化示例展示了PPO的核心思想:收集数据 → 评估动作 → 有限度地更新策略。真实的PPO实现会更复杂,但基本逻辑是一致的。

七、总结与思维导图

一句话总结PPO的核心价值:

PPO是一位“稳健的革新者”,它让AI智能体能够既大胆探索新策略,又稳健地优化现有能力,在复杂任务中实现高效学习。

PPO知识体系思维导图:

给初学者的学习建议:

如果你是第一次接触PPO,记住这三个关键点就够了:

- PPO是AI的“智慧教练”:它指导智能体学习复杂技能

- 核心是“稳健进步”:每次只做小幅调整,避免学习过程中的大起大落

- 擅长“虚拟训练”:在可模拟的环境中学习连续决策任务

学习PPO就像学习任何新技能一样,开始时可能觉得复杂,但一旦理解了它的核心思想——在探索与稳定之间找到平衡——你就会发现它的美妙之处。这个思想不仅适用于AI训练,也适用于我们个人的学习和成长。

更多推荐

已为社区贡献126条内容

已为社区贡献126条内容

所有评论(0)