测试用例设计的新挑战与LLM的机遇:从用户故事到边界用例的智能生成路径

摘要:本文探讨如何利用大语言模型(LLM)自动生成高质量边界测试用例,解决传统测试设计中依赖人工经验的瓶颈。通过结构化语义解析、渐进式追问和测试启发式方法,LLM可深度理解用户故事并识别潜在风险点。文章提出标准化Prompt模板和"AI提案+人工审核"的协同流程,同时指出当前面临的幻觉问题、专业领域依赖等挑战。未来趋势将结合知识图谱等技术,实现需求到测试用例的自动化映射,推动测

测试用例设计的新挑战与LLM的机遇

在敏捷开发与DevOps实践中,用户故事是承载业务需求的核心载体。然而,将一句简短的用户故事(如“作为一名用户,我希望能够通过手机号快速注册,以便立即使用服务”)转化为一套完整、精准,特别是能覆盖各种边界条件的测试用例,是一项极具挑战性的工作。它要求测试人员不仅理解功能本身,还要能预见到数据边界、异常流程、并发冲突等复杂场景。传统方法依赖脑力风暴和经验库,效率与完备性存在瓶颈。

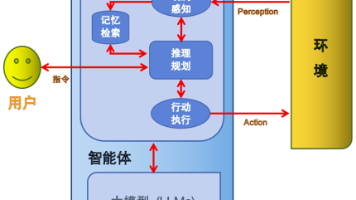

大语言模型的出现,为解决这一痛点带来了新的可能。LLM拥有强大的自然语言理解、逻辑推理和上下文生成能力。本文旨在探讨,如何系统地让LLM“读懂”用户故事,并基于此自动生成高质量的边界测试用例,为测试工程师赋能。

一、 基石:LLM如何进行测试场景的语义解析

要让AI生成用例,首先必须让它“理解”场景。LLM对测试场景的语义解析,并非简单的关键词匹配,而是一个结构化的深度理解过程。

要素提取与结构化:LLM首先会识别用户故事中的核心要素,并将其归纳为结构化的信息。这通常包括:

角色:谁在使用系统(如“注册用户”、“管理员”)。

操作/功能:要完成什么动作(如“注册”、“查询”、“支付”)。

业务对象:操作涉及哪些核心数据或实体(如“用户账户”、“订单”、“手机号”)。

约束条件/验收标准:通常隐含或附加在故事描述中(如“快速”、“通过手机号”、“成功后才能使用”)。

关系与流程建模:在提取要素的基础上,LLM能够根据通用业务逻辑和训练语料中的知识,构建要素之间的关系模型和操作流程。例如,从“注册”这一动作,可以关联出“输入信息”、“提交验证”、“接收反馈”、“状态变更”等一系列子步骤及其先后逻辑。

上下文与领域知识融合:一个优秀的解析过程不能脱离具体的业务领域。通过为LLM提供领域术语表、业务规则文档或历史测试用例作为上下文,可以显著提升其解析的准确性和专业性,使其理解“支付”在电商场景和金融场景下的不同边界。

二、 核心:让AI深度“读懂”用户故事的方法论

仅仅结构化解构还不够,深度“读懂”意味着洞见潜在的风险点和变异空间。这需要设计特定的Prompt工程与交互策略。

渐进式追问与澄清:模仿资深测试人员的思考方式,可以引导LLM对模糊的用户故事进行自我追问。例如,面对“快速注册”,我们可以设计Prompt让LLM主动思考并回答:“‘快速’可能意味着哪些技术或体验指标?(如页面加载时间、步骤简化)”、“‘手机号注册’可能存在哪些国家/地区代码、格式、实名制验证的变体?”。

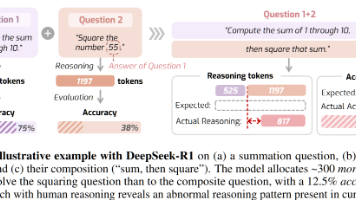

基于测试启发式的语义增强:将经典的测试设计方法(如边界值分析、等价类划分、决策表、状态迁移)融入Prompt指令。例如,指令可以是:“请对‘用户年龄需在18岁以上’这一条件,运用边界值分析法,列出所有需要测试的边界输入。” LLM便能据此生成17, 18, 19,以及可能的大边界值(如150)等用例。

异常流与负面场景推导:这是生成边界用例的关键。明确要求LLM不仅考虑“阳光路径”,更要专注于“可能出错的路径”。Prompt可以是:“假设网络中断、数据库连接失败、输入非法字符、并发重复提交等情况发生,请描述在上述注册故事中可能出现的异常现象及系统的预期行为。”

多角色视角冲突分析:引导LLM从不同系统角色(前端、后端、数据库、第三方服务)的视角审视同一个用户故事,识别因视角差异可能产生的理解不一致和接口边界问题,从而生成集成和系统层面的边界用例。

三、 目标:自动化生成高质量边界用例的实践路径

在实现深度语义解析的基础上,生成边界用例便可按标准化流程推进。

1.输入与上下文准备:

输入:清晰、标准的用户故事描述,最好包含明确的验收标准。

上下文:提供业务领域 glossary、系统架构图(简述)、相关业务规则等作为参考信息,注入LLM上下文窗口。

2.标准化Prompt模板设计:构建一个可复用的Prompt模板,模板包含以下部分:

角色:你是一名经验丰富的软件测试架构师。

任务:基于给定的用户故事,生成一组合适的边界值测试用例。

步骤:

a. 解析:请首先解析以下用户故事,提取角色、功能、主要业务对象和约束条件。

b. 分析:基于以上解析,运用边界值分析、等价类划分等测试技术,识别出所有关键的输入、输出、状态边界。

c. 生成:为每一个识别出的边界,生成一个具体的测试用例。用例格式应包括:用例ID、测试标题、前置条件、测试步骤、输入数据、预期结果、是否为边界用例(是/否)及简要说明。

用户故事:【在此插入具体的用户故事】

3.迭代优化与评审:LLM生成的初版用例,必须由测试工程师进行评审和确认。这是一个“AI提案,人决策”的协同过程。工程师可以:

修正:纠正AI基于过时或不准确知识生成的用例。

补充:加入AI未能考虑到的、高度依赖具体系统实现的特殊边界。

优化:调整用例的描述,使其更符合内部测试用例管理规范。

将评审反馈作为新的学习样本,可以持续优化Prompt,形成闭环。

4.集成至测试工作流:将上述能力封装成工具或插件,集成到需求管理平台(如Jira)或测试管理平台中。当产品经理或业务分析师完成一个用户故事的编写后,测试工程师可以一键触发“边界用例生成”功能,快速获得一份高质量的测试用例草稿,大幅提升需求到测试用例的转换效率。

四、 潜在挑战与未来展望

尽管前景广阔,但当前实践仍需正视以下挑战:

LLM的“幻觉”与不确定性:LLM可能生成看似合理但实际错误的用例。人工审核环节不可或缺。

领域专业知识依赖:在专业度极高的领域(如航天软件、医疗设备),LLM需要大量高质量的领域语料进行微调或提供上下文,才能保证解析的专业性。

测试Oracle问题:LLM可以生成“输入”和“操作”,但对于复杂场景下的“预期结果”,尤其是涉及多系统交互的精确状态,其判断能力仍有局限,通常需要结合业务规则库或模型检查技术。

展望未来,结合LLM与知识图谱、形式化方法,构建“需求-测试用例”的精准、自动化映射链路,将是测试智能化演进的重要方向。测试工程师的角色将逐渐从重复性的用例编写中解放出来,更聚焦于测试策略制定、复杂缺陷根因分析以及AI测试工具本身的评估与优化,实现人机协同的更高

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)