大数据领域数据服务:实现数据的全面分析与洞察

而另一家医疗企业的数据工程师更直白:“每天处理PB级数据,但业务部门抱怨分析报表永远落后一周,关键指标无法实时看到。(图示:基础设施层(数据源) -> 数据处理层(ETL,计算) -> 服务抽象层(API网关/查询引擎) -> 统一接入层(API/SQL/UI) -> 应用消费层(BI/APP/AI))当数据如同电力一样畅通无阻地为组织的每个“神经元”提供能量时,真正的数据智能时代便将到来。在数字

大数据领域数据服务:构建数据价值链,驱动全面分析与深度洞察

“我们拥有海量的用户行为数据、交易日志和IoT传感器信息,却依然感觉在‘摸黑决策’。” —— 这是某大型电商平台CTO的深刻困惑。而另一家医疗企业的数据工程师更直白:“每天处理PB级数据,但业务部门抱怨分析报表永远落后一周,关键指标无法实时看到。”

一、 引言:从数据孤岛到价值金矿的核心桥梁

在数字化转型的浪潮中,“数据是新时代的石油”已成共识。然而,真正困扰企业的是:如何将原始的、“粘稠的”数据原油,高效精炼成驱动业务增长的“高辛烷值燃料”?大数据技术栈(Hadoop、Spark、Flink、Kafka等)解决了数据“存得了”和“算得快”的问题,而数据服务(Data Services)则致力于解决“用得好”和“价值显”的核心痛点。

传统模式下常见问题:

- 分析延迟: 关键决策需要等待T+1甚至更久的报表。

- 数据烟囱: 数据分散在不同系统,难以形成统一视图。

- 使用门槛高: 分析师、业务人员难以直接利用原始数据或复杂ETL结果。

- 性能瓶颈: 高并发分析查询压垮生产数据库。

- 安全与治理缺失: 数据访问混乱,难以追溯与审计。

数据服务的核心使命正是解决这些问题。它是在大数据基础设施之上构建的一套可复用、可组合、可管理的数据能力抽象层。其目标是让数据在安全、可控的前提下,像水一样自然流淌到每一个需要它的业务场景、分析工具和决策者手中,支撑实时监控、深度分析、精准预测和智能决策。

通过阅读本文,你将收获:

- 透彻理解数据服务的核心概念、架构模式与核心组件。

- 掌握构建统一数据服务层的关键步骤与技术选型(包括API网关、查询引擎、实时服务等)。

- 学习如何通过数据服务提升数据分析时效性(实时化)与用户体验(自助化)。

- 规避数据服务建设中的常见陷阱(性能、安全、治理)。

- 了解前沿趋势(Data Mesh, Data Fabric, Lakehouse)如何重塑数据服务架构。

二、 基础篇:数据服务的核心概念与定位

在深入技术细节之前,厘清相关概念和定位至关重要。

-

数据服务 vs. 数据平台 vs. 数据仓库/湖:

- 数据平台: 泛指提供数据存储、计算、处理等基础能力的底层设施(如Hadoop YARN集群、Kafka集群、Spark/Flink计算引擎)。

- 数据仓库/湖: 是数据平台的逻辑存储层,负责结构化/半结构化/非结构化数据的集中存储和管理(DWH通常结构严谨,Data Lake更灵活)。

- 数据服务: 构建在数据平台和数据仓库/湖之上的应用层。它不存储数据本身,而是提供访问、操作、组合和交付数据的标准化接口(API)和能力。它屏蔽底层复杂性,向上层应用和分析提供统一、便捷、安全的入口。

- 类比: 数据平台/仓库/湖是发电厂(产生原始能源),数据服务是国家电网(负责高效、安全、标准化地配送能源到千家万户的插座)。

-

核心价值主张:

- 降低数据消费门槛: 通过API、SQL接口、可视化工具,让非核心开发人员也能高效消费数据。

- 提高数据时效性与可用性: 支持实时/准实时数据访问,打破批处理延迟。

- 保障数据安全与合规: 集中管理访问控制、脱敏、审计追踪。

- 提升开发效率与复用性: 统一接口定义,避免重复开发数据访问逻辑。

- 优化数据资产治理: 明确数据血缘、服务契约、生命周期。

-

数据服务的核心用户群体:

- 数据分析师/科学家: 通过SQL接口、API或可视化工具获取数据进行分析建模。

- 业务应用开发: 调用数据API为前端应用(如CRM、ERP、BI看板)提供数据支撑。

- 自动化系统(如AI/ML模型): 持续消费实时或批量数据进行推断。

- 数据工程师: 使用服务编排复杂数据流任务。

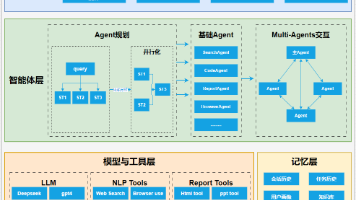

三、 核心架构篇:构建统一、高效的数据服务层

一个强大的数据服务层需要精心设计和构建。其核心架构通常采用分层模式:

![数据服务核心架构分层图]

(图示:基础设施层(数据源) -> 数据处理层(ETL,计算) -> 服务抽象层(API网关/查询引擎) -> 统一接入层(API/SQL/UI) -> 应用消费层(BI/APP/AI))

(一) 服务抽象层:技术实现的基石

-

数据API服务:数据的标准化输出管道

- 架构模型:

RESTful API(主流):通用性强,易集成,如GET /api/v1/sales?startDate=...&endDate=...。GraphQL API(新兴):强大灵活,一次请求获取所需复杂关系数据。gRPC API(高性能需求):适合内部微服务间高效通信。

- 核心组件与技术栈:

- API Gateway:统一入口(如

Kong,Apache APISIX,Amazon API Gateway),处理认证、限流、日志、路由等。 - 业务逻辑服务:执行数据处理逻辑(Java/Go/Python微服务,部署在K8s或Serverless)。

- ORM/查询代理:与底层数据存储交互(SQLAlchemy, Hibernate, MyBatis)。

- API Gateway:统一入口(如

- 代码示例(Python Flask REST API获取销售数据):

from flask import Flask, request, jsonify from your_data_service_layer import get_sales_data app = Flask(__name__) @app.route('/api/v1/sales', methods=['GET']) def get_sales(): start_date = request.args.get('startDate', '2023-01-01') end_date = request.args.get('endDate', '2023-01-31') region = request.args.get('region', None) # 可选过滤条件 # 调用底层服务逻辑,可能涉及查询DW或数据湖 sales_data = get_sales_data(start_date, end_date, region) # 可选:数据格式转换、字段映射、脱敏 return jsonify({'data': sales_data}), 200 if __name__ == '__main__': app.run(port=5000) - 关键实践: 版本管理(

/v1/),清晰的API文档(Swagger/OpenAPI),接口标准化(JSON Schema),客户端SDK生成。

- 架构模型:

-

SQL查询服务:分析师最爱的直通桥梁

- 目的: 为熟悉SQL的用户提供直接查询语义层的能力。

- 核心引擎:

- 统一SQL层:

Presto/Trino(跨异构源联合查询神器),Apache Spark SQL(强大计算引擎)。 - 数据虚拟化层:

Denodo(领先商用),Dremio(Lakehouse架构代表),AtScale。

- 统一SQL层:

- 技术亮点:

- 虚拟数据集市 (Virtual Mart): 定义逻辑表,隐藏底层复杂性(分区、格式、位置)。

- 下推优化: 引擎尽可能将计算逻辑推送到底层存储引擎执行。

- 结果缓存: 提高重复查询性能(如

Alluxio)。

- 配置示例(在Trino中定义Hive和MySQL数据源并创建视图):

-- 在Hive catalog中创建数据源 CREATE SCHEMA hive.demo WITH (location='s3a://data-lake/demo/'); CREATE TABLE hive.demo.orders (...); CREATE TABLE hive.demo.customers (...); -- 在MySQL catalog中创建数据源 CREATE SCHEMA mysql.erp WITH (connection_url='jdbc:mysql://mysql-host:3306/erp'); CREATE TABLE mysql.erp.products (...); -- 创建虚拟视图 (SalesSummary) CREATE VIEW demo.sales_summary AS SELECT c.name, p.product_name, o.order_date, o.quantity, o.price FROM hive.demo.orders o JOIN mysql.erp.products p ON o.product_id = p.id JOIN hive.demo.customers c ON o.customer_id = c.id; - 关键实践: 严格权限控制(库/表/行列级),资源队列管理(避免大查询阻塞),连接池优化。

-

实时数据推送服务:数据流动的脉搏

- 场景: 实时监控大屏、用户行为实时推荐、风险欺诈实时识别。

- 核心技术:

- 流处理引擎:

Apache Kafka(核心消息总线),Apache Flink(主力计算引擎),Kafka Streams(轻量级),ksqlDB(流式SQL)。 - 数据同步:

Debezium(基于CDC的变更数据捕获),Maxwell。 - 推送协议:

WebSocket(全双工实时通道),Server-Sent Events (SSE)(服务器到客户端单向流)。

- 流处理引擎:

- 架构模式:

- 模式一 (数据变更推送): DB (binlog) ->

Debezium->Kafka->流处理计算->API/Push服务-> Web端/App端。 - 模式二 (复杂事件处理): IoT设备数据 ->

MQTT Broker->Kafka->Flink(CEP规则计算) -> 触发告警API。

- 模式一 (数据变更推送): DB (binlog) ->

- 代码示例(Flink实时处理Kafka用户点击事件并计算UV写入ES):

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); // 从Kafka topic读取点击流 DataStream<UserClickEvent> clicks = env.addSource(new FlinkKafkaConsumer<>( "user-clicks", new JSONDeserializationSchema(), properties)); // 处理逻辑:开窗1小时,计算独立用户数(UV) DataStream<HourlyUV> uvStream = clicks .keyBy(ClickEvent::getEventType) .window(TumblingEventTimeWindows.of(Time.hours(1))) .aggregate(new CountDistinctAggregate()); // 写入Elasticsearch供可视化或API查询 uvStream.addSink(new ElasticsearchSink.Builder<HourlyUV>(...).build()); env.execute("Realtime UV Calculation");

(二) 统一接入层:用户触点与交互入口

-

自助服务门户:数据消费的“应用商店”

- 目标: 为内部用户提供一个发现、理解、申请和使用数据服务的中心化平台。

- 功能组件:

- 数据目录: 搜索数据集,查看元数据(描述、schema、血缘、SLA)。

- 服务市场: 浏览和订阅可用的API、SQL视图、推送服务。

- 在线查询/探索平台: 集成

Trino/Presto Web UI,Jupyter Notebook。 - 使用申请与审批流: 管理权限申请。

- 使用文档与示例: 降低上手门槛。

- (可选) SDK自动生成与下载: 为不同语言自动生成客户端代码。

-

API网关:安全、流量与策略的守门人

- 核心职责:

- 统一接入: 所有数据API的唯一入口点。

- 认证与授权 (AuthN/AuthZ): 支持OAuth2.0/JWT/API Key等多种认证方式。

- 速率限制 (Rate Limiting): 防止单个用户或IP过度消耗资源。

- 请求转换: 协议转换、数据格式转换。

- API编排/聚合: 组合多个下游微服务调用。

- 日志与监控: 记录详细访问日志供审计与分析。

- 典型选型对比:

特性 Kong APISIX (Apache) Amazon API Gateway 部署模式 On-Prem/Cloud On-Prem/Cloud AWS Only 核心语言 Lua/Nginx Lua/Nginx Managed Service 插件生态 极其丰富 迅速增长 AWS原生集成 性能 极高 极高 高(按需扩展) 成本模型 社区版免费/企业版收费 完全开源 按调用量计费 - 配置示例(Kong配置一个API并添加Key-Auth插件):

# 创建一个名为'sales-api'的服务 (指向底层API微服务) curl -i -X POST http://kong:8001/services \ -d 'name=sales-api' -d 'url=http://sales-service:5000' # 为该服务创建一个路由(任何访问/kong路径的请求都路由到sales-api) curl -i -X POST http://kong:8001/services/sales-api/routes \ -d 'paths[]=/kong' # 启用Key-Auth插件保护该路由 curl -i -X POST http://kong:8001/routes/{route-id}/plugins \ -d 'name=key-auth'

- 核心职责:

(三) 数据处理与加速层:服务性能的引擎

-

高性能存储选择与优化:

- OLAP引擎:

ClickHouse(极致速度),Doris/StarRocks(高性能MPP),Google BigQuery/Snowflake(云数仓)。 - 列式存储:

Apache Parquet/ORC(HDFS/S3上格式标准)。 - 索引策略: 二级索引、分区索引、位图索引、倒排索引。

- 数据分区与分桶: 优化数据剪裁(Partition Pruning)。

- OLAP引擎:

-

缓存策略:减少重复计算与IO

- 服务结果缓存: 在API Gateway层缓存常见查询响应(

Redis,Memcached,Varnish)。 - 查询结果缓存: Presto/Trino支持结果集缓存。

- 分布式缓存层:

Alluxio(连接计算层和存储层的虚拟缓存层), 对上层提供内存速度访问存储层数据(S3, HDFS)的体验。 - 物化视图: 定期/实时计算并存储结果供查询(如

ClickHouse Materialized View)。

- 服务结果缓存: 在API Gateway层缓存常见查询响应(

-

预计算与聚合层:空间换时间

- 目的: 将复杂的、耗时的聚合计算预先完成。

- 实现方式:

- 离线批处理:

Spark SQL,Hive构建Cube(Kylin),准备核心宽表/聚合表。 - 实时/准实时计算:

Flink/Spark Streaming进行增量聚合。 - Lambda架构/Kappa架构: 处理不同时效性要求的聚合。

- 离线批处理:

-

数据预取与推送:

- 预测性加载: 基于用户行为分析预加载可能被访问的数据。

- 增量同步: CDC工具实时将变化数据同步到缓存或预计算层。

四、 进阶篇:安全、治理、性能与企业级实践

构建数据服务仅是起点,保障其安全稳定高效运行才能释放持久价值。

(一) 数据安全与服务治理:生命线

-

精细化的访问控制:

- 模型:

RBAC(基于角色),ABAC(基于属性,更细粒度)。 - 实现: API Gateway鉴权 + 后端服务强校验。

- 行级/列级权限: SQL服务层(如

Trino的System Access Control+File Based System Access Control), 数据虚拟化层配置。 - 数据脱敏: 动态/静态脱敏(基于策略), 如

SELECT name, mask(credit_card) FROM users;。

- 模型:

-

强大的身份认证与授权:

- 企业级身份提供商 (IdP):

Keycloak,Okta,Azure AD。 - 协议:

OAuth 2.0,OpenID Connect (OIDC),SAML 2.0。 - 统一配置示例 (Keycloak保护API): 在API Gateway配置为OIDC Relaying Party,转发Token到后端微服务校验。

- 企业级身份提供商 (IdP):

-

数据加密(传输中 & 静态):

- TLS Everywhere: 确保所有API调用都是HTTPS。

- 存储层加密: S3 Server-Side Encryption, HDFS Transparent Data Encryption (TDE)。

- 数据库字段级加密: 应用层或数据库插件实现。

-

审计与监控:

- API访问审计: API Gateway日志 + 数据访问审计插件(如

PostgreSQL Audit Logging,AtlasHook)。 - 集中日志平台:

Elastic Stack (ELK),Splunk,Graylog。 - 监控指标:

Prometheus+Grafana(监控API Latency、Error Rate、QPS, DB查询性能, 缓存命中率)。 - 可视化仪表板示例: 展示核心API服务健康度与资源利用率。

- API访问审计: API Gateway日志 + 数据访问审计插件(如

-

服务契约与API管理:

- API定义: 严格使用

OpenAPI Specification (Swagger)定义接口契约。 - 契约驱动开发: 基于契约自动生成代码桩和Mock服务。

- 生命周期管理: 版本管理、升级通知、优雅下线(Deprecation)。

- 服务级别协议 (SLA): 明确承诺的可用性与性能指标。

- API定义: 严格使用

(二) 性能与成本优化实战

-

性能诊断三板斧:

- 度量(Metrics): 建立端到端关键路径指标。

- 追踪(Tracing):

OpenTelemetry/Jaeger/Zipkin定位瓶颈链路。 - 剖析(Profiling):

async-profiler,JFR分析JVM应用热点。 - 数据库慢查询分析:

EXPLAIN ANALYZE是数据库性能优化神器。

-

高效访问模式设计:

- 合理的API设计:

- 分页: 避免返回过大结果集 (

limit/offset,seek method/cursor). - 过滤、投影、排序: 请求参数支持灵活筛选所需数据字段和顺序。

- 避免N+1查询: API设计时考虑资源聚合。

- 分页: 避免返回过大结果集 (

- 查询优化:

- 避免

SELECT *: 只取必要字段。 - 利用索引: 为高频WHERE、JOIN、GROUP BY字段建索引。

- 优化复杂JOIN: 数据模型设计(星型/雪花模型)、预计算宽表。

- 使用分区过滤: 确保查询条件能触发分区剪裁。

- 避免

- 合理的API设计:

-

资源调度与隔离:

- Kubernetes:容器化部署,利用

ResourceQuotas和LimitRanges进行CPU/内存配额限制。 - YARN/Fair Scheduler:保障关键服务队列资源。

- 服务熔断与降级:

Hystrix/Resilience4J防止级联故障。

- Kubernetes:容器化部署,利用

-

成本控制策略:

- 资源按需扩缩: Serverless、

K8s HPA。 - 冷热数据分层: 高频访问热数据放SSD/内存,冷数据归档到廉价存储(S3 IA/Glacier)。

- 计算资源调度优化: 错峰执行资源密集型任务。

- 监控成本构成: AWS Cost Explorer, Azure Cost Management等。

- 资源按需扩缩: Serverless、

(三) 企业级架构演进与新兴范式

-

数据网格(Data Mesh):解耦与赋能

- 核心原则:

- 领域数据自治: 由业务领域团队负责其生产数据的质量、管理与服务提供(“谁生产,谁服务”)。

- 数据即产品: 每个领域数据视为独立产品,有明确的产品负责人(Data Product Owner)负责SLA、文档等。

- 自助式基础设施平台: 提供标准化、自动化的数据服务部署、安全、治理平台。

- 联合计算治理: 全局统一的标准化(安全、互操作)由中心化组织制定,领域团队负责本地执行。

- 对数据服务的影响:

- 服务粒度更细: 每个领域团队自己发布和管理其领域内的数据API。

- 更强的产品化思维: 注重用户体验(开发者/分析师体验)、SLA、文档质量。

- 平台工程重要性提升: 提供便捷的工具链和服务框架模板。

- 核心原则:

-

Data Fabric(数据编织):跨环境的统一治理层

- 核心能力:

- 智能数据发现与编目: 主动识别、分类、标记分散数据。

- 增强数据血缘: 动态追踪数据的起源、转换和去向。

- 统一策略执行点: 在多个数据源和消费点上集中实施访问控制、脱敏、合规策略。

- 统一语义层: 提供一致的数据术语和业务视图。

- 与数据服务关系: Data Fabric是支撑数据服务在复杂(混合云/多云)环境下实现统一治理和安全保障的智能“神经中枢”。

- 核心能力:

-

Lakehouse架构:融合数据湖与数仓

- 代表性技术:

Delta Lake,Apache Iceberg,Apache Hudi。 - 对数据服务的价值:

- 统一批流: 单一存储层支持高性能更新、事务能力(ACID),简化服务后端存储。

- 开放性与高性能: 开放格式(Parquet)保证兼容性,支撑高性能查询(支持索引、Z-Ordering)。

- 简化架构: 降低管理多套存储(湖+仓)的复杂性和数据冗余。

- 代表性技术:

五、 结论:驾驭数据洪流,成就智能未来

通过深入探讨,我们已经清晰地看到,数据服务绝非简单的API封装,而是构建现代化数据驱动型企业的核心战略资产。它是连接数据孤岛、打通数据价值链的关键枢纽:

-

核心要义回顾:

- 服务化抽象: 数据服务通过统一接口(API/SQL/推送)将复杂的数据基础设施转化为易于消费的能力。

- 分层构建: 坚实的数据处理与加速层、强大的服务抽象层、便捷的统一接入层共同构成服务体系。

- 双轮驱动: 安全与治理是底线和保障,性能与成本是效率与可持续性。

- 演进趋势: 数据网格的分布式自治、Data Fabric的统一治理、Lakehouse的统一存储正塑造下一代服务架构。

-

未来展望:

- AI的深度融合: AI驱动的查询优化、智能缓存预测、自动化元数据生成和治理将日益普及。

- 实时化成为标配: 流式处理与服务结合将更加紧密,从“准实时”迈向“毫秒级决策”。

- 主动式数据服务: 基于数据分析和预测模型,主动推送洞察建议,实现“数据找人”。

- 开发者体验革命: 更加智能化、低代码化的数据服务开发与管理工具(如

Airbyte,Tecton等)将加速数据消费。 - 可持续性(Green Data): 数据服务的架构设计将更关注能耗和碳足迹优化。

-

行动号召:

- 评估现状: 盘点现有数据消费的痛点(延迟?难度?瓶颈?)。

- 规划蓝图: 从高价值业务场景(如实时风控、运营看板)切入,设计符合企业需求的服务架构(集中式 or 数据网格?)。

- 启动试点: 选择一个典型业务领域,实施最小可行数据服务(MVDS),验证技术栈与价值。

- 投资平台与工具: 构建内部数据服务平台团队或利用成熟的第三方平台解决方案。

- 培养文化: 倡导“数据即产品”思维,明确数据域所有权与服务契约精神。

开启你的数据服务之旅:

- 实践篇:基于开源栈搭建基础数据服务

- 学习Presto/Trino:官方文档

- 探索Kong网关:Kong入门教程

- 了解Debezium CDC:Debezium入门

构建卓越的数据服务之路充满挑战但也回报丰厚。当数据如同电力一样畅通无阻地为组织的每个“神经元”提供能量时,真正的数据智能时代便将到来。在评论区分享你建设或使用数据服务的挑战与成功经验吧! 你的实践将为同行者照亮前路。

更多推荐

已为社区贡献96条内容

已为社区贡献96条内容

所有评论(0)