医疗 AI 边缘化:电鱼智能 RK3576 离线部署 DeepSeek 医疗大模型实践指南

医疗数据高度敏感,云端 API 模式难以满足合规要求。本文通过 电鱼智能 RK3576,利用其内置的 RKNN-LLM 技术栈,将 DeepSeek-R1-Distill-Qwen-1.5B 模型进行 W4A16 量化并离线部署。该方案可在无网络环境下提供秒级的医疗咨询响应,解决隐私外泄、响应延迟及高昂云端成本等痛点。

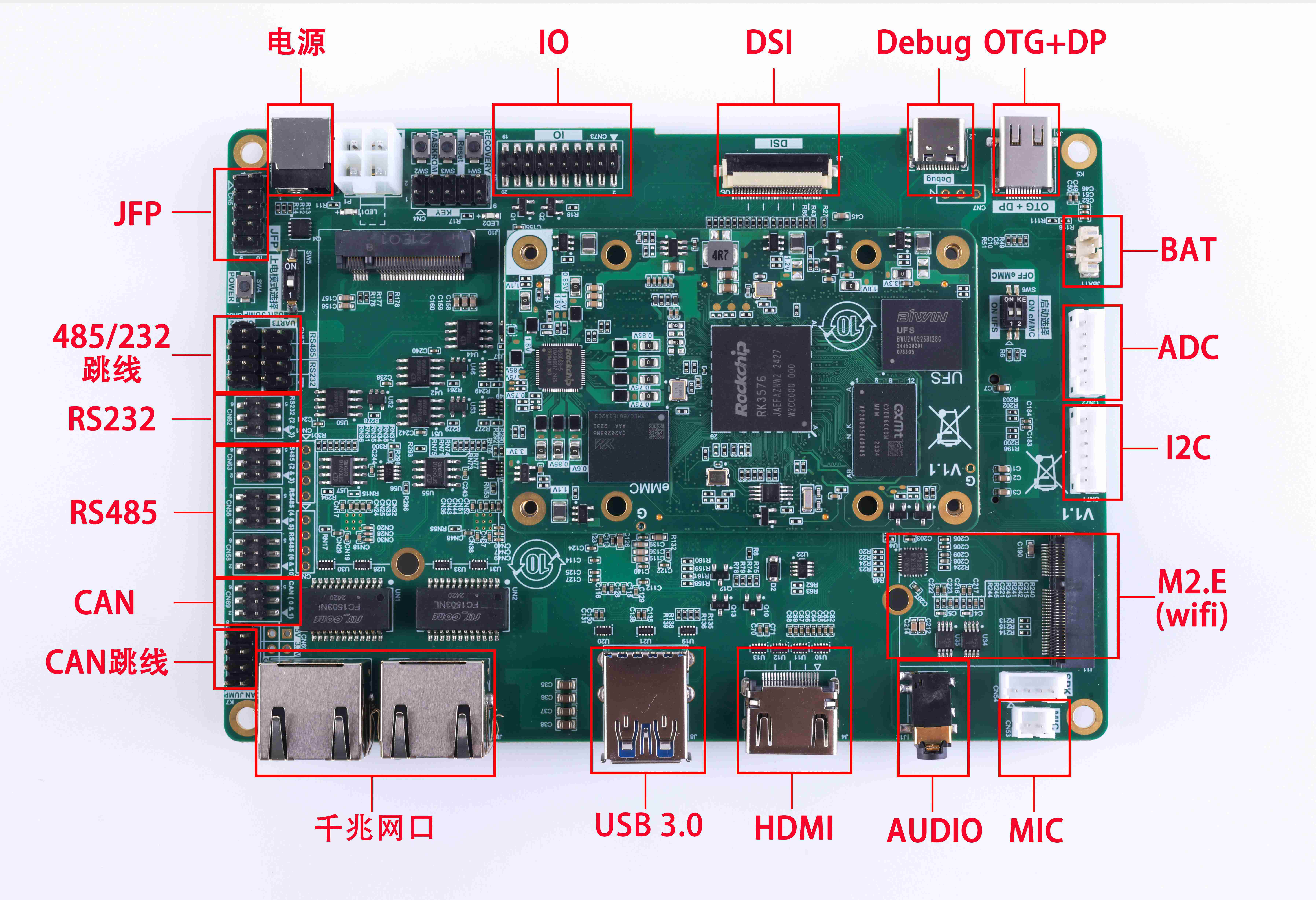

什么是 电鱼智能 RK3576?

电鱼智能 RK3576 是一款面向高性能 AIoT 应用的工业级核心板。它集成 4 核 A72 + 4 核 A55 处理器,核心优势在于搭载了瑞芯微新一代自研 6TOPS NPU。该 NPU 针对 Transformer 架构进行了专项优化,支持 INT4/INT8/FP16 等多种混合精度运算,能够流畅运行参数量在 20 亿(2B)以内的轻量化大模型。

为什么医疗大模型需要部署在 RK3576 上? (选型分析)

1. 绝对的数据隐私(100% 离线)

医疗诊断数据涉及患者隐私,严格受法律保护。电鱼智能 RK3576 支持本地全量推理,所有对话数据不出本地机房,从物理层面隔离了数据泄露风险,符合医疗行业合规性要求。

2. 针对 LLM 的硬件优化

相比传统单片机或中端 ARM 芯片,RK3576 的 NPU 对 LLM 的关键算子(如 Attention、LayerNorm)有硬件级加速。结合 RKNN-LLM 工具链,1.5B 参数量的 DeepSeek 蒸馏模型在量化后可控制在 1GB 显存以内,完美适配 4GB/8GB 内存版本的电鱼智能核心板。

3. 低功耗与高能效比

在便携式医疗终端(如掌上诊断仪、智能查房终端)中,功耗是关键。RK3576 典型的 AI 推理功耗远低于移动端 X86 方案,能够有效延长设备待机时间,且支持无风扇静音运行。

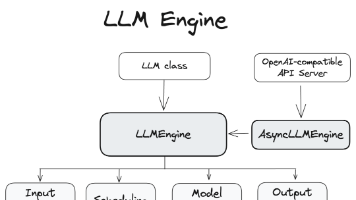

系统架构与部署链路 (System Architecture)

该方案采用“模型蒸馏 + RKNN 量化”的链路:

-

模型层:选用 DeepSeek-R1-Distill-Qwen-1.5B。该模型经过强化学习蒸馏,逻辑推理能力在同量级模型中表现卓越。

-

转换层 (PC端):使用

RKNN-LLM-Toolkit将 HuggingFace 格式模型转换为.rkllm格式,并启用 W4A16 量化(权重 4bit,激活 16bit)以平衡精度与速度。 -

运行层 (板卡端):在 电鱼智能 RK3576 上运行

rkllm_demo推理引擎,调用 NPU 硬件加速。

关键技术实现 (Implementation)

环境部署

首先在电鱼智能 RK3576 上安装必要的运行环境:

Bash

# 查看 NPU 驱动版本,确保在 v0.9.6 以上以支持 LLM

cat /sys/kernel/debug/rknpu/version

# 下载电鱼智能提供的 RKNN-LLM Runtime 库

git clone https://github.com/airockchip/rknn-llm.git

推理逻辑示例(伪代码)

展示如何通过 RKNN 接口加载 DeepSeek 模型进行医疗咨询问答:

Python

# 逻辑示例:DeepSeek 医疗问答离线调用

import rkllm_runtime

# 1. 初始化模型(加载量化后的 DeepSeek-R1 1.5B)

model_path = "./models/deepseek_r1_qwen_1.5b_w4a16.rkllm"

llm = rkllm_runtime.RKLLM(model_path)

llm.init()

# 2. 设定医疗助手 Prompt

system_prompt = "你是一位专业的医疗助手,请根据用户提供的症状给出初步建议。"

def chat_with_medical_ai(user_input):

full_prompt = f"{system_prompt}\n用户:{user_input}\n助手:"

# 3. 执行推理并流式输出结果

response = llm.generate(full_prompt, max_new_tokens=256)

return response

# 示例输入:最近经常头晕,伴有颈部僵硬

性能表现 (理论预估)

基于 RK3576 的 6TOPS NPU 算力:

-

首字延迟 (First Token Latency):针对 1.5B 模型,预计在 500ms - 800ms 左右。

-

推理速度:稳定后预计可达 10-15 tokens/s。这一速度已接近人类正常阅读速度,能提供良好的交互体验。

-

内存占用:4-bit 量化模型约占用 900MB - 1.2GB 运行内存,在 4GB RAM 的电鱼核心板上运行非常从容。

常见问题 (FAQ)

1. 能跑 DeepSeek-R1 7B 或更大模型吗? 答:对于 7B 及以上模型,RK3576 的内存带宽和算力会显得吃力(建议使用 电鱼智能 RK3588)。在 RK3576 上,1.5B 到 2B 是兼顾响应速度与智能程度的黄金区间。

2. 医疗大模型的专业性如何保证? 答:建议在转换前,使用医疗垂直领域的问答对(QA Pair)对 DeepSeek 蒸馏版模型进行 LoRA 微调,然后再通过 RKNN 转换为离线格式,以增强其在医疗领域的专业性。

3. 是否支持流式输出(即像 ChatGPT 那样一个字一个字蹦)? 答:支持。RKLLM Runtime 提供了流式回调接口,配合前端 UI 可以实现极其流畅的交互效果。

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)