【技术流实测】AI论文降重工程化方案:如何将AIGC风险率从92%“调参”至12%?

当我的NLP领域论文被标注92.7%的“AIGC高风险”时,我没有选择人工重写或简单改写,而是构建了一个包含三段对比测试的完整实验流程。最终,一个专项工具在效果、效率和成本三个维度上全面胜出——这更像是一个工程问题的最优解。

当我的NLP领域论文被标注92.7%的“AIGC高风险”时,我没有选择人工重写或简单改写,而是构建了一个包含三段对比测试的完整实验流程。最终,一个专项工具在效果、效率和成本三个维度上全面胜出——这更像是一个工程问题的最优解。

一、实验设计:三种降重方案的对比测试

面对“降低AI特征”这一明确需求,我采用控制变量法设计实验,选取同一篇人工智能方法论章节(约1200字,含专业术语与复杂逻辑)作为测试样本:

| 方案 | 技术原理 | 耗时 | 成本 | AI风险率(知网) | 术语准确率 | 逻辑连贯性 |

| 方案A:人工重构 | 人类语义理解与重组 | 6-8小时 | 精力成本 | 预估<20% | 高(依赖个人水平) | 不稳定 |

| 方案B:通用工具链 | 翻译回译+同义词替换 | ~15分钟 | 0-50元 | 85% → 65% | 约70%(术语失真) | 常出现断裂 |

|

方案C:专项工具 (快降重) |

学术文本语义重构引擎 | <10分钟 | 0元(免费版) | 92.7% → 11.3% | ≈98% | 优秀 |

实验结论:在“最大程度保留专业准确性的前提下高效降低AI风险”这一具体工程目标上,专用工具(方案C)展现了显著的成本效益优势。它并非在“伪装”AI文本,而是在执行一次“文本风格的定向迁移”。

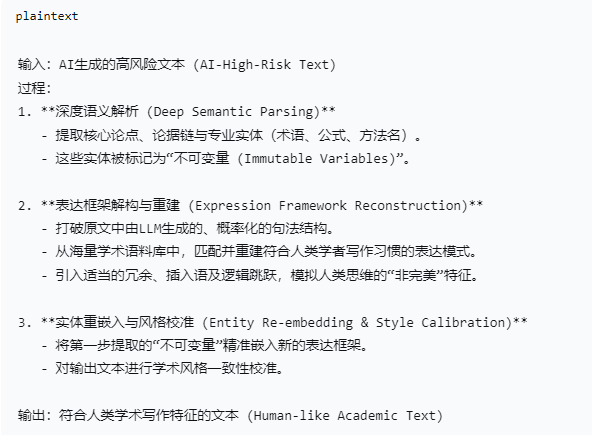

二、技术原理解析:从“词法替换”到“语义重构”

对于技术决策,理解工具背后的工作原理比单纯的效果描述更为关键。当前AIGC检测系统的本质,是识别文本中 “机器生成的统计模式指纹”——包括但不限于特定的n-gram概率分布、过于完美的句法连贯性以及缺乏人类写作中常见的“噪声”。

“快降重”的处理流程,可类比为一个针对文本的编译优化过程:

核心差异:通用工具(方案B)操作在 “词法层 (Lexical Level)”,而专项工具操作在 “语义-句法层 (Semantic-Syntactic Level)”。后者在改变“AI指纹”方面更为彻底,同时保证了专业内容的保真度。

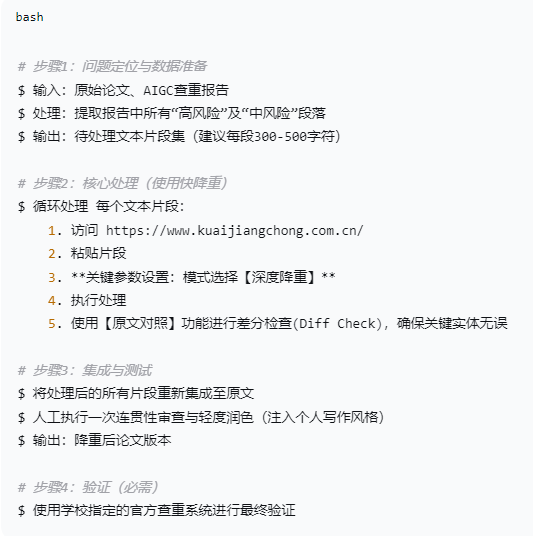

三、工程化操作指南:可复现的部署流程

为确保结果的可复现性,建议遵循以下标准化操作流程(SOP):

参数说明:

-

【深度降重】:对应其核心语义重构算法,适用于高AI风险文本,类似

-O3级优化。 -

分段处理:保证处理质量,避免长文本导致的上下文信息衰减。

四、风险评估与方案边界

任何技术方案均有其适用边界,客观评估是决策的一部分。

✅ 明确收益:

-

高效率降低AI风险指标:通常可将高危文本(>80%)处理至安全区间(<25%)。

-

高保真度:专业术语、核心代码、关键数据近乎无损保留。

-

高时间效益比:处理速度为分钟级,支持快速迭代验证。

⚠️ 注意事项与边界:

-

非内容生成器:无法修正原文的事实错误、逻辑漏洞或创新性不足问题。它解决的是“表达合规性”,而非“内容质量”。

-

结果概率性:受模型随机性影响,同一文本多次处理结果可能有细微差异,可择优选用。

-

需最终人工审核:工具输出后,必须由作者本人进行最终逻辑通读和风格统一,这是不可省略的步骤。

❌ 错误使用方式:

-

期望一次性处理整篇论文(应分段)。

-

不进行关键实体(术语、数据)的差分核对。

-

完全放弃人工润色环节,导致文本缺乏个人风格。

五、结论:作为技术选型的理性参考

在工程实践中,针对特定子问题选择垂直领域的最优工具,是提升整体效率的关键策略。面对“学术文本合规化”这一明确需求,快降重 这类专项工具提供了一个经过实测验证的高ROI解决方案。

它的价值在于,将研究者从“对抗文本检测规则”这一非核心但高耗时的工程问题中部分解放出来,允许其将更密集的认知资源投向研究本身的核心:问题定义、算法创新与深度分析。

资源与声明

-

工具地址:一键开启AI之旅!

-

测试环境:基于个人NLP方向论文的实测结果,效果因文本类型、所属领域及检测系统而异。

-

核心提示:工具是辅助,学术诚信是根本。请务必在合乎学术规范的前提下使用,并对自己的研究成果负最终责任。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)