Exo入门教程:用日常设备构建个人AI集群

Exo是一个开源AI集群项目,可将日常设备连接成分布式计算系统,支持运行大型语言模型。它利用Thunderbolt上的RDMA技术降低延迟,实现自动设备发现和拓扑感知并行,在4台M3 Ultra Mac上可流畅运行Qwen3-235B等大模型。Exo支持macOS/Linux系统,提供命令行和图形界面,让个人用户、开发者和小企业无需昂贵硬件即可体验AI计算。相比云服务,Exo具有成本低、隐私好、可

本文为Exo的简化入门教程,详细内容请查看原文:https://ai225.com/article/exo-ai-cluster-introduction

在AI技术飞速发展的今天,大型语言模型的能力越来越强大,但运行这些模型通常需要昂贵的硬件设备。Exo项目的出现改变了这一现状,它允许用户将家中的日常设备连接起来,构建一个强大的AI集群,让每个人都能体验大型AI模型的魅力。

什么是Exo?

Exo是一个开源项目,旨在将您拥有的所有设备连接成一个AI集群。它不仅能运行比单个设备内存更大的模型,还通过Thunderbolt上的RDMA(远程直接内存访问)技术,使模型在添加更多设备时运行速度更快。

这个项目的核心理念是"让AI计算民主化",充分利用现有设备资源,无需购买昂贵的专用硬件。

核心优势

| 特性 | 描述 |

|---|---|

| 自动设备发现 | 设备间自动发现,无需手动配置 |

| RDMA支持 | Thunderbolt 5上实现99%延迟降低 |

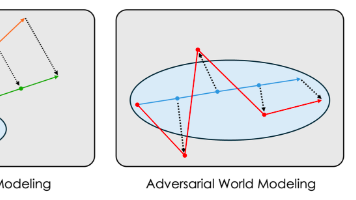

| 拓扑感知并行 | 基于设备拓扑自动优化模型分布 |

| 张量并行 | 2设备1.8倍加速,4设备3.2倍加速 |

| MLX支持 | 使用MLX作为推理后端,适合Apple Silicon |

性能表现

Exo在多个大型模型上进行了基准测试,展示了其强大的分布式计算能力:

- Qwen3-235B (8-bit):在4台M3 Ultra Mac Studio上流畅运行

- DeepSeek v3.1 671B (8-bit):同样硬件配置下成功运行超大规模模型

- Kimi K2 Thinking (原生4-bit):验证了不同精度和架构模型的兼容性

快速开始

系统要求

- 操作系统:macOS、Linux

- Python环境:需要uv(Python依赖管理工具)

- Apple Silicon设备:需要macmon(硬件监控工具)

安装步骤

-

安装前置工具

brew install uv macmon -

克隆项目

git clone https://github.com/exo-explore/exo -

构建仪表板

cd exo/dashboard && npm install && npm run build && cd .. -

运行Exo

uv run exo

完成后,访问 http://localhost:52415/ 即可使用Exo仪表板和API。

macOS应用

Exo还提供了macOS应用程序,可在后台运行。需要macOS Tahoe 26.2或更高版本。

下载地址:EXO-latest.dmg

基本使用

1. 预览模型部署

curl "http://localhost:52415/instance/previews?model_id=llama-3.2-1b"

2. 创建模型实例

curl -X POST http://localhost:52415/instance \

-H 'Content-Type: application/json' \

-d '{

"instance": {...}

}'

3. 发送聊天请求

curl -N -X POST http://localhost:52415/v1/chat/completions \

-H 'Content-Type: application/json' \

-d '{

"model": "mlx-community/Llama-3.2-1B-Instruct-4bit",

"messages": [

{"role": "user", "content": "What is Llama 3.2 1B?"}

],

"stream": true

}'

4. 删除实例

curl -X DELETE http://localhost:52415/instance/YOUR_INSTANCE_ID

应用场景

个人AI研究

💡 研究利器:研究人员和学生可以使用Exo在家中构建小型AI集群,进行实验和学习,无需访问昂贵的云服务。

小型企业和创业公司

对于预算有限的小型企业和创业公司,Exo提供了一种经济高效的方式来运行AI模型,开发AI驱动的产品和服务。

AI应用开发

开发者可以使用Exo测试和优化他们的AI应用,确保在不同硬件配置下的兼容性和性能。

教育和培训

教育机构可以使用Exo为学生提供实践AI计算的机会,让他们了解分布式AI系统的工作原理。

优势比较

与传统的云计算AI服务相比,Exo具有以下优势:

- 成本效益:充分利用现有设备,无需购买昂贵的专用硬件

- 隐私保护:数据保留在本地设备上,不依赖第三方云服务

- 离线能力:无需互联网连接即可运行AI模型

- 可扩展性:随着设备增加,性能线性提升

- 开源透明:完全开源,代码透明可审计

常见问题

Q: Exo支持哪些操作系统?

A: 目前Exo主要支持macOS和Linux系统。在macOS上使用GPU加速,在Linux上目前运行在CPU上。

Q: 需要什么类型的设备才能构建AI集群?

A: 任何现代计算机都可以加入集群,但Apple Silicon设备(如M系列芯片的Mac)由于支持MLX框架,性能表现更佳。

Q: Exo与传统的云计算服务相比有什么优势?

A: Exo主要优势包括成本效益、隐私保护、离线能力和可扩展性。数据保留在本地,无需依赖第三方云服务。

Q: 如何优化Exo集群的性能?

A: 可以通过Thunderbolt连接设备以获得最佳性能,使用RDMA技术降低延迟,并根据设备资源合理分配模型分片。

未来发展

Exo项目仍在快速发展中,未来计划包括:

- 扩展对更多硬件平台的支持

- 改进用户界面和用户体验

- 增强安全性和隐私保护功能

- 优化更多模型的并行化策略

- 简化安装和配置过程

总结

Exo项目代表了AI计算民主化的重要一步,它让普通用户也能利用日常设备构建强大的AI集群。通过自动设备发现、RDMA技术、拓扑感知并行等创新特性,Exo大大降低了运行大型AI模型的门槛。

无论您是研究人员、开发者、学生还是AI爱好者,Exo都为您提供了一个探索AI世界的强大工具。随着项目的不断发展和社区的积极参与,我们有理由相信Exo将在未来的AI生态系统中发挥越来越重要的作用。

原文链接:https://ai225.com/article/exo-ai-cluster-introduction

想了解更多AI工具和项目?请访问AI225导航,我们提供最全面的AI工具介绍和使用指南。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)