让 MCP 服务永不宕机:基于 Service Mesh 构建高可用 AI 工具网络

摘要:本文探讨如何通过服务网格(ServiceMesh)技术解决MCP(ModelContextProtocol)在企业级生产环境中的高可用挑战。重点介绍了MCP与Istio/Linkerd的深度集成方案,包括服务发现、流量治理、多租户隔离和跨集群联邦等核心功能。通过将MCP作为数据平面组件,实现了零侵入式的熔断、限流、重试等能力,构建了支持动态扩缩容、多租户隔离和跨集群调用的AI工具网络,使MC

当 MCP(Model Context Protocol)从单机实验走向企业级生产,一个严峻挑战随之而来:如何保障成百上千个工具服务的高可用、可观测与弹性伸缩?

传统的“裸奔”式部署已无法满足需求——一次数据库超时可能拖垮整个 Agent 响应链,一个异常工具可能耗尽全集群资源。

答案是:将 MCP 服务纳入服务网格(Service Mesh)体系。

本文将详解如何将 MCP 作为数据平面,与 Istio/Linkerd 集成,实现服务发现、流量治理、多租户隔离与跨集群联邦,构建真正生产就绪的 AI 工具网络。

一、MCP 作为数据平面:与 Istio / Linkerd 深度集成

在 Service Mesh 架构中,MCP Server 本质是提供“能力”的微服务,天然适合作为数据平面(Data Plane)组件。

集成方式

- Sidecar 模式:每个 MCP Server Pod 注入 Envoy(Istio)或 Linkerd-proxy;

- 协议透传:MCP 基于 HTTP/gRPC,Mesh 无需理解业务语义,仅处理网络层;

- mTLS 自动启用:Service Mesh 默认为所有服务间通信启用双向 TLS,无需修改 MCP 代码即可加密传输。

优势

- 零侵入:MCP Server 代码无需关心熔断、重试、监控;

- 统一治理:与业务微服务共用同一套网格策略;

- 无缝升级:Mesh 控制平面(如 Istiod)可动态下发配置,无需重启 MCP 服务。

关键认知:MCP 不是特殊存在,而是网格中的一员。

二、服务发现:动态注册与发现工具能力

在微服务架构中,工具服务可能动态扩缩容、迁移 IP。硬编码地址将导致调用失败。

解决方案:通过注册中心动态发现

- Consul / Nacos / Eureka:MCP Server 启动时向注册中心注册自身(含

tool_name元数据); - Agent Client 查询注册中心,获取当前可用的 MCP 服务实例列表;

- 结合 DNS 或 xDS 协议,实现负载均衡。

实现示例(基于 Istio + Kubernetes)

- MCP Server 以 Kubernetes Service 形式暴露:

apiVersion: v1

kind: Service

metadata:

name: mcp-db-tool

labels:

app: mcp-tool

tool: query_user_db # 关键:标注工具能力

spec:

selector:

app: mcp-db-tool- Agent 通过

tool-name标签 发现服务:

// 伪代码:通过 Istio DNS 发现

endpoints := resolve("query_user_db.mcp.svc.cluster.local")这样,Agent 调用 query_user_db 时,自动路由到健康实例。

三、流量治理:熔断、限流、重试,保障系统韧性

LLM Agent 可能在短时间内发起大量 MCP 调用(如并行查询多个系统)。若无流量控制,极易引发雪崩。

1. 熔断(Circuit Breaking)

当某 MCP 服务错误率超过阈值(如 50%),自动切断调用,避免资源浪费。

- Istio 配置:

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

spec:

host: mcp-db-tool

trafficPolicy:

connectionPool:

http:

maxRequestsPerConnection: 10

outlierDetection:

consecutive5xxErrors: 5

interval: 30s2. 限流(Rate Limiting)

防止单个 Agent 耗尽工具服务资源。

- 基于命名空间或 Agent ID 限流;

- Istio 配合 Redis 实现全局速率限制。

3. 重试(Retry)

对幂等工具(如查询)自动重试,提升成功率。

- 配置最大重试次数、超时、退避策略;

- 避免对非幂等操作(如创建订单)重试。

注意:MCP Client 仍需保留应用层重试逻辑,Mesh 层重试仅处理网络瞬时故障。

四、多租户隔离:命名空间 + 资源配额

在 SaaS 或多团队共享 MCP 平台时,必须实现租户隔离,防止资源争用。

1. 命名空间隔离

- Kubernetes Namespace:每个租户独占一个 Namespace;

- Istio Sidecar 范围限制:租户 Agent 只能访问本 Namespace 内的 MCP 服务;

- NetworkPolicy:禁止跨 Namespace 流量。

2. 资源配额(Resource Quota)

- CPU/Memory 限制:防止某租户工具占用过多节点资源;

- 请求配额:通过 Istio Quota Spec 限制每秒调用量;

- 工具可见性隔离:租户 A 无法看到租户 B 注册的工具。

实现效果:财务团队的 payroll_tool 对 HR 团队完全不可见,也无法调用。

五、跨集群 MCP 调用:构建联邦工具网络

大型企业常有多个 Kubernetes 集群(生产/测试、多云、混合云)。如何让 Agent 调用跨集群的工具?

解决方案:服务网格联邦(Mesh Federation)

- Istio Multi-Cluster:通过共享根 CA 和 Istiod,实现跨集群服务发现;

- 东西向网关(East-West Gateway):集群间流量通过加密网关转发;

- 工具元数据同步:通过外部注册中心(如 Consul)全局同步

tool_name → 集群地址映射。

调用流程

- Agent 在集群 A 发起

tool_requestforbackup_db; - 本地 Istio 发现该工具仅在集群 B 提供;

- 流量经东西向网关加密转发至集群 B;

- 集群 B 的 MCP Server 执行并返回结果。

结果:Agent 无需关心工具物理位置,全局工具网络对上层透明。

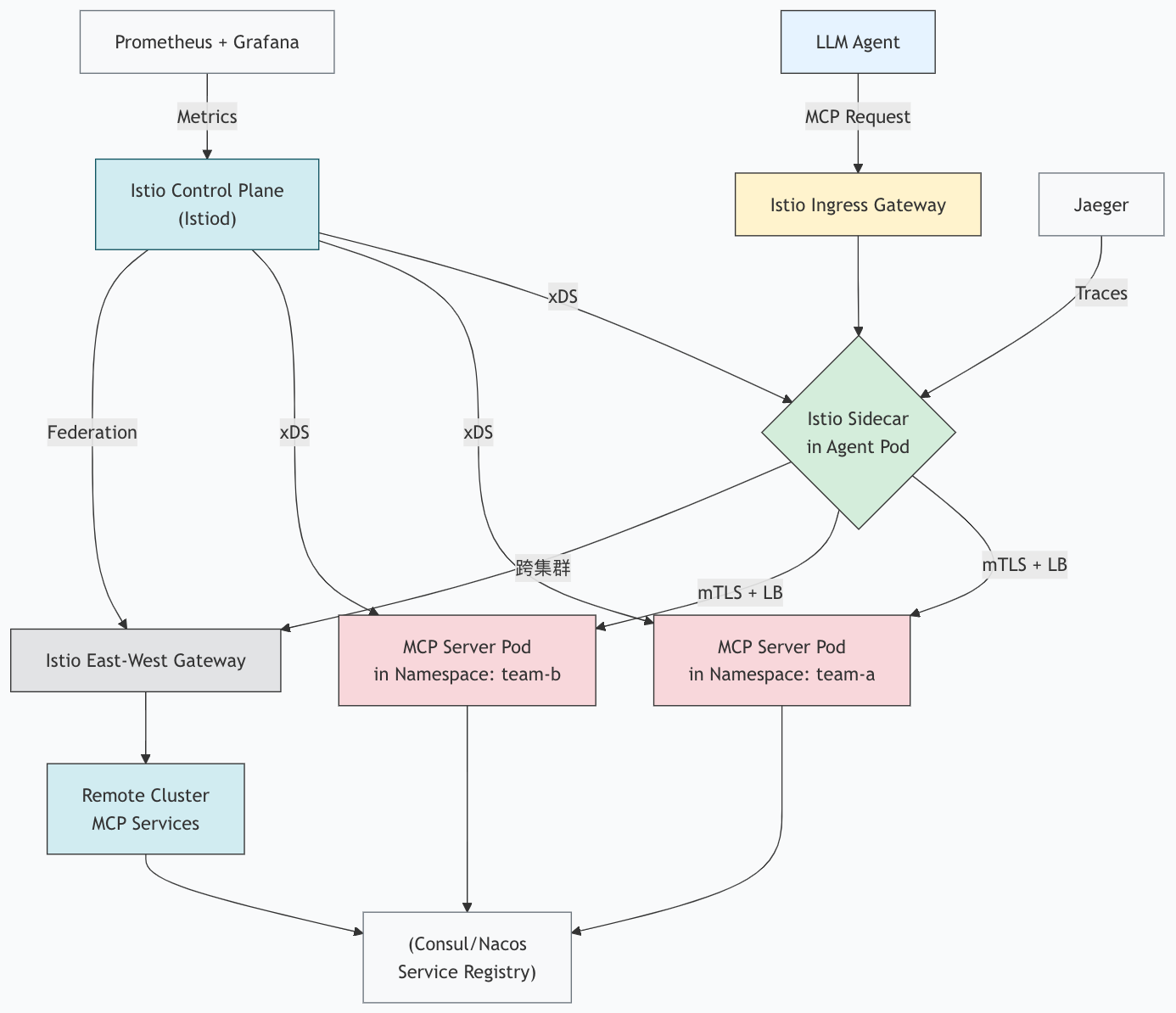

六、高可用 MCP 服务网格架构图

下图展示了基于 Istio 的 MCP 服务网格整体架构:

该架构实现了:

- 服务发现自动化

- 多租户物理隔离

- 跨集群透明调用

- 统一可观测性

结语:MCP 的未来在网格中

单体 MCP Server 只能解决“能不能调”的问题,而 Service Mesh 解决了“能不能稳稳地调”。

通过将 MCP 深度融入服务网格,你获得了:

- 企业级高可用

- 精细化流量治理

- 安全多租户架构

- 跨云/跨集群扩展能力

这不再是“AI 工具”,而是一个可运维、可度量、可信赖的基础设施。

当你的 MCP 服务运行在网格之中,LLM Agent 才真正拥有了一个强健、可靠、弹性的“手脚”。现在,是时候把你的 MCP 服务“织进”这张智能之网了。

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)