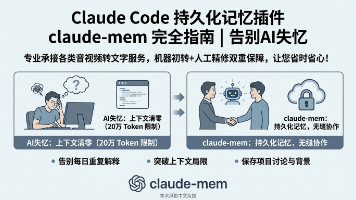

AI Agent 的记忆进化:从“金鱼脑”到“思维图书馆”

AI记忆技术的演进与突破 摘要:本文系统阐述了AI记忆能力的三次重大进化。早期AI系统采用无状态设计,存在严重的记忆断裂问题。第一波突破来自RNN和LSTM架构,实现了有限的短期记忆。2017年Transformer架构的革命性创新,通过注意力机制使AI具备上下文理解能力。最新的第三波技术将AI与外部记忆系统结合,通过向量数据库实现语义检索,建立了包含工作记忆、情景记忆等多层次的记忆体系。这些突破

目录

引言:当AI不再健忘

想象一下,你与一位智能助手进行对话。第一次见面,你告诉它你喜欢黑咖啡、讨厌下雨天。一周后重逢,它却像从未见过你般重新询问相同的偏好。这种场景在早期的AI系统中并不罕见——它们就像是数字世界的“金鱼”,只有几秒钟的记忆。

但今天,情况正在发生根本性的改变。

当前,智能体架构的技术研讨热度持续攀升,核心组件的标准化与抽象化进程不断推进——诸如MCP(Model Context Protocol,模型上下文协议)与A2A(Agent-to-Agent,智能体间交互协议)等关键协议,正逐步明确智能体调用外部工具的流程规范,以及多智能体协同工作的交互逻辑。

1. AI记忆的原始时代:从零开始的困境

在人工智能发展的早期阶段,大多数系统采用“无状态”设计。每一次交互都被视为独立事件,AI没有能力记住之前的对话、决策或经验。就像电影《记忆碎片》中的主角,每次“醒来”都从零开始。

这种设计的局限性显而易见:

-

用户体验的断裂性

-

无法进行长期、连贯的互动

-

每次都需要重新学习用户偏好

-

无法建立真正的个性化服务

2. 记忆的三次进化浪潮

第一波:短期记忆的诞生

早期突破来自于对循环神经网络(RNN)和长短期记忆网络(LSTM)的应用。这些架构使AI能够保留有限时间内的信息,处理顺序数据,如文本序列或时间序列数据。然而,这种记忆仍然短暂且容量有限,就像只记得对话的最后几句话。

RNN(循环神经网络)系列:

按顺序处理文本,一个字一个字“阅读”

理论上能记住很长的信息

但实际上存在“梯度消失”问题,记不住太远的内容

无法并行计算,训练极慢

LSTM(长短期记忆网络)系列:

- 引入门控机制,让网络能够有选择地记忆和遗忘

- 有效记忆长度:提升到~100-200个时间步

- 顺序处理的本质未变

- 所有历史信息压缩到固定维度的隐藏状态(试图用一句话总结一本小说)

- 长距离依赖仍然困难

- 无法并行计算,训练更慢(但更稳定)

CNN(卷积神经网络)系列:

能并行计算,训练较快

但只能看到局部信息,难以理解长距离关系

第二波:注意力机制与Transformer革命

2017年,谷歌团队在论文《Attention Is All You Need》中提出了一个激进的想法:抛弃循环和卷积,完全依靠注意力机制来处理序列。

这就像是从“逐字阅读”变成了“一眼扫过全文,同时关注所有重要部分”。

2017年,Transformer架构的提出彻底改变了游戏规则。其核心创新——注意力机制——允许模型在处理当前信息时,“注意”到输入序列中的任何部分,无论距离多远。这相当于给AI装上了“可调节的聚光灯”,可以按需照亮记忆中的相关部分。

但Transformer本身仍然有上下文窗口的限制,通常只能记住几千个词元(token)。超出这个范围的信息就会“溢出”。

整体架构:编码器-解码器框架

输入 → 编码器(理解输入) → 解码器(生成输出) → 输出

关键组件一:自注意力机制(Self-Attention)

这是Transformer的灵魂。让我们用一个简单例子理解:

句子:“猫追老鼠,因为它饿了”

问题:“它”指的是谁?

人类能瞬间知道“它”指的是“猫”,因为我们同时看到了整个句子,并理解了其中的关系。

自注意力如何工作:

为每个词创建三个向量:

查询向量(Query):“我想知道什么?”

键向量(Key):“我是谁?”

值向量(Value):“我实际的信息是什么?”

计算注意力分数:

对于“它”的查询,计算与句子中每个词的键的匹配度

“猫”得分高,“老鼠”得分低,“饿了”得分中等

加权求和:

用这些分数作为权重,对所有的值向量加权求和

结果:“它”的表示会包含更多“猫”的信息

关键组件二:多头注意力(Multi-Head Attention)

如果自注意力像是用一束聚光灯照亮重要的词,那么多头注意力就像是用多个不同颜色的聚光灯从不同角度同时照射。

每个“头”学习不同的注意力模式:

一个头可能关注语法关系(主谓一致)

另一个头可能关注语义关系(同义替换)

第三个头可能关注指代关系(代词指向)

关键组件三:位置编码(Positional Encoding)

由于Transformer没有循环或卷积,它本身不知道词的顺序。“猫追老鼠”和“老鼠追猫”会被视为相同的词袋。

解决方案:为每个位置添加一个独特的“位置信号”

词嵌入 + 位置编码 = 带有位置信息的词表示

位置编码使用正弦和余弦函数,确保模型能理解相对位置和绝对位置。

关键组件四:前馈网络(Feed-Forward Network)

每个注意力层后面跟着一个简单但强大的前馈网络,独立处理每个位置的信息。

关键组件五:残差连接和层归一化

残差连接:将输入直接加到输出上

解决深度网络中的梯度消失问题

让模型可以轻松学习恒等映射

层归一化:稳定训练过程

对每个样本单独归一化

加速收敛,提高稳定性

第三波:外部记忆库与检索增强

最新的突破是将AI与外部记忆系统相结合。AI Agent不再仅仅依赖模型内部的参数记忆,而是能够:

将重要信息存储在外部数据库中

在需要时检索相关信息

不断更新和整理记忆内容

这就像是给AI配备了一个不断增长的“思维图书馆”,而模型本身则是熟练的图书管理员,知道在何时、如何查找和使用这些知识。

3. 记忆能力的核心技术突破

1. 向量数据库:记忆的存储方式

现代AI Agent使用向量嵌入(embeddings)将文本、图像等信息转换为高维向量,并存储在专门的向量数据库中。当需要回忆时,Agent会计算当前查询的向量表示,并在数据库中搜索最相关的记忆向量。

# 简化的记忆存储与检索过程示意

store_memory(embedding_function(text), metadata)

relevant_memories = retrieve_similar(embedding_function(query), top_k=5)2. 记忆检索:找到正确的回忆

检索过程不只是简单的关键词匹配,而是基于语义相似性的智能搜索。即使查询与存储记忆使用不同的表述方式,系统仍能找到相关记忆。

3. 记忆更新:学习与遗忘的平衡

高效的记忆系统不仅需要记住,还需要:

-

优先级排序:重要记忆更容易被检索

-

记忆整合:将相关记忆连接成知识网络

-

选择性遗忘:降低过时或不准确信息的权重

-

记忆巩固:通过“回放”重要记忆加强记忆痕迹

4. 记忆的层级结构:从瞬间到终身

现代AI Agent正在发展出类似人类的记忆层次:

-

感觉记忆:瞬时处理原始输入

-

工作记忆:短期保持和处理信息(当前对话上下文)

-

情景记忆:记录特定事件和经历(用户的历史交互)

-

语义记忆:存储事实和概念知识(领域专业知识)

-

程序记忆:保存技能和操作步骤(如何完成任务)

记忆不仅是信息的存储,更是智能的基础。它连接过去与现在,为决策提供上下文,为学习提供材料,为个性提供连续性。随着AI Agent记忆能力的不断发展,我们正在见证一种新型智能的诞生——不仅能够计算,还能够回忆、反思和成长。

这种进化将重新定义我们与AI的关系,从工具到助手,从执行者到合作伙伴,甚至可能成为某种形式的“数字伙伴”。在这个旅程中,我们需要谨慎前行,既要开发强大的记忆能力,也要建立适当的护栏,确保这项技术真正服务于人类的福祉。

毕竟,最好的记忆不是简单地存储更多信息,而是以更智慧的方式使用这些信息,帮助我们——无论是人类还是AI——做出更明智、更富有同情心的决策。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)