从 Vision Pro 到 AI 眼镜:苹果“Project Atlas”如何押注无屏空间计算

【摘要】苹果正从 Vision Pro 的重型空间计算范式,转向以“Project Atlas”为代表的轻量化 AI 眼镜。此举押注无屏形态,旨在通过 AI 驱动的视觉与音频交互,打造全天候可穿戴的个人计算设备。

【摘要】苹果正从 Vision Pro 的重型空间计算范式,转向以“Project Atlas”为代表的轻量化 AI 眼镜。此举押注无屏形态,旨在通过 AI 驱动的视觉与音频交互,打造全天候可穿戴的个人计算设备。

引言

苹果 Vision Pro 系列,历经两代硬件迭代,成功在 XR 领域展示了其无与伦比的技术实力。无论是 M 系列芯片提供的断档算力,还是顶级的 Micro-OLED 显示系统,都为“空间计算”这一概念设定了行业标杆。然而,技术的肌肉秀并未完全转化为市场的持续热情。以近期发布的 Vision Pro M5 为例,其开售初期的热度窗口极为短暂,通常在一个月后便迅速冷却。

究其根本,M5 的升级更像是对既有体验的精细打磨,例如提升 Mac 虚拟显示的刷新率,而未能触及初代产品遗留的核心症结。高昂的售价、超过 600 克的机身重量、以及尚不成熟的应用生态,这三座大山共同构成了用户难以将其融入日常生活的壁垒。当最初的新鲜感褪去,用户回归理性思考,设备便不可避免地走向“吃灰”的命运。这种现象清晰地表明,当前空间计算设备在技术上的“性能冗余”,与用户实际需求的“体验必需”之间存在巨大鸿沟。

正是在这一背景下,苹果内部代号为“Project Atlas”的项目浮出水面。它所指向的并非 Vision Pro 的 очередная迭代,而是一个截然不同的产品形态——轻量化的 AI 眼镜。这标志着苹果的战略思考正在发生一次深刻的钟摆运动,从追求极致沉浸的“头戴式电脑”,转向探索低打扰、全天候的“个人智能助理”。本文将深入剖析这一战略转向背后的技术权衡、交互重构与市场博弈。

🔮 一、战略的钟摆:从“性能冗余”到“体验必需”

苹果在可穿戴设备领域的每一步都经过深思熟虑。从 Apple Watch 定义智能手表,到 AirPods 占领无线音频市场,其成功路径始终围绕着一个核心,即如何将技术无缝融入用户的日常生活。Vision Pro 的出现,更像是一次对技术边界的探索,而“Project Atlas”则代表着向用户体验本源的回归。

1.1 Vision Pro 的技术验证与市场困境

Vision Pro 的历史使命,首先是完成技术可行性的验证。它向世界证明,一台消费级设备能够承载桌面级的操作系统(visionOS),并实现高精度的手眼追踪与空间感知。这为后续所有空间计算的讨论奠定了基础。但作为一款产品,它在市场上遭遇的挑战同样是教科书级别的。

1.1.1 三大核心短板

-

重量与佩戴负担:这是最直观的物理障碍。接近 700 克的重量,意味着用户很难连续佩戴超过一小时。这种“头戴负担”直接将其使用场景限制在静态、短时的特定任务中,例如观影或专注工作,彻底排除了移动与社交的可能性。

-

高昂的成本结构:其售价主要由两块顶级的 4K Micro-OLED 屏幕、复杂的传感器阵列以及 M+R 双芯片架构所决定。这使其价格远超普通消费电子产品范畴,更接近于专业生产力工具或开发者套件,天然地将大众消费者拒之门外。

-

应用生态的“鸡生蛋”难题:尽管苹果提供了强大的开发工具,但高昂的设备门槛导致用户基数受限,开发者缺乏足够的动力去创造“杀手级”应用。反过来,缺乏不可替代的应用场景,又让潜在用户找不到购买的充分理由。发布至今,其应用生态仍未摆脱初期以内容消费和轻度交互为主的局面。

Vision Pro M5 的市场表现,正是这些结构性问题的集中体现。它未能带来任何革命性的体验突破,因此无法重新点燃市场热情。这让苹果清醒地认识到,沿着“堆料”路线继续走下去,短期内无法实现可穿戴设备的普及梦想。

1.2 “Project Atlas”的诞生:重新定义“可穿戴”

“Project Atlas”项目的启动,标志着苹果研发思路的重大转变。据 9to5Mac 等媒体报道,该项目的一个关键动作是进行大规模内部用户研究,专门收集员工对现有智能眼镜,特别是 Meta Ray-Ban 系列的反馈。

这种做法在苹果内部并不常见,它透露出两个重要信号:

-

承认市场已有验证者:苹果承认 Meta 在轻量化智能眼镜这条路上做对了某些事,成功找到了产品与市场的初步契合点。

-

寻求根本性问题的答案:研究的核心不再是“如何塞进更强的性能”,而是回归本源——“普通人为什么愿意全天佩戴一副智能眼镜?”

这个问题的答案,直接导向了与 Vision Pro 完全相反的设计哲学。如果说 Vision Pro 是做加法,追求功能的完备性;那么 AI 眼镜就是做减法,追求体验的无扰性。其产品定位的核心,从“沉浸式体验”转向了**“全天候可穿戴”与“低打扰交互”**。这意味着,设备的物理形态、功耗控制和交互模式都必须进行彻底的重新设计。

⚙️ 二、架构解耦:无屏形态下的技术权衡

要实现全天候佩戴,首先必须解决重量、功耗和发热这三大物理难题。苹果在“Project Atlas”中给出的答案,极有可能是首代产品采用“无屏”路线。这是一个大胆但逻辑自洽的决策,它将直接重塑整个设备的硬件架构与成本结构。

2.1 “无屏”决策的背后:成本、功耗与重量的平衡术

显示模组是 Vision Pro 中成本最高、功耗最大、重量最显著的部件。砍掉屏幕,意味着一次性解决了多个核心瓶颈。

|

权衡维度 |

Vision Pro (有屏) |

Apple AI Glasses (无屏) |

带来的优势 |

|---|---|---|---|

|

重量 |

Micro-OLED 屏幕、光学透镜组、散热系统占据主要重量 |

无显示模组,重量可控制在 30-50g 区间 |

实现与普通眼镜无异的佩戴感,是全天候佩戴的基础 |

|

功耗 |

两块 4K 屏幕是耗电大户,需要外置电池 |

功耗主要来自传感器、芯片与音频单元,大幅降低 |

续航能力有望覆盖全天,摆脱续航焦虑 |

|

发热 |

M 系列芯片与高分辨率显示产生巨大热量,需主动散热 |

低功耗芯片与传感器发热量小,可被动散热 |

提升佩戴舒适度,避免面部灼热感 |

|

成本 |

定制 Micro-OLED 屏幕成本极高 |

成本结构转向芯片、传感器与精密制造 |

定价有望进入 299-499 美元的大众消费区间 |

|

设计 |

形态受限于光学结构,体积庞大,外观科技感强 |

设计自由度高,可无限趋近于传统时尚眼镜 |

降低社交障碍,让用户愿意在公共场合佩戴 |

通过这张对比表可以清晰地看到,“无屏”是实现产品定位从“极客玩具”向“日常用品”跃迁的关键一步。苹果将产品的价值点,从视觉沉浸转移到了基于现实世界的 AI 增强。设备的核心不再是显示内容,而是感知世界。

2.2 算力分离模型:端侧感知与 iPhone 协同计算

砍掉屏幕并不能解决所有问题。一副 40 克的眼镜镜腿,其物理空间和散热能力都极其有限,无法容纳 M 系列甚至 A 系列这样的高性能芯片。因此,苹果大概率会采用一种算力分离的协同计算架构,这与早期 Apple Watch 的设计思路如出一辙。

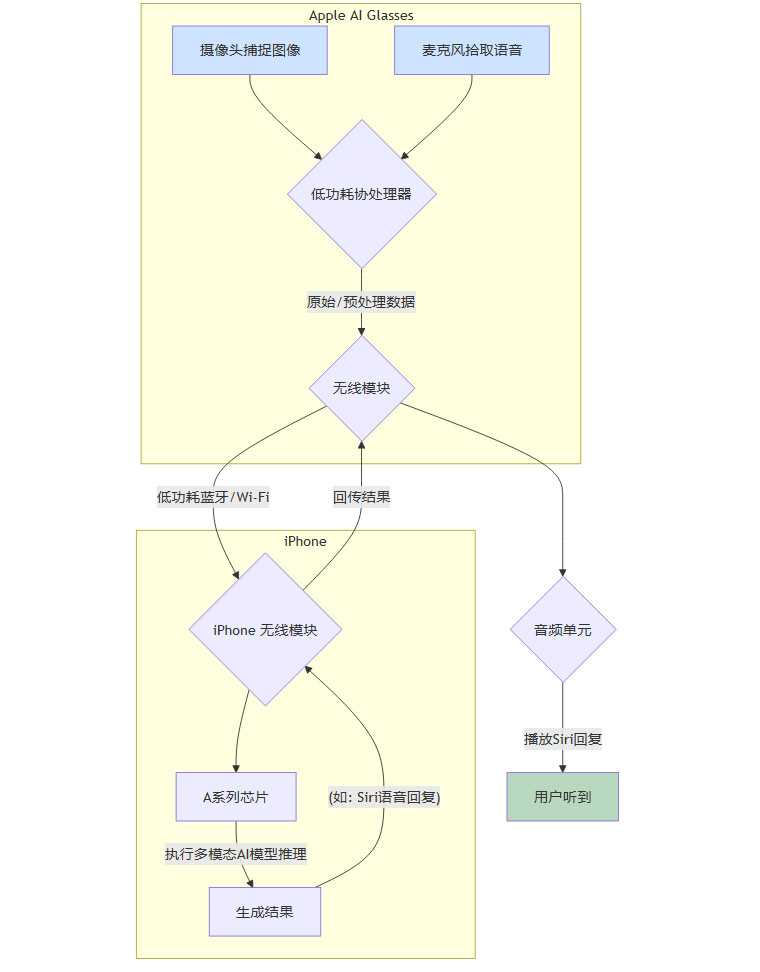

这种架构可以被理解为一个两级处理模型:

-

眼镜端(轻量级处理):眼镜本身集成一颗低功耗的协处理器(可能类似 AirPods 中的 H 系列或 Apple Watch 中的 S 系列芯片的变种)。它的主要职责是实时数据采集与预处理,包括:

-

驱动摄像头进行图像捕捉。

-

运行麦克风阵列进行语音唤醒和初步降噪。

-

处理 IMU(惯性测量单元)数据以追踪头部姿态。

-

管理蓝牙等无线连接。

-

-

iPhone 端(重量级处理):眼镜通过低功耗蓝牙或 Wi-Fi 与用户的 iPhone 保持连接。绝大多数复杂的计算任务,特别是多模态 AI 模型的推理,都在 iPhone 上完成。iPhone 强大的 A 系列芯片将作为眼镜的“外置大脑”,处理完数据后再将结果(如 Siri 的语音回复)回传至眼镜。

下面是一个简化的 Mermaid 流程图,展示了这一协同过程:

这种**“端侧感知 + 手机协同”**的模式,是在当前技术条件下,平衡设备轻便性、续航能力与智能体验的最佳方案。它牺牲了设备的独立性,但换来了用户最关心的全天候佩戴可能性。

2.3 传感器矩阵:构建情境感知的基石

无屏 AI 眼镜的核心能力在于感知。因此,一个高度集成且低功耗的传感器矩阵是其硬件基石。除了最核心的摄像头和麦克风,它还可能包括:

-

高分辨率摄像头:用于捕捉高质量的图像和视频,是所有视觉 AI 功能的基础。

-

麦克风阵列:至少包含多个麦克风,用于实现波束成形,精准拾取用户语音,并抑制环境噪声。

-

惯性测量单元 (IMU):包括加速度计和陀螺仪,用于精确追踪用户的头部运动和姿态,为未来的空间音频或简单的手势交互提供数据支持。

-

环境光传感器:用于感知环境光照变化,未来可能用于辅助摄像头调整曝光,或触发某些情境模式。

-

佩戴检测传感器:类似 AirPods Pro 上的皮肤识别传感器,用于检测眼镜是否被佩戴,以实现自动播放/暂停、连接/断开等智能化操作。

这些传感器共同构成了一个多维度的感知系统,让眼镜能够实时理解用户所处的环境和意图,为上层的 AI 应用提供丰富、高质量的输入数据。

🧠 三、交互重构:AI 驱动的视觉与听觉闭环

在无屏形态下,传统的图形用户界面 (GUI) 不复存在。取而代之的,将是一种全新的、以多模态 AI 为核心的自然交互范式。苹果的目标是创造一个无缝的交互闭环,让用户通过最自然的动作——“看”和“说”,就能完成信息获取与任务执行。

3.1 核心交互范式:“摄像头 + Siri + 多模态 AI”

这种新范式的核心逻辑是用视觉输入替代手动输入,用语音输出替代屏幕输出。iPhone 上已经出现的“视觉智能”功能,极有可能是为这副眼镜所做的技术预演。

未来的典型场景可能如下:

-

情境识别:用户看向一家餐厅,轻点镜腿或说出唤醒词,眼镜上的摄像头捕捉画面,Siri 会通过耳机告知这家店的评分、特色菜,甚至实时排队情况。

-

实时翻译:在国外旅行时,看向路牌或菜单,Siri 会直接将翻译后的内容读给用户听。

-

物体识别与信息查询:看到一株不认识的植物,或一件感兴趣的商品,眼镜可以立即识别并提供相关信息。

-

视觉辅助:帮助视障用户识别前方的障碍物、读取信件内容,或辨认钞票面额。

这种“所见即所得”的交互方式,其效率远高于传统流程。它将**“掏出手机 -> 解锁 -> 打开 App -> 扫描/输入”**这一系列步骤,简化为了一个下意识的动作。这背后依赖的,正是强大的多模态 AI 模型,它能够理解图像内容,并将其与用户的语音指令或上下文情境相结合,做出准确的响应。

3.2 音频技术的挑战与机遇

既然主要的输出方式是音频,那么音频体验的质量就直接决定了产品的成败。这其中既有机遇,也有巨大的工程难题。

3.2.1 机遇:空间音频与自适应音频的延伸

苹果在 AirPods 系列上积累的音频技术,可以无缝迁移到 AI 眼镜上。

-

空间音频:结合 IMU 的头部追踪,Siri 的声音可以听起来像是来自空间中的某个固定位置,或者来自 iPhone 所在的方向,让交互体验更加自然和沉浸。

-

自适应音频:当用户开始说话时,眼镜可以自动降低正在播放的音乐音量,并增强环境中的人声;当对话结束,再平滑地恢复音乐。这使得在听内容与和人交流之间的切换变得毫不费力。

3.2.2 挑战:漏音是最大的工程难题

对于眼镜形态的音频设备而言,漏音是最大的社交尴尬。如果用户与 Siri 的私密对话被旁边的人听到,产品的可用性将大打折扣。苹果需要解决这个开放式声学环境下的难题。

目前业界探索的方向主要有两种:

-

定向扬声器:通过微型扬声器阵列,将声波以非常窄的角度直接传递到用户的耳道口,减少向周围环境的扩散。

-

波束成形与相位抵消:这是一种更复杂的技术。它不仅利用波束成形将声音聚焦,还可能在镜腿外侧产生与泄漏声音相位相反的声波,从而在外部空间实现主动的声音抵消。这类似于 HomePod 的空间感知技术,但需要在一个微型化、移动化的设备上实现。

解决漏音问题,将是 Apple AI Glasses 能否被用户在办公室、公共交通等安静环境中接受的关键。

3.3 隐私的再设计:信任是佩戴的前提

一个时刻朝向外界的摄像头,引发的隐私担忧是巨大的。用户不仅担心自己的隐私被侵犯,也担心自己成为他人隐私的侵犯者。苹果必须在产品设计和系统层面建立一套全新的信任机制。

-

明确的可视化指示:设备在进行拍摄或录音时,必须有一个清晰、无法被软件禁用的物理指示灯。这是 Meta Ray-Ban 已经采用并被证明行之有效的方法,让周围的人能够明确感知到设备的运行状态。

-

强化端侧处理:对于敏感数据,如人脸识别特征、个人物品的图像等,应尽可能在设备端或用户的 iPhone 上进行处理,避免上传云端。苹果在“私密计算云”上的投入,也可能为此类场景提供技术保障。

-

透明的权限管理:visionOS 和 iOS 需要为 AI 眼镜设计一套全新的、颗粒度极高的权限管理系统。用户可以清晰地看到哪个应用在何时访问了摄像头或麦克风,并能随时撤销授权。

-

品牌形象的背书:相比以广告业务为核心的竞争对手,苹果长期以来建立的“隐私至上”的品牌形象,将是其推广此类产品的最重要资产。用户可能更愿意相信苹果不会滥用他们的数据。

构建隐私信任体系的复杂性,不亚于任何一项硬件技术的攻关。这将是决定 AI 眼镜能否跨越社会接受度鸿沟的核心要素。

⚔️ 四、市场博弈:在巨人的棋局中落子

苹果进入任何一个新领域,都必然会搅动现有的市场格局。在智能眼镜赛道,河里已经站着两位巨人,Meta 和 Google。苹果的策略并非凭空创造,而是在深刻洞察对手动作后,选择了一条最适合自己的切入路径。

4.1 狙击 Meta Ray-Ban,避战 Orion

在智能眼镜领域,Meta 无疑是当前最激进、也最成功的玩家。其与雷朋合作的 Meta Ray-Ban 智能眼镜,已经成为该品类第一个真正意义上的“爆款”。

Meta Ray-Ban 的成功,关键在于其极度的产品克制。它没有试图将一台手机塞进眼镜里,而是首先确保它是一副外观时尚、佩戴舒适的雷朋眼镜。在此基础上,它只集成了三个核心功能:拍照、听歌、问 AI。这种“首先是好眼镜,其次才是智能设备”的产品哲学,已经被市场证明是行得通的,而这正是苹果目前正在借鉴的思路。

与此同时,Meta 也在布局更遥远的未来。其内部代号为“Orion”的项目,目标是打造拥有真正全息显示和神经肌电手环交互的终极 AR 眼镜。然而,Orion 目前仍处于成本高达数万美元的原型机阶段,更像是一个展示技术实力的图腾,距离量产遥遥无期。

面对 Meta 的双线布局,苹果的策略显得非常务实和精准:

-

短期目标:Apple AI Glasses 并非要对标遥不可及的 Orion,而是要直接狙击已经验证了市场需求的 Meta Ray-Ban。

-

战略算盘:在“真 AR”眼镜的成本和技术成熟之前(这可能还需要 5-10 年),利用“AI 眼镜”这一形态,先占领用户的心智和鼻梁。这是一种典型的市场占位策略,即在终极形态到来前,用一个体验更优的过渡形态产品来收割市场。

4.2 Google 的平台化变量

另一边的 Google 也没有停下脚步。尽管当年的 Google Glass 遭遇滑铁卢,但 Google 在多模态 AI 领域的深厚积累,使其依然是牌桌上不可忽视的力量。其在 I/O 大会上展示的 Project Astra,演示了 AI 通过摄像头实时理解世界的能力,这与苹果的视觉智能方向异曲同工。

但与苹果不同,Google 目前的策略似乎更倾向于打造一个大一统的“Android XR”平台。它希望通过开放平台,拉拢三星、XREAL 等众多硬件厂商,共同构建一个繁荣的 XR 生态。这本质上是智能手机时代 Android vs. iOS 战局在 XR 领域的重演。

-

Google 的优势:在于其强大的 AI 数据积累和平台号召力,能够快速催生出形态各异的硬件产品,实现市场的广度覆盖。

-

苹果的应对:苹果的强项始终在于软硬一体的垂直整合。它不追求硬件形态的多样性,而是专注于打造一款标杆级的自研产品,并通过生态系统提供无与伦比的连续性体验。

4.3 苹果的护城河:生态连续性

面对 Meta 的先发优势和 Google 的平台野心,苹果最深的护城河,依然是其无缝衔接的生态系统。这是一种其他厂商难以复制的、系统级的降维打击。

想象一下这些场景:

-

跨设备任务流:眼镜识别到一个电话号码,用户只需轻点镜腿,iPhone 就会自动拨出;会议中听到的关键信息,可以直接生成纪要,并无缝同步到 Mac 的备忘录中。

-

空间感知联动:当用户找不到自己的 AirTag 时,可以询问 Siri,眼镜上可能会通过空间音频,以声音指向的方式引导用户找到物品。

-

健康与运动:眼镜可以与 Apple Watch 联动,在用户跑步时,通过音频实时反馈心率、配速等数据,而无需低头看表。

这种跨设备的连续性体验,将 AI 眼镜从一个孤立的信息节点,变为了苹果个人计算生态中一个全新的、永远在线的感知入口。这才是苹果真正的杀手锏,也是其敢于后发制人的底气所在。

👓 五、产品实现:从概念到鼻梁的最后一公里

一个再宏大的战略,最终也要落到一副具体的、可供用户佩戴的产品上。对于 Apple AI Glasses 而言,设计的最后一公里,在于如何处理好重量、形态以及对特殊人群的适配问题。

5.1 设计目标:40 克的“无感佩戴”

根据彭博社 Mark Gurman 等多个可靠信源的爆料,苹果为这款眼镜设定的重量目标,是进入普通眼镜的 30-50 克区间。

这是一个极具挑战性但又至关重要的指标。我们可以通过一个简单的重量对比来理解其意义:

-

普通近视眼镜:约 20-30 克

-

Meta Ray-Ban 智能眼镜:约 49 克

-

Apple Vision Pro:约 600-650 克

如果苹果能将重量控制在 40 克左右,用户将几乎可以实现“无感佩戴”。这直接决定了产品能否从一个需要“下定决心”才佩戴的设备,转变为一个用户早上出门会下意识戴上的日常配饰。重量,是区分“科技玩具”与“生活工具”的第一道分水岭。

5.2 光学适配:拥抱庞大的近视群体

任何一款想要普及的眼镜产品,都无法忽视全球数以亿计的近视用户。如果智能眼镜无法解决处方镜片的问题,就意味着它将自动放弃最大的一块市场。

苹果在这方面已有经验。其在 Vision Pro 上与光学巨头蔡司的合作,已经验证了一套成熟的定制镜片流程。对于形态更简单的 AI 眼镜,苹果极有可能采用一种更便捷的方案,例如:

-

磁吸式处方镜片:用户可以单独购买符合自己度数的镜片,通过磁力吸附在眼镜框架内侧。

-

卡扣式结构:提供一种标准化的卡扣接口,让合作的光学厂商能够生产可快速安装和拆卸的处方镜片。

解决近视适配问题,不仅仅是技术问题,更是一个关乎渠道、销售和售后服务的体系化工程。只有当用户可以像配普通眼镜一样,方便快捷地为 Apple AI Glasses 配上处方镜片时,它才真正具备了替代用户鼻梁上那副旧眼镜的潜力。

📈 六、前瞻与展望:时间表、定价与终极愿景

综合目前供应链和分析师的预测,我们可以对 Apple AI Glasses 的未来路径进行一次合理的推演。

6.1 发布时间:软件先行,硬件在后

从目前项目仍处于内部大规模调研的阶段来看,Apple AI Glasses 大概率不会在 2025 年上半年发布。一个更现实的时间表是 2026 年甚至 2027 年。

这背后遵循了苹果一贯的“软件先行”策略。硬件的发布,往往滞后于软件和生态的铺垫。决定这副眼镜智商上限的,并非硬件本身,而是 AI 版本的 Siri 以及 visionOS/iOS 的多模态能力。我们可以预见,在未来一到两年的 WWDC 上,苹果会逐步展示一个更强大、更懂情境的 Siri。当软件能力储备成熟时,才是硬件登场的最佳时机。毕竟,如果 Siri 还是那个只能定闹钟的语音助手,那么这副眼镜的体验将大打折扣。

6.2 定价推测:迈向“甜点级”消费市场

与 Vision Pro 高高在上的定价不同,业界普遍认为 Apple AI Glasses 的定价会亲民得多。由于砍掉了最昂贵的 Micro-OLED 屏幕,其成本结构将发生根本性改变。

一个合理的定价区间,可能是在 299 美元至 499 美元之间。

-

对标 Meta Ray-Ban:其起售价为 299 美元,苹果可能会选择一个略高的价位以体现品牌和生态溢价。

-

卡位“甜点级”:499 美元(约合人民币 3500 元)的价格,虽然比普通眼镜贵,但已经进入了许多消费者“愿意尝鲜”的范围,与 Apple Watch 的部分型号相当。

这个价格定位,清晰地表明了苹果的野心。它不希望 AI 眼镜再次成为少数极客的玩物,而是要将其打造成一款能够规模化销售、真正进入大众市场的主流产品。

结论

从 Vision Pro 的“性能肌肉秀”,到“Project Atlas”的“体验轻量化”,苹果在空间计算领域的战略路径正变得愈发清晰。Vision Pro 负责向上探索技术的极限,定义交互的未来;而 AI 眼镜则负责向下扎根,解决普及的难题。

这种从“把电脑戴在头上”的激进,转向“给眼镜装上智慧”的务实,更像是一种库克时代的典型打法。它不追求参数的暴力堆砌,而是试图通过 AI 与生态的深度融合,润物细无声地改变用户的日常生活。当 Meta 在描绘未来的全息梦想,Google 在构建通用的 AI 大脑时,苹果选择了一条最稳健的路:先做一副你能戴得出去的眼镜,再让它变得足够聪明。

这或许不是最科幻的路径,但它可能是通往“取代 iPhone”这一终极目标的、最坚实的第一步。

📢💻 【省心锐评】

苹果正用“减法”重塑可穿戴未来。砍掉屏幕的 AI 眼镜,以轻量化和 AI 交互为核心,旨在通过生态联动狙击 Meta,这步棋比 Vision Pro 更接近个人计算的下一章。

更多推荐

已为社区贡献519条内容

已为社区贡献519条内容

所有评论(0)