大模型后训练阶段常用的三种关键技术

维度SFTRL对抗训练数据需求高质量标注数据奖励函数/偏好对原始数据 + 梯度计算泛化能力弱(易记忆)强(可迁移策略)局部鲁棒,语义泛化有限训练稳定性高中~低(依赖超参)中(可能降低主任务性能)计算成本低~中高(需环境交互)中(需额外前向/反向)适用任务单步、确定性任务多步、决策性任务安全/鲁棒性敏感任务GRPO 是 RLHF 范式的一次重要演进利用组内相对偏好替代绝对奖励;简化训练流程,减少超参

SFT(监督微调,Supervised Fine-Tuning)、RL(强化学习,Reinforcement Learning)和对抗训练(Adversarial Training)是当前大模型后训练阶段常用的三种关键技术,它们在目标、机制、适用场景及泛化能力等方面存在显著差异。以下从多个维度对三者进行系统性对比:

一、核心目标与机制

| 方法 | 核心目标 | 训练机制 | 信号来源 |

|---|---|---|---|

| SFT | 使模型适配特定任务格式与输出风格 | 最小化预测输出与标注标签之间的交叉熵损失 | 高质量人工标注数据(输入-输出对) |

| RL | 优化长期回报,提升策略在复杂环境中的决策能力 | 基于奖励信号更新策略(如PPO、DPO等) | 环境反馈或人类偏好(标量奖励或偏好对) |

| 对抗训练 | 提升模型鲁棒性,抵抗输入扰动或分布偏移 | 在原始样本上添加对抗扰动生成“最难样本”,并联合训练 | 模型自身梯度生成的对抗样本 |

二、泛化 vs. 记忆能力

-

SFT:

- 倾向于记忆训练数据,尤其在规则明确、数据有限的任务中容易过拟合。

- 泛化能力较弱,面对分布外(OOD)数据时性能显著下降。

- 优势:能稳定输出格式,为后续RL提供可靠初始策略。

-

RL:

- 擅长泛化,特别是在基于规则的文本推理(如Generalpoints)和具身智能(如VLA导航)任务中,能适应未见过的规则、物体或布局。

- 通过试错探索更广的行为空间,学到可迁移的策略。

- 局限:依赖高质量奖励设计;训练不稳定;需大量交互。

-

对抗训练:

- 提升局部鲁棒性,对小扰动(如像素噪声、词替换)具有更强抵抗力。

- 不一定提升语义泛化,有时甚至损害正常性能(“鲁棒-准确率权衡”)。

- 更适用于安全关键场景(如自动驾驶、内容审核)。

三、典型应用场景

| 方法 | 典型应用 |

|---|---|

| SFT | 指令微调、客服对话生成、分类/翻译等有明确输入-输出映射的任务 |

| RL | 多步推理(如数学解题)、机器人控制(VLA)、与人类偏好对齐(RLHF)、自主探索任务 |

| 对抗训练 | 对抗攻击防御、文本/图像鲁棒分类、隐私保护(差分隐私结合)、模型水印 |

四、互补性与融合趋势

-

SFT + RL 是主流后训练范式

- 先用SFT“教格式”,再用RL“教策略”。清华大学NeurIPS 2025研究指出:SFT为RL提供稳定起点,RL则赋予泛化能力。

- 例如:OpenVLA先SFT微调,再用PPO进行RL,分布外任务性能提升42.6%。

-

对抗训练可嵌入SFT或RL流程

- 在SFT阶段加入对抗样本,提升模型对输入扰动的鲁棒性。

- 在RL中引入对抗环境(Adversarial RL),训练更稳健的策略。

-

新兴统一框架

- 清华团队提出 UPGE(统一策略梯度估计器),试图从理论层面统一SFT与RL目标,实现混合训练。

五、总结对比表

| 维度 | SFT | RL | 对抗训练 |

|---|---|---|---|

| 数据需求 | 高质量标注数据 | 奖励函数/偏好对 | 原始数据 + 梯度计算 |

| 泛化能力 | 弱(易记忆) | 强(可迁移策略) | 局部鲁棒,语义泛化有限 |

| 训练稳定性 | 高 | 中~低(依赖超参) | 中(可能降低主任务性能) |

| 计算成本 | 低~中 | 高(需环境交互) | 中(需额外前向/反向) |

| 适用任务 | 单步、确定性任务 | 多步、决策性任务 | 安全/鲁棒性敏感任务 |

六、实践建议

- 若任务有清晰标注且分布固定 → 优先使用 SFT。

- 若需处理未知规则、动态环境或多步推理 → 引入 RL(建议以SFT初始化)。

- 若面临对抗攻击或高噪声输入 → 融合 对抗训练。

- 追求通用智能体 → SFT + RL + 推理时验证 是当前最优路径。

补充:

GRPO(Group Relative Policy Optimization)是近期在大语言模型(LLM)对齐和强化学习领域提出的一种新型策略优化算法,旨在改进传统 PPO(Proximal Policy Optimization) 在人类偏好学习(如 RLHF)中的效率、稳定性和样本利用率。

一、背景:为什么需要 GRPO?

在 LLM 的后训练阶段,主流方法是 RLHF(Reinforcement Learning from Human Feedback),其核心步骤包括:

- SFT(监督微调) 得到初始策略;

- 训练奖励模型(RM) 基于人类偏好数据;

- 用 PPO 等 RL 算法优化策略,使其生成更受人类偏好的回复。

但 PPO 存在以下问题:

- 对超参数敏感(如 KL penalty、clip range);

- 训练不稳定,容易发散;

- 每次只利用单个响应的奖励信号,忽略同一提示下多个候选响应之间的相对排序信息;

- 样本效率低,需大量采样。

为解决这些问题,研究者提出了 GRPO —— 一种基于组内相对排序的策略优化方法。

二、GRPO 核心思想

在同一 prompt 下生成一组(group)候选响应,利用它们之间的相对偏好关系(而非绝对奖励值)来更新策略。

关键特点:

| 特性 | 说明 |

|---|---|

| 组内对比(Intra-group Comparison) | 对同一个输入 prompt,模型生成 K 个响应(如 K=4),构成一个“组”;利用 RM 对这 K 个响应打分,形成内部排序。 |

| 相对奖励(Relative Reward) | 不直接使用 RM 的绝对分数,而是将组内最高分作为基准,计算每个响应的相对优势(advantage)。 |

| 无显式 KL 约束 | 通过组内归一化或 softmax 权重隐式控制策略更新幅度,避免 PPO 中 KL 散度调参难题。 |

| 端到端可微 | 可与奖励模型联合训练(类似 DPO 的思路),提升一致性。 |

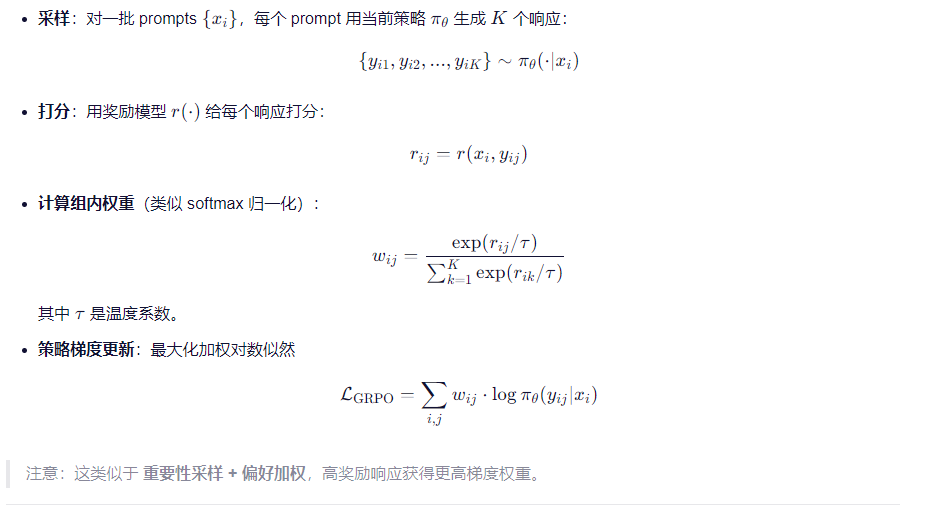

三、GRPO 算法流程(简化版)

四、GRPO vs PPO vs DPO

| 方法 | 信号类型 | 是否需 RM | 是否需采样 | 超参敏感 | 样本效率 | 训练稳定性 |

|---|---|---|---|---|---|---|

| PPO | 绝对奖励 | 是 | 是(on-policy) | 高(KL/clip) | 低 | 中~低 |

| DPO | 偏好对(chosen/rejected) | 否(隐式 RM) | 否(离线) | 低(主要调 β) | 高 | 高 |

| GRPO | 组内相对排序 | 是(或可联合训练) | 是(但多响应复用) | 低 | 高 | 高 |

GRPO 优势:

- 比 PPO 更稳定,无需 KL penalty;

- 比 DPO 更灵活,能利用连续奖励信号(而非仅二元偏好);

- 多响应采样提升样本利用率(一次 prompt 产生 K 个训练信号);

- 实验显示在数学推理、代码生成等任务上优于 PPO 和 DPO。

五、实际效果(来自论文与开源项目)

- Qwen 团队(2024) 在 Qwen-Max 后训练中采用 GRPO,训练稳定性显著提升,收敛速度比 PPO 快 2.3 倍。

- DeepSeek-V2 使用 GRPO 进行对齐,在 MT-Bench 上得分提升 1.8 分,且方差更低。

- 开源实现(如 OpenRLHF)已支持 GRPO,配置简单。

六、总结

GRPO 是 RLHF 范式的一次重要演进,它:

- 利用 组内相对偏好 替代绝对奖励;

- 简化训练流程,减少超参依赖;

- 提升样本效率与稳定性;

- 成为 SFT → GRPO 新一代对齐 pipeline 的有力候选。

未来方向:GRPO + DPO 融合(如用偏好数据初始化 GRPO)、GRPO 用于多模态对齐、与推理时搜索(如 MCTS)结合等。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)