测试AIGC应用:当输出不再是确定性结果

摘要:生成式AI(AIGC)的兴起正在颠覆传统软件测试范式。面对非确定性输出、多维评估需求等挑战,测试方法需从二进制断言转向概率化评估,建立置信度阈值和相似度度量体系,并融合众包评估与专家评审。测试工程师需掌握提示工程等新技术,思维模式从"缺陷检测"转向"适用性评估"。行业领先企业已构建分层评估框架,开源工具生态也在快速发展。这场测试范式的根本变革,将推动质

测试范式的根本性转变

随着生成式人工智能(AIGC)技术在各行业的深入应用,软件测试领域正面临前所未有的挑战。传统的二进制断言(True/False)测试框架在应对非确定性、创造性输出的AIGC系统时显露出局限性,这要求测试工程师从根本上重构质量评估体系。

一、AIGC应用的核心测试挑战

1.1 非确定性输出的本质特征

传统软件测试基于"相同输入必得相同输出"的基本假设,而AIGC系统每次调用可能产生符合要求但内容各异的响应。这种非确定性源于大型语言模型的概率采样机制、温度参数设置以及上下文窗口的动态性。

1.2 评估维度的多元化拓展

-

事实准确性:对抗"幻觉"输出的检测与量化

-

逻辑一致性:长文本生成中的上下文连贯性验证

-

安全合规性:敏感内容过滤与价值观对齐测试

-

创造性质量:文本/图像/代码生成的实用性与新颖度平衡

二、新兴测试方法论与实践框架

2.1 概率化断言系统

建立基于置信度阈值、相似度度量(如BLEU、ROUGE、余弦相似度)的评估体系,取代传统的精确匹配验证。开发针对AIGC的专属评估指标,包括:

-

语义一致性评分

-

风格保持度检测

-

指令遵循准确率

-

毒性内容出现频率

2.2 众包评估与专家评审机制

针对主观性较强的输出质量(如创意文案、艺术设计),构建人类反馈驱动的评估流水线。采用Likert量表、 pairwise比较等社会科学研究方法,建立可靠的人工评估标准。

2.3 连续监控与漂移检测

部署生产环境下的模型性能监控系统,跟踪关键指标:

-

输出质量随时间衰减趋势

-

输入分布偏移警报

-

边缘案例累积效应

-

资源消耗增长模式

三、测试工程师的能力转型路径

3.1 技术栈扩展需求

掌握提示工程、向量数据库、嵌入模型等AIGC相关技术,具备构建复杂测试工作流的能力。学习统计分析方法与数据可视化工具,应对概率化测试结果的解读需求。

3.2 测试思维模式进化

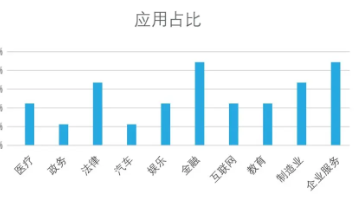

从"寻找缺陷"转向"评估适用性",培养基于风险评估的质量决策能力。建立领域知识深度,能够设计符合业务场景的专项测试用例,如法律文档生成的条款完整性验证、医疗咨询的安全边界测试等。

四、行业实践案例与工具生态

4.1 领先企业的测试架构

-

微软Azure AI:采用三层评估框架(单元测试、系统测试、红队测试)

-

Google Bard:实施实时学习与人工反馈融合的迭代机制

-

** Anthropic Claude**:构建宪法AI与基于原则的测试体系

4.2 开源测试工具演进

-

LMval:大规模语言模型评估套件

-

Checklist:自适应测试用例生成框架

-

AlpacaEval:自动化指令遵循评估系统

-

ToxiGen:隐式仇恨言论检测工具

结语:面向智能时代的质量工程

当软件输出从确定性走向创造性,测试工程师的角色正在从质量 gatekeeper 转变为体验架构师。构建适应非确定性系统的测试范式,不仅需要技术创新,更需要重新定义软件质量的维度与边界。这场范式变革将推动测试行业进入全新的发展阶段,为可信AI生态系统奠定坚实基础。

精选文章

更多推荐

已为社区贡献283条内容

已为社区贡献283条内容

所有评论(0)