Gemini 3 flash-不可能三角被打破了?

hi兄弟们,我是麦当mdldm,一个致力于把AI说明白、让大家都能用起来的0基础AI教学博主。

hi兄弟们,我是麦当mdldm,一个致力于把AI说明白、让大家都能用起来的0基础AI教学博主。

第一幕:不可能三角被打破了?

兄弟们,咱们玩AI的都知道一个“潜规则”,或者说是一个让人头疼的“不可能三角”:

模型要么聪明但死贵且慢(比如 Pro/Ultra 系列),要么便宜飞快但脑子不太灵光(比如 Flash/Mini 系列)。

每次我在做 coze教学 或者给企业做 AI通识培训 时,总有兄弟问我:“麦当,有没有那种既聪明、又快、还便宜的模型?我想用来跑复杂的Agent工作流,但GPT-5实在太肉疼了。”

以前我只能摊摊手说:“兄弟,想啥呢,鱼和熊掌不可兼得。”

但是今天,我看到谷歌发布的新闻,感觉脸被打得“啪啪”响——不过这脸打得我心里真爽。谷歌刚刚发布的 Gemini 3 Flash,似乎真的把桌子给掀了。

很多人看到“Flash”这个后缀,第一反应是:“哦,又是个为了省钱的阉割版吧?”

大错特错。 我深挖了一下数据和评测,发现这次谷歌不是在挤牙膏,而是在“降维打击”。

第二幕:不仅是“快”,更是“强”得离谱

咱们不整那些虚头巴脑的参数,作为麦当mdldm,我直接替兄弟们提炼几个对咱们实际应用(特别是搞开发、搭Bot)最关键的点:

1. 它是“价格屠夫”,但它带刀侍卫的武功比皇帝还高

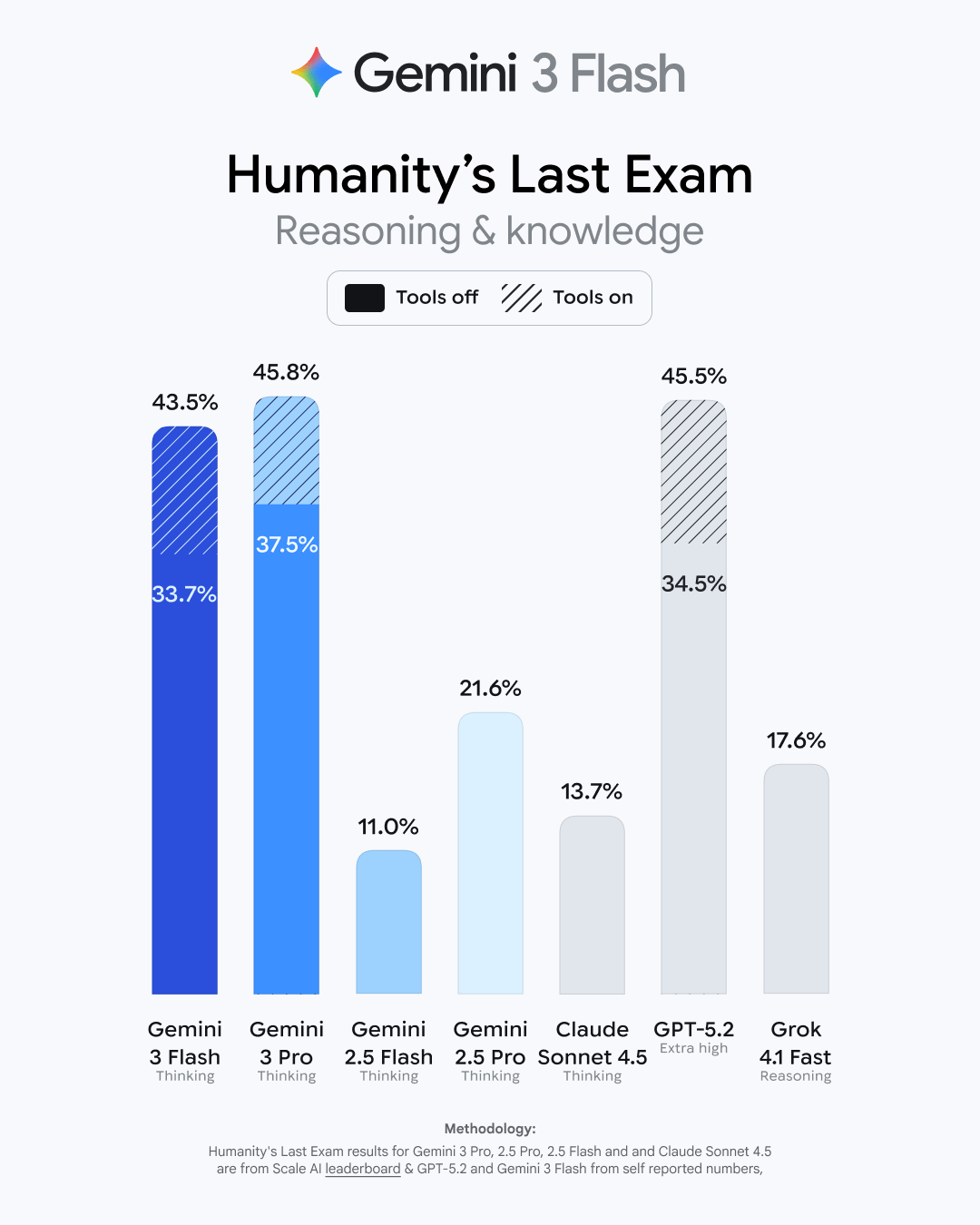

新闻里有个数据非常炸裂:Gemini 3 Flash 的成本只有 Gemini 3 Pro 的四分之一,但它的能力在部分测试中竟然胜过了 GPT-5.2!

特别是在 MMMU-Pro(多模态理解和推理) 这个测试上,Gemini 3 Flash 得分 81.2%,直接把 GPT-5.2(79.5%)给超了。这意味着什么?意味着如果你想做一个能看懂复杂视频、能理解图表、能听懂长音频的AI应用,你现在可以用“白菜价”享受到“顶配”的效果。

2. 速度就是生产力

对于咱们做 coze教学 和搭建智能体(Agent)的兄弟来说,延迟(Latency) 是用户体验的杀手。

Gemini 3 Flash 的速度是上一代 2.5 Pro 的 三倍。

想象一下,你搭了一个客服机器人或者一个代码助手,以前用户问一句要等转圈圈转半天,现在几乎是“秒回”。这种体验的提升,对于企业级应用来说是质变的。谷歌自己都把 Gemini App 和搜索的默认模型换成了它,这信心可见一斑。

3. “思考模式”下放,这才是大杀器

新闻里提到一个细节:美国地区用户可以通过模型选择器启用 “Thinking with 3 Pro”。

这说明什么?谷歌开始把类似 OpenAI o1 系列的“深度思考”能力,通过 Flash 这种轻量级架构进行普及。

我在给企业做培训时常说:未来的AI竞争,不是看谁的模型参数大,是看谁能把推理成本降下来。 Gemini 3 Flash 支持“思考量调节”,遇到难题多想一会儿,遇到简单题秒回,这种动态调节才是我们开发者最想要的。

4. 对 Coze 玩家意味着什么?

兄弟们,咱们在 Coze 上搭 Bot,最怕的就是 Token 消耗太快,钱包顶不住。Gemini 3 Flash 的定价是 每百万输入 $0.50。

这是什么概念?四舍五入约等于不要钱啊!

配合它强大的 长上下文缓存(Context Caching) 功能(新闻里提到可以削减90%成本),咱们完全可以把几百页的技术文档、整本的小说扔进去,让它做一个超低成本的“超级知识库”。

第三幕:别让工具限制了你的想象力

看完这个新闻,我最大的感受是:技术平权的时代真的来了。

以前,只有大公司用得起最顶尖的模型来处理复杂任务。现在,谷歌把这个门槛直接踩碎了。Gemini 3 Flash 的出现,意味着我们每一个普通人,每一个在 麦当的知识站 学习的兄弟,都可以用极低的成本,去构建以前想都不敢想的应用。

无论是你想做一个能看懂你所有家庭录像的视频助手,还是想为你的公司搭建一个处理海量文档的办公Agent,“贵”和“慢”不再是借口了。

麦当mdldm 想对兄弟们说:工具已经进化到这个地步了,剩下的就看咱们的行动力了。不要只做新闻的看客,去试用它,去 Coze 上调用它,去把你的想法变成现实。

AI 的浪潮还在加速,咱们得跟上。

欢迎大家:

- B站/小红书/掘金: 麦当mdldm

- 个人知识站: www.mdldm.club (海量免费教程和付费精品课,等你来解锁!)

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)