DeepSeek-Coder:开源代码大模型的架构演进与技术突破

DeepSeek-Coder系列模型作为这一领域的杰出代表,自开源发布以来,凭借其在专业基准测试中的卓越性能和极具包容性的开源协议,迅速成为学术界和工业界关注的焦点。通过融合创新的模型架构(如稀疏混合专家SMoE)与前沿的训练范式(如代码思维链提炼),该系列模型正重新定义AI辅助编程的边界,推动软件开发从“手动编写”向“智能协同”的范式转变。则采用236B参数的稀疏混合专家(SMoE)架构,在保持

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!

引言

在人工智能驱动软件工程(AI4SE)的时代浪潮中,大型语言模型(LLM)已成为代码生成、补全与理解的核心引擎。DeepSeek-Coder系列模型作为这一领域的杰出代表,自开源发布以来,凭借其在专业基准测试中的卓越性能和极具包容性的开源协议,迅速成为学术界和工业界关注的焦点。与通用大模型不同,DeepSeek-Coder专为代码处理设计,它不仅追求在HumanEval、MBPP等标准评测上的高分,更致力于解决实际开发中的核心痛点:如何生成正确、高效、可维护的代码。通过融合创新的模型架构(如稀疏混合专家SMoE)与前沿的训练范式(如代码思维链提炼),该系列模型正重新定义AI辅助编程的边界,推动软件开发从“手动编写”向“智能协同”的范式转变。🚀

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!

往期文章推荐:

- 20.MBPP:评估大语言模型代码生成能力的基准数据集

- 19.RepoCoder:基于迭代检索与生成的仓库级代码补全框架

- 18.Py150数据集:Python代码建模与分析的基准资源

- 17.GPT-Neo:开源大型自回归语言模型的实现与影响

- 16.编辑相似度(Edit Similarity):原理、演进与多模态扩展

- 15.CodeSearchNet:一个大规模代码-文档检索数据集的构建、应用与挑战

- 14.Text-Embedding-Ada-002:技术原理、性能评估与应用实践综述

- 13.RepoEval:定义仓库级代码补全评估的新基准

- 12.NaturalQuestions:重塑开放域问答研究的真实世界基准

- 11.SkCoder:基于草图的代码生成方法

- 10.长尾分布:现实世界数据的本质挑战与机器学习应对之道

- 9.概率校准:让机器学习模型的预测概率值得信赖

- 8.牛顿法:从最优化到机器学习的二阶收敛之路

- 7.交叉验证:评估模型泛化能力的核心方法

- 6.Softmax回归:原理、实现与多分类问题的基石

- 5.多重共线性:机器学习中的诊断与应对策略

- 4.惰性学习:延迟决策的机器学习范式

- 3.模糊集合理论:从Zadeh奠基到现代智能系统融合

- 2.基于实例的学习:最近邻算法及其现代演进

- 1.汉明距离:度量差异的基石与AI应用

1. 核心概念阐述:模型系列与设计哲学

DeepSeek-Coder并非单一模型,而是一个覆盖广泛参数规模和应用场景的模型家族。其设计哲学的核心在于性能与效率的平衡,以及通用能力与专业深度的结合。

-

模型系列概览:该系列提供了从1B到236B参数不等的多种规格模型。其中,广受关注的DeepSeek-Coder-33B模型在多项评测中性能超越同规模的CodeLlama,而DeepSeek-Coder-V2则采用236B参数的稀疏混合专家(SMoE)架构,在保持高性能的同时大幅降低推理时的激活参数量,实现了接近GPT-4 Turbo的代码能力。

-

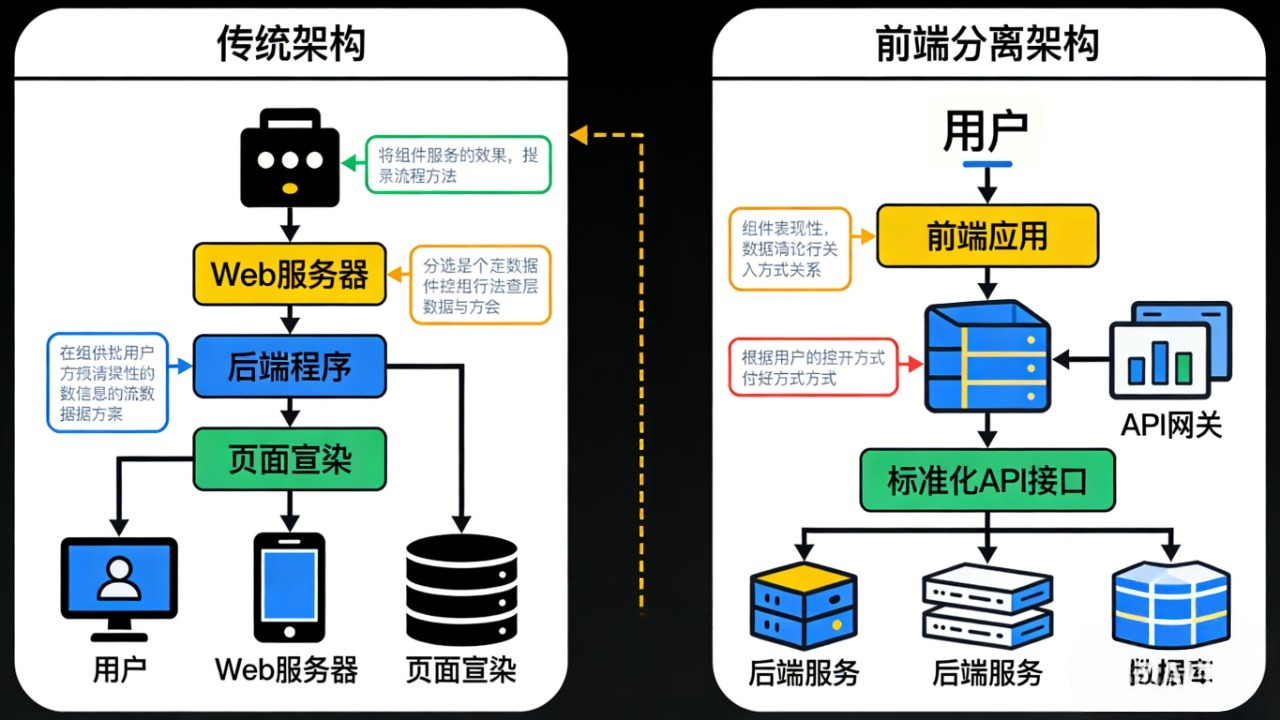

训练数据与架构:模型的卓越能力根植于其高质量的预训练数据。训练语料库经过精心构建,涵盖了GitHub上的开源项目、竞赛代码以及多种编程语言的文档,确保了广泛的语法和逻辑模式覆盖。在架构层面,除了基于Transformer的稠密模型,V2版本采用的SMoE架构是其标志性创新。该架构将总参数划分为多个“专家”网络,在推理时根据输入内容动态路由,仅激活部分专家,从而在模型容量巨大的情况下(如236B)仍能实现高效的推理速度。

2. 关键技术细节剖析

DeepSeek-Coder的技术优势源于其在预训练、指令微调和效率优化等多个层面的系统性创新。

-

Fill-in-the-Middle (FIM) 训练目标:与仅根据前缀预测后续代码的传统方式不同,FIM目标要求模型同时利用代码前缀和后缀上下文来预测中间缺失的部分。这种训练方式使模型更适配集成开发环境(IDE)中实际的代码补全场景,即光标前后均有代码上下文。研究表明,通过对具有复杂结构的“难例”代码模式进行课程学习,并利用检索增强生成(RAG)技术引入项目级上下文,可以显著提升模型(包括DeepSeek-Coder)在FIM任务上的表现。

-

CODEI/O:从代码中凝练通用推理能力:一项突破性研究揭示了DeepSeek团队如何通过CODEI/O方法赋予模型更强的泛化推理能力。该方法的核心是将代码库转换为“输入-输出预测”任务。具体而言,给定一个函数和其功能描述,模型需要预测特定输入下的输出,或为给定输出构造可行的输入,且整个推理过程需以自然语言思维链(Chain-of-Thought)的形式呈现。

例如,对于一个排序函数,模型需要解释输入[3, 1, 2]如何产生输出[1, 2, 3]。通过从数十万代码文件中构建超过350万个此类训练样本,模型得以学习内化在代码中隐含的逻辑流程规划、状态空间搜索等通用推理原语。实验证明,在CODEI/O数据上训练后,模型不仅在代码任务上有所提升,在数学、常识和符号推理等非代码任务上也表现出显著的性能迁移。

以下概念性代码展示了如何为课程学习和上下文集成构建训练样本,尽管实际实现更为复杂:

# 概念示例:构建结合课程学习和项目上下文的训练数据

def construct_curriculum_fim_sample(code_repo, file_path, cursor_line):

"""

根据代码仓库构建一个FIM训练样本,包含难例代码和检索到的相关上下文。

"""

# 1. 解析目标文件,获取光标处的前缀(prefix)和后缀(suffix)

prefix, suffix, ground_truth = extract_fim_context(code_repo, file_path, cursor_line)

# 2. 课程学习策略:识别复杂模式(如嵌套循环、递归调用)

ast_complexity = analyze_ast_complexity(prefix, suffix) # 分析抽象语法树复杂度

if ast_complexity > THRESHOLD:

# 将此样本标记为“难例”,在训练中可能赋予更高权重或特殊处理

difficulty_label = "HARD"

# 3. 检索增强:从同一仓库中检索相关函数或类定义作为额外上下文

relevant_context = retrieve_related_code(code_repo, file_path, current_function_name)

# 4. 组装最终训练样本:前缀 + [掩码] + 后缀,并附加上下文

training_sample = {

“prefix”: prefix,

“suffix”: suffix,

“ground_truth”: ground_truth,

“context”: relevant_context, # 用于增强模型的项目感知能力

“difficulty”: difficulty_label

}

return training_sample

- 高效微调与部署:为实现资源高效的适配,研究证实了QLoRA等技术在DeepSeek-Coder模型上的有效性。QLoRA通过将全参数微调压缩为对少量低秩适配器的训练,使得开发者能以极低的计算成本,在消费级GPU上为特定任务(如代码摘要、特定领域代码生成)微调大型代码模型。此外,模型提供了从INT4到FP16的多种量化版本,使得参数量庞大的模型也能在有限的硬件资源下部署,极大地拓宽了其应用范围。

3. 总结

DeepSeek-Coder系列模型通过其开源性、高性能和前沿的技术探索,在代码大模型领域确立了重要地位。它的成功不仅体现在基准测试的分数超越,更在于其为解决实际问题提供的技术路径:通过FIM目标优化真实编码体验;通过CODEI/O方法从代码中抽象出通用推理能力,打破任务壁垒;并通过SMoE架构和高效微调技术平衡能力与成本。

未来,代码大模型的研究将更深入地与软件工程实践结合,例如在长上下文项目级理解、生成代码的可靠性与安全性验证、以及多模态编程(从设计图到代码) 等方面持续深化。DeepSeek-Coder的开源与持续迭代,无疑为全球开发者社区和研究人员提供了一个强大的基座,共同推动AI辅助编程走向更智能、更可靠的未来。

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!

更多推荐

已为社区贡献69条内容

已为社区贡献69条内容

所有评论(0)