【datawhale组队学习】TASK01|课程导论:站在认知范式的临界点

当我们在“表达”环节获得了一个惊艳的结果时,不应止步于此。我们需要利用“逆向提示(Reverse Prompting)”技术让 AI 分析“是怎样的 Prompt 生成了这个结果”,从而将这次成功的偶发经验固化为可复用的 Prompt 模板。这不仅是个人知识库的建设,更是将隐性知识显性化、标准化的过程,为下一次工作流的启动提供了更高的起点。MVW(最小可行工作流)被定义为能够把一个具体任务从输入跑

课程讲义大纲

📁 01-课程导论

├─ 1.1 迎接生成式思维革命

│ ├─ 1.1.1 时代背景:AI从工具到思维框架

│ ├─ 1.1.2 人机协作范式的变化

│ └─ 1.1.3 传统知识工作方式的瓶颈

└─ 1.2 课程目标与成果说明

├─ 1.2.1 五大学习成果

├─ 1.2.2 完成路径与成果闭环

└─ 1.2.3 Task-Based Learning模型说明

📁 02-从搜索到生成——定义你的知识工作流

├─ 2.0 引言:从自然语言的混沌到认知工程的秩序

│ ├─ 2.0.1 语言的熵值与人机对齐的挑战

│ ├─ 2.0.2 提示工程的认识论转折:从黑客技巧到系统科学

│ └─ 2.1.3 2.0.3 本章学习目标

├─ 2.1 生成式思维:Prompt是结构化思考的投影

│ ├─ 2.1.1 大语言模型的认知架构与交互机制

│ ├─ 2.1.2 信息熵(Information Entropy)与结构化的必要性

│ └─ 2.1.3 Prompt不只是和 AI 对话的命令,更是人类结构化思维的载体。

├─ 2.2 从指令到系统:构建可控的知识工作流

│ ├─ 2.2.1 什么是知识工作流?

│ ├─ 2.2.2 为什么生成式AI需要知识工作流?

│ ├─ 2.2.3 知识工作流与Prompt的关系

│ └─ 2.2.4 重定位:Prompt是知识工作流的“通信协议”

├─ 2.3 知识工作流的五环节模型:I-S-G-I-E 的深度解构

│ ├─ 2.3.1 环节一:输入(Input)—— 语境的质量决定智能的上限

│ ├─ 2.3.2 环节二:结构(Structure)—— 将人类意图转化为机器指令

│ ├─ 2.3.3 环节三:生成(Generate)—— 概率与逻辑的共舞

│ ├─ 2.3.4 环节四:迭代(Iterate)—— 从平庸到卓越的跃迁

│ └─ 2.3.5 环节五:表达(Express)—— 资产的沉淀与分发

├─ 2.4 提示工程中的S.C.O.R.E模型——结构化Prompt的设计艺术

│ ├─ 2.4.1 Setting (角色设定):锚定潜空间

│ ├─ 2.4.2 Context (语境/背景):构建认知基石

│ ├─ 2.4.3 Objective (目标/任务):植入思维链

│ ├─ 2.4.4 Requirement (要求/约束):设立质量护栏

│ ├─ 2.4.5 Example (示例/样本):激活少样本学习

│ └─ 2.4.6 S.C.O.R.E通用Prompt模板

├─ 2.5 提示工程中的S.C.O.R.E模型——结构化Prompt的设计艺术

│ ├─ 2.5.1 什么是MVW?

│ ├─ 2.5.2 从五环节模型压缩出一个MVW

│ ├─ 2.5.3 案例演示:为课程写一篇“小论文”的 MVW

│ └─ 2.4.4 设计MVW时的常见误区与原则

└─ 2.6 课程总结

📁 03-结构化输入——为AI准备清晰的“图纸”

├─ 3.1 核心概念:信息结构化的威力

│ ├─ 3.1.1 为何AI读不懂模糊需求?结构化即翻译

│ ├─ 3.1.2 从无序到有序:清单、矩阵与层级分解法

│ ├─ 3.1.3 长文转结构化策略

│ ├─ 3.1.4 资料提取与标签标注

│ └─ 3.1.5 “可输入性”判断标准

├─ 3.2 方法与工具:在Obsidian中构建结构化笔记

│ ├─ 3.2.1 Markdown基础:标题、列表、代码块与链接

│ └─ 3.2.2 实战:将一篇网络文章整理为带有层级的要点提纲

├─ 3.3 Prompt示例:结构化信息提取提示词**

│ └─ 3.3.1 示例:使用角色-任务-背景框架,将长文本转为大纲

└─ 3.4 课堂练习

├─ 3.4.1 任务:为你的创作主题,完成一份结构化输入笔记

├─ 3.4.2 分享与互评

└─ 3.4.3 讲师点评与升级建议

📁 04-生成与迭代——导演你的首次人机共创

├─ 4.1 核心概念:生成推理与批判性迭代

│ ├─ 4.1.1 从大纲到初稿:如何下达清晰的“分镜头脚本”?

│ └─ 4.1.2 迭代的艺术:如何评估AI初稿并提出有效修改指令?

├─ 4.2 方法与工具:使用Qwen进行多轮对话生成**

│ ├─ 4.2.1 生成式提示技巧:基于前文、指定风格与格式

│ └─ 4.2.2 迭代反馈技巧:具体化、角色化、示例化

├─ 4.3 模型对比:利用DeepSeek/GPT进行交叉验证**

│ ├─ 4.3.1 为何要对比?不同模型的特长与盲区

│ └─ 4.3.2 实战:同一提示词在不同模型下的输出对比分析

└─ 4.4 课堂练习

├─ 4.4.1 任务:基于结构化输入,生成作品初稿并完成至少一次迭代优

├─ 4.4.2 分享与互评

└─ 4.4.3 讲师点评与升级建议

📁 05-资产沉淀——构建工作流模板

├─ 5.1 核心概念:从项目经验到可复用方法**

│ ├─ 5.1.1 工作流模板的价值:将一次性成功转化为可重复的资产

│ └─ 5.1.2 模板要素:触发条件、输入输出、核心步骤、工具与检查点

├─ 5.2 方法:如何将Task03的经验抽象为模板?**

│ ├─ 5.2.1 复盘你的创作过程:识别关键决策点与重复模式

│ └─ 5.2.2 使用Markdown编写标准化模板文档

├─ 5.3 模板示例:

│ └─ 5.3.1 展示模板结构,解析各部分的编写要点

└─ 5.4 课堂练习

├─ 5.3.1 任务:将你的创作过程,沉淀为一个可复用的知识工作流模板

├─ 5.3.2 分享与互评

└─ 5.3.3 讲师点评与升级建议

📁 06-智能助手入门——让工作流半自动运行

├─ 6.1 核心概念:从模板到智能助手

│ ├─ 6.1.1 智能助手 vs 智能体:关系与过渡

│ └─ 6.1.2 执行逻辑:Prompt链、记忆、迭代控制

├─ 6.2 平台与工具:Cherry Studio基础

│ ├─ 6.2.1 Cherry概览:多模型客户端与工作流容器

│ └─ 6.2.2 Assistants配置与Preset Prompt结构

├─ 6.3 方法:将你的模板配置为AI助手

│ ├─ 6.3.1 创建Assistant并配置系统提示词

│ └─ 6.3.2 设计执行步骤:确认→生成→优化

├─ 6.4 智能助手调试

│ ├─ 6.4.1 多版本生成与选择机制

│ ├─ 6.4.2 打磨输出风格与结构

│ └─ 6.4.3 Debug策略:模型偏移/输出不收敛处理

└─ 6.5 课堂练习

├─ 6.5.1 任务:创建属于你的工作流写作助手

├─ 6.5.2 分享与互评

└─ 6.5.3 讲师点评与升级建议

📁 07-智能助手开发——构建可复用的知识工作助手

├─ 7.1 架构视角:前端工作台 vs 后端智能体服务

│ ├─ 7.1.1 Cherry Studio作为人机协作前端

│ ├─ 7.1.2 ModelScope MCP作为智能体与工具编排层

│ └─ 7.1.3 “工作流模板 → 智能体服务”的升级路径

├─ 7.2 ModelScope 智能体MCP概念

│ ├─ 7.2.1 MCP中的模型、工具与会话

│ ├─ 7.2.2 将一个复杂任务拆为可编排的工具链

│ └─ 7.2.3 示例:检索+总结+写作的一体化Agent

├─ 7.3 Cherry + MCP 的协同模式(概念级)

│ ├─ 7.3.1 在Cherry中调用外部Agent API的思路

│ ├─ 7.3.2 「前端对话 / 后端执行」的责任分工

│ └─ 7.3.3 未来可扩展方向:多智能体协作与自动化流水线

├─ 7.4 构建MCP智能体

│ ├─ 7.4.1 设计智能体任务链(task-chain blueprint)

│ ├─ 7.4.2 选择至少一个步骤由MCP执行(提纲/总结/生成/分析)

│ └─ 7.4.3 输出:一个可在Cherry中调用或独立运行的MCP智能体

├─ 7.5 调试与优化

│ ├─ 7.5.1 如何定位Agent执行失败点

│ ├─ 7.5.2 迭代提示词、优化步骤与处理异常

│ └─ 7.5.3 输出规范:Markdown结构/日志记录/可复用参数

└─ 7.6 课堂任务

├─ 7.6.1 「最终任务」构建一个可运行的MCP智能体

├─ 7.6.2 分享与互评

└─ 7.6.3 讲师点评与升级建议

📁 08-课程总结与未来之路

├─ 8.1 回顾:两周的思维升级之旅

│ ├─ 8.1.1 从信息到智能体:重新梳理知识工作流的完整价值链条

│ └─ 8.1.2 优秀学员作品闪电展示与点评

└─ 8.2 展望:生成式思维的无限可能

├─ 8.2.1 工作流思维在其他领域的迁移应用(学习、研究、业务)

└─ 8.2.2 AI协作生态的演进趋势:从工具到伙伴再到团队

01-课程导论:站在认知范式的临界点

1.0 引言:从计算辅助到智能编排的范式转移

在人类技术文明的演进长河中,我们正处于一个前所未有的临界点。如果说工业革命是对人类体力的延伸与替代,那么以大语言模型(LLM)为代表的生成式人工智能(Generative AI)的崛起,则标志着一场更为深刻的“认知革命”的爆发。这不仅是工具层面的迭代,更是人类工作方式、思维模式乃至知识本身定义的根本性重构。

本课程《生成式思维与知识工作流》的设计初衷,并非仅仅作为一份AI工具的操作手册,而是旨在回应这一时代巨变对知识工作者提出的核心挑战:当机器不再仅仅是执行预设指令的“计算器”,而是演化为具备概率推理、语境理解和创造性生成能力的“智能体”(Agent)时,人类在知识生产链条中的位置应当如何重新锚定?

我们所处的时代背景,正如计算机科学家Edsger Dijkstra数十年前所预言的那样:“机器是否会思考的问题,就像潜水艇是否会游泳一样无关紧要。”[1] 真正关键的问题在于,人类如何与这些具备“类思维”能力的机器共同进化。本讲义作为课程的第一模块“课程导论”,将宏观地构建这一认知框架,深入剖析生成式 AI 带来的协作范式转移,解构传统知识工作的痛点,并详细阐述本课程基于“任务驱动学习”(Task-Based Learning, TBL)的教学逻辑与预期成果。这是一份为未来知识工作者准备的生存与进化蓝图,旨在帮助每一位学习者完成从“工具使用者”到“智能编排者”的身份跃迁。

,AI 的发展经历了多次起伏,从基于规则的专家系统(Expert Systems)到基于统计的机器学习(Machine Learning)。在这一阶段,AI主要表现为“判别式”(Discriminative)模型,其核心能力在于分析既有数据、识别模式并进行分类或预测。例如,垃圾邮件过滤器可以高效地将邮件分类,推荐算法可以精准地预测用户喜好。然而,这类AI的局限性在于其“再现性”而非“创造性”——它无法生成训练数据之外的新内容。

2023年被视为“人机协作的新纪元”,以GPT-4为代表的生成式AI的爆发,彻底改变了这一格局。生成式AI不仅能够理解复杂的自然语言指令,更能够基于海量的训练数据进行推理、组合并创造出全新的文本、图像、代码甚至策略。这种能力的跃迁,使得AI从一个被动的“检索与分析工具”,质变为一个主动的“生产与推理引擎”。生成式AI不仅仅是一个工具,它代表了一种系统级的转变,重塑了学习、工作流乃至组织设计。

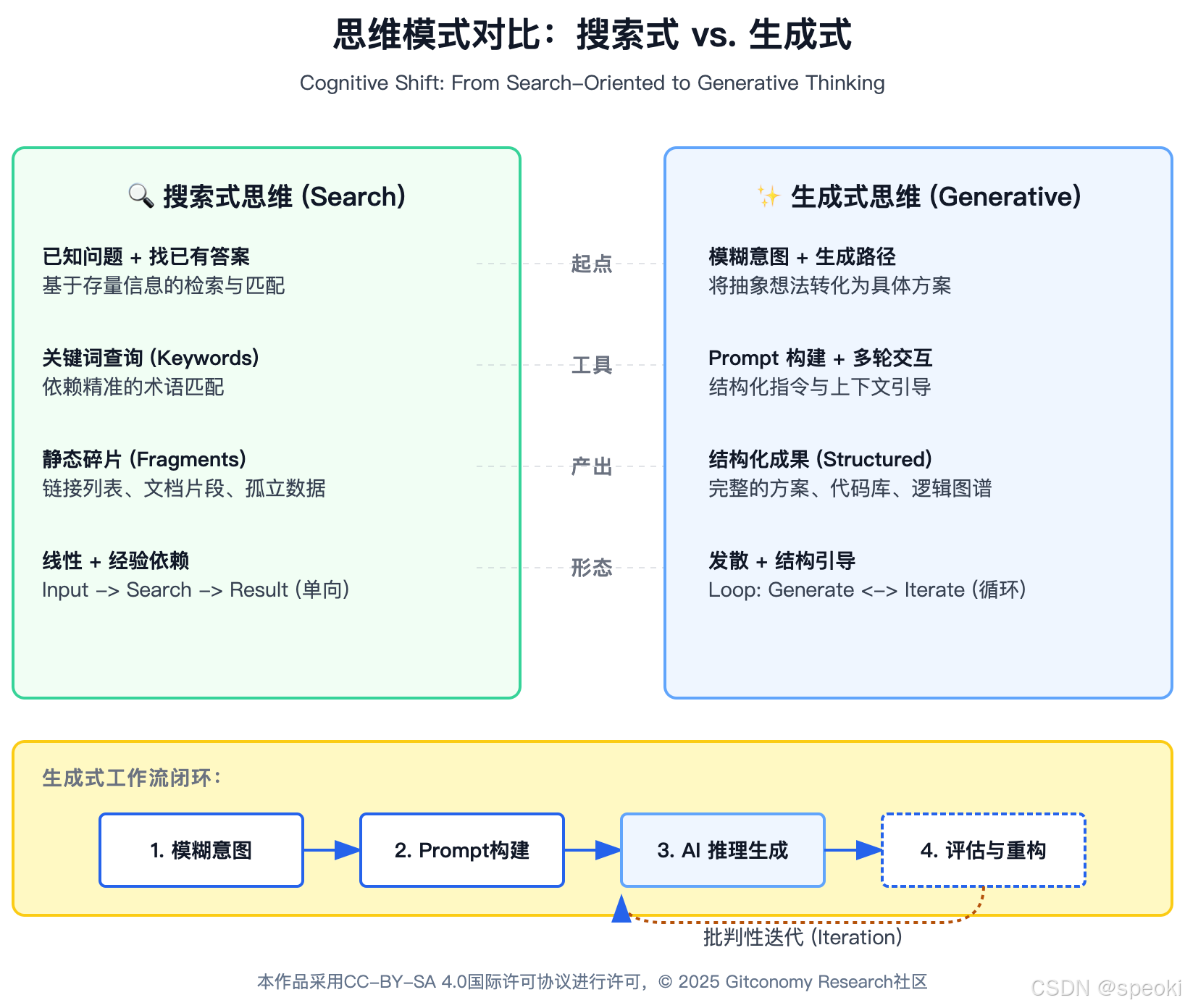

在本课程中,我们将“生成式思维”定义为一种适应 AI 时代的全新认知习惯。它区别于传统的“搜索式思维”(Search-Oriented Thinking)和“记忆式思维”(Memory-Oriented Thinking)。

【从“获取”到“生成”】: 传统思维下,当我们面临一个问题(如撰写一份市场报告),第一反应是【“搜索”】——去寻找现成的模板、数据或文章,然后进行拼接。生成式思维的第一反应是【“构建”】——设计一个能够产出该报告的逻辑结构,然后引导 AI 根据这一结构生成内容。

前者是信息的搬运,后者是信息的炼金。

提示词作为思维的脚手架: 许多人误以为 Prompt(提示词)仅仅是与AI对话的命令,但实质上,Prompt是人类思维结构的显性化表达。

一个优秀的 Prompt 包含了【背景(Context)、任务(Task)、约束(Constraints)和输出标准(Criteria)】。在设计 Prompt 的过程中,人类被迫将模糊的意图清晰化、结构化。因此,Prompt Engineering 本质上是思维工程(Thinking Engineering)。

概率推理与逻辑引导: 大语言模型本质上是【概率预测机】。

生成式思维要求我们理解这一点,并学会用【逻辑结构去“收敛”概率】。当我们提供清晰的大纲和约束时,我们实际上是在缩减模型生成的搜索空间,强制其在高质量的逻辑通道中运行,从而避免“幻觉”(Hallucination)和平庸的输出。

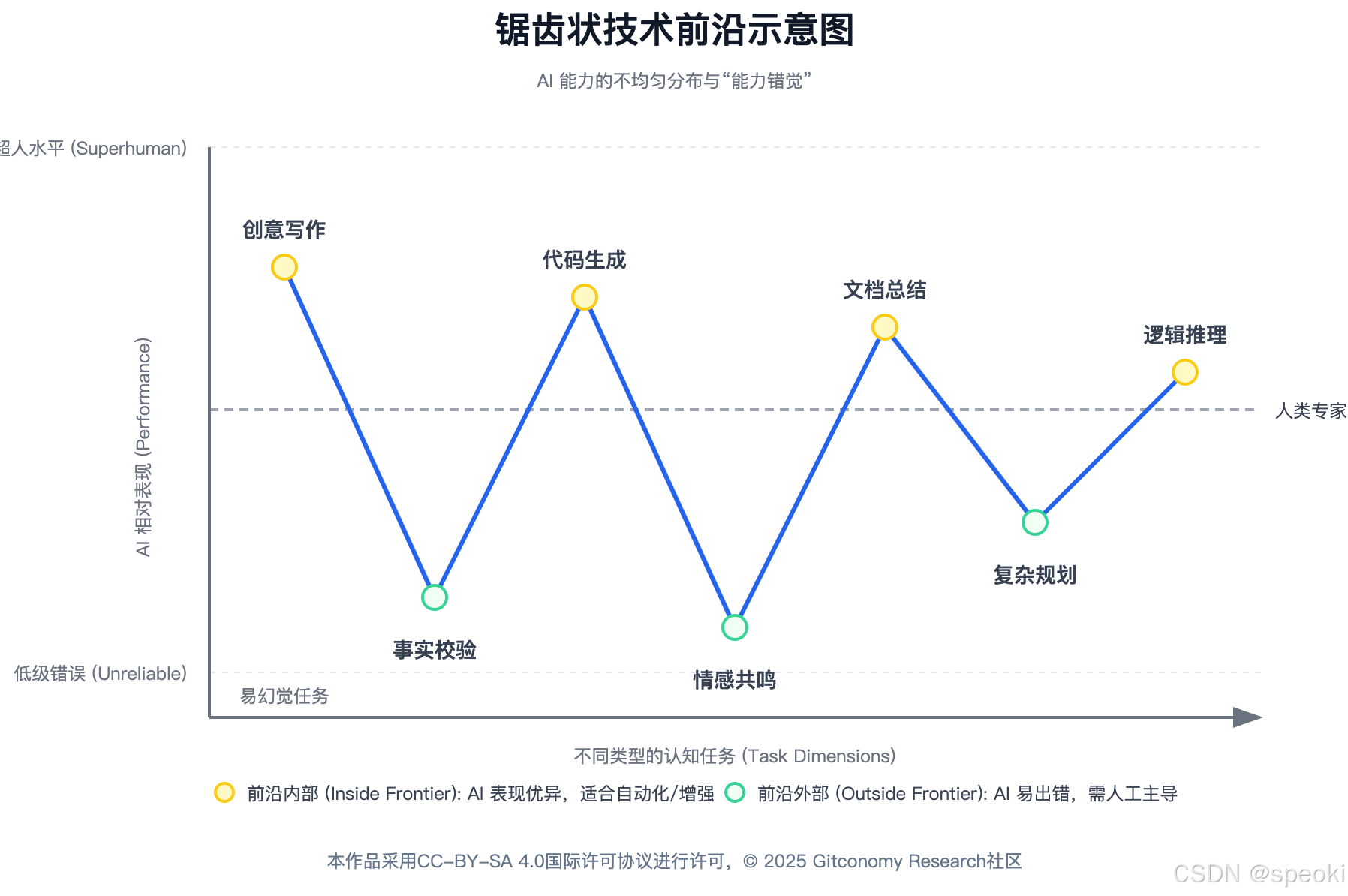

“锯齿状技术前沿”(Jagged Technological Frontier)

在拥抱生成式思维时,我们必须保持理性的边界意识。哈佛商学院的一项重要研究(Dell’Acqua et al. ,2023)[2]提出了“锯齿状技术前沿”的概念:**AI 的能力边界是不规则的。**在某些人类认为极其困难的任务上(如撰写复杂的代码、生成创意营销文案),AI 可能表现出超越顶尖人类专家的水平;而在某些人类认为简单的任务上(如基本的算术、事实核查或需要高度语境感知的社交协调),AI 可能表现得像个初学者甚至完全失效。

这种不均匀的能力分布对知识工作者提出了极高的要求。我们需要具备一种动态的判断力,能够识别当下的任务是处于 AI 能力前沿的“内部”(适合自动化与生成)还是“外部”(必须由人类主导)。盲目地将所有工作交给AI会导致质量下降,而完全拒绝 AI 则意味着效率的巨大损失。本课程将着重训练这种“任务甄别”与“边界管理”的能力。

人机协作范式的变化:从指令执行到智能编排

协作光谱的四个阶段

在享受AI带来的效率红利时,我们必须警惕“认知卸载”(Cognitive Offloading)带来的副作用。MIT研究研究表明,生成式AI虽然显著降低了知识检索和初稿生成的门槛,但也可能导致人类【批判性思维】的退化[3]。当AI 能够轻易给出一个看似完美的答案时,学习者可能倾向于跳过验证和深思的环节,直接采纳。

这被称为“GenAI 批判性思维悖论”(GenAI-Critical Thinking Paradox)。为了对抗这一趋势,本课程特别强调“批判性迭代”的重要性。我们不仅教如何让 AI 生成,更教如何“质疑”AI。在工作流中,人类必须保留**“否决权”和“修改权”。信任机制需要从传统的“信任专家”转变为“信任验证过程”**。只有经过人类严谨审查和多轮迭代的AI产出,才具备真正的知识价值

信任的重构:认识性信任的转移

在传统的知识网络中,我们对信息的信任往往基于社会关系(Social Epistemic Ties),例如我们信任某位同事或某个权威机构。然而,生成式AI打破了这一链条。AI生成的内容往往缺乏明确的来源标注,且容易产生极其逼真的虚假信息。这迫使知识工作者必须从“信息的消费者”转变为“信息的审计者”。我们在课程中将反复训练学员如何通过多模型交叉验证、溯源检查和逻辑一致性测试来确保知识的可靠性。

传统知识工作方式的瓶颈

在引入新范式之前,我们需要深刻理解旧范式为何难以为继。传统知识工作面临着“不可能三角”的制约:速度、质量与规模难以兼得。

静态知识管理的崩溃

传统的知识管理系统(Knowledge Management Systems, KMS)通常基于静态文档库(如 SharePoint, Wiki)。它们面临着三大致命缺陷:

-

【静态性与滞后性】: 知识被固化在文档中,一旦生成即开始贬值。维护和更新这些文档需要巨大的人力成本,导致知识库往往滞后于业务现实。

-

【检索的低效性】: 传统检索依赖关键词匹配。如果你不知道准确的术语,就无法找到信息。此外,大量的隐性知识(Tacit Knowledge)——如专家的经验、直觉——无法被有效地文档化和检索。

-

【信息孤岛】: 不同部门、不同系统之间的数据难以互通,导致企业内部存在大量的重复劳动,“重新造轮子”现象普遍。

相比之下,生成式AI引入了动态的知识管理模式。AI 可以实时读取、理解并综合多源信息,通过自然语言对话提供精准的答案,而非仅仅返回一堆文档链接。它将“搜索-阅读-综合”的繁琐过程压缩为一次“提问-获取”的交互。

协调成本与“协作磨损”

一份由Asana发布的《Anatomy of Work Index》报告指出,许多知识工作者将约 60% 的时间花在所谓 “work about work”(为工作本身而做的工作上,例如会议、邮件、协调、切换工具、行政任务等[4]。因此知识工作者实际上只有不到 40% 的时间用于核心的个人产出。这种“协调磨损”是组织效率低下的主要原因。

生成式AI虽然无法完全替代面对面的情感交流,但它可以通过以下方式显著降低协调成本:

-

【异步通信的质量提升】: AI 可以自动生成高质量的会议纪要、行动清单和项目摘要,使得异步协作更加顺畅,减少不必要的同步会议。

-

【知识流动的自动化】: 智能体可以自动将某个项目组的更新同步给相关方,打破信息壁垒,减少人工汇报的负担。

-

【决策辅助】: 在需要共识的环节,AI 可以预先整理各方观点,分析利弊,为决策者提供结构化的参考,从而缩短决策周期。

能力方差与“拉平效应”

在传统模式下,资深专家与新手之间的能力差距是巨大的,且这种差距的弥合通常需要【数年的经验积累】。生成式AI对此产生了颠覆性的影响,即“拉平效应”(Leveling Effect)。

最近一项针对近5,000名软件开发者的大规模随机对照实验发现,在使用生成式 AI 辅助后,整体任务完成率提升了约 26%。不过,对于经验较浅、初级职位的开发者,生产力提升更大(27%–39%),而对于资深开发者,提升则较小(8%–13%)。这暗示生成式 AI 有可能对“新手 / 低经验人群”产生“拉平效应”,缩小与老手之间在产出效率上的差距(Cui et al., 2024)[5]。

这一现象对组织意味着:

培训周期的缩短: 新员工可以借助AI辅助快速上手,掌握原本需要长期摸索的隐性知识。

专家角色的转变: 专家不再通过垄断信息或基础技能来维持地位,他们必须转向更高阶的“判断力”、“创新力”和“复杂系统管理”能力。本课程正是为了帮助学员(无论是新手还是专家)在这一新格局中找到自己的生态位。

五大学习成果:构建全栈式 AI 协作能力

基于对上述时代背景的深刻洞察,本课程设计了层层递进的五大核心学习成果。我们的目标绝非仅仅教授学员如何写出几个“神奇的提示词”,而是要帮助学员建立一套可复用、可扩展的系统化知识工作流能力

理解生成式思维的核心概念

建立“人机协同”的深层认知模型,彻底摆脱将 AI 视为“更快的百度”的旧习。

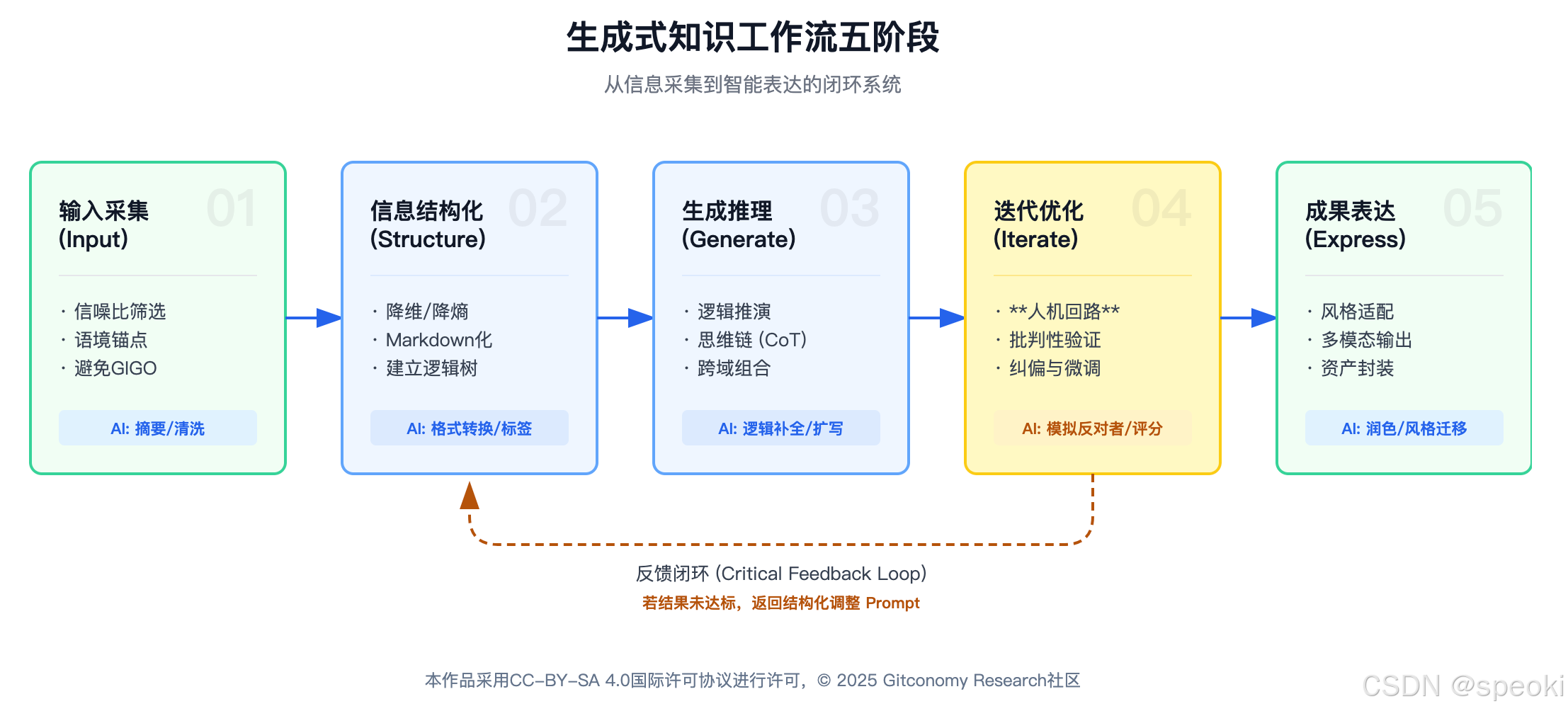

能够清晰应用“知识工作流”五大环节:

- 信息采集 (Input):识别高信噪比源,理解 GIGO 原理。

- 结构化理解 (Structure):非结构化信息转 Markdown/JSON。

- 生成推理 (Generate):引导逻辑推演而非文本补全。

- 迭代反馈 (Iterate):掌握“批判性迭代”与多轮对话。

- 成果表达 (Express):针对受众调整风格格式。

阶段一:定义与结构化(Definition & Structuring) —— 对应 Task 01 & 02

核心任务: 明确工作流的目标,并准备高质量的输入。

理论基础: 信息熵理论。无序的信息是高熵的,AI 难以处理。学员需要通过结构化手段降低信息熵,为 AI 提供清晰的“语境锚点”。

阶段二:生成与批判性迭代(Generation & Critical Iteration) —— 对应 Task 03

核心任务: 利用 AI 生成初稿,并进行多轮打磨。

理论基础: 人在回路(Human-in-the-loop)控制论。AI 负责高发散的生成,人类负责高收敛的判断。通过反馈循环(Feedback Loop)不断缩小生成结果与目标之间的误差。

阶段三:抽象与模板化(Abstraction & Templating) —— 对应 Task 04

核心任务: 复盘 Task 03 的过程,剔除偶然因素,提炼必然规律。

理论基础: 知识工程中的“本体构建”(Ontology Construction)。将具体的经验抽象为通用的方法论,使其具备可迁移性。

阶段四:自动化与代理化(Automation & Agentization) —— 对应 Task 05

核心任务: 将模板配置进 Agent 平台,进行调试与发布。

理论基础: 分布式认知(Distributed Cognition)。将人类的认知过程外包给智能代理,实现认知能力的扩展。

阶段五:沉淀、迭代与生态化协作(Repository & Evolution) —— 对应最终成果提交 + 长期增量实践

核心任务: 将已构建的 MCP 智能体发布至仓库,实现复用、评价、版本演进,并在实践中持续迭代,完成从个人工具到群体知识资产的升级。

理论基础: 知识循环(Knowledge Lifecycle)与开放协作(Open Collaboration)机制。

Task-Based Learning (TBL) 模型说明

本课程采用任务驱动学习(Task-Based Learning, TBL) 作为核心教学法。这并非随意的选择,而是基于对AI教育特性的深刻理解和教育学实证研究的支撑。

传统课堂普遍采用 PPP(Presentation–Practice–Production)模式[7],即“呈现 → 练习 → 产出”。教师负责讲授(Presentation),学生通过重复练习巩固内容(Practice),最终在考试或作业中展示掌握程度(Production)。这种教学方式强调知识传递与记忆,对结构化内容教学有效,但学习过程较被动,创新性、探索性和批判性思维空间较小,难以适应生成式AI时代对“自主学习、问题提出与开放式探究”的能力要求。

由于生成式AI极易上手,学生只需输入简单指令即可获得看似不错的结果,这容易让他们误以为自己已经掌握了技能。但实际上,他们可能并不理解背后的逻辑,一旦遇到复杂场景就会束手无策。

还有,AI 的表现高度依赖于具体的任务情境。脱离真实任务谈Prompt是没有意义的。因此,将AI工具整合进 TBL 框架,能够显著提升学习者的流利度、动机以及解决实际问题的能力。

本课程的TBL模型架构:Pre-Task, Task Cycle, Post-Task

我们的TBL模型包含三个核心阶段,每个阶段都深度融合了AI工具的使用:

Pre-Task

- 激活背景知识,明确任务目标,提供脚手架。

- 引入概念,展示优秀的 Agent 案例,提供基础的 Prompt 框架(Scaffolding)。

- 分析任务需求,进行头脑风暴,明确工作流设计思路。

- 概念辅助:利用 AI 解释复杂概念,或生成头脑风暴的初始点子。

Task Cycle

执行任务,经历困难,进行迭代。

观察学员操作,提供即时反馈(非直接答案),引导学员查阅文档。

- 计划:设计工作流。

- 执行:与 AI 进行高强度交互,记录 Prompt 日志。

- 报告:整理生成结果,准备展示。

执行伙伴:AI 生成初稿,根据反馈修改,甚至反向提问以澄清需求。

Post-Task

反思、分析、归纳与内化。

- 抽取典型案例进行点评(Critique),强调“结构化”与“迭代”的价值。

- 复盘整个过程,分析哪些 Prompt 成功了,哪些失败了,为什么?将经验沉淀为模板。

- 分析工具:利用 AI 分析自己的 Prompt 日志,甚至让 AI 给自己打分并提出改进建议

基于 Git 的协作式 TBL:将学习过程代码化

为了进一步强化 TBL 的效果,我们将软件工程中的Git工作流引入教学:

Issue 作为提问板: 学员通过Issue提出在任务执行中遇到的困难,通过讨论区进行协作学习。

Pull Request (PR) 作为作业提交: PR的机制天然包含了“Code Review”。讲师和助教可以直接在学员提交的Markdown文档上进行行级评论(Line-by-line Comment),指出 Prompt 的逻辑漏洞。

Commit History 作为思维黑匣子: Git的提交记录忠实地保存了学员的每一次修改。这使得学习过程变得可视、可追溯。我们不仅评价最终的“作品”,更评价“修改的过程”。

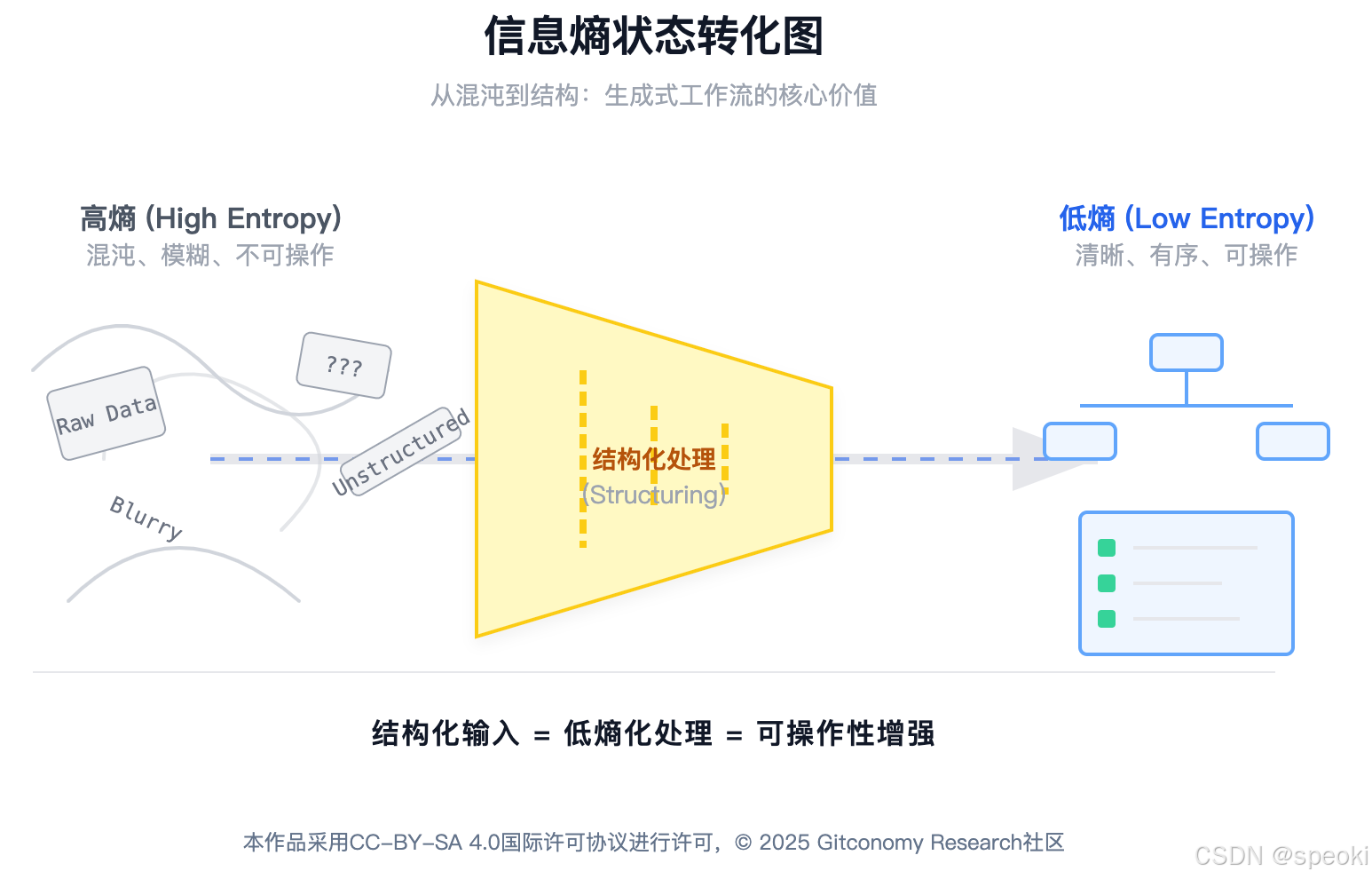

在导论中,我们反复提到了“结构化”。为什么在生成式 AI 时代,结构化变得如此重要?这不仅仅是一个操作技巧,更关乎大语言模型(LLM)的本质运作机理和信息论的基本原理。

从底层原理来看,LLM本质上是一个概率模型。它是基于海量文本数据训练出来的,通过计算“给定上文,下一个词出现的概率分布”来生成文本。它并没有人类那样严密的、基于因果律的内在逻辑世界观。

高熵状态: 当你给出一个模糊指令(如“帮我写个方案”)时,模型面临的上下文极其宽泛,可能的输出路径成千上万。这是一种“高熵”状态。在这种状态下,模型倾向于输出最平庸、最常见(概率最高)的内容,甚至产生幻觉),因为它在茫茫的概率海洋中“猜”你想要什么。

低熵状态: 当你提供一个清晰的结构(背景、角色、任务、约束、输出格式)时,你实际上是极大地缩小了模型的搜索空间。你排除了那些低质量的概率路径,强制模型在高质量的逻辑通道中运行。这就是 Prompt Engineering 的本质——通过引入负熵(Structure Information),对抗生成的随机性。

Prompt作为“认知接口”

生成式思维的一个核心功能,就是充当人类“模糊认知”与 AI “精确结构”之间的翻译器。

- 人类端: 思考往往是跳跃的、碎片的、隐性的(Tacit)。

- AI 端: 执行需要是连续的、完整的、显性的(Explicit)。

本课程后续章节,特别是第三章《结构化输入——为AI准备清晰的“图纸”》将重点训练这种“翻译能力”——如何将你脑海中灵光一现的想法,拆解为 AI 能够一步步执行的工序。Prompt在这里不仅是指挥 AI 的工具,更是人类思维显性化的接口。如果你自己对任务没有想清楚,你是写不出好Prompt的。因此,我们常说:“清晰的写作来自清晰的思考”,在 AI 时代,我们可以说:“清晰的生成来自结构化的思考”。

伦理与责任:作为AI公民的自觉

在课程导论中,我们必须提及AI使用的伦理维度。随着AI逐步介入决策流程,其潜在的偏见、隐私风险和所有权问题不容忽视。

数据隐私: 在构建工作流时,特别是涉及企业内部数据时,必须了解哪些数据可以输入给公有大模型,哪些必须本地化处理。

责任归属: 即便AI完成了 99% 的工作,人类依然是最终结果的责任人。我们不能将错误推卸给算法。这种“责任感”是人机协作中人类不可让渡的底线。

Jagged Frontier

锯齿状技术前沿

指 AI 能力分布的不均匀性现象。AI可能在某些人类认为困难的任务上表现极强,却在某些简单的任务上表现极弱或完全失效。使用者需具备识别这一边界的能力。

Human-in-the-loop

指在自动化系统中,人类保留关键的监督、审核和决策权。在AI生成初稿后,必须有人类的介入进行价值判断和迭代优化,以确保结果的可靠性。

Epistemic Trust

在知识网络中对信息有效性的信任机制。在 AI 时代,这种信任需要从基于“权威信源”转移到基于“严谨的验证过程”(如交叉验证、逻辑自洽性检查)

GIGO

(Garbage In, Garbage Out)_

“垃圾进,垃圾出”原理。在生成式 AI 中,特指输入数据的质量、结构和清晰度直接决定了 AI 生成结果的质量。

语言的熵值与人机对齐的挑战

本章的核心任务——“结构化提示工程”(Structured Prompt Engineering),本质上是一场熵减运动。我们需要通过引入特定的句法结构、逻辑约束和认知框架,人为地降低输入信息的熵值,从而迫使模型的概率分布向我们需要的高价值区域坍缩。这不仅仅是学习如何“提问”,更是一种思维工程(Thinking Engineering)——在向AI发出指令之前,我们必须首先对自己的混沌思维进行结构化清洗,将其编译为机器可读的“认知合约”

提示工程的认识论转折:从黑客技巧到系统科学

随着模型能力(特别是 DeepSeek V3、GPT-4o 等强推理模型)的指数级跃迁,提示工程正在经历一场深刻的认识论转折——从经验主义的炼金术转向基于原理的系统科学。

这种转折体现在三个层面:

-

从自然语言到半结构化语言:引入XML标签、Markdown语法、JSON 结构,利用符号体系界定语义边界,防止“指令遵循”(Instruction Following)漂移。

-

从单轮指令到**思维链(CoT)**设计:通过植入“思维链”,强制模型调用“系统2”(慢思考)能力,实现复杂逻辑任务的性能飞跃 。

-

从通用模版到模型特异性优化:针对不同架构(如 DeepSeek V3 的 MLA 架构)调整策略,更多依赖上下文学习(In-Context Learning)而非死记硬背。

目标

理解生成式思维与传统“搜索式思维”的本质差异;

掌握知识工作流的五环节模型(Input → Structure → Generate → Iterate → Express);

学会使用 SCORE 模型设计结构化 Prompt;

完成第一次“可运行”的最小可行工作流(MVW)。

生成式思维:Prompt是结构化思考的投影

大语言模型的认知架构与交互机制

Transformer架构的核心本质在于“注意力机制”(Attention Mechanism),它通过并行计算输入序列中每一个Token与其他Token之间的关联权重来理解语义。

【分隔符】在处理上下文窗口时,以DeepSeek V3为例,尽管其支持高达128K token的输入,但为了有效解决长文本中常见的“中间迷失”现象,用户仍需通过【标题、分隔符】等显著的【格式标记】来【人为提升关键信息的权重】。

【少样本】DeepSeek V3采用的MLA技术显著减小了KV Cache的规模,从而提升了推理效率,这意味着我们在交互中可以更“奢侈”地使用少样本示例(Few-Shot Examples),而无需过分担忧由此带来的推理延迟或成本压力。

在此基础上,我们需要重新审视“锯齿状技术前沿”(Jagged Technological Frontier)这一概念,并培养对任务进行甄别的元能力。

【AI能力强的】对于位于“前沿内部”的任务,如文本摘要、翻译及简单代码生成,AI展现出卓越的能力,此时的交互重点应聚焦于指令的清晰度和格式规范。

【AI能力弱的】相反,对于“前沿外部”的任务,例如复杂的数学证明或创作长篇连贯小说,AI的能力尚显不足,因此策略重心必须转向过程控制,需要通过**拆解任务、强制反思以及运用多路径推理(Tree of Thoughts)**来引导模型。

为了进一步优化输出质量,我们可以借鉴人类认知心理学,尝试唤醒AI的“慢思考”(系统2)。

例如,使用Zero-Shot CoT策略,即提示模型“Let’s think step by step”,虽然这增加了计算时间,但却为模型提供了一个宝贵的“自我纠错”缓冲区。

特别值得注意的是DeepSeek R1带来的启示:由于R1已通过强化学习内化了思维链,在使用此类模型时,【过分琐碎的过程指导】反而可能干扰其内部优化的路径,因此应调整策略,更侧重于提供清晰的最终验证标准。

信息熵(Information Entropy)与结构化的必要性

为什么有时候 AI 会一本正经地胡说八道(幻觉)?从信息论的角度来看,这是因为输入信息的熵(Entropy)过高。

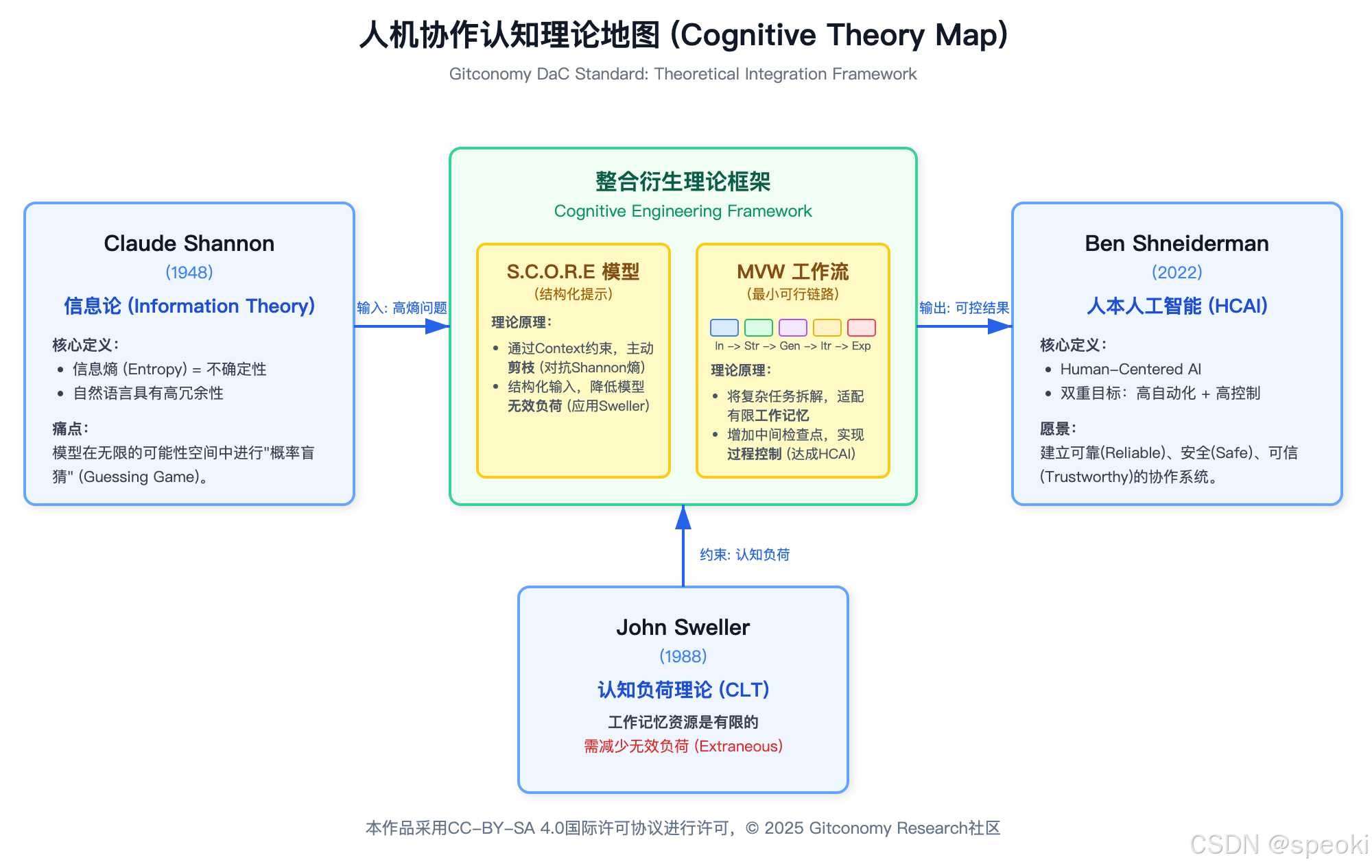

理论支撑:Claude Shannon (1948) 在其信息论奠基之作中指出,信息传递的有效性取决于信号的组织结构[1]。当输入信号极其混乱(高熵)时,接收端(无论是人还是 AI)解码出准确信息的概率就会大幅下降。

在 AI 中的映射:一个模糊的Prompt(如“帮我写个方案”)包含极高的熵,模型在潜在空间中的搜索范围接近无限,因此输出质量不可控。

结构化的本质:结构化输入 = 熵减(Entropy Reduction)。通过引入明确的约束(Constraints)、背景(Context)和格式(Format),我们实际上是在对信息进行“预压缩”,迫使模型在更窄、更准确的概率空间内进行推理。

Prompt不只是和 AI 对话的命令,更是人类结构化思维的载体。

在生成式 AI 出现之前,解决问题往往依赖我们搜索资料并直接整理答案,这更接近于信息的搬运和记忆;而生成式思维要求我们先搭建解决问题的逻辑框架,再让 AI 去填充细节。

Barbara Minto 在《金字塔原理》中提到,有效传达想法的前提是清晰的逻辑结构(Minto, 1996)[2]。

类似地,一个精心设计的Prompt会包含角色设定、背景上下文、任务目标、约束条件和输出评价等要素,使我们的意图对 AI 来说清晰明了。这一过程迫使我们将模糊的想法条理化,把隐藏的假设摊开来审视——可见,Prompt Engineering 本质上是思维工程,要求我们具备结构化表达和问题分解的能力。

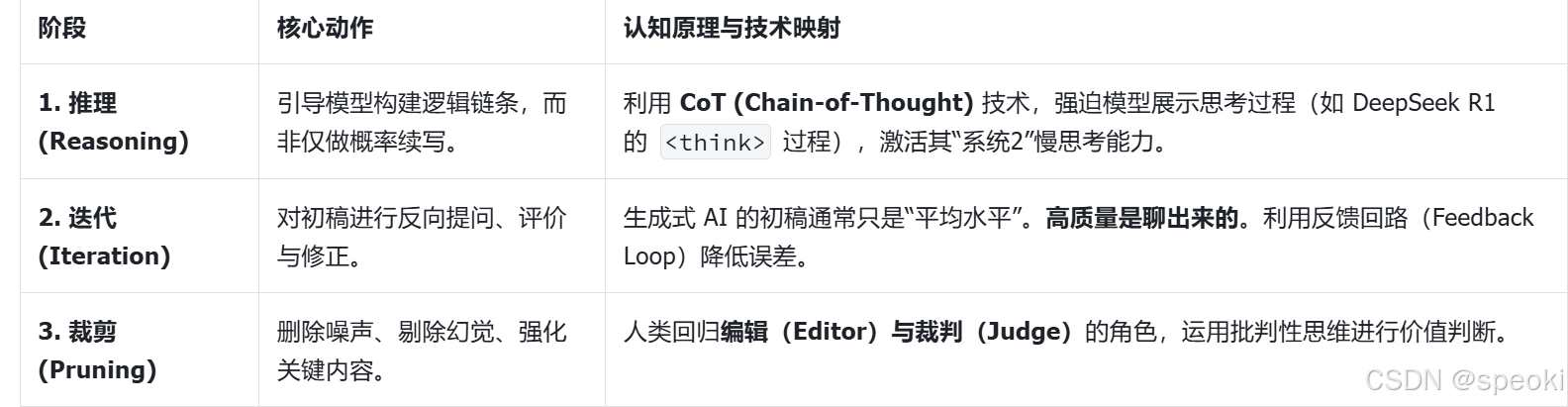

值得强调的是,在与大型语言模型(LLM)交互时,**“生成”不等于直接得到输出,而是一个包括推理、迭代和裁剪的循环过程。**首先是推理:我们引导模型逐步思考,分解复杂问题,让它给出初步的推理过程或草稿答案。这一点与人类写作先列提纲再行文类似,大模型通过链式思考获得了更高质量的结果(Wei et al., 2022)[3]。接着是迭代:对模型的初始回答进行批判性评估,找出其中的不足之处,然后通过新的提示对其进行改进。迭代是生成式思维的核心环节——正如 Sweller (1988)[4] 强调的,逐步解决问题、不断反馈修正,可以有效降低认知负荷,让复杂任务更易管理。最后是裁剪:在多轮生成之后,我们需要对内容进行取舍和定稿。这一阶段就像编辑润色文章,去除冗余信息,纠正错误与不一致之处,确保输出与预期目标严丝合缝。

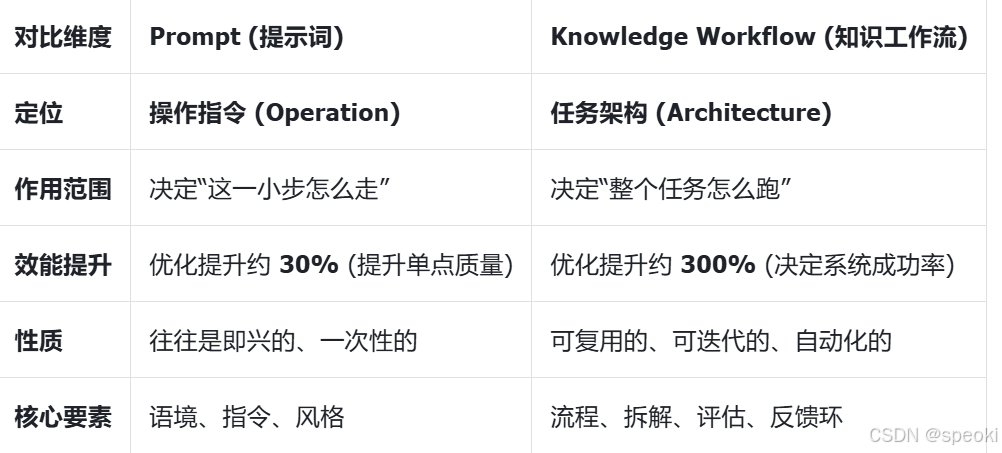

构建可控的知识工作流

当我们处理写研究综述、周报、项目方案或数据分析等知识密集型任务时,我们永远不会是一蹴而就的。相反,我们会经历一系列隐性的认知步骤:从收集材料开始,经过整理理解、形成结构、撰写草稿、打磨修改,直到最终产出成果。这些步骤之间存在明确的依赖关系、角色分工和信息流动,就像一条精密的“知识生产流水线”。

因此,我们将知识工作流定义为:**人类认知步骤的可视化 + 可复用的执行链路。**与企业中处理标准化事务的“业务流程”不同,知识工作流处理的是开放性问题、复杂任务以及抽象的思考与表达。其本质是一种从输入到输出的系统化协作方式,它规定了信息如何进入系统、如何被结构化处理、如何被 AI 生成草稿以及如何被人类迭代。

⭐ 核心洞察:

Prompt 是单点行为,着眼于“怎么说”;

知识工作流是[系统行为],着眼于“整个任务怎么跑”。

为什么生成式 AI 需要知识工作流?

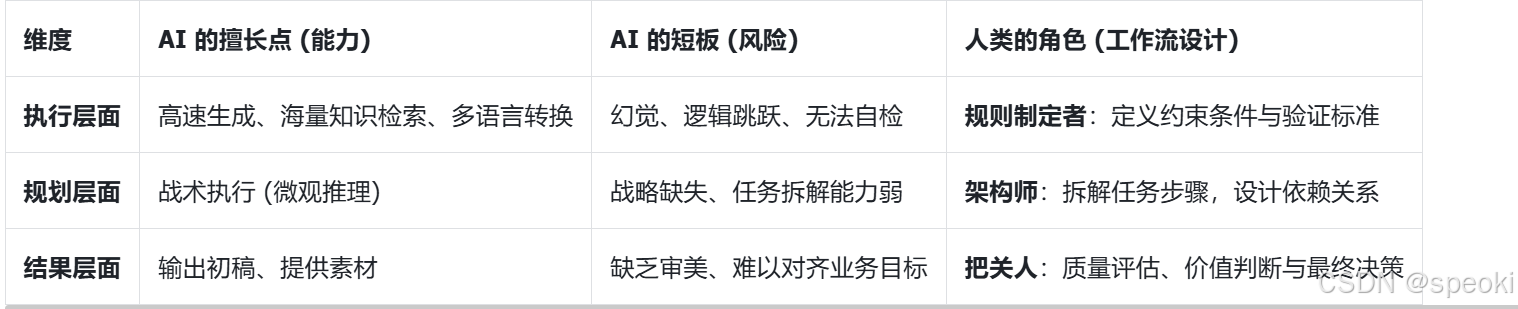

生成式 AI 的出现并没有消灭工作流,反而使其变得更加重要。大语言模型(LLM)虽然在文本生成、语言转化、多轮推理和信息总结方面表现卓越,但它存在天然的短板:它不擅长定义任务目标、规划执行步骤、检查质量标准以及决定最终的表达形式。

如果缺乏工作流的约束,完全依赖 AI 的“自由发挥”,我们往往会遇到生成内容“看起来正确实则离谱”、内容冗长无重点,甚至在多轮对话中逐渐偏离主题(幻觉)的问题。因此,生成式时代的核心技能,不再仅仅是“写好一个 Prompt”,而是“设计一条可控的知识工作流”。

知识工作流与 Prompt 的关系

为了避免陷入“Prompt 理论堆砌”的误区,我们需要明确二者的辩证关系:Prompt是工具,知识工作流是方法。

在没有工作流设计时,Prompt 只能一次次“碰运气”,试图用一个指令解决所有问题。但一旦建立了**“输入 → 结构 → 生成 → 迭代 → 表达**”的链路,每个 Prompt 就变成了任务链中的一个“结构化组件”或“节点函数”。每一步都清楚信息从哪里来、到哪里去。可以说,Prompt决定了“局部最优”,而工作流决定了“整体最优”和任务的成功率。

重定位:Prompt是知识工作流的“通信协议”

基于上述理解,我们对“Prompt 是结构化思考”这一概念进行更精确的重写:Prompt 是知识工作流中“Structure(结构化)→ Generate(生成)”之间的接口层。

在一个完整的五步知识工作流中,Prompt 承担着承上启下的关键作用。它不再是随口而出的“请求”,而是人类的结构化思考能够被模型准确接收与执行的“通信协议”。

知识工作流的五环节模型:I-S-G-I-E 的深度解构

基于 Tiago Forte 的CODE模型[6]及现代AI最佳实践,我们提出了五环节模型:Input(输入)、Structure(结构)、Generate(生成)、Iterate(迭代)、Express(表达)。

环节一:输入(Input)—— 语境的质量决定智能的上限

上下文窗口与精选 (Curation)

。研究发现,随着输入长度的增加,模型在中间部分的注意力会发生衰减(Lost in the Middle Phenomenon)[7]。这一现象意味着,模型并非简单地“读得越多、理解越好”,冗余信息反而可能稀释关键信号,降低推理与生成质量。因此,“精选(Curation)”能力变得比“收集(Collection)”更为重要。我们需要构建高信噪比的“语境包(Context Package)”,不仅包含任务所需的核心事实与数据,还应包含明确的负面约束(Negative Constraints)与参考风格。

检索增强生成 (RAG) 的前奏

在更高级的工作流中,输入不仅仅是简单的复制粘贴,而是涉及到检索增强生成(RAG, Retrieval-Augmented Generation)的逻辑。通过连接外部知识库(如 Obsidian 笔记、企业数据库),我们可以让 AI 在生成时实时调用私有的、最新的知识。在 MVW 阶段,我们通过手动筛选高质量素材来模拟这一过程,培养对“优质输入”的敏感度

环节二:结构(Structure)—— 将人类意图转化为机器指令

这是本课程的核心技能,即将非结构化信息(长文、材料、语音记录)转化为:

- 层级化大纲

- 要点列表

- 表格

- 矩阵结构

结构化编码:将原始输入转化为可计算的认知骨架

将原始输入进行整理、编码,转化为模型易于消化的结构化形式。

这一步的产出通常是提纲、表格、清单或JSON结构等。

通过结构化,复杂问题被分解为有层次的子问题,杂乱的信息被整理成有序的知识。

正如Sweller 的认知负荷理论[4]所示,恰当的组织信息可以减轻工作记忆负担,提高问题解决效率(。在实践中,这可能体现为将长篇幅的笔记提炼成层级分明的要点大纲,或者把用户的模糊需求翻译成明确的参数列表。在结构化模块,我们充当信息架构师:搭建知识的骨架,使后续的 AI 生成有据可循、有章可循。

思维链(Chain of Thought):认知的显性化

这种分步骤的结构设计,实际上是将人类专家的“元认知(Metacognition)”注入到了 AI 的生成过程中,迫使模型由浅入深地处理信息。

为了消除自然语言的歧义性,我们需要使用标准化的框架来封装我们的指令。本章将重点介绍 SCORE 模型,它就像是建筑蓝图,确保了Prompt具备所有必要的构件——角色、语境、目标、约束与示例。使用框架可以显著降低模型出现“幻觉(Hallucination)”的风险,并提高输出的稳定性

生成(Generate)—

生成环节是 AI 执行指令、产出内容的阶段。理解 LLM 作为“概率预测机”的本质,对于驾驭这一环节至关重要 。AI 并不是在像人类一样“思考”,而是在高维向量空间中,根据上文预测下一个最可能的Token。

基于结构化输入生成初稿,而不是让 AI 自由发挥。生成的关键词是:

分段生成

逐步生成

参考结构生成

遵循约束生成

确定性与创造性的权衡

确定性任务,我们需要通过降低“温度(Temperature)”参数或在 Prompt 中施加严格的格式约束,限制模型的发散

创造性任务,我们则可以允许模型探索概率空间中那些非大概率的路径,从而产生新颖的组合

骨架思维(Skeleton of Thought):并行的艺术

核心思想是模仿人类的写作过程:先构思大纲(Skeleton),再填充内容。

迭代(Iterate)

许多初学者止步于第一次生成的结果,这往往只能得到 60 分的平庸之作。真正的专家深知,好内容是“改”出来的,更是“人机协作”迭代出来的。迭代环节不仅仅是简单的修改,而是一个包含自我修正、密度提升与反馈循环的系统工程。

本阶段是本课程与其它 AI 使用课程的最大区别。 你不是接收模型输出,而是要:

- 评价

- 标注问题

- 给出反向指令

- 控制模型收敛

人类反馈

人类反馈:有效的迭代技巧包括具体化指令(指出具体哪里需要修改)、角色扮演(让模型以某专家身份自检输出)以及示例引导(提供理想输出的示例片段)等,它们能帮助模型更准确地领会我们的改进意图。

自我修正

AI 具备一种独特的能力:它可能无法一次性写出完美的代码或文章,但它往往具备“识别错误”的能力。通过设计“生成者(Generator)— 批评者(Critic)— 修正者(Refiner)”的回环工作流,我们可以让 AI 自我审视初稿,指出其中的逻辑漏洞、数据幻觉或风格不符之处,并据此进行重写 。研究表明,这种递归式的自我修正过程(Recursion)能显著提升输出质量,甚至超越了单纯增加模型参数带来的提升 。

密度链

“密度链(Chain of Density)”技术通过多轮迭代,要求 AI 在保持字数不变的前提下,逐步识别并融入更多缺失的实体(Entities)与细节,从而不断提升内容的“信息熵” 。这一过程形象地展示了迭代如何将松散的文本锻造为精炼的知识晶体

表达(Express)—— 资产的沉淀与分发

工作流的终点并非生成文本,而是将价值交付给受众,并将经验沉淀为资产。这个阶段是将生成的内核(Kernel)转化为适配最终受众的格式(PPT, 邮件, 代码)。这一步实现了知识的资产化。将对话过程沉淀为 SOP 或模板,供下次复用。

成果表达:让知识被正确的人以正确的方式理解

根据特定受众和用途,对最终内容进行包装和呈现。再好的内容也需要合适的形式表达出来。表达模块关注输出的格式、风格和可读性。例如,同样是技术报告,给管理层阅读可能需要精炼的要点和商业价值强调,而给工程团队则需要详细的数据和实现细节。成果表达阶段可能涉及让 AI 将内容改写为特定文体,增加引导语、插图,或生成摘要方便不同读者快速理解。这里,人类扮演“发行人”的角色,确保最终成果既专业美观又切合受众需求。经过这一环节,知识工作流的链路闭环完成——最初输入的信息已经被转化为对目标受众有价值的知识成果

表达不是最后润色,而是适配最终受众。包括:

风格

格式

受众阅读场景(汇报、文档、说明书、公告)

表达方式(图、表、结构图)

完整的知识工作流,是从 原始材料 → 可用成果 的系统化路径。

多模态与多渠道分发

在 AI 时代,同一份知识内核(Knowledge Core)可以被低成本地转换为多种表达形式。通过调整 Prompt 中的“角色”与“格式”要求,我们可以将一份深度研报瞬间转化为适合CEO阅读的 Executive Summary、适合开发者的Python代码演示、甚至是适合社交媒体传播的图文脚本 。这种能力的释放,极大拓展了知识工作者的影响力边界。

逆向沉淀(Reverse Prompting):闭环的最后一步

当我们在“表达”环节获得了一个惊艳的结果时,不应止步于此。我们需要利用 “逆向提示(Reverse Prompting)”技术 , 让 AI 分析“是怎样的 Prompt 生成了这个结果”,从而将这次成功的偶发经验固化为可复用的 Prompt 模板 。这不仅是个人知识库的建设,更是将隐性知识显性化、标准化的过程,为下一次工作流的启动提供了更高的起点 。

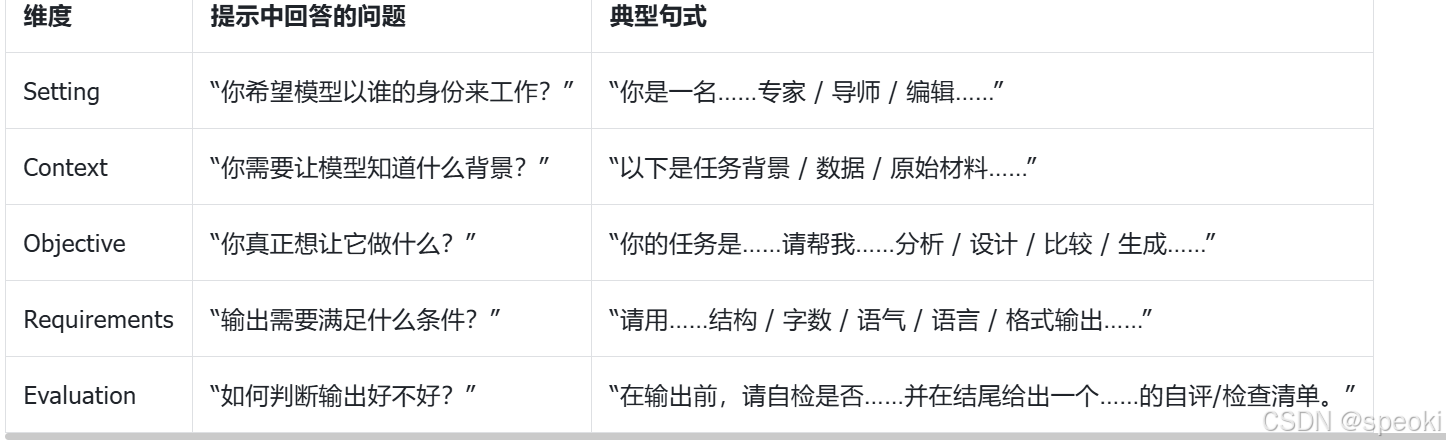

提示工程中的 S.C.O.R.E 模型——结构化Prompt 的设计艺术

S = Setting(角色设定)

C = Context(背景信息)

O = Objective(任务目标)

R = Requirements(输出要求)

E = Evaluation(评估标准)

Prompt 工程 S.C.O.R.E 模型,将一个完整 Prompt 分解为 Setting、Context、Objective、Requirements、Evaluation 五大要素。

它为构造可控、明确的提示提供了一个检查清单,帮助我们从多方面约束和引导模型的输出。

Setting (角色设定):锚定潜空间

也称“角色定位”,明确告诉模型它所扮演的角色或所处的场景。这一部分为模型赋予了初始视角和语气。大模型在不同角色指令下会倾向于采用相应的风格和侧重点。例如,以“你是一名精通营销的AI顾问”开头,模型回复时就会更多采用专业咨询的口吻。角色设定还能限定输出形式,比如“充当翻译,将以下文本翻译成英文”,模型就会只产出翻译结果。通过角色设定,我们确保模型以合适的身份和状态来理解后续请求。

定义:设定 AI 在对话中的身份、角色或模拟的人物画像。

原理:通过定义角色(Persona),利用角色定位缩减搜索空间,激活潜空间中相关的专业权重 18。

实战对比:

❌ 弱 Prompt:“写一篇关于量子计算的文章。”

✅ SCORE Prompt:“你是一位拥有20年经验的量子物理学教授,同时也是特约专栏作家。你的写作风格深入浅出…”

Context (语境/背景):构建认知基石

背景信息是模型理解任务的“土壤”。大模型本质上是基于概率预测的,如果没有充分的上下文,它会根据训练数据中的“平均概率”进行猜测,从而产生平庸的回答甚至幻觉。在这一部分,我们需要提供任务相关的背景知识、参考数据、历史对话或特定的业务约束。这不仅能缩小模型的搜索范围,还能让输出结果更“接地气”,符合特定的业务场景(如:“基于以下会议记录总结…” vs “总结一下…”)。

定义:提供任务所需的背景信息、原始数据、历史记录。

原理:利用 上下文学习 (In-Context Learning) 能力,将相关知识注入到模型的短期记忆(Context Window)中,减少对模型内部训练数据的依赖,从而降低幻觉。

实战对比:

❌ 弱 Prompt:“帮我写一份由于服务器宕机的道歉信。”

✅ SCORE Prompt:“【背景】:我们是一家SaaS公司,昨天因数据库升级导致服务中断了2小时,受影响客户约500人。我们需要向核心用户发送邮件…【参考】:请参考我们以往的公关语调(附文风样本)…”

Objective (目标/任务):植入思维链

这是 Prompt 的指令核心,即“动词”部分。虽然模型有强大的推理能力,但它无法读心。如果目标模糊,模型往往会产出大而化之的内容。一个清晰的目标应当包含具体的动作指令(Action Verbs),如“分析”、“提取”、“重写”、“分类”或“代码生成”。在这一部分,我们要将模糊的需求(“我想了解X”)转化为明确的任务指令(“请分析X的优缺点并给出建议”),确保模型的注意力机制聚焦在正确的任务类型上。

定义:明确、具体、原子化的任务指令,以及解决问题的逻辑步骤。

原理:结合 CoT (Chain-of-Thought) 技术,强迫模型展示思考过程。通过将大目标拆解为“一步步(Step-by-step)”的子任务,可以显著降低模型的推理错误率,激活其“系统2”慢思考能力。

实战对比:

❌ 弱 Prompt(模糊指令):“分析一下这份财务报表。”

✅ SCORE Prompt(链式指令):“请作为财务专家分析报表。请按以下步骤执行:

提取近三年的营收与净利润数据;

诊断成本结构中变动最大的科目;

基于历史趋势预测下一季度的现金流;

综合以上分析,提出三条具体的战略建议。”

Requirement (要求/约束):设立质量护栏

这一部分是用户作为“甲方”对交付物提出的验收标准。为了避免模型输出内容过于发散或格式混乱,我们需要明确规定输出的“形状”。这包括格式约束(Markdown、JSON、表格)、字数限制、语言风格(学术、幽默、通俗)、受众对象以及必须包含或避免的元素。明确的要求可以大幅降低后续的人工编辑成本,使生成内容直接可用。

定义:对输出结果的格式、长度、风格、禁忌进行规定。包含正向要求(Do’s)和负面约束(Don’ts)。

原理:在生成过程中对 Token 的概率分布 施加约束,强制模型按照特定的语法树或结构模式进行解码,确保输出符合预期的工程标准。

实战对比:

❌ 弱 Prompt:“把上面的内容整理一下。”

✅ SCORE Prompt:“请将上述信息整理成一张 Markdown 表格。列标题为:‘事件’、‘时间’、‘责任人’。保持语言简洁,不要使用形容词。”

Example (示例/样本):激活少样本学习

这是由“单向生成”迈向“智能推理”的关键一步。在 Prompt 中预埋评估标准,实际上是要求模型在输出最终结果前(或后)进行自我反思(Self-Reflection)。通过让模型扮演“裁判”来检查自己的生成结果,或者要求模型按照特定标准打分,可以有效激活思维链(Chain of Thought),发现逻辑漏洞并进行自我修正。这相当于在模型内部构建了一个微型的“生成-判别”对抗网络。

定义:提供 1-3 个“输入-输出”范例。

原理:激活模型的 反思 (Reflection) 能力,通过多步推理(Multi-step Reasoning)强制模型重新审视生成的逻辑链条,模拟人类的“审稿”过程。

实战对比:

❌ 弱 Prompt:“给我五个创业点子。”

✅ SCORE Prompt:“…提出五个创业点子。评估要求:在输出后,请根据‘可行性’、‘创新性’和‘成本’三个维度,对这五个点子进行打分(1-10分),并指出得分最高的一个方案。”

[ S.C.O.R.E 通用 Prompt 模板]

[Setting / 角色设定]

你是一名……

[Context / 背景信息]

- 任务场景:……

- 相关资料:……

- 已有产出/约束:……

[Objective / 任务目标]

你的任务是:……

请重点完成以下目标:

1. ……

2. ……

[Requirements / 输出要求]

- 目标读者:……(如:非技术背景的老师)

- 内容结构:……(如:三部分:现状 / 分析 / 建议)

- 表达方式:……(如:使用 Markdown 二级标题 + 列表)

- 字数与风格:……(如:800–1000 字,正式、克制,避免口语)

[Evaluation / 评估标准]

在给出最终答案之前,请先检查:

- 是否覆盖了所有目标?

- 是否与提供的背景信息一致、无自相矛盾?

- 是否严格遵守了结构与格式要求?

如果有无法满足的地方,请在答案末尾用“【待确认】”列出。

MVW:最小可行工作流(Minimum Viable Workflow)

我们引入产品设计领域 MVP(最小可行性产品)的概念,提出了工作流设计的第一原则:MVW(Minimum Viable Workflow),即最小可行工作流。

什么是 MVW?

MVW(最小可行工作流)被定义为能够把一个具体任务从输入跑到输出的、当前条件下最简单可行的工作流版本。它不是一个完美的自动化系统,而是一个“够用、能跑、可复用的 1.0 版本”。

一个合格的 MVW 应当具备以下三个核心特征:

首先是端到端完整,即从接到任务到交付成果,中间所有必要的步骤都包含在内,形成闭环,哪怕每一步都很粗糙;其次是结构尽可能简单,不追求覆盖所有边缘情况,也不要求全自动,只要“70% 由 AI 协作、30% 由人工补位”即算成功;

最后是可复用与迭代,它不应是一次性的临时拼凑,而是可以在未来遇到类似任务时再次使用的流程雏形。

从五环节模型压缩出一个MVW

我们将知识工作流的五个标准环节(Input → Structure → Generate → Iterate → Express)进行简化。在MVW 阶段,我们不需要为每个环节配置复杂的智能体或子步骤,而是通过“降维”的方式,找到每个环节的最低配版本。

下表展示了在设计MVW 时,如何将“理想状态”压缩为“最小可行状态”

案例演示:为课程写一篇“小论文”的 MVW

第一步:Input(收集最起码的材料)

我们不需要进行大规模的文献综述。作为人类协作者,你只需要列出 3-5 条自己关于 AI 改变学习的真实体验(例如“用模型检查作业思路”),并找出 2-3 篇老师推荐过的相关文章。将这些信息整理成一份简单的“原始材料清单”备用。

人类:

列出 3–5 条自己关于“生成式 AI 改变学习方式”的真实体验;

找 2–3 篇老师或课堂推荐过的相关文章(而不是从零开始乱搜)。

产出:

一份简单的“材料清单”,例如:

💡

# 原始材料

- 我的体验:

- 用大模型检查作业思路vs直接给答案

- 用搜索 + 用模型的时间对比

- 记笔记从“抄PPT”变成“和模型对话整理”

- 参考文章:

- 文章A:某某高校关于AI辅助学习的调研

- 文章B:某科技媒体关于学生使用GPT的报道

第二步:Structure(粗略搭结构)

放弃完美的思维导图工具,仅在文本框中列出简单的结构草图。例如采用“引言—三个具体影响—结论”的框架,并为每一部分写下 2-3 个核心要点。这步操作是为了确保 AI 生成的内容有骨架支撑,不至于跑题。

-

人类:

采用“总分总”或“问题–分析–建议”这样的简单结构;

列出每一部分的 2–3 个要点。

-

可能的结构示例:

# 小论文结构草图

1. 引言:AI进入大学课堂的速度

- 简要背景:ChatGPT/通义千问等工具的普及

- 本文问题:它究竟如何改变了学习方式?

2. 影响一:学习资料获取方式的变化

- 从“搜资料”到“要解释”

- 学生更容易获得“多视角答案”

3. 影响二:作业与学术诚信的挑战

- 抄答案 vs 辅助思考

- 教师评估方式的调整

4. 影响三:学习策略与元认知的转变

- 从“背答案”到“设计问题”

- 学生需要掌握Prompt和工作流思维

结论:如何善用AI,避免依赖与滥用?

第三步:Generate(让 AI 生成初稿)

这是核心环节。利用 S.C.O.R.E 模型编写一条 Prompt。你需要明确告诉模型:角色是教育技术方向学生,背景是上述整理的材料和结构,任务是撰写 1500 字小论文。特别要注意自检标准的设定,例如要求模型“检查是否覆盖了结构草图中的所有章节”。

-

人类:

- 用 S.C.O.R.E 模型写一个 Prompt,告诉模型:

- 角色:教育技术方向的学生 / 研究者

- 背景:上面那份结构和材料

- 目标:1500 字左右的小论文

- 要求:结构清晰,引用生活体验,避免浮夸词

- 评估:检查是否覆盖每一章的要点

- 示例 Prompt(简化版):

- 用 S.C.O.R.E 模型写一个 Prompt,告诉模型:

你是一名教育技术方向的本科生,需要为课程写一篇小论文。

【背景材料】

(粘贴“原始材料”和“结构草图”)

【写作任务】

请根据上述结构,撰写一篇约 1500 字的小论文,主题为“生成式 AI 对大学学习方式的影响”。

【写作要求】

- 采用“引言 – 三个影响 – 结论”的结构。

- 每一部分要引用至少一条我的真实体验或参考文章中的观点。

- 语气客观、克制,避免出现“颠覆”“革命性”“史无前例”等夸张词。

- 用一位学生第一视角写,但不要太口语化。

【自检标准】

输出前,请检查:

- 是否覆盖了结构草图中的所有章节?

- 是否每一章都有具体例子或论据支持?

- 结论部分是否给出了至少两条“如何善用 AI”的建议?

第四步:Iterate(清单式修正)

拿到初稿后,不要试图重写一切。通读一遍,找出三个最关键的问题:哪里不准确?哪里太空洞?哪里太啰嗦?将这三点整理成一个简短的“改进清单”反馈给 AI(例如:“请加入一个具体的概率论课例子”、“删掉关于全球革命的夸张描述”),让模型生成第二版。

- 人类:

- 读一遍初稿,先不急着埋怨模型,而是问三个问题:

有哪些地方明显不准确或与我的真实体验不符?

有哪些段落太空,需要更具体的例子?

有哪些地方可以删掉或合并,让篇幅更紧凑?

根据这三点,整理一份简短的改进清单,再进行二次交互。例如:

- 读一遍初稿,先不急着埋怨模型,而是问三个问题:

请在原文基础上做一次修改,注意:

1. 第二部分请加入一个更具体的例子:我如何用 GPT 帮助理解概率论课上的定理。

2. 第三部分关于“学术诚信”的内容,请删掉关于“全球教育革命”的描述,改为更实在的课堂场景。

3. 全文长度控制在 1600 字以内,可以适当合并类似句子。

第五步:Express(交付形态)

最后,由人类完成最后的“包装”工作。将 AI 生成的文本复制到文档软件中,调整标题格式、检查段落层次、添加页眉页脚和文件名。至此,一个端到端的任务就完成了。

- 人类:

- 最终在 Word / Markdown 中整理排版,

- 检查标题格式、段落层次、页眉页脚、文件名(如:2025-Task02-AI-learning-essay-张三.md)。

到此,一个小论文写作的 MVW 就完成了:

你有一条端到端的、可复用的工作流,可以下次继续套用——只需要替换输入材料和结构草图。

设计MVW时的常见误区与原则

在实际练习中,学员们很容易因为思维惯性而踩坑。最常见的错误包括一上来就追求全自动、步骤设计得过于细碎导致无法执行,以及缺乏明确的输入输出定义。

我们可以参考下表来规避这些误区:

课程总结

本章不仅为你介绍了一套工具,更定义了一种全新的工作方式。从 I-S-G-I-E 模型的宏观架构,到 SCORE 框架的微观操控,再到 MVW 的实战演练,我们完整地走过了一遍知识生成的闭环。

工具(AI)不是目的,流(Workflow)才是资产。 现在的任务是:打开你的 AI 工具,按照 SCORE 模型,构建并运行你的第一个 MVW。未来的知识高地,属于那些能够驾驭工作流的人。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)