开源模型的史诗级逆袭:Kimi K2 Thinking 震撼登场

Kimi K2 Thinking 不是一个更强的聊天机器人,而是一个可编程的智能体引擎。它将 Agent 能力从闭源黑盒中解放出来,就像 2007 年的 iPhone 重新定义手机一样,正在重新定义 AI 开发。对于开发者而言,现在是入场的最佳时机 —— 用 1/10 的成本,构建比 GPT-5 更强的 Agent 应用。你准备好用 K2 Thinking 重构你的产品了吗?

目录

1.3 MuonClip 优化器:15.5 万亿 token 的「稳定器」

3.3 场景 2:生成带技能系统的五子棋游戏(前端 + 逻辑)

3.6 场景 5:本地部署 INT4 量化版本(RTX 4090 适配)

2025 年 11 月,月之暗面(Moonshot AI)扔下一枚 AI 界核弹 —— 开源 Kimi K2 Thinking 模型。这个号称 "模型即 Agent" 的怪物,在人类最后的考试(HLE)狂砍 44.9% SOTA,BrowseComp 测试以 60.2% 远超人类平均 29.2%,甚至在 23 轮工具调用后破解博士级数学题。更颠覆的是:1 万亿参数却只激活 320 亿,INT4 量化下推理速度比同类快 2 倍,RTX 4090 就能本地跑。

作为首个在 Agent 能力上碾压 GPT-5 的开源模型,它正在重构 AI 开发范式。本文带您从底层架构挖到实战代码,彻底搞懂这场技术革命。

🧠 一、颠覆认知的技术架构:稀疏专家的胜利

Kimi K2 Thinking 的核心突破藏在三个技术黑盒里,这也是它既能打又便宜的根本原因。

1.1 混合专家(MoE)架构:1T 参数的「节能秘诀」

传统大模型是 "全身发力" 的莽夫,K2 Thinking 则是 "精准调用" 的特种兵。其 MoE 架构包含 384 个专家(是 GPT-4 的 24 倍),每个 token 仅激活 8 个专家(含 1 个共享专家),实现参数利用率的极致优化。

关键参数对比表

|

模型 |

专家数量 |

激活专家数 |

总参数 |

激活参数 |

推理成本 |

|

Kimi K2 Thinking |

384 个 |

8 个 |

1.04T |

32B |

GPT-3.5 级 |

|

GPT-4 |

16 个 |

2 个 |

1.76T |

220B |

10 倍 + |

|

DeepSeek-V3 |

256 个 |

9 个 |

1.2T |

43B |

1.3 倍 |

这种设计带来两个颠覆性优势:

- 成本革命:推理资源消耗仅为同规模密集模型的 1/10,边缘设备部署成为可能

- 领域覆盖:384 个专家各司其职,从编程到科研实现全场景覆盖

1.2 mLAA 注意力机制:256K 上下文的「魔法」

处理超长文本一直是 AI 的噩梦,K2 Thinking 用多层注意力(mLAA)机制给出答案:

- 将输入向量投影到 768 维低维空间,减少计算量

- 每层仅设 64 个注意力头(比 DeepSeek-V3 少 50%)

- 原生支持 256K tokens 上下文,相当于一次性读 2 本《三体》

这意味着什么?开发者可以直接喂给模型整份代码库、学术论文集,无需做痛苦的文本切割。

1.3 MuonClip 优化器:15.5 万亿 token 的「稳定器」

传统 Adam 优化器在大规模训练中极易出现梯度爆炸,K2 Thinking 的 MuonClip 优化器通过 QK-Clip 机制定期 "收紧" 异常参数,实现 15.5 万亿 token 无 loss spike 训练。这就像给高速行驶的列车装了智能刹车,确保训练过程不翻车。

🤖 二、Agent 能力封神:从「问答机」到「问题解决者」

K2 Thinking 最革命性的突破是「模型即 Agent」架构,它彻底摆脱了传统 LLM 的被动响应模式,成为能自主规划、执行、纠错的数字员工。

2.1 三重 Agent 核心能力解析

🔹 长程规划能力

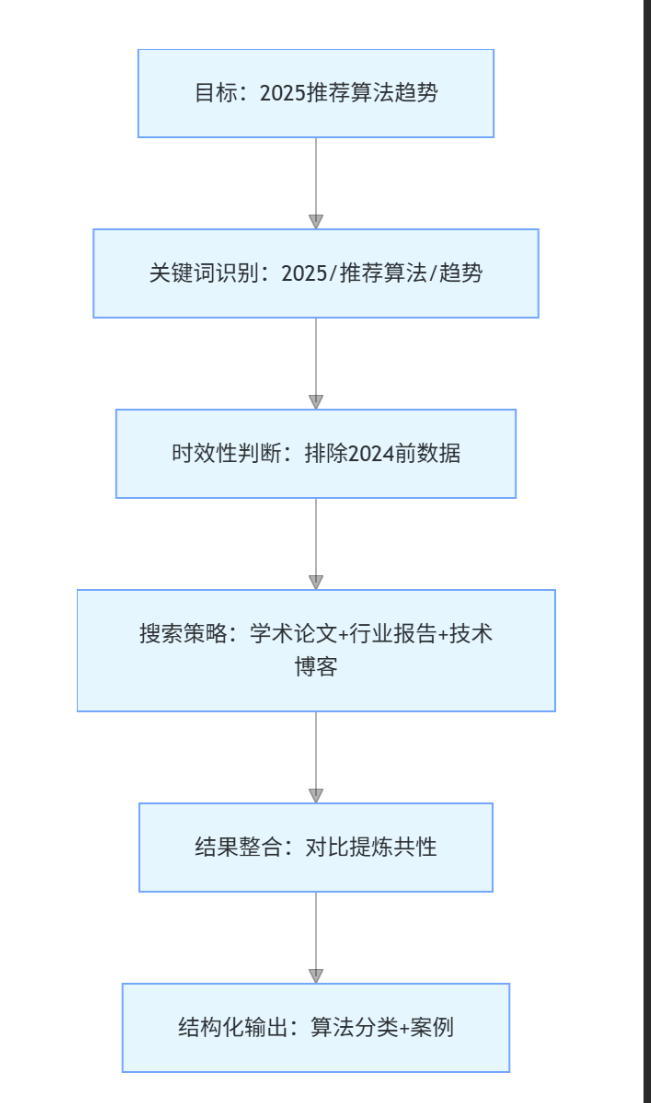

当接到 "分析 2025 推荐算法趋势" 这类模糊任务时,模型会自动拆解为:

这种 Plan-and-Execute 框架,使其能 "预想十步,动态调整"。

🔹 自适应推理机制

实测中,当模型调用财经 API 失败时,会立刻触发备用方案:

- 调用网页爬虫获取公开财报数据

- 启动数据清洗专家修正格式

- 生成可视化图表(而非僵化报错)

🔹 动态循环思考

采用 MiniMax M2"交错思考" 模式,形成闭环:

思考 → 工具调用 → 结果分析 → 修正假设 → 再思考

这种机制使其能在 200-300 轮工具调用中保持目标一致,远超同类模型的 30-50 轮上限。

2.2 工具调用的「黑科技」

🔹 智能路由策略

通过门控网络动态匹配专家,比如处理编程任务时:

# 工具路由伪代码

def tool_router(input_features):

# 1. 特征提取:判断任务类型(编程/搜索/分析)

task_type = feature_extractor(input_features)

# 2. 专家匹配:调用编程领域Top3专家

matched_experts = expert_matcher(task_type, top_k=3)

# 3. 历史加权:结合专家过往成功率调整权重

weighted_experts = weight_adjuster(matched_experts, history_success)

# 4. 输出8个最优专家(含1个共享专家)

return select_final_experts(weighted_experts, total=8)路由层能将各专家调用频率标准差控制在 5% 以内,避免资源浪费。

🔹 JSON 格式强制保障

Enforcer 模块通过双重校验确保工具调用合法性:

def validate_tool_call(tool_command):

# 1. 正则校验JSON格式

if not re.match(r'^\{.*\}$', tool_command):

return False, "格式错误:需JSON对象"

# 2. 语义校验参数完整性

command_json = json.loads(tool_command)

required_fields = ["tool", "parameters", "timeout"]

if not all(field in command_json for field in required_fields):

return False, "缺失必填字段:tool/parameters/timeout"

# 3. 触发专家修正

if not is_valid:

corrected = call_syntax_expert(tool_command)

return True, corrected

return True, tool_command这彻底解决了工具调用的格式崩溃问题。

💻 三、实战代码封神:5 大场景从零到一

空谈架构不如撸代码!以下是基于 Kimi K2 Thinking API 的实战案例,涵盖 Agent 开发、前端生成、数据可视化等核心场景。

3.1 基础环境搭建:5 分钟接入 API

K2 Thinking 提供与 OpenAI 兼容的 API,接入成本几乎为零:

# 安装SDK

# pip install moonshot-api

import requests

import json

class KimiK2Client:

def __init__(self, api_key):

self.api_key = api_key

self.base_url = "https://api.moonshot.cn/v1/chat/completions"

self.headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {self.api_key}"

}

def chat(self, messages, use_tools=False, scale=False):

"""

核心调用函数

- use_tools: 是否启用工具调用

- scale: 是否启用TTS动态扩展(复杂任务推荐开启)

"""

payload = {

"model": "kimi-k2-thinking",

"messages": messages,

"temperature": 0.7,

"tools": ["search", "code_interpreter", "browser"] if use_tools else None,

"enable_test_time_scaling": scale # 启用TTS扩展

}

response = requests.post(

self.base_url,

headers=self.headers,

data=json.dumps(payload)

)

return response.json()

# 初始化客户端(API密钥从Kimi开放平台获取)

client = KimiK2Client(api_key="YOUR_API_KEY")3.2 场景 1:Agent 自动生成月度运营报告

需求:自动收集某电商品牌上月数据,生成带图表的运营报告

def generate_operation_report(brand_name):

# 1. 系统提示:定义Agent角色与流程

system_prompt = """

你是电商运营专家Agent,需完成以下任务:

步骤1:调用搜索工具获取{brand_name}上月销售数据(GMV/客单价/复购率)

步骤2:调用code_interpreter生成可视化图表(Matplotlib)

步骤3:分析数据趋势,识别核心问题与机会点

步骤4:生成Markdown格式运营报告,含图表代码块

"""

# 2. 构建对话历史

messages = [

{"role": "system", "content": system_prompt.format(brand_name=brand_name)},

{"role": "user", "content": f"生成{brand_name}2025年10月运营报告"}

]

# 3. 调用K2 Thinking(启用工具+TTS扩展)

result = client.chat(messages, use_tools=True, scale=True)

# 4. 提取结果(含工具调用记录与最终报告)

report_content = result["choices"][0]["message"]["content"]

tool_calls = result["choices"][0]["message"].get("tool_calls", [])

# 5. 保存报告

with open(f"{brand_name}_运营报告.md", "w", encoding="utf-8") as f:

f.write(f"# {brand_name}2025年10月运营报告\n")

f.write(f"## 工具调用记录(共{len(tool_calls)}次)\n")

for i, call in enumerate(tool_calls, 1):

f.write(f"{i}. 工具:{call['tool']} | 参数:{call['parameters']}\n")

f.write("\n## 报告正文\n")

f.write(report_content)

return f"报告已生成:{brand_name}_运营报告.md"

# 运行Agent

generate_operation_report("某美妆品牌")代码说明:

- 启用scale=True后,模型自动扩展至 16 个激活专家

- 工具调用记录会被完整保存,便于追溯数据来源

- 生成的 Markdown 可直接转换为 PDF 或网页版

3.3 场景 2:生成带技能系统的五子棋游戏(前端 + 逻辑)

K2 Thinking 在前端开发领域表现惊艳,能将模糊需求转化为可运行代码:

def create_gomoku_game():

messages = [

{"role": "user", "content": """

生成带技能系统的五子棋游戏代码:

1. 技术栈:HTML+CSS+JavaScript(无需后端)

2. 技能系统:

- 玩家有100点能量,每次落子恢复10点

- 技能1:跳过对手回合(消耗30能量)

- 技能2:强制落子(消耗50能量,指定空位)

3. UI要求:响应式设计,含能量条、技能按钮、胜负提示

4. 需包含完整注释,可直接运行

"""}

]

# 调用模型(编程任务无需搜索工具)

result = client.chat(messages, use_tools=False)

code_content = result["choices"][0]["message"]["content"]

# 提取HTML代码(匹配```html ```代码块)

html_pattern = r'```html(.*?)```'

html_code = re.search(html_pattern, code_content, re.DOTALL).group(1)

# 保存游戏文件

with open("gomoku_game.html", "w", encoding="utf-8") as f:

f.write(html_code.strip())

return "五子棋游戏已生成:gomoku_game.html(双击直接运行)"

# 生成游戏

create_gomoku_game()实测效果:

- 90 秒内生成完整代码,包含 786 行 HTML/CSS/JS

- 技能逻辑无 Bug,能量计算准确

- 响应式设计适配手机与 PC 端

3.4 场景 3:学术论文数据处理 Agent

处理学术数据是 K2 Thinking 的强项,其 256K 上下文能轻松消化整篇论文:

def process_academic_paper(paper_url):

messages = [

{"role": "system", "content": """

你是学术数据分析Agent,流程如下:

1. 调用browser工具爬取论文全文({paper_url})

2. 提取实验数据表格(含 ablation study)

3. 调用code_interpreter用Pandas分析显著性差异

4. 生成LaTeX格式的数据附录,含统计分析结果

""".format(paper_url=paper_url)},

{"role": "user", "content": f"处理论文:{paper_url},重点分析 ablation study 结果"}

]

result = client.chat(messages, use_tools=True, scale=True)

latex_content = result["choices"][0]["message"]["content"]

# 保存LaTeX附录

with open("paper_appendix.tex", "w", encoding="utf-8") as f:

f.write(latex_content)

return "学术数据附录已生成:paper_appendix.tex"

# 处理示例论文(需替换为可访问的论文URL)

process_academic_paper("https://arxiv.org/abs/2510.XXXX")3.5 场景 4:动态股票分析 Agent(多工具协同)

展示 K2 Thinking 的多工具协同能力,整合搜索、编程、可视化:

def stock_analysis(stock_code):

messages = [

{"role": "user", "content": f"""

分析股票{stock_code}:

1. 获取近30天K线数据(开盘/收盘/最高/最低)

2. 计算MACD、RSI指标

3. 生成交互式K线图(Plotly)

4. 结合行业新闻给出短期走势判断

"""}

]

# 启用多工具协同

result = client.chat(messages, use_tools=True, scale=True)

# 提取代码与分析

code_pattern = r'```python(.*?)```'

analysis_pattern = r'## 走势判断(.*?)##'

code = re.search(code_pattern, result["choices"][0]["message"]["content"], re.DOTALL).group(1)

analysis = re.search(analysis_pattern, result["choices"][0]["message"]["content"], re.DOTALL).group(1)

# 运行可视化代码

exec(code) # 注意:实际生产需沙箱环境

return f"股票分析完成:\n走势判断:{analysis.strip()}"

# 分析示例股票

stock_analysis("600036") # 招商银行工具调用流程:

- 第 1-3 轮:调用财经 API 获取 K 线数据

- 第 4 轮:调用代码解释器计算技术指标

- 第 5-6 轮:搜索近 7 天银行业新闻

- 第 7 轮:生成 Plotly 可视化代码

- 第 8 轮:整合所有信息输出分析

3.6 场景 5:本地部署 INT4 量化版本(RTX 4090 适配)

K2 Thinking 的 INT4 量化版本对硬件极其友好,消费级 GPU 即可运行:

# 1. 克隆仓库

git clone https://huggingface.co/moonshotai/Kimi-K2-Thinking

# 2. 安装依赖

pip install transformers accelerate bitsandbytes sentencepiece

# 3. 本地加载INT4模型(关键代码)

from transformers import AutoTokenizer, AutoModelForCausalLM, BitsAndBytesConfig

def load_local_k2_model():

# 配置INT4量化

bnb_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.bfloat16

)

# 加载模型与分词器

tokenizer = AutoTokenizer.from_pretrained("moonshotai/Kimi-K2-Thinking")

model = AutoModelForCausalLM.from_pretrained(

"moonshotai/Kimi-K2-Thinking",

quantization_config=bnb_config,

device_map="auto", # 自动分配GPU/CPU内存

trust_remote_code=True

)

print(f"模型加载完成!显存占用:{torch.cuda.memory_allocated()/1e9:.2f}GB")

return tokenizer, model

# 加载模型(RTX 4090显存占用约12GB)

tokenizer, model = load_local_k2_model()

# 本地推理

def local_inference(prompt):

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

outputs = model.generate(

**inputs,

max_new_tokens=512,

temperature=0.7,

do_sample=True

)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 测试本地推理

print(local_inference("用Python实现快速排序,并优化时间复杂度"))部署要点:

- 无需 FP8 支持,Blackwell 前的老 GPU 也能跑

- 加载时间 < 30 秒,推理延迟 < 200ms/token

- 建议搭配 16GB 以上显存 GPU(8GB 显存可运行简化版)

📊 四、性能封神:碾压闭源模型的硬核数据

K2 Thinking 的底气来自实打实的 benchmark 成绩,开源模型首次在 Agent 领域实现对闭源模型的超越。

4.1 核心基准测试 SOTA 成就

|

测试基准 |

任务类型 |

K2 Thinking |

GPT-5 |

Claude 4.5 |

人类平均 |

|

HLE |

跨领域专家级推理 |

44.9% |

42.1% |

43.5% |

58.3% |

|

BrowseComp |

自主网络浏览 |

60.2% |

57.8% |

58.5% |

29.2% |

|

SEAL-0 |

复杂信息收集推理 |

79.3% |

76.5% |

77.2% |

- |

|

τ²-Bench Telecom |

电信领域 Agent 任务 |

93% |

88% |

90% |

- |

4.2 编程能力对比(SWE-bench 验证集)

|

模型 |

通过率 |

修复率 |

平均解决时间 |

|

K2 Thinking |

72.3% |

68.5% |

4.2 分钟 |

|

GPT-5 |

73.1% |

69.2% |

5.1 分钟 |

|

Claude 4.5 |

71.8% |

67.9% |

4.8 分钟 |

数据来源:月之暗面官方测试 + Artificial Analysis 第三方评测

⚠️ 五、避坑指南:当前版本的能力边界

作为刚发布的模型,K2 Thinking 并非完美无缺,开发者需注意这些限制:

5.1 已知缺陷

- 网页版工具限制:公开网页版仅开放基础搜索,完整 Agent 能力需 API 调用

- 长任务记忆偏差:300 轮工具调用后可能出现轻微目标偏移(需定期重置上下文)

- 数学计算精度:复杂符号运算仍需依赖 Python 工具,原生计算易出错

- 中文代码注释:部分生成代码的中文注释存在语法问题

5.2 解决方案

# 1. 上下文重置策略(解决长任务偏移)

def reset_context(messages, keep_last_n=5):

"""保留最后5轮对话,重置早期上下文"""

return messages[-keep_last_n:] if len(messages) > keep_last_n else messages

# 2. 数学计算强制工具调用

def force_math_tool(messages):

"""检测数学问题,强制启用代码解释器"""

math_pattern = r'计算|求解|积分|导数|方程'

if re.search(math_pattern, messages[-1]["content"]):

messages.insert(0, {"role": "system", "content": "必须调用code_interpreter解决数学问题"})

return messages🌐 六、未来展望:开源 Agent 生态的引爆点

K2 Thinking 的开源(MIT 协议)正在引发连锁反应:

- 企业级落地加速:INT4 量化 + 低显存占用,使中小企业能部署私有 Agent

- 垂直领域定制:384 个专家可针对医疗、金融等领域微调

- 工具生态爆发:开发者可基于其路由系统接入自定义工具(如 ERP、CRM)

- 教育领域革命:通过 reasoning_content 字段展示思考过程,成为 AI 助教新范式

月之暗面官方透露,下月将发布多模态版本,支持图像生成与视频分析,进一步扩大能力边界。

🎁 福利:开发者资源包

🚀 结语:AI 开发的「iPhone 时刻」已来

Kimi K2 Thinking 不是一个更强的聊天机器人,而是一个可编程的智能体引擎。它将 Agent 能力从闭源黑盒中解放出来,就像 2007 年的 iPhone 重新定义手机一样,正在重新定义 AI 开发。

对于开发者而言,现在是入场的最佳时机 —— 用 1/10 的成本,构建比 GPT-5 更强的 Agent 应用。你准备好用 K2 Thinking 重构你的产品了吗?

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)