“豆包手机”引热议!企业AI落地的关键是“怎么用”?还是“怎么合规”?

通过这一整套建设方案,企业不仅可以确保 AI 在合规边界内运行,满足 GDPR、CCPA、PIPL 等法规对身份可验证、最小权限、可审计的要求,更能在此基础上放心地扩展 AI 场景,让“安全、可控、可追责”的 AI 成为新的生产力引擎。当 AI 通过 RAG、向量检索、知识库等形态访问企业数据时,派拉的数据访问代理会基于令牌中携带的身份与属性,自动改写查询语句、注入数据过滤条件、输出脱敏字段,确保

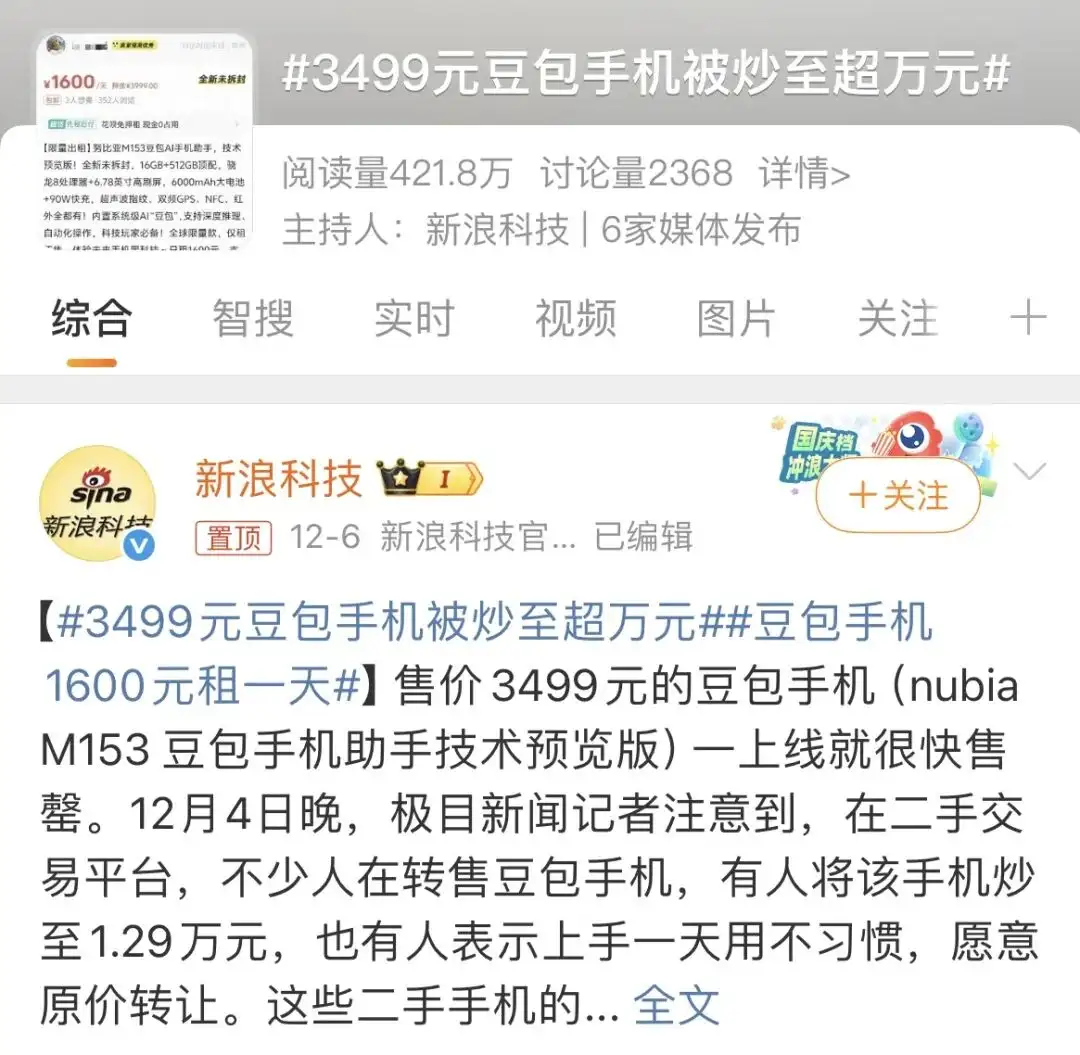

最近,“豆包手机”频频冲上热搜。更令人意外的是,它竟然成了近几年难得一见的——“二手机比新机还贵”的存在。

为什么一台手机会引发这样罕见的市场现象?核心原因很简单:它搭载了一位“拥有系统级权限的 AI 助手”。

这意味着什么?

对于网络安全从业者来说,这句话的分量无需多言——这个 AI 助手几乎拥有整部手机的最高权限,可以在系统底层自由操作。

这当然让人惊叹:它能做以前手机做不到的事,能以全新的方式重新定义用户体验和功能边界。

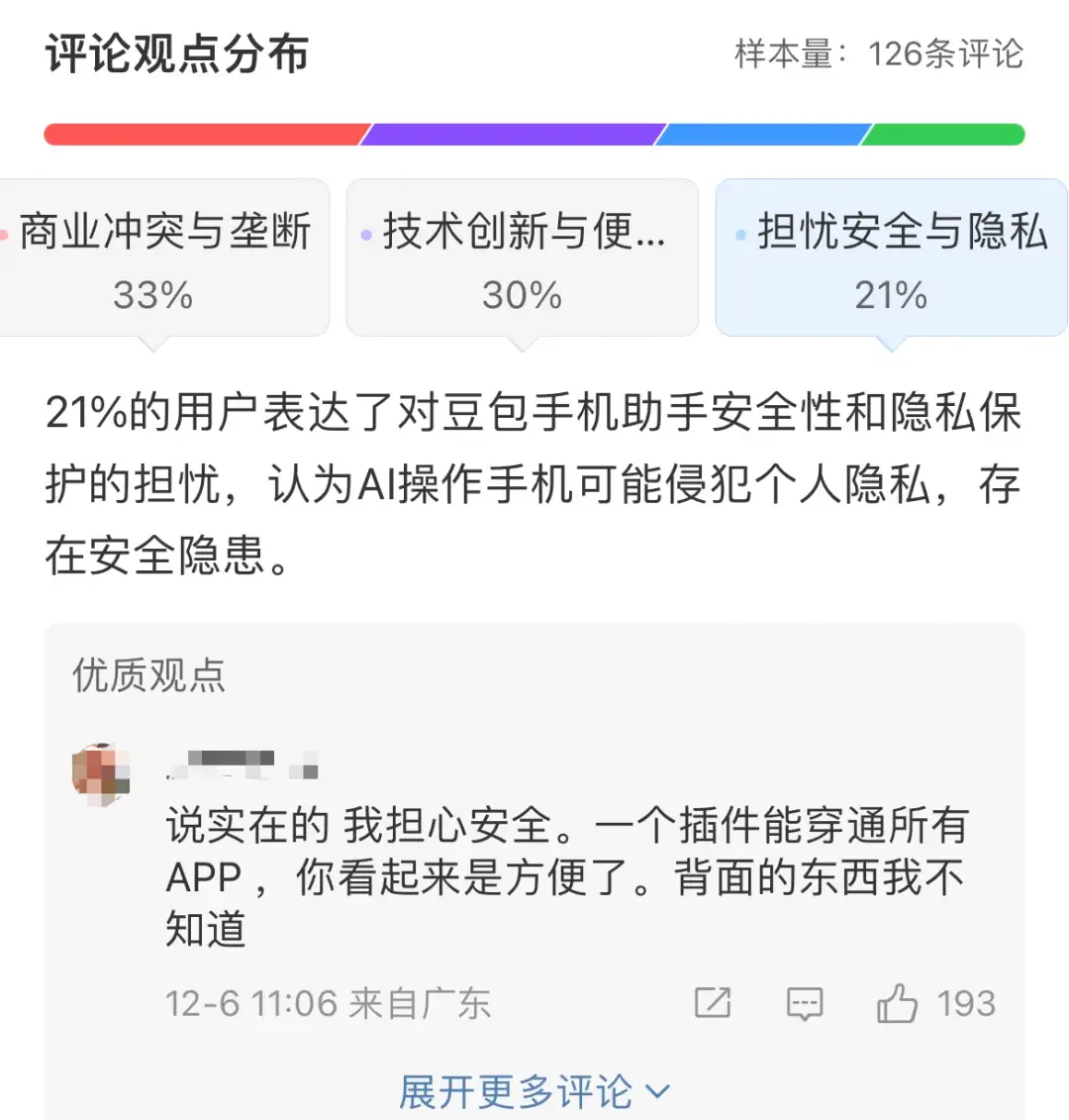

但与此同时,一个挥之不去的问题也开始在心里盘旋——当 AI 拥有全部权限时,这样的手机,还安全吗?万一 AI 在没有明确授权的情况下自动操作支付应用、发起银行转账,又会发生什么?

这种担忧并非普通用户的“杞人忧天”。

在企业世界里,这正是许多 CIO、CSO、合规负责人最真实的焦虑:当 AI 全面进入企业、进入业务流程,它带来的价值是巨大的,但随之而来的安全与合规风险也会成倍、甚至指数级放大。

派拉软件在大量企业实践中清晰地看到:AI 推不动,不是技术不够强,而是安全和合规的底座未打牢,谁也不敢贸然全面放开使用。

那么,风险究竟来自哪里?我们不妨从 AI 最关键的三个环节谈起:

1、数据输入:边界失效,数据混流成新风险

众所周知,AI模型训练讲究“多吃数据,吃好数据”。回到企业的现实情况,这些喂养的数据往往来自内部系统、外部平台乃至第三方服务等,存在大量跨系统流动。

这就意味着过去那套“守住边界、内部可信”的逻辑已经不适用。数据混流、敏感信息暴露、无授权采集……都可能发生。

2、模型本体:成为攻击者的新主要靶点

传统系统是“黑客攻服务器”;AI时代可能变成“黑客攻你的模型,让模型自己泄密”。

提示注入、数据投毒、越权调用、模型反推……这些都已是真实发生的案例。模型本身正在成为攻击的核心。

3、AI输出:偏见、违规内容触发监管问题

AI输出如果没有权限控制和审计机制,可能毫无预警地产生这些内容:暴露敏感数据、生成带偏见的决策、触发跨境合规违规、输出未经授权的内部信息......

所有这些,都已成为全球监管重点,随之而来的就是企业风险。

所以我们常说:AI安全不再只是“防攻击”,而是贯穿输入、模型、输出全链路的“身份与合规管理”。

一、全球数据保护法规齐上阵,企业面临多重压力

回到实际法律法规来看,先合规再上线已成为AI时代企业的必然选择。

当前,全球法规碎片化,跨境与本地化要求相互冲突。不同国家对跨境要求、本地化要求、数据主体权利、合规证明方式等都有各自标准。企业要满足这么多不同标准,成本自然成倍增加。

其次,违规成本惊人!GDPR最高可罚全球营收 4%,美国州法中多起罚款已经超过数千万美元,国内也逐步加大了处罚力度。

因此,企业不得不面对一个新现实:AI可以迭代,合规不能补救。上线前不合规,将付出巨大代价。

这也是为什么很多企业CIO、CSO在讨论AI落地时,第一反应不是“怎么用”,而是“怎么合规”。

二、为什么“身份为中心”成AI安全合规的必备路线?

我们再细看全球法律法规,会发现无论是欧洲的 GDPR、美国的 CCPA,还是国内的 《个人信息保护法》......这些法规虽然存在核心差异,但也有共同焦点:

可验证身份(验证调用者是否可信)

最小权限(只能访问必要数据)

全审计可追溯(每一次调用都可查)

这些要求直接指向同一个核心技术:IAM(身份与访问控制管理)。

此外,从安全技术角度来看,过去的安全逻辑是“把网络边界守住,人只要进了系统,就是可信的。”但AI时代已经完全变了。你面对的主体不仅是“人”,还有系统服务、AI Agent......

它们之间的调用频次极高,动作高度自动化,且跨越多个系统。要想真正控制风险,必须回答三个问题:

是谁在访问?

能访问什么?

做了什么?

而这正是IAM的核心能力!

因此,无论是在满足安全合规的角度,还是在技术安全维度,IAM都是企业AI时代系统安全的基础底座。

三、AI时代,传统IAM体系亟需升级

然而,AI时代,企业如果还停留在传统的IAM体系防御,势必会带来严重安全风险。

据Gartner 的预测显示:70%的企业在引⼊AI应⽤后,未同步升级IAM策略,导致权限蔓延⻛险提⾼了300%。

换句话说,为了让AI能安全运行,企业IAM体系必须升级:

1、从“角色”变成“属性”

权限不再是提前设定好的,而是根据任务、上下文、风控实时调整,进一步加强防御能力。

2、从“账号”变成“主体”

人、服务、机器人流程自动化、AI Agent......都必须有自己的“身份档案”。

3、从“系统日志”变成“全链路可观测”

每次调用、每条数据、每一次权限变化都需要被记录。

四、零信任IAM架构重塑企业AI落地安全

在上述背景下,以“身份为中心”的 零信任IAM架构成为企业AI 安全治理体系的关键——通过统一的身份管理、权限控制、接口管控与数据权限模型,构建一套覆盖人类用户、业务系统与 AI Agent 的全域安全底座。

整体建设思路可以概括为:“先立主体,再定边界,最后做监控与问责”。

1、AI主体身份治理

首先,在主体层面,将 AI 从“工具”提升为一类独立的数字主体,纳入企业 IAM 体系统一治理。

通过 AI 身份治理模块,为 Agent、MCP 等 AI 实体提供注册与自动发现机制,分配唯一标识(ID)、密钥与凭证,并与其背后的人类责任人建立强绑定关系。

所有 AI 身份都被纳入统一的生命周期管理:从注册、启用、授权、权限收敛直至注销,确保不存在“无主 AI”“野生 Agent”等。

与此同时,结合现有的人力组织、岗位体系,把 AI 身份与业务角色、部门、系统帐号建立映射,实现“人—AI—系统”的三维身份视图。

2、AI业务权限动态控制

其次,在权限边界上,采用“零信任 + ABAC(基于属性的访问控制)”的方式重构 AI 权限模型。

在每一次调用中综合评估调用方身份(人/系统/Agent)、任务类型、数据敏感级别、环境风险评分等上下文信息,实时决策是否放行、放行到什么粒度、是否需要人类复核。

对于高风险或新型业务操作,系统自动触发“人类在环”机制,将请求升级至责任人审批后才可执行,形成“AI 运行、人工兜底”的控制闭环。

所有策略以统一策略编排平台集中管理,可按业务域、数据域、区域监管要求进行差异化下发。

3、AI访问接口控制

在接口通路上,通过“AI 业务接口控制层”和“AI 网关”对所有 AI 调用进行统一代理。

无论是 Agent 调用内部业务 API,还是 MCP 调用外部大模型服务,都必须经由接口控制平面完成身份认证、权限校验与 Token 透传。

AI 网关统一托管模型 Key 和调用凭证,扮演策略执行点(PEP),严格防止绕过网关的直连调用;同时,对调用频率、目标资源、返回数据进行策略控制和审计记录,避免 AI 在自动化场景下发生权限蔓延和滥用调用。

4、AI数据权限控制

在数据安全层面,引入专门的 AI 数据权限控制模型,将“谁可以访问什么数据”的问题细化为对表级、字段级、记录级的精细化授权。

数据根据敏感度进行分级分类,不同级别对应不同的访问前置条件(如强认证、多因子、人审)与不同的展示形态(如脱敏展示、聚合展示、只读/只写限制等)。

当 AI 通过 RAG、向量检索、知识库等形态访问企业数据时,派拉的数据访问代理会基于令牌中携带的身份与属性,自动改写查询语句、注入数据过滤条件、输出脱敏字段,确保“AI 看到的世界”严格受限于其被授权的范围。

针对数据导出和批量处理场景,系统还会自动注入水印、记录导出轨迹,为后续追责提供证据。

5、安全运营与合规监管

最后,在安全运营与合规监管层面,构建面向 AI 的监控与可观测性体系。

一方面,通过统一审计平台记录每一个 AI Agent 的关键行为:包括谁在什么时间、以什么身份、经由哪个接口访问了哪些数据、触发了哪些策略;

另一方面,通过可观测性组件将 AI 的调用链路、响应结果、策略命中情况可视化,帮助安全团队识别异常模式,如异常放量调用、越权访问趋势、提示注入迹象等。

配合可配置的告警和报表能力,企业可以面向内部合规、外部审计和监管检查,提供完整、连贯、可验证的 AI 行为证据链。

通过这一整套建设方案,企业不仅可以确保 AI 在合规边界内运行,满足 GDPR、CCPA、PIPL 等法规对身份可验证、最小权限、可审计的要求,更能在此基础上放心地扩展 AI 场景,让“安全、可控、可追责”的 AI 成为新的生产力引擎。

五、企业AI落地不仅关乎“怎么用”,更需解决“怎么合规”

AI带来的价值巨大,但这一切都建立在“可信”基础之上。越是大型企业、跨区域企业、数据密集型企业,越会感受到这件事的重要性。

派拉软件认为:能不能用AI,不仅取决于技术,更取决于你有没有构建好“身份为中心的安全能力”。当底座打牢,AI才真正能成为企业的生产力。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)