以后 P 图、做 3D 只要一句话?Meta 发布 SAM 3,普通人也能玩的黑科技

Meta发布SAM3系列AI模型,实现视觉理解能力质的飞跃。新一代SAM3不仅能识别物体,更能理解复杂概念,支持开放式文本提示分割目标,性能超越现有系统2倍。同时发布的SAM3D可从单张图像重建3D场景,已应用于电商预览等场景。Meta通过"人机混合"数据引擎训练模型,并推出在线Playground降低使用门槛。该技术已应用于Instagram创作工具和野生动物保护项目,将重塑

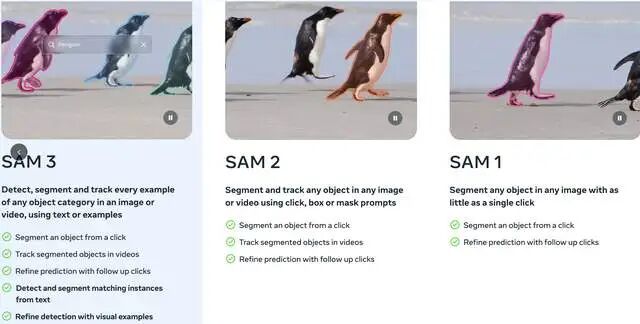

就在最近,Meta 再次展示了其在开源 AI 领域的统治力。Segment Anything Model (SAM) 系列迎来了第三代——SAM 3。如果说 SAM 1 是“抠图神器”,SAM 2 搞定了视频,那么 SAM 3 则是真正“读懂了世界”。

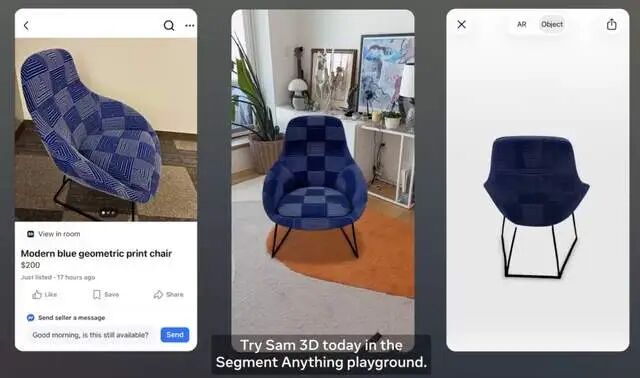

不仅如此,还有单图转 3D 的 SAM 3D 同步登场。一起来看这次更新有多炸!

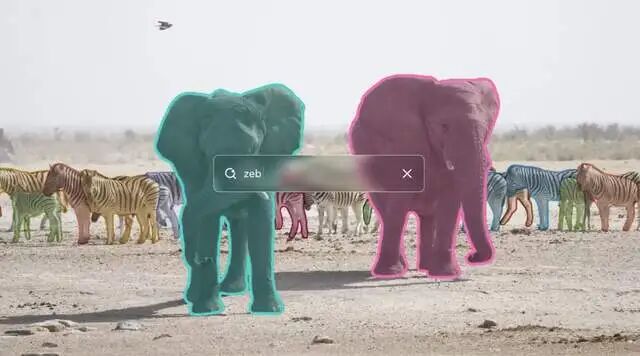

Meta 正式发布了 Segment Anything Model 3 (SAM 3)。不同于以往的模型只能识别“人”、“车”、“狗”这些死板的标签,SAM 3 竟然学会了理解“概念”。

这不仅仅是一次版本号的更新,这是 AI 视觉理解能力的一次维度的飞跃。

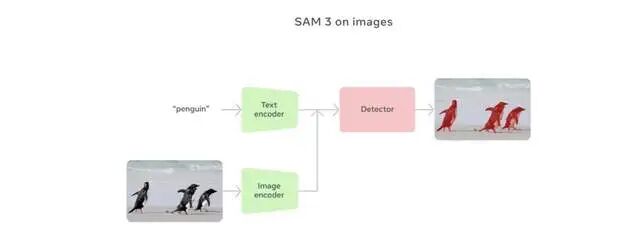

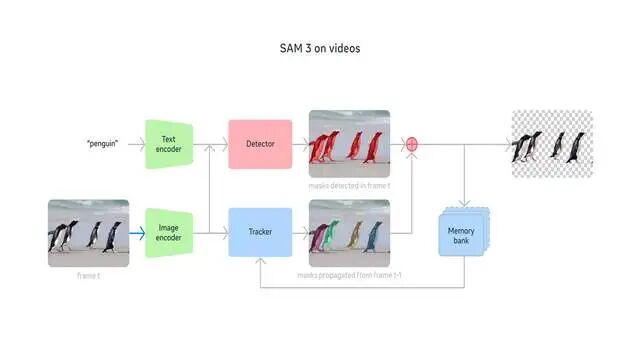

从“看到物体”到“理解概念”

以前的 AI 视觉模型,更像是一个做选择题的学生。你给它一张图,它只能从预设的标签库里选(比如:猫、狗、桌子)。

但 SAM 3 进化成了做简答题的学霸。

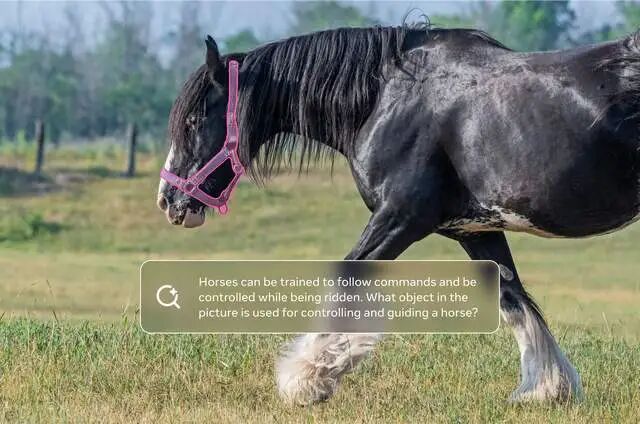

它最大的突破在于:文本提示与视觉分割的完美融合。

以前: 你让 AI 分割“伞”,它会把图里所有的伞都抠出来。

现在(SAM 3): 你可以说“红色的条纹伞”或者“人们坐着但手里没有拿礼物盒”。

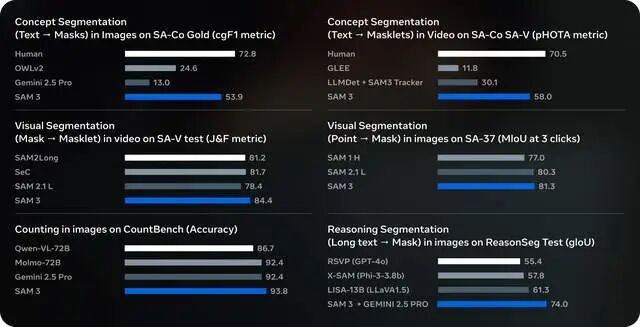

SAM 3 能听懂这些复杂的、开放式的描述(Open Vocabulary),精准定位并分割视频或图像中的目标。在官方的测试中,SAM 3 在处理这些复杂概念时,性能比现有的系统(甚至包括 Google 的 Gemini 2.5 Pro)强了整整 2 倍!

这意味着,AI 不再是机械地识别轮廓,而是真正理解了画面中的逻辑和语义。

SAM 3D:一张图,还原一个 3D 世界

除了 SAM 3,Meta 还顺手扔出了一个“副业”产品——SAM 3D。

这东西有多神?它能从单张图像重建 3D 物体和人体。

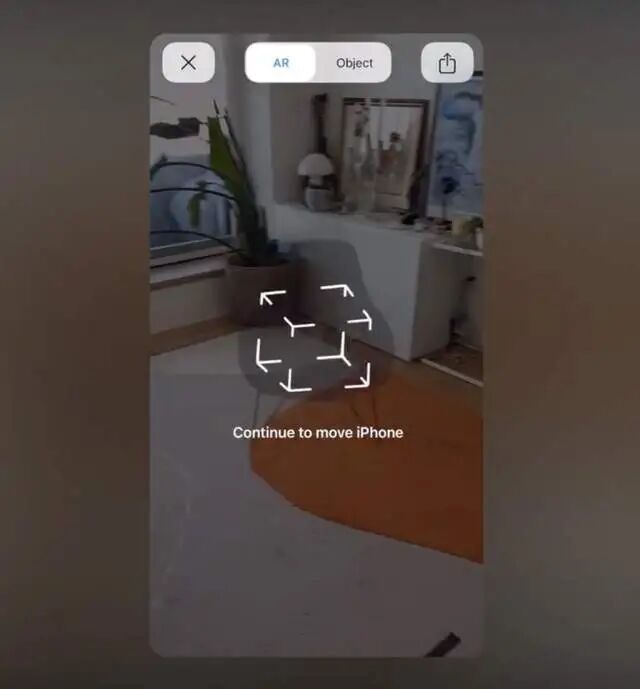

对于做游戏开发、VR/AR 内容甚至电商的朋友来说,这简直是福音。Meta 已经把它用在了 Facebook Marketplace 的“房间预览”功能里。

想象一下,你想买盏灯,拍张家里的照片,再选个网上的灯具模型,SAM 3D 就能帮你把这盏灯以正确的尺寸、光影风格“放”进你的房间里。这不是简单的贴图,而是基于物理世界的 3D 重建。

每个人都能玩的 AI:Playground 与 Instagram

技术的尽头是产品。Meta 这次没有把技术藏在实验室里,而是直接让普通用户上手。

SAM 3 的应用场景更是让我眼前一亮。它即将登陆Instagram的视频创作App“Edits”,创作者能一键给视频里的特定人物或物体加动态特效,简化了那些繁琐的编辑流程。

Meta AI的Vibes功能和网页版meta.ai也会融入SAM 3,让你用AI工具混剪视频,生成新创意。甚至在Facebook Marketplace上,SAM 3 和它的3D兄弟SAM 3D 能帮用户预览家居装饰在自家空间的效果——买灯具前,先“试摆”一下,避免买回家后悔!

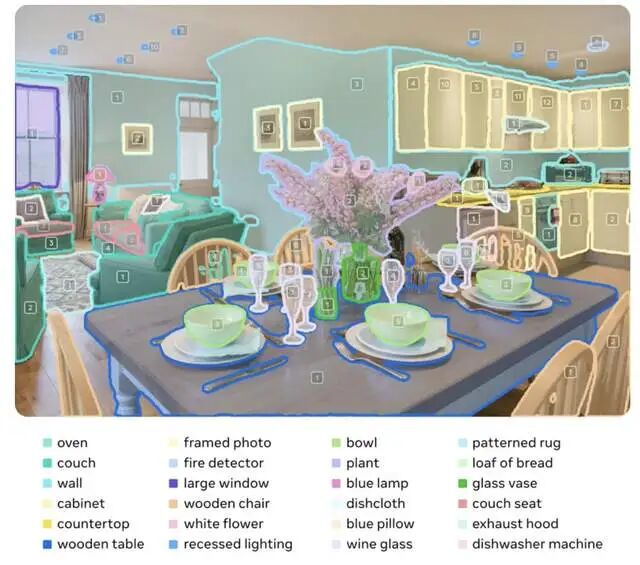

Segment Anything Playground:Meta 推出了一个全新的网页平台,任何人(对,就是屏幕前的你)都可以去上面试玩 SAM 的功能,体验一把“指哪抠哪”或者“说啥抠啥”的快感。

SAM 3D 本身就是一套开源的3D重建模型,能从单张图像重建物体或人体姿态,设定新标准。我的观点是,这不只提升了电商体验,还为AR/VR内容创作打开了大门。

它是怎么变强的?“AI 训练 AI”

读完技术报告,我发现 SAM 3 变强的秘诀在于数据引擎。

为了教 AI 认出“红色条纹伞”这种细微差别,Meta 构建了一个疯狂的循环:

SAM 3 + 人类标注员 + Llama 模型。

简单来说,就是先让 AI 自己干活(生成掩码和标签),然后让人类去修,接着再让更强的 Llama 模型去检查。这种“人机混合双打”的模式,让标注速度比纯人工快了 36% 到 5 倍!最终搞出了一个包含 400 万+ 独特概念的训练集。

不止是好玩,还能保护地球

最后,让我感动的一点是 SAM 3 的科学应用。

Meta 与 Conservation X Labs 合作,发布了 SA-FARI 数据集。这包含了 1000 多万个野生动物视频,利用 SAM 3 来自动监测和分割视频里的珍稀动物。

从陆地的豹子到深海的生物(FathomNet 项目),SAM 3 正在成为科学家们的“数码望远镜”。

2倍性能提升背后,是创作者的生产力解放

数据不会说谎:在SA-Co基准测试中,SAM 3的cgF1分数比现有模型直接翻倍。但对于我们创作者来说,比数字更重要的是:30毫秒处理100+个目标,视频处理接近实时。

这意味着什么?

打个比方:过去给一段5分钟的Vlog做人物追踪特效,你可能要手动逐帧调整蒙版,泡三杯咖啡都搞不定。现在?点一下,等个眨眼功夫,AI已经把视频里每个出现的人都标记好了,还能持续跟踪。Meta即将在Instagram的Edits应用里上线这个功能——复杂的动态特效,变成了一键美颜般的存在。

我在测试时看到的效果堪称恐怖:给视频里的特定人物加发光特效,AI不仅识别出了主角,连背景里一闪而过的路人都能准确判断"这不是你要的那个"。这背后是多模态大语言模型与视觉感知的深度融合,简单说,AI开始有了"上下文理解能力"。

Meta 在开源这条路上,确实走得既坚定又聪明

OpenAI 选择了闭源,打造最强的“大脑”;而 Meta 选择开源,试图通过 SAM 系列占领“眼睛”的市场。SAM 3 的发布,实际上是在确立一种标准:未来的视觉 AI,必须是多模态、可交互、且深度理解语义的。

虽然官方也坦诚,SAM 3 在面对极其生僻的专业术语(比如特定的医学细胞名称)时还有待提升,但它开放了微调代码。这意味着,各行各业的开发者可以把它改造成自己的专用工具。

视觉 AI 的“ChatGPT 时刻”,或许就在 SAM 3 普及的这一刻到来了。

Meta这次最让我欣赏的,不是模型本身,而是Segment Anything Playground的推出。

技术圈有个怪现象:越先进的模型,门槛越高。但Meta反其道而行,搞了个"游乐场"——让普通人不用懂代码,不用配环境,打开网页就能玩。这步棋走得极妙:把AI从实验室的玩具,变成了大众的生产工具。

我试了试Playground,上传一张乱糟糟的客厅照片,输入"现代主义台灯",AI立刻在画面里标出了所有符合描述的灯具,还能一键生成3D预览。更绝的是,配合Facebook Marketplace的"房间预览"功能,我直接把一张餐桌"拖"进我的客厅,尺寸、风格、光影,几乎以假乱真。

SAM 3给我的最大感触是:它不再是炫技,而是真正在塑造下一代创意工作流。

从Edits到Vibes,从Marketplace到meta.ai,Meta把SAM 3塞进了自家所有产品矩阵。这步棋很明确——用AI原生体验重新定义内容创作。当抠图、追踪、3D重建都变成"一句话的事",创作者就能从技术的泥泞里抽身,专注到真正的创意表达上。

这像极15年前iPhone刚推出时,有人嘲笑"没有实体键盘怎么用"。但历史证明,降低门槛的工具,最终都会引爆一场创作革命。

现在问题来了:当AI能听懂你的"脑洞",甚至帮你在视频里"魔法"般地添加特效,你最想用它来做什么?是复活老电影里的经典场景,还是给自己的Vlog加点科幻大片的感觉?

更多transformer,VIT,swin tranformer

参考头条号:人工智能研究所

v号:人工智能研究Suo, 启示AI科技动画详解transformer 在线视频教程

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)