从多模态大模型到通用具身智能体:苹果团队的最新研究

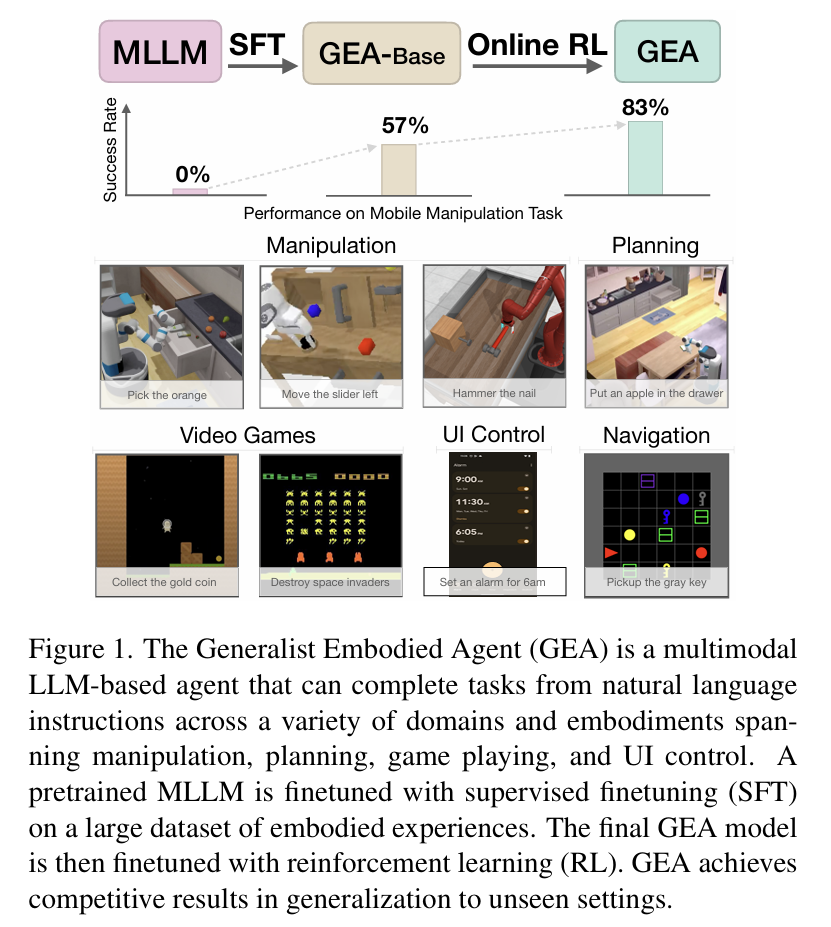

摘要:本文介绍了一种名为"通用具身智能体"(GEA)的新型AI框架,由苹果公司和佐治亚理工学院联合开发。该研究通过将多模态大语言模型(MLLM)与特定训练方法相结合,打造了一个能够同时处理机器人操作、电子游戏控制和手机界面交互等多种任务的通用智能体。GEA采用两阶段训练法:先通过监督式微调学习220万条任务轨迹,再进行在线强化学习优化性能。实验表明,GEA在未见过的任务中仍保持

论文:Szot A, Mazoure B, Attia O, et al. From multimodal llms to generalist embodied agents: Methods and lessons[C]//Proceedings of the Computer Vision and Pattern Recognition Conference. 2025: 10644-10655.

链接:https://openaccess.thecvf.com/content/CVPR2025/papers/Szot_From_Multimodal_LLMs_to_Generalist_Embodied_Agents_Methods_and_Lessons_CVPR_2025_paper.pdf

今天要和大家分享一篇刚刚在顶级计算机视觉会议CVPR 2025上发表的重磅研究。这篇由苹果公司(Apple)和佐治亚理工学院(Georgia Tech) 联合完成的论文,提出了一种名为 “通用具身智能体”(Generalist Embodied Agent, GEA) 的全新框架,旨在打造一个能够“一专多能”的AI大脑,让同一个模型可以轻松驾驭机器人操作、玩转电子游戏、甚至控制我们的智能手机界面。

听起来是不是有点像科幻电影里的场景?但这项研究正让它离现实越来越近。

一、我们想要什么样的AI?——从“专才”到“通才”的进化

过去几年,以GPT、LLaVA为代表的多模态大语言模型(MLLM) 在理解和生成文本、图像方面取得了巨大成功。它们不仅能聊天、写诗、画画,还能回答复杂的视觉问题。

然而,这些模型大多停留在“看”和“说”的层面。真正的智能,应该能“做”——也就是具身智能(Embodied AI),即智能体通过感知环境、理解指令并执行动作来与物理世界或虚拟世界进行交互。

目前,大多数AI系统都是“专才”。比如:

-

有一个专门玩《超级马里奥》的AI。

-

有一个专门在工厂里抓取零件的机器人。

-

还有一个专门帮你刷短视频的手机自动化工具。

这些系统各自为政,训练成本高昂,且难以迁移到新任务。我们真正需要的,是一个“通才”*——一个模型,一条指令,就能搞定所有任务。

这就是GEA的核心目标。

二、GEA是什么?一个能“动手”的多模态大脑

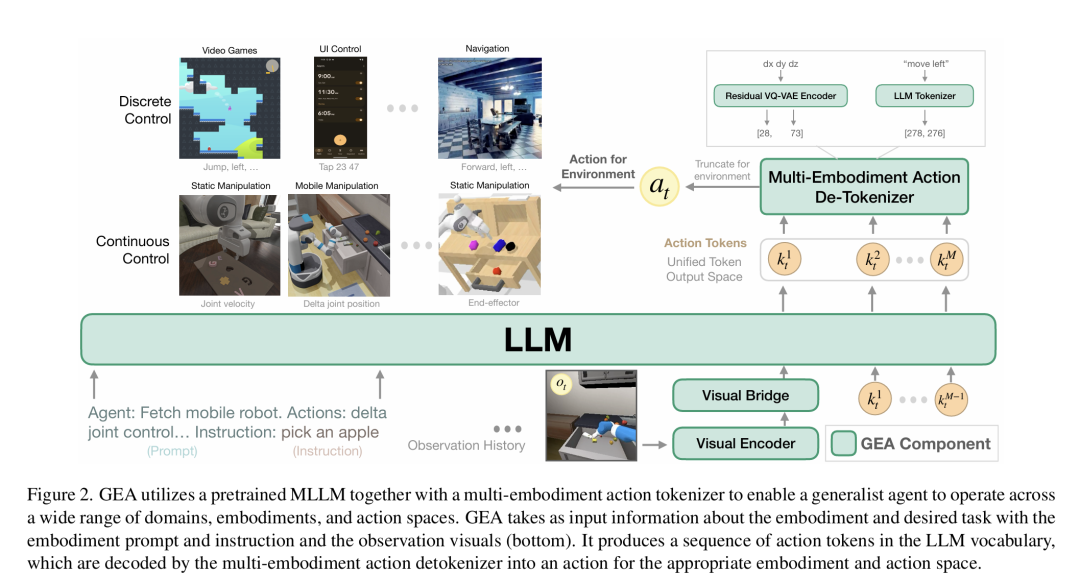

简单来说,GEA就是将强大的多模态大语言模型(MLLM),通过特定的训练方法,改造成了一个能“动手”的全能型智能体。

它的核心思想是:

- 基础是强大的MLLM

:研究人员选择了 LLaVA-OneVision 作为基础模型,因为它天生擅长处理图文交织的长序列信息,非常适合处理智能体在环境中连续看到的画面和听到的指令。

- 统一的动作编码器

:不同任务的动作千差万别。机器人可能需要控制关节速度(连续动作),而玩游戏可能只需要按“上、下、左、右”(离散动作)。GEA创新性地设计了一个多形态动作分词器(Multi-Embodiment Action Tokenizer),它能将各种各样的动作都“翻译”成模型词汇表中的特殊“token”(标记)。这样,无论控制的是机器人手臂还是游戏角色,对模型来说都是在预测一串“文字”。

- 两阶段训练法:先模仿,再实战

- 第一阶段:监督式微调(SFT)

- “老师教” 模型首先在一个包含超过220万条来自机器人操作、视频游戏、UI控制等领域的成功任务轨迹的庞大数据集上进行学习。它就像一个学生,通过观看大量专家的操作录像(画面+动作),学会基本的技能。

- 第二阶段:在线强化学习(Online RL)

- “自己练” 仅仅模仿是不够的。现实中总会犯错,需要学会“纠错”和“探索”。因此,GEA进入第二个阶段,在模拟环境中进行在线强化学习。模型开始自己动手尝试,根据任务的反馈(奖励或惩罚)不断调整策略,从而变得更鲁棒、更智能。

- 第一阶段:监督式微调(SFT)

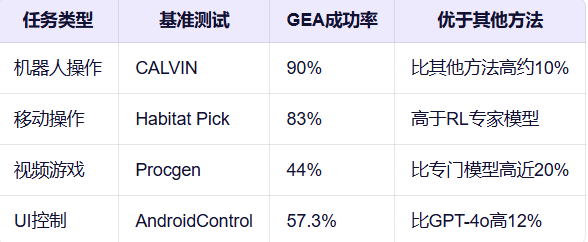

实验结果:通用智能体的卓越表现

特别值得注意的是,GEA在未见过的指令和背景下仍能保持高性能,这证明了其强大的泛化能力。例如,在CALVIN操作任务中,GEA在未见过的指令和背景环境下达到90%的成功率,而其他方法仅约80%。

为什么GEA如此强大?

论文深入分析了GEA成功的关键因素:

-

跨领域数据的重要性:使用来自多个领域的数据进行训练,比仅使用单一领域数据效果更好。GEA在多领域数据上训练,性能显著优于仅在特定领域训练的模型。

-

在线强化学习的必要性:GEA在SFT基础上加入在线RL训练,性能大幅提升。在Habitat Pick任务中,GEA的性能从57%提升到83%,这表明在线交互学习对模型鲁棒性至关重要。

-

预训练MLLM的基础价值:使用预训练的MLLM作为基础模型,比从头训练效果更好。论文展示了模型规模越大,性能越强,但不同模型类型的影响相对较小。

五、未来展望:迈向真正的通用决策模型

GEA的成功为我们描绘了一幅激动人心的蓝图:未来的AI助手可能不再需要为每个应用单独开发,而是拥有一个统一的、强大的“大脑”(GEA),能够无缝地在家庭机器人、自动驾驶、游戏NPC、个人数字助理等多个角色间自由切换。

当然,挑战依然存在。论文作者也坦诚,GEA在某些复杂任务(如Maniskill)上的表现还不够完美,扩展强化学习到更多领域将是下一步的关键。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)