Parasoft洞察: 2026年五大AI测试抢先看

2026年AI测试五大趋势:1)自主测试崛起,AI成为"数字协作测试伙伴";2)AI生成代码测试成为重点,需验证业务适配性;3)AI融合应用测试转向"置信度评估";4)关键系统AI应用需可验证和可审计;5)AI驱动智能故障诊断与自我修复。测试人员角色将转变为"战略质量架构师",需要建立人机协同机制,确保测试可追溯和合规。提前布局AI测试的

哈喽,各位测试人~ 过去几年,软件测试领域的变革速度远超以往十年:从最初的回归套件自动化,到如今AI自主编写、分析测试用例,甚至决定执行哪些测试——测试行业早已不是从前的模样。

展望2026年,这场由AI驱动的变革势头不仅没有放缓,反而将全面提速。AI不再是测试人员工具箱里的“备选工具”,而是正在重塑测试的方式,甚至是“执行者”的身份。

这些变革听起来或许有些科幻,但事实上它们已在悄然发生。能提前布局的团队,必将在未来的质量竞争中占据绝对优势。今天就为大家拆解2026年最值得关注的五大AI测试趋势。

PART1:自主测试全面崛起,AI智能加入QA团队

如今,自主软件智能已不再是实验室里的研究项目。到2026年,这些以目标为导向的AI将深度参与测试全生命周期管理:搭建测试环境、协调测试套件、分析测试结果,甚至自动记录缺陷。

你可以把它理解为“数字协作测试伙伴”——它们绝非为了取代人类测试员,而是接手那些重复繁琐的工作,让你能专注于需要洞察力的复杂问题:比如探索性测试、异常场景分析等更有价值的任务。

备战指南:

- 从小处着手,先行试点:选择业务优先级较低的小型项目,尝试AI测试生成和自主工作流,积累实践经验。

- 保留人类决策环节:治理机制和可观测性是建立信任的关键,避免AI带来的风险。

- 记录并监控AI智能体的决策过程(比如测试结果判断),确保整个流程可追溯。

2026年,越来越多团队将采用智能体辅助测试模式。从而测试人员将有更多时间投入到创造性的高质量测试工作中。

PART2:AI生成代码的测试:为“AI开发者”做质量把关

AI编码助手早已成为行业常态——它们速度快、实用性强。

AI能在几秒内生成代码,但有时他们编写的代码 “表面看似无误”,却没有表达出真正的意图。行业最新研究:超过70%的开发者表示,他们经常需要重写或重构AI生成的代码,才能使其投入生产环境。

简单来说:AI确实能提升开发效率,但速度不等于正确性或场景适配性。这正是QA团队的核心价值所在——随着AI生成代码成为主流,测试人员需要验证的不仅是代码“能运行”,更要确保它“符合业务实际需求”。

备战指南:

- 对AI生成代码执行静态分析和安全扫描,从源头规避基础风险。

- 补充单元测试和功能测试,验证代码逻辑与真实业务规则的一致性。

- 记录生成代码所用的AI模型和提示词,确保全流程可追溯。

- 将AI生成代码视为“起点”而非“成品”,保留人工审核和优化环节。

PART3:AI融合应用测试:从“非过即败”到“置信度评估”

如今的主流应用早已不是单纯的传统代码,而是软件、机器学习和生成式AI的混合体。测试这类系统,不仅要评估其产出结果,更要关注它在整个生态中的行为表现。

简单的“通过/失败”已无法覆盖AI输出的复杂性:

比如聊天机器人对同一问题可能给出多个有效答案;视觉模型某天对某张图片的分类置信度是90%,另一天可能因系统特性变化降至82%。团队需要评估的,是置信度水平、输出一致性以及长期趋势变化。

模型评估框架能帮助我们结构化追踪AI输出的准确性、置信度、稳健性和公平性。但在现代AI融合系统中,模型并非孤立运行——它们常与外部数据、工具或其他AI系统联动。

模型上下文协议(MCP)、智能体间通信协议(A2A)等新兴标准正让这些联动更规范化,这也意味着测试人员需要额外验证AI组件在跨服务交互中的表现。

备战指南:

- 使用AI增强型测试工具:这类工具能生成自然语言断言,有效验证模糊或概率性的AI输出。

- 搭建提示词回归测试套件,持续监控AI响应的一致性。

- 借助模型评估框架,追踪置信度、正确性和公平性的变化趋势。

- 确保自动化平台能模拟并验证AI模型与关联服务的交互——尤其是基于A2A或MCP的集成场景。

PART4:关键系统的AI应用必须经过验证,而非仅可编程

如今的AI早已不局限于聊天机器人和网页应用,它已渗透到高风险领域:

- 需瞬间做出驾驶决策的智能汽车;

- 监测生命体征的医疗设备;

- 实时调整生产的工厂系统。

在这些场景中,仅问“它能用吗?”远远不够。我们必须能证明它“安全、可靠、无漏洞”——这就是合规驱动型AI测试的核心价值。

随着AI进入安全关键型、受监管的领域,测试已升级为“全链路可追溯+可审计证据”模式。它不再局限于功能验证,更要清晰展示系统的“行为逻辑”和“决策依据”。

备战指南:

- 将每一次测试结果与特定的模型版本和数据集关联,实现全链路追溯。

- 将合规报告与测试工件一同存储,方便随时调取审计。

- 尽早让安全和网络安全团队参与——而非事后补救。

- 使用可解释AI(XAI)工具(如LIME、SHAP),让模型行为透明化。

- 将传统验证方法(如静态分析、覆盖率测试)与AI感知验证技术相结合。

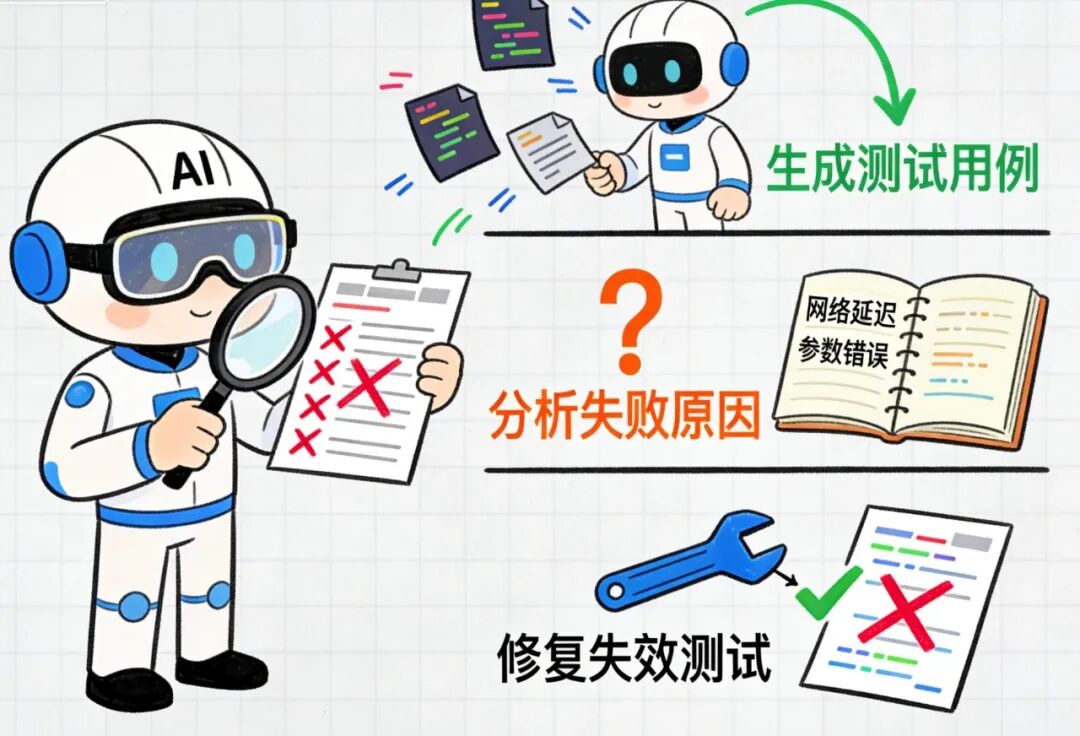

PART5:AI驱动的故障诊断:更智能的根本原因分析与自我修复

除了生成测试用例,AI还能分析测试失败原因、提出解决方案,甚至修复失效的测试。

AI驱动的根本原因分析(RCA)能筛选日志、堆栈跟踪和历史缺陷数据,精准定位故障的可能原因;它还能聚类相关问题、识别不稳定测试、优先排序需要修复的问题,甚至在你开始调试前就给出解决方案。

而这仅仅是开始——自我修复测试正日益普及:当应用出现微小变化时,AI能自动更新测试脚本或数据,减少维护时间;部分AI工具甚至能自主修复静态分析违规问题,提出代码修改建议,甚至在保留人工决策环节、生成每一步操作审计记录的前提下,安全自动应用更新。

备战指南:

- 从“人机协同”工作流起步:由AI提出修复建议,人工负责审核确认。

- 基于真实结果,跟踪AI驱动的问题优先级排序效果;必要时根据实际情况重新训练模型。

- 确保所用工具能生成详细日志,记录AI的所有操作,满足审计需求。

到2026年,智能诊断、自我修复测试和自主修复将成为“更快、更稳定发布”的核心驱动力,让测试人员能专注于扩大测试覆盖范围、优化测试策略和高价值的探索性测试工作。

做好准备,迎接AI测试时代

AI不仅在改变我们的开发对象,更在重塑我们的验证方式和信任逻辑。测试人员正从“执行者”转变为“战略质量架构师”——负责保障AI生成输出的准确性,确保自动化、合规性和人工判断协同工作,交付安全、可靠的系统。

如果你的团队正准备探索AI与自动化如何重塑测试策略——从智能测试生成到自主代码扫描,Parasoft 能助你信心十足地实现现代化转型。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)