AiPing × Claude Code:MaaS 平台上的 AI 创作新范式

作为一名热衷用 AI 提升开发效率的程序员,最近我用搞了个小项目:一个能自动生成奇幻/悬疑/日常故事的 AI 创作工具。在实际开发的过程中我彻底被AI Ping 平台圈粉 —— 它不生产模型,却让我轻松“挑到最好用、跑得最快、价格最香”的大模型 API;同时还通过统一接口和智能路由,省去了我在不同平台反复切换、调试的麻烦。而则帮我自动生成前后端代码,几分钟就搭好了原型。本文将从实战出发,手把手带你

人们眼中的天才之所以卓越非凡,并非天资超人一等而是付出了持续不断的努力。1万小时的锤炼是任何人从平凡变成超凡的必要条件。———— 马尔科姆·格拉德威尔

🌟 Hello,我是Xxtaoaooo!

🌈 “代码是逻辑的诗篇,架构是思想的交响”

摘要

作为一名热衷用 AI 提升开发效率的程序员,最近我用 AI Ping + Claude Code 搞了个小项目:一个能自动生成奇幻/悬疑/日常故事的 AI 创作工具。在实际开发的过程中我彻底被 AI Ping 平台 圈粉 —— 它不生产模型,却让我轻松“挑到最好用、跑得最快、价格最香”的大模型 API;同时还通过统一接口和智能路由,省去了我在不同平台反复切换、调试的麻烦。而 Claude Code 则帮我自动生成前后端代码,几分钟就搭好了原型。本文将从实战出发,手把手带你用 AI Ping 选模型、调接口,配合 Claude Code 快速构建自己的项目,实现从“创意构想到可运行应用”的极速落地。

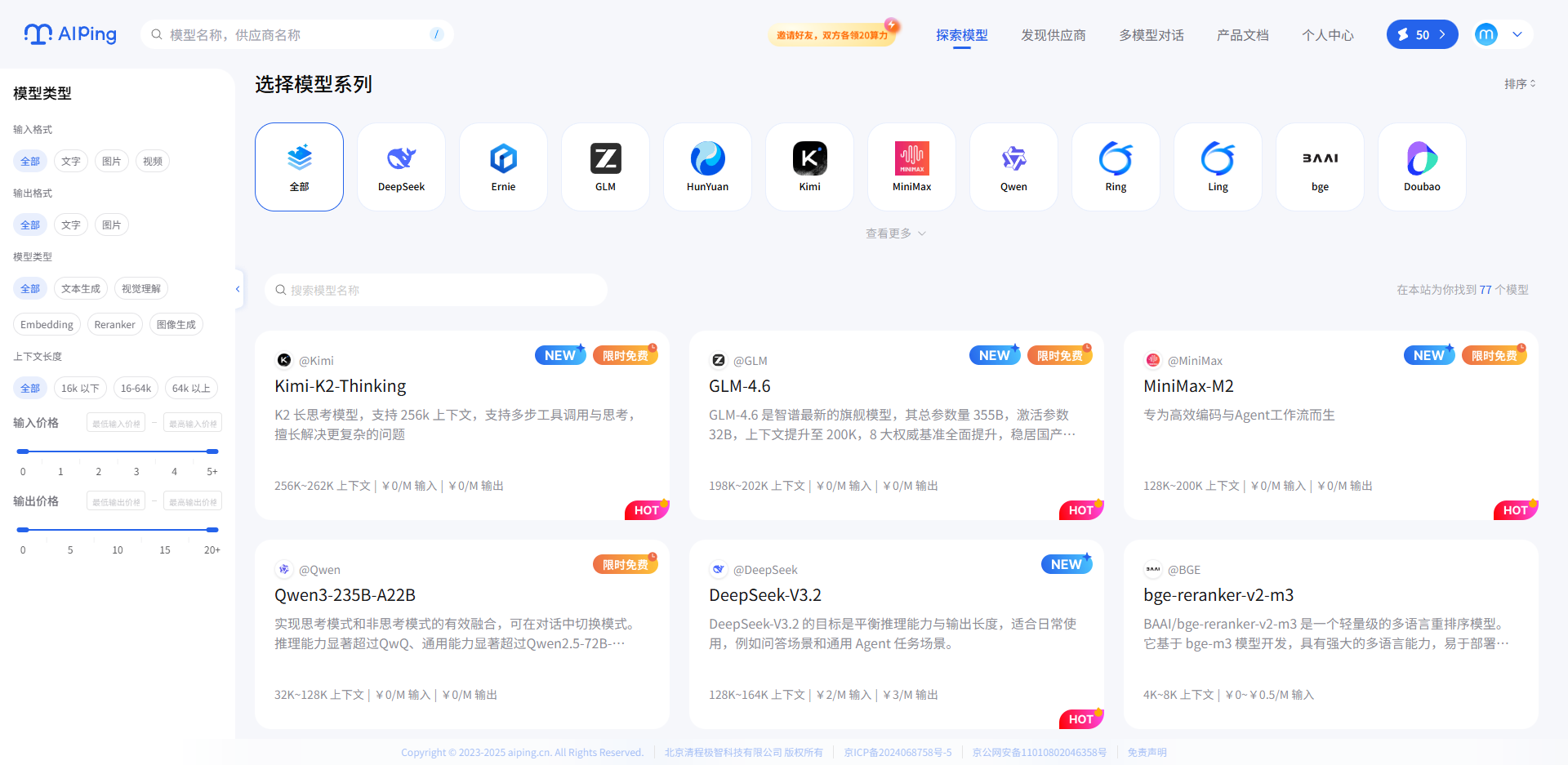

AI Ping 平台目前可免费使用MiniMax-M2、GLM-4.6、Kimi-K2-Thinking、Qwen3等模型。可以通过此专属链接注册登录,送30的算力:https://aiping.cn/#?channel_partner_code=GQCOZLGJ

一、AI Ping 核心定位

在当前大模型生态高度碎片化的背景下,开发者在调用 AI 能力时常常面临三大难题:模型选型难、接口不统一、接入成本高。为系统性解决这些问题,AI Ping 应运而生——它是一个集大模型服务平台评测与一站式调用功能于一体的专业服务平台,被开发者亲切地称为“大模型 API 服务的大众点评”。

AI Ping 的设计初衷,源于对开发者真实工作流的深度洞察,该平台重点围绕两大核心需求构建能力体系。

1.1 大模型性能评测

AI Ping 团队通过 7×24 小时持续、高频、标准化的自动化评测机制,对来自数十家主流大模型 API 服务商的数百个模型服务进行全方位评估。评测维度覆盖响应延迟、吞吐量、服务可靠性、上下文支持长度、输出质量稳定性等关键指标,并按不同云厂商、时间段动态呈现数据表现。基于此,平台定期发布权威的模型服务性能排行榜,帮助开发者摆脱“盲选”困境,做出数据驱动的决策。

1.2 模型调用基础设施

针对“每换一个模型就要重写一套对接代码”的痛点,AI Ping 提供统一 API 接口,开发者只需一次集成,即可无缝访问平台上所有已接入的模型服务,彻底告别多平台切换与重复开发。更进一步,平台还推出API 智能路由功能:开发者调用大模型服务时,希望“省时省力地获得兼顾速度与成本的选择”,该功能可根据用户的意向模型,帮助用户在众多大模型API服务平中智能选择最优供应商:用户只需明确自身业务需求(如响应速度优先级、成本控制目标等),平台便会开启智能调度模式——基于实时监控的多维度数据(包括各供应商的服务价格、P90 延迟、吞吐能力等),结合负载均衡与成本优化算法,为每一次请求动态匹配当前最优供应商。其中,业务高峰期优先选择吞吐能力强、延迟低的供应商,保障服务流畅不卡顿;非高峰时段自动切换至性价比更高的选项,帮助开发者节省成本与时间。

除此之外,AI Ping 还提供详尽的模型详情页,系统化展示每个模型的核心参数,包括最大上下文长度、输出限制、定价策略、支持的语言等,支持横向对比与深度查询,极大提升了模型选型与技术评估的效率。

二、Claude code 集成

AiPing 目前支持 Claude Code、cline、codex、cursor、trae、roo code、Kilo code 等主流 coding 工具;甚至沉浸式翻译、Cherry Studio 办公助手等场景工具,可直接使用 AIPing 基础功能。

这里我是通过集成Claude Code 来开发Ai创作助手。

2.1 Claude Code 安装

// 安装Claude Code之前需要安装Node.js 版本>18 和 安装Git

npm install -g @anthropic-ai/claude-code

// 使用

cd your-awesome-project

claude2.2 Claude Code 中使用 AI Ping

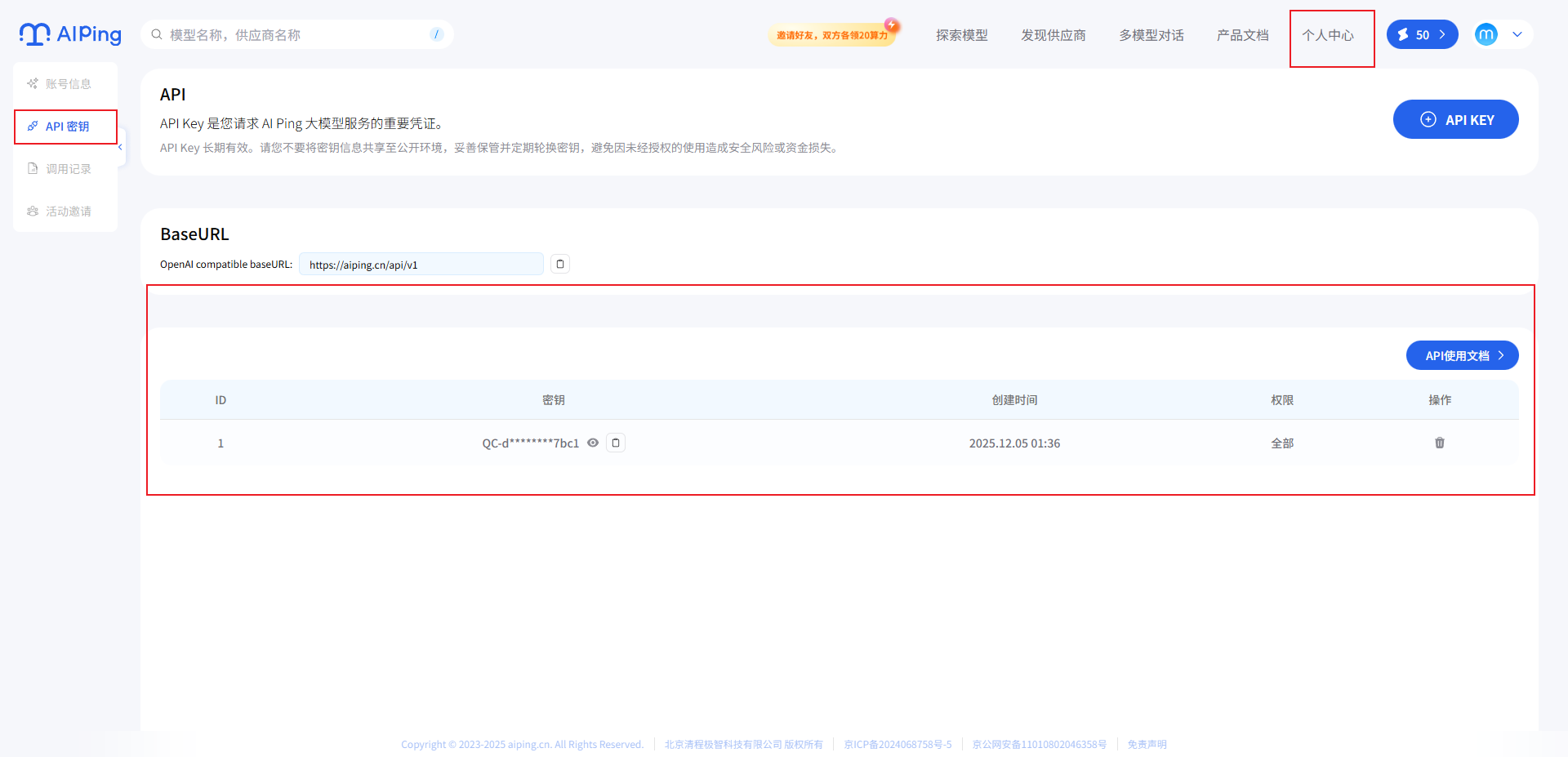

在集成AI Ping之前,需要先注册登录一下:

创建个人API密钥

最后配置Claude Code

- 编辑或创建 Claude Code 的配置文件,路径为 ~/.claude/settings.json,在该文件中添加或更新 env 字段,其中,需要将 YOUR_API_KEY 替换为从 AI Ping 平台获取的 API Key

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "Kimi-K2-Thinking",

"ANTHROPIC_SMALL_FAST_MODEL": "Kimi-K2-Thinking",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "Kimi-K2-Thinking",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "Kimi-K2-Thinking",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "Kimi-K2-Thinking"

}

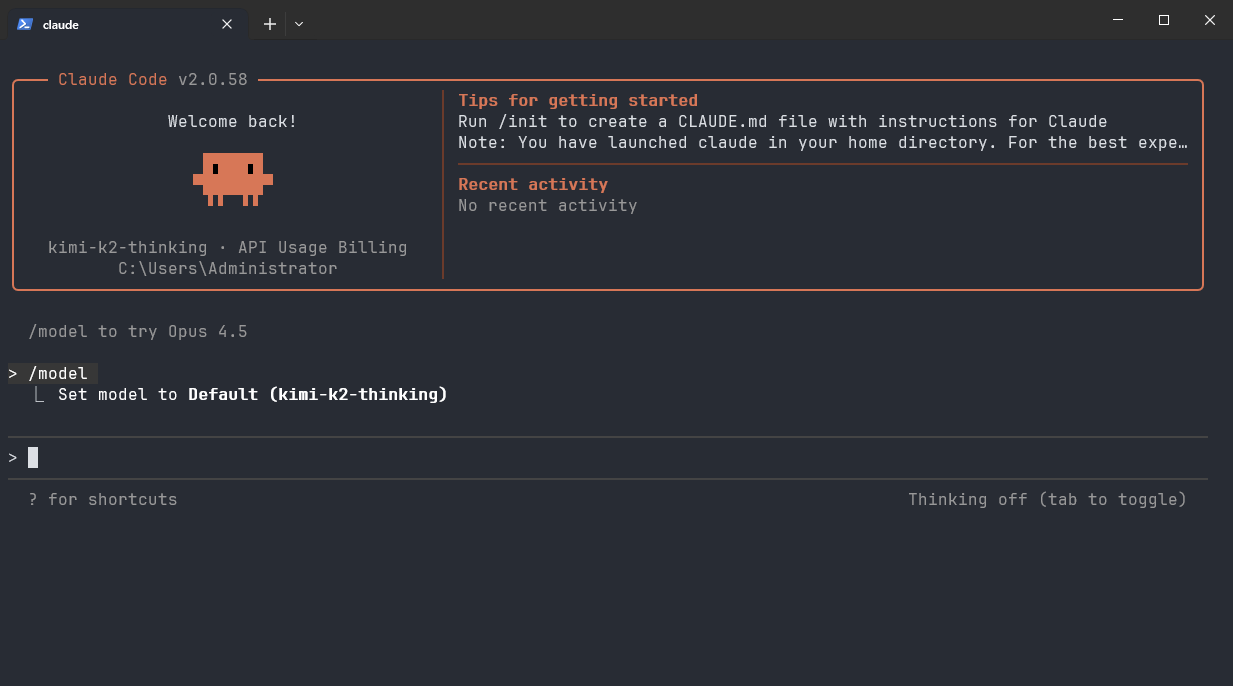

}- 配置完成后,进入工作目录,在终端中运行 claude 命令以启动 Claude Code

- 启动后,选择 “信任此文件夹 (Trust This Folder)”,以允许 Claude Code 访问该文件夹中的文件,随后开始在 Claude Code 中使用 Kimi-K2-Thinking。

三、AI创作小能手应用开发

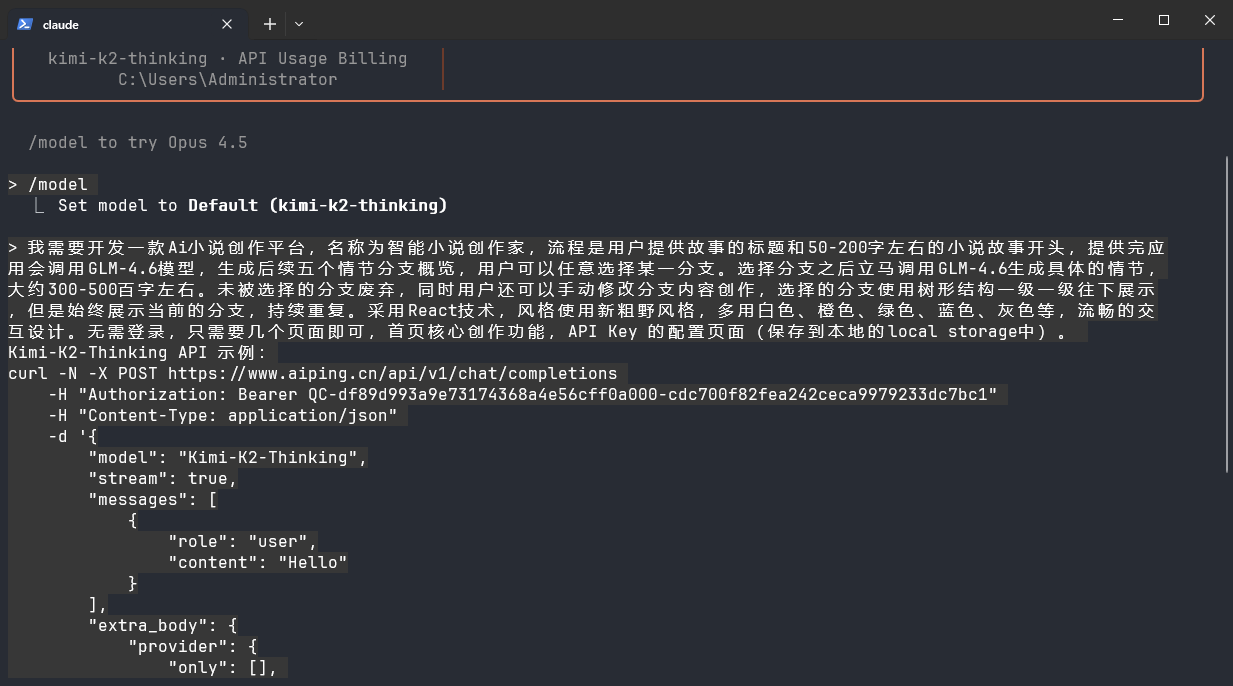

3.1 vibe coding

直接把提示词喂给Claude code进行开发

我需要开发一款Ai小说创作平台,名称为智能小说创作家,流程是用户提供故事的标题和50-200字左右的小说故事开头,提供完应用会调用GLM-4.6模型,生成后续五个情节分支概览,用户可以任意选择某一分支。选择分支之后立马调用GLM-4.6生成具体的情节,大约300-500百字左右。未被选择的分支废弃,同时用户还可以手动修改分支内容创作,选择的分支使用树形结构一级一级往下展示,但是始终展示当前的分支,持续重复。采用React技术,风格使用新粗野风格,多用白色、橙色、绿色、蓝色、灰色等,流畅的交互设计。无需登录,只需要几个页面即可,首页核心创作功能,API Key 的配置页面(保存到本地的local storage中)。

Kimi-K2-Thinking API 示例:

curl -N -X POST https://www.aiping.cn/api/v1/chat/completions

-H "Authorization: Bearer QC-df89d993a9e73174368a4e56cff0a000-cdc700f82fea242ceca9979233dc7bc1"

-H "Content-Type: application/json"

-d '{

"model": "Kimi-K2-Thinking",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"provider": {

"only": [],

"order": [],

"sort": null,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

}

}'

3.2 应用效果展示

AiPing + Claude Code 组合使用,让我的开发重心完全聚焦在产品逻辑与交互设计上,而非繁琐的 API 适配与调试,实现了从“创意构想到可运行应用”的极速落地。

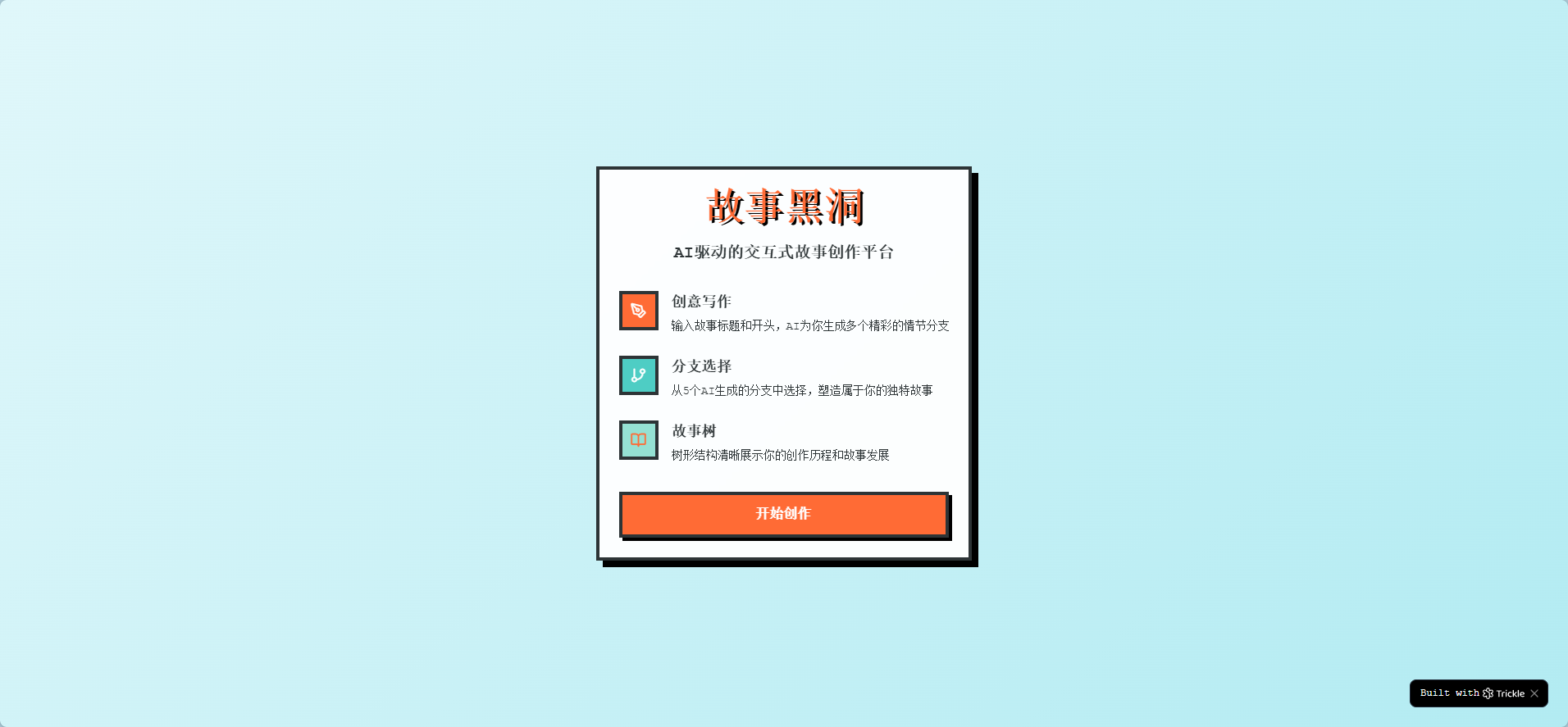

3.2.1 欢迎页

首页(用户未配置模型):

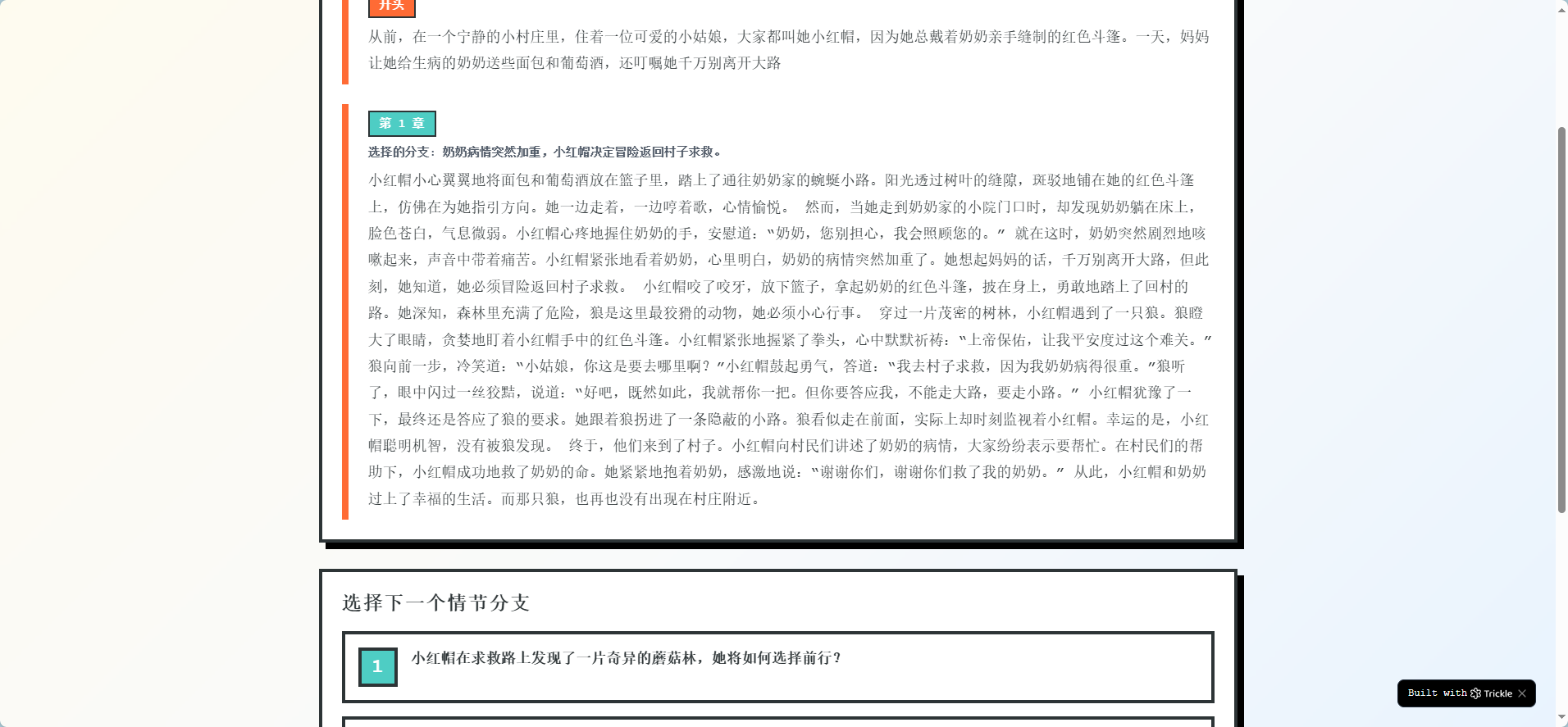

3.2.2 故事创建

故事创作页(核心,树形结构清晰展示整个故事的发展路径与分支概览):

3.2.3 创作时光

创作时光(历史查看及故事回溯界面):

四、总结

通过集成 AI Ping,整个开发过程实现了“选模型如点菜、调接口如呼吸”般的流畅体验。以往在多个大模型平台之间反复比价、测试延迟、调试不兼容的 API 格式,往往要耗费数小时甚至数天;而如今,只需一次配置,就能在 GLM-4.6、Kimi-K2-Thinking 等顶尖模型间自由切换,甚至根据实时性能数据自动路由到最优服务节点。更便捷的是,AI Ping 提供的统一接口和详尽的模型参数对比,让我在原型阶段就能快速验证不同模型对“情节生成质量”和“响应速度”的影响——最终选定 Kimi-K2-Thinking 作为主模型,这正是基于 AI Ping 上清晰的吞吐量与上下文长度评测数据。可以说,没有 AI Ping 的底层支撑,这个“从想法到可交互 Demo 仅用半天”的奇迹几乎不可能实现。

参考资料

- AI Ping 官方平台:https://www.aiping.cn

- AI Ping 开发者文档:https://www.aiping.cn/docs/product

- kimi-k2-thinking 大模型介绍:https://moonshotai.github.io/Kimi-K2/thinking.html

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)