『AI大模型』Ollama、DeepSeek 和 Cherry Studio 本地知识库搭建实战指南

本文深入探讨如何利用 Ollama、DeepSeek 和 Cherry Studio 搭建本地知识库,从技术原理到实践步骤,再到优化策略,全方位呈现知识库构建的精髓,助你在本地数据管理与检索领域实现技术突破,打造高效、智能的企业级知识管理解决方案。Ollama 是一个开源的本地大语言模型运行框架,支持在本地机器上便捷部署和运行多种大模型。它提供简洁的命令行界面,支持 Windows、macOS 和

📣读完这篇文章里你能收获到

- 🌟 掌握 Ollama 在知识库中的核心作用及配置技巧

- 🚀 掌握 DeepSeek 的各个模型部署方式

- 💡 学会利用 Cherry Studio 进行知识库的可视化管理与扩展

前言

本文深入探讨如何利用 Ollama、DeepSeek 和 Cherry Studio 搭建本地知识库,从技术原理到实践步骤,再到优化策略,全方位呈现知识库构建的精髓,助你在本地数据管理与检索领域实现技术突破,打造高效、智能的企业级知识管理解决方案。

一、技术栈简介

1. Ollama

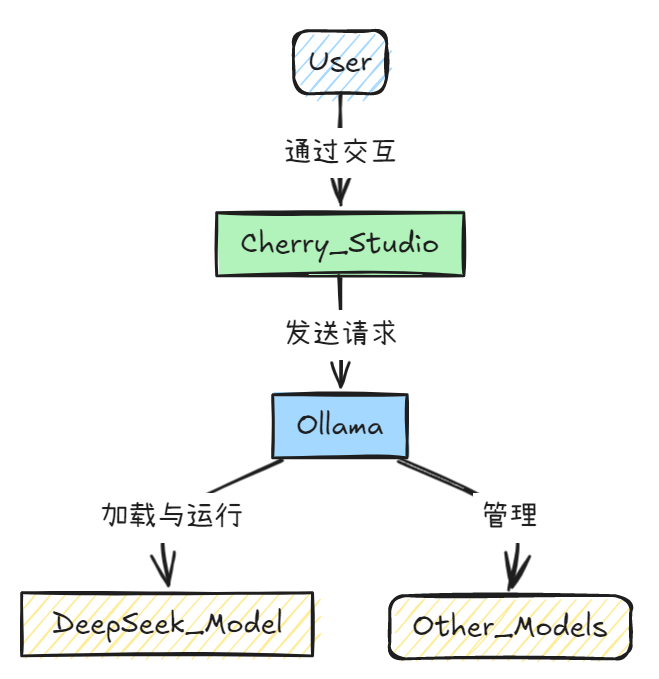

Ollama 是一个开源的本地大语言模型运行框架,支持在本地机器上便捷部署和运行多种大模型。它提供简洁的命令行界面,支持 Windows、macOS 和 Linux 系统。同时,Ollama 允许用户通过环境变量配置模型的运行参数,如内存保持时间和并发请求数量。

2. DeekSeep

DeekSeep 是一种高性能的大语言模型,支持多种应用场景,如文本生成、代码辅助和知识问答。其模型版本丰富,包括收费的高精度版本(如 DeekSeep - R1、DeekSeep - V3)和免费的蒸馏版本(如 DeekSeep - R1 - Distill - Llama - 8B)。

3. Cherry Studio

Cherry Studio 是一款跨平台的多模型 AI 客户端,支持 Windows、macOS 和 Linux 系统。它集成了超过 300 个大语言模型,支持本地模型运行(通过 Ollama 集成),并提供丰富的功能,如多模态对话、知识库构建和智能助手定制。

二、本地化部署大模型

1. 安装 Ollama

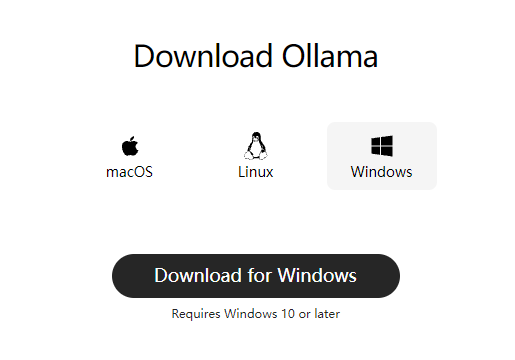

1.1 下载 Ollama

访问 Ollama 官网(https://ollama.com/download/),并下载相应的安装程序。

1.2 安装 Ollama

双击安装文件并点击“Install”,Ollama 默认安装路径为 C:\Users\<username>\AppData\Local\Programs\Ollama。

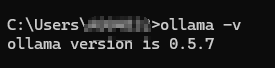

- 验证安装:打开命令行,输入

ollama -v,若显示版本信息,则表示安装成功。

ollama -v

1.3 配置环境变量(可选)

设置环境变量,可以优化 Ollama 的运行。

| 环境变量名称 | 作用 |

|---|---|

OLLAMA_MODELS |

这个变量指定了模型镜像的存储路径。通过设置OLLAMA_MODELS=F:\OllamaCache,我们可以将模型镜像存储在E盘,避免C盘空间不足的问题。 |

OLLAMA_HOST |

这个变量定义了Ollama监听的网络接口。通过设置OLLAMA_HOST=0.0.0.0,我们可以让Ollama监听所有可用的网络接口,从而允许外部网络访问。 |

OLLAMA_PORT |

这个变量允许我们更改Ollama的默认端口。例如,设置OLLAMA_PORT=8080可以将服务端口从默认的11434更改为8080。 |

OLLAMA_ORIGINS |

允许的源列表,星号*或使用逗号分隔。 |

2. 部署 DeekSeep 模型

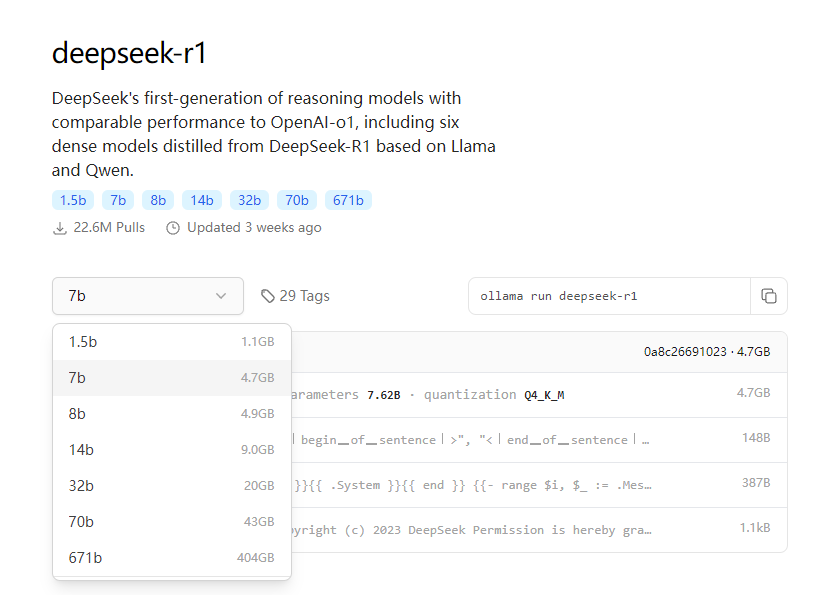

2.1 选择模型

在 Ollama 官网(https://ollama.com/search)找到 DeekSeep 模型,根据电脑配置选择合适的模型版本。

2.2 下载及运行模型

在cmd命令行窗口中打开命令行,输入以下命令下载及启动模型:

# 默认安装地址是 C:\Users\<username>\.ollama\models

# 下载模型

ollama pull deepseek-r1:1.5b

# 下载/运行模型,模型不存在时自动下载

ollama run deepseek-r1:1.5b

三、Cherry-Studio安装及配置

1. 下载 Cherry-Studio

访问 Cherry-Studio 官网(https://cherry-ai.com/download)

2. 配置 Cherry-Studio

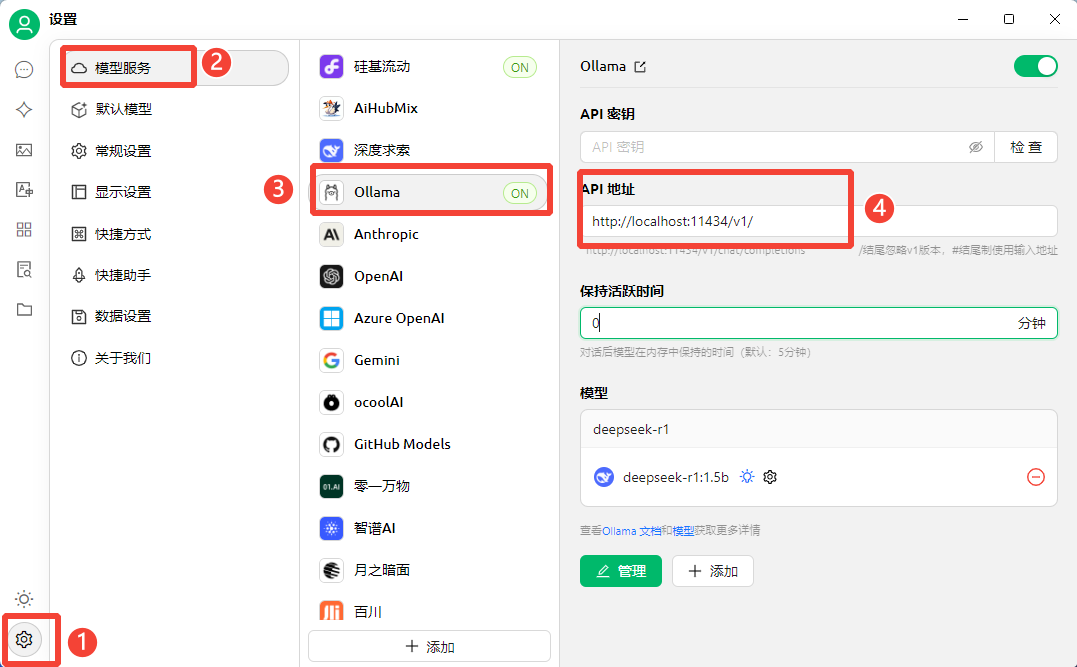

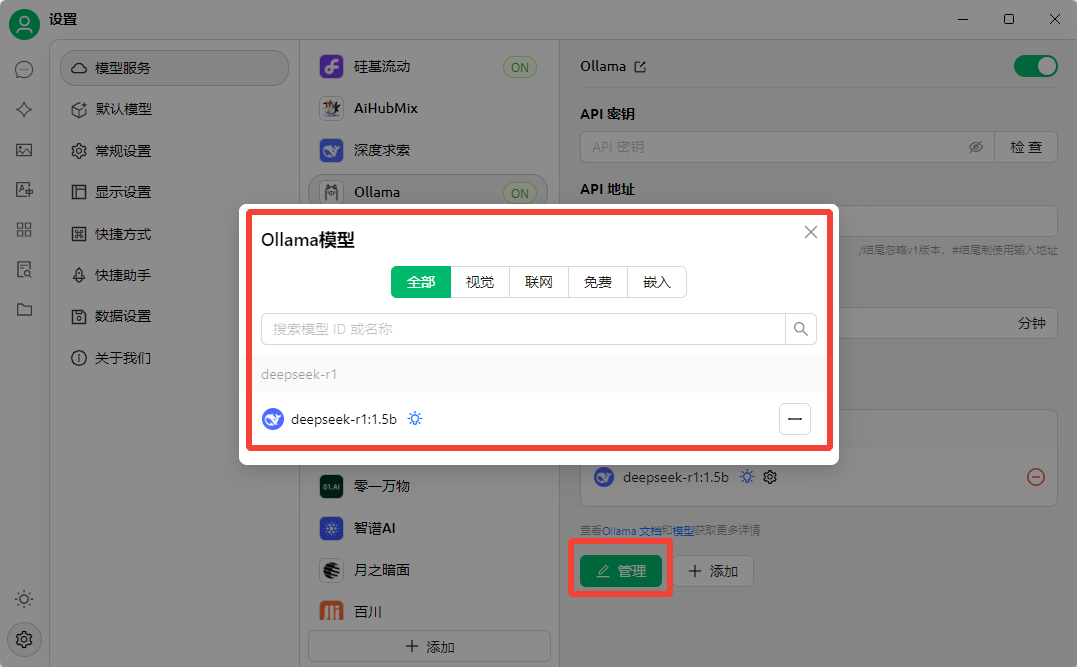

- 添加本地模型

在 Cherry-Studio 中,选择<font style="color:rgb(6, 6, 7);">模型服务</font>,添加本地<font style="color:rgb(6, 6, 7);">Ollama</font>模型服务。配置完成后,选择已部署的 DeekSeep 模型(deekseek-r1:1.5b)。

3. 创建知识库(可选)

如果需要使用知识库功能,可以在 Cherry-Studio 中上传 PDF、DOCX 或网页链接等文件,构建专属知识库。

4. 在 Cherry-Studio 中对话

完成上述配置后,即可在 Cherry-Studio 中与本地部署的 DeekSeep 模型进行对话。用户可以通过对话框输入问题,模型会基于本地知识库或预训练知识生成回答。

四、总结

通过 DeekSeep、Ollama 和 Cherry-Studio 的组合,用户可以在 Windows 系统中轻松实现大模型的本地化部署和对话交互。这种方式不仅降低了成本,还确保了数据隐私,适用于个人开发者、创作者和团队协作场景。希望本文能帮助读者快速搭建本地化的 AI 应用环境,探索更多可能性。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)