AI Agent 的错误修正策略:基于反馈学习的决策迭代优化方法

随着大模型驱动的 AI Agent 在实际业务中的渗透率日益增加,如何让 Agent 在复杂场景中持续纠错、稳定进化,成为影响其性能上限的核心问题。传统的 AI 模型往往依赖预训练知识与启发式规则,但在动态环境中,这种方式难以避免累积错误(Error Accumulation)或策略退化(Policy Drift)。因此,构建一套系统性的 错误修正策略,并采用 基于反馈学习(Feedback Le

AI Agent 的错误修正策略:基于反馈学习的决策迭代优化方法

随着大模型驱动的 AI Agent 在实际业务中的渗透率日益增加,如何让 Agent 在复杂场景中持续纠错、稳定进化,成为影响其性能上限的核心问题。传统的 AI 模型往往依赖预训练知识与启发式规则,但在动态环境中,这种方式难以避免累积错误(Error Accumulation)或策略退化(Policy Drift)。因此,构建一套系统性的 错误修正策略,并采用 基于反馈学习(Feedback Learning) 的迭代优化方法,对 Agent 来说至关重要。

本文将从原理到应用,系统介绍 AI Agent 如何在真实环境中“学会变得更好”,并通过反馈驱动持续改进决策能力。

一、AI Agent 错误修正的必要性

1. 决策链条长导致的误差放大

在多步推理任务中,AI Agent 的每一个错误都会影响后续步骤。例如,在自动化脚本生成、数据分析代理、智能客服等任务中,一个细小的误判往往会在链式动作中成倍影响最终结果。

因此,向 Agent 提供机制让其能判断、定位、并纠正错误,是确保稳定输出的基础。

2. 环境动态变化带来的策略过期

AI Agent 运行的目标环境并不是静态的:API 可能更新、业务流程可能改变、数据可能增量变化。

依赖固定规则或静态记忆的 Agent 很可能在环境变化后继续执行过期策略,从而产生错误行为。动态纠错能力使 Agent 能够自适应地更新策略并保证一致性。

3. 用户反馈本身常不完整或噪声化

从用户角度来看,反馈往往是间接的、不明确的,甚至是情绪化的。例如用户只会说“这个结果不对”,但不会指出哪里不对。

AI Agent 需要具备推理能力,从模糊反馈中推断可执行的优化路径。

二、反馈学习(Feedback Learning)的核心机制

1. 基于显式反馈的优化

显式反馈包括:

- 用户指出错误位置

- 用户给出正确答案

- 用户请求重写或重新规划

- 用户对结果给予评分

此类反馈无需 Agent 做额外推断,可直接成为监督信号。

系统会记录错误原因与场景,然后在未来遇到相同模式时优先避免。

2. 基于隐式反馈的推断

隐式反馈主要来自操作结果,如:

- 任务执行失败

- API 调用报错

- 数据校验不通过

- 用户多次重复请求同一任务

此时 Agent 要通过“行为 → 结果”的映射推断错误点。这种隐式反馈尤为珍贵,因为它无需用户主动标注,能让系统持续自监控。

3. 通过奖励模型实现反馈强化

为了让 Agent 具备“偏好学习”能力,可以结合奖励模型(Reward Model)或评分模型实现:

- 正确决策 → 奖励

- 错误决策 → 惩罚

- 更优策略 → 高奖励 → 优先选择

这一过程类似于 RLHF,但可以改为轻量级在线版本,适用于生产环境。

三、Agent 错误修正的策略与方法

1. Self-Reflect(自我反思)策略

Self-Reflect 是大模型常用的纠错思路:

Agent 在执行任务前或失败后,会强制进行一次“自检推理”。

过程一般为:

1)输出初版决策

2)对决策进行自我评估

3)定位潜在错误

4)重新输出优化版答案

这种方法在推理任务、代码生成等场景中效果显著。

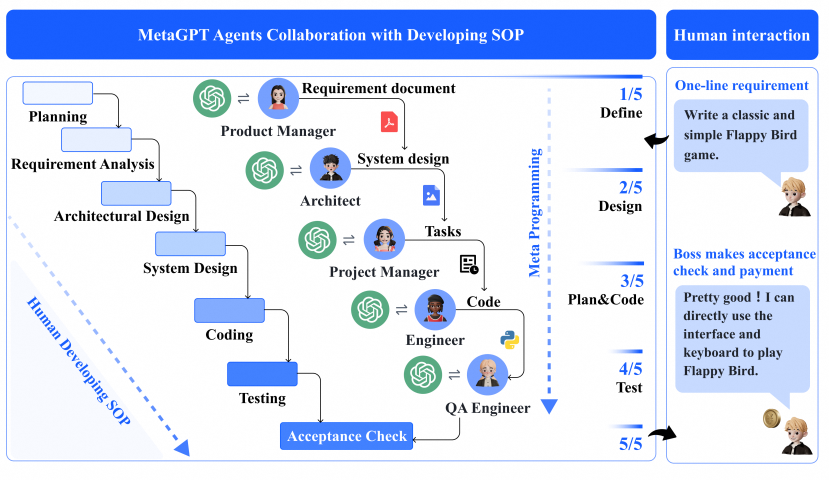

2. Critic & Actor 双Agent结构

通过将 Agent 拆成两个角色:

- Actor:执行任务

- Critic:审查并提供反馈

可以形成类似于“程序员写代码 → code review”的结构。

Critic 的反馈会作为 Actor 下一轮迭代的输入,实现闭环优化。

3. Tool-Feedback(工具化反馈)

Agent 与工具结合能进行更高质量的纠错,例如:

- 用 Linter 检查代码

- 用 SQL explain 分析查询优化

- 用 API 的状态码判断请求是否成功

- 用测试用例自动验证结果

工具化反馈通常比人类反馈更加精准,易于自动化。

4. Memory-Based Correction(基于记忆的纠错)

将错误模式存入记忆后,Agent 能够避免重复错误,例如:

- “这个 API 需要指定字段 X”

- “这个脚本的路径是 /opt/data,不是 /data”

- “某类输入常常导致解析失败,需提前校验”

通过记忆机制可以将纠错成果固化。

四、决策迭代优化:让 Agent 持续进化

1. 迭代循环:Plan → Act → Evaluate → Improve

一个成熟的 AI Agent 通常运行在如下循环中:

Plan(规划)

→ Act(执行)

→ Evaluate(评价)

→ Improve(改进)

→ Plan(再次规划)

每次循环都会积累新的反馈,从而持续优化策略。

2. 引入局部与全局优化机制

- 局部优化:修正当前任务中的具体错误

- 全局优化:从历史经验中抽象出通用行为规范或策略模板

例如,Agent 会从一次失败的 API 调用中学习参数校验规则(局部优化),也可能从多次不同任务中学习如何统一处理系统错误(全局优化)。

3. 长期价值函数:让 Agent 避免短视决策

决策的好坏不仅取决于当前结果,还取决于未来的影响。

通过学习长期价值(Long-term Value),Agent 可避免为了短期成功而做出造成长期错误的策略。

五、真实业务中的应用与价值

1. 在自动化任务中的应用

例如在 ETL 数据处理、脚本自动化、日志分析任务中,Agent 可基于错误日志持续优化:

- 错误字段自动识别

- 重试策略自动调整

- 风险步骤提前警告

使自动化任务越跑越稳。

2. 在智能助手中的应用

如果用户经常补充需求说明,Agent 会学会主动问清楚;

如果用户经常纠正某类答案,Agent 会更新响应模式。

最终提升交互质量与用户满意度。

3. 在企业 AI Agent 产品中的价值

对于企业级应用,更强的错误修正能力意味着:

- 更低的人工运维成本

- 更少的生产事故

- 更高的交付可靠性

- 更快的部署扩展能力

企业真正希望的不只是“能用”,而是“能稳、能改、能自动提升”的 Agent。

结语

AI Agent 的核心竞争力不只来自模型本身的能力,而是来自 能否通过反馈实现自我进化。

基于反馈学习的纠错机制,可以让 Agent 在不断试错与反思中迭代优化决策能力,实现真正意义上的智能自治。

随着工具化反馈、奖励学习、记忆模块等技术的成熟,我们即将看到拥有强大自修复能力、自推理能力和自进化能力的下一代智能 Agent,它们将成为未来自动化系统的基础设施。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)