从 0 拆解 AI 模型底层逻辑:不用代码,读懂神经网络核心工作机制

在 AI 技术遍地开花的今天,很多人能熟练调用框架、跑通模型代码,却始终隔着一层 “黑箱”—— 说不清模型到底如何 “学会” 解决问题,也搞不懂调整参数时背后的逻辑支撑。这种 “调包式” 的实践,在面对嵌入式部署、数值模拟融合等实际场景时,很容易陷入瓶颈。本文将彻底抛开代码,用初中数学常识和生活化类比,拆解神经网络的核心工作机制,帮你从 “用模型” 进阶到 “懂模型”。

在 AI 技术遍地开花的今天,很多人能熟练调用框架、跑通模型代码,却始终隔着一层 “黑箱”—— 说不清模型到底如何 “学会” 解决问题,也搞不懂调整参数时背后的逻辑支撑。这种 “调包式” 的实践,在面对嵌入式部署、数值模拟融合等实际场景时,很容易陷入瓶颈。本文将彻底抛开代码,用初中数学常识和生活化类比,拆解神经网络的核心工作机制,帮你从 “用模型” 进阶到 “懂模型”。

一、AI 模型的本质:不是魔法,是 “数据 + 数学规则” 的协作

AI 模型解决问题的底层思路,本质上是把现实问题转化为数学问题:用数据描述问题特征,用预设的数学规则对特征进行处理,最终输出符合目标的结果。比如图像识别,就是把像素点的数值特征,通过一系列数学变换,归类到 “猫”“狗”“汽车” 等标签中。

神经网络其实就是一种 “自适应的复合数学函数”—— 它不像普通函数那样固定了输入输出的映射关系,而是能根据数据调整内部参数,让函数拟合真实的规律。我们可以把它类比成一条 “定制化的信号筛选流水线”:数据是流水线的原料,经过多道工序(层)的加工筛选,最终产出符合要求的成品(预测结果)。

二、神经网络的最小单元:神经元(感知机)的工作逻辑

神经网络的核心基础是 “人工神经元”,它的设计灵感来自人脑神经元的信号传递方式:人脑神经元通过突触接收信号,整合后若达到阈值就会发放脉冲;人工神经元则复刻了这个逻辑,核心包含四个组件:

- 输入:来自数据的原始特征(比如图像的像素值、文本的词向量);

- 权重:每个输入对应的 “重要性系数”(相当于突触的连接强度,权重越大,该输入对结果的影响越强);

- 偏置:调整整体输出的 “偏移量”(避免输入全为 0 时模型无输出);

- 激活判断:对整合后的信号进行筛选,决定是否传递给下一级。

用生活化的例子类比:这就像班级评优系统 —— 输入是学生的各科成绩(语文、数学、英语),权重是各科在评优中的占比(比如数学占 40%,语文占 30%),偏置是评优的基础门槛(比如总分至少要加 5 分才够资格),激活判断就是把 “各科成绩 × 权重 + 偏置” 的结果,和评优分数线对比,达线就评上(输出 1),没达线就淘汰(输出 0)。

三、从单个神经元到 “层”:神经网络的结构搭建逻辑

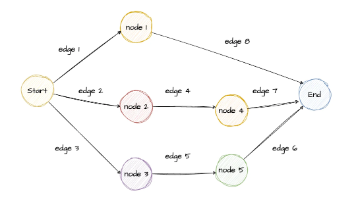

单个神经元的能力有限,无法处理复杂问题,神经网络的威力来自 “分层组织神经元”。一个典型的神经网络分为三层核心结构:

- 输入层:负责接收原始数据,相当于流水线的 “原料分拣站”,只传递数据不做处理(比如图像识别中,输入层神经元数量等于图像的像素总数);

- 隐藏层:神经网络的 “核心加工区”,由多层神经元组成,负责从数据中提取抽象特征 —— 浅层隐藏层提取边缘、纹理等基础特征,深层隐藏层则把基础特征组合成形状、物体部件,最终形成高阶特征(比如从 “线条” 到 “圆形轮廓” 再到 “车轮”);

- 输出层:负责输出最终结果,相当于流水线的 “成品检测台”(分类问题中输出各类别的概率,回归问题中输出具体数值)。

信号在层间的传递过程叫 “前向传播”:输入层的信号传递到隐藏层后,每个神经元先计算 “输入 × 权重 + 偏置” 的线性组合,再通过激活函数筛选,把结果传递给下一层,直到输出层产生最终预测。

四、神经网络的 “学习能力” 核心:激活函数与权重更新

神经网络能 “学习”,关键在于两个核心设计:激活函数打破线性限制,权重更新让模型逼近真实规律。

1. 激活函数:给模型装上 “非线性开关”

如果没有激活函数,神经网络无论有多少层,本质上都是线性变换的叠加,无法拟合现实世界中的非线性规律(比如图像中 “猫” 的特征组合是非线性的)。激活函数就像一个 “非线性开关”,对神经元的输出进行筛选和变换:

- ReLU 函数:最简单的 “单向开关”—— 只保留正数输出,负数直接置 0。它的作用是过滤无效信号,让模型聚焦于有用特征,比如在图像识别中,过滤掉像素值过低的噪声点;

- Sigmoid 函数:“概率缩放器”—— 把任意数值压缩到 0-1 之间,适合二分类问题(比如判断 “是猫” 还是 “不是猫”,输出 0.9 就代表 90% 的概率是猫)。

2. 权重更新:让模型 “从错误中调整”

模型的 “学习” 过程,本质上是不断调整权重,让预测结果越来越接近真实值的过程。这需要两个关键工具:

- 损失函数:模型的 “错题本”—— 量化预测结果和真实值的误差(比如均方误差用于回归问题,交叉熵损失用于分类问题)。损失函数的值越小,说明模型预测越准确;

- 梯度下降:模型的 “纠错指南”—— 用 “下山找最低点” 的思路优化权重:把损失函数想象成一座山,山顶是误差最大的位置,山脚是误差最小的位置。梯度就是山体的 “坡度方向”,模型沿着梯度下降的方向(误差减小的方向),一步步调整权重,最终走到山脚(误差最小)。

五、反向传播:模型如何 “溯源修正”?

前向传播能得到预测结果,但要让模型学会修正错误,还需要 “反向传播”—— 把输出层的误差,从后往前逐层分配,指导每层的权重更新。

用考试错题订正类比:输出层的误差相当于 “总分扣了多少分”,反向传播就是从总分倒推,找出每道题扣了多少分(隐藏层误差),再分析每道题里哪个知识点错了(输入层对应的权重问题)。这个过程依赖数学中的 “链式法则”(不用纠结公式,核心是 “误差溯源”):输出层的误差通过链式法则,传递给上一层的神经元,计算每个神经元对总误差的贡献,然后根据贡献大小调整对应权重。

反向传播的意义在于,让多层神经网络具备了 “端到端自主学习” 的能力 —— 不用人工干预,模型就能从结果误差中,自动修正整个网络的参数。

六、常见神经网络结构的底层设计逻辑

不同类型的神经网络,本质是针对不同数据特征定制的 “信号处理规则”:

- CNN(卷积神经网络):专为图像、视频等网格状数据设计,核心是 “局部特征提取 + 参数共享”。比如识别图像时,CNN 只关注局部像素的关联(比如相邻像素组成的边缘),而非全局像素;同时,同一组权重可以复用在图像的不同位置,既减少了参数数量,又能捕捉到平移不变的特征(比如不管猫在图像左边还是右边,都能识别);

- RNN(循环神经网络):专为文本、语音等序列数据设计,核心是 “保留上下文记忆”。RNN 的神经元会把上一步的输出,作为下一步的输入,这样就能捕捉到序列的先后关系(比如理解 “我爱吃苹果,它很甜” 中的 “它” 指的是苹果)。

七、落地视角:底层逻辑对实际应用的影响

理解底层逻辑,才能在嵌入式部署、数值模拟等实际场景中灵活调整模型:

- 嵌入式设备(如 STM32)部署:神经网络的权重规模决定了模型体积,隐藏层数量决定了计算量。STM32 的存储和算力有限,就需要基于 “权重优化” 逻辑,采用量化(把浮点数权重转为整数)、剪枝(删除不重要的神经元)等方法,让模型适配硬件;

- 数值模拟(如 OpenFOAM)融合 AI:数值模拟需要实时输出结果,这就要求 AI 模型的推理速度足够快。基于 “前向传播计算量” 的逻辑,可以简化隐藏层结构,或选择轻量化激活函数,在精度和速度之间找到平衡。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)