LazyLLM测评丨构建个人知识库AI助手的最佳实践

LazyLLM作为一个新兴的大模型应用开发框架,以其简洁的API设计和强大的功能特性,为开发者提供了一种全新的解决方案。本文将通过实际案例,深入解析LazyLLM框架的核心技术和应用实践,展示如何利用它构建一个功能完整的个人知识库助手。

引言

在人工智能技术飞速发展的今天,大语言模型(LLM)已经成为了各行各业关注的焦点。从智能客服到内容创作,从代码生成到数据分析,大语言模型正在深刻地改变着我们的工作和生活方式。然而,如何高效地利用这些强大的AI工具,特别是如何将它们与我们自己的知识库相结合,构建个性化的智能助手,仍然是许多开发者和企业面临的挑战。

LazyLLM作为一个新兴的大模型应用开发框架,以其简洁的API设计和强大的功能特性,为开发者提供了一种全新的解决方案。本文将通过实际案例,深入解析LazyLLM框架的核心技术和应用实践,展示如何利用它构建一个功能完整的个人知识库助手。

LazyLLM框架概述

LazyLLM是一个专注于简化大语言模型应用开发的Python框架,它提供了高度抽象的API接口,使得开发者能够以极简的代码实现复杂的大模型应用功能。LazyLLM的核心设计理念是"懒加载",即只有在真正需要时才执行相应的计算操作,这种设计不仅提高了代码的执行效率,也使得开发过程更加直观和易于理解。

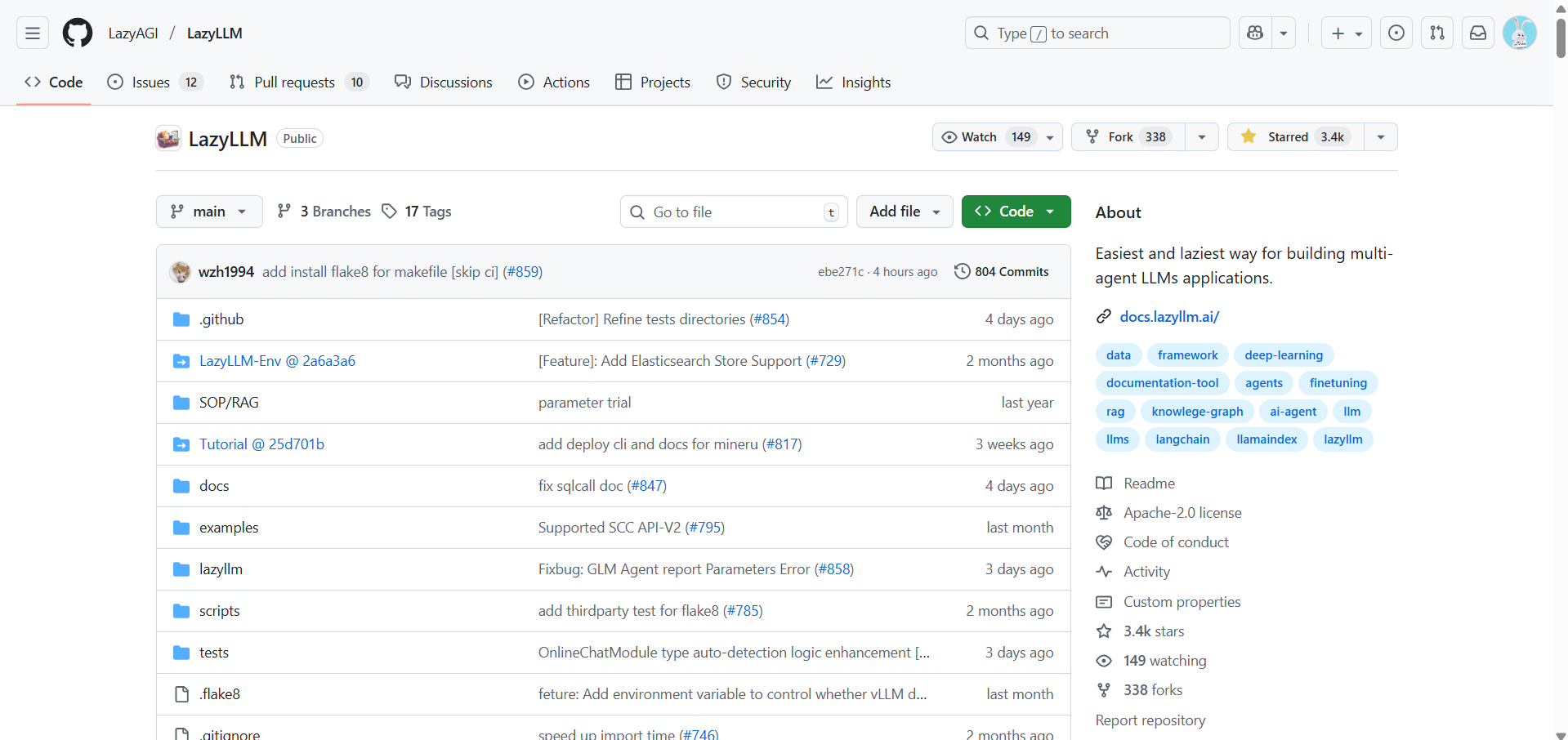

LazyLLM:https://github.com/LazyAGI/LazyLLM

LazyLLM的主要特点包括:

- 简洁易用:通过高度抽象的API设计,大幅降低大模型应用开发的门槛

- 模块化设计:将大模型应用的各个组件(如文档处理、检索器、重排序器等)封装为独立模块,便于组合和复用

- 懒加载机制:只有在需要时才执行计算操作,提高执行效率

- 多模型支持:支持多种主流大语言模型和嵌入模型

- Web应用集成:内置Web应用模块,可快速将模型功能部署为Web服务

LazyLLM快速入门

环境准备

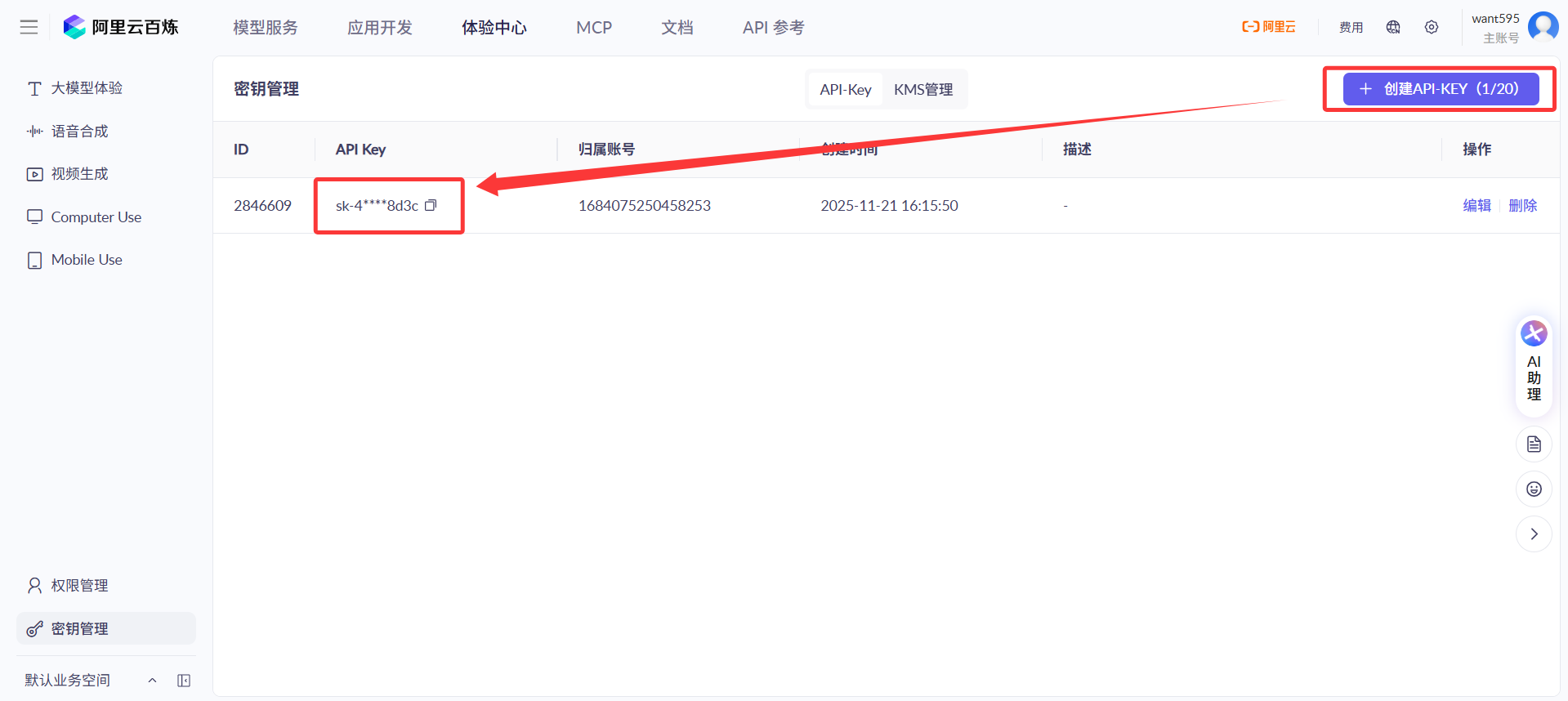

在开始使用LazyLLM之前,首先需要进行环境配置。LazyLLM支持多种大模型平台,本文以阿里云百炼平台为例进行演示。

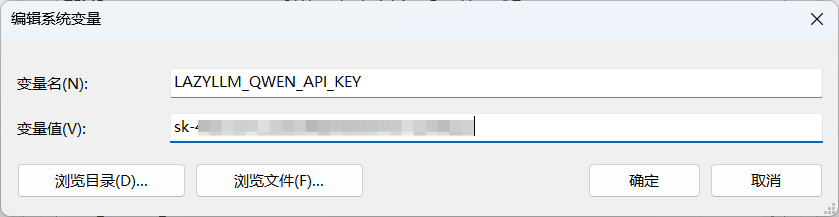

- 进入阿里云百炼平台,创建一个API KEY,然后复制API KEY。

- 将API KEY添加到系统环境变量 LAZYLLM_QWEN_API_KEY。

- 安装LazyLLM框架及相关依赖:

pip install lazyllm

智能对话

快速入门LazyLLM调用大模型的流程。

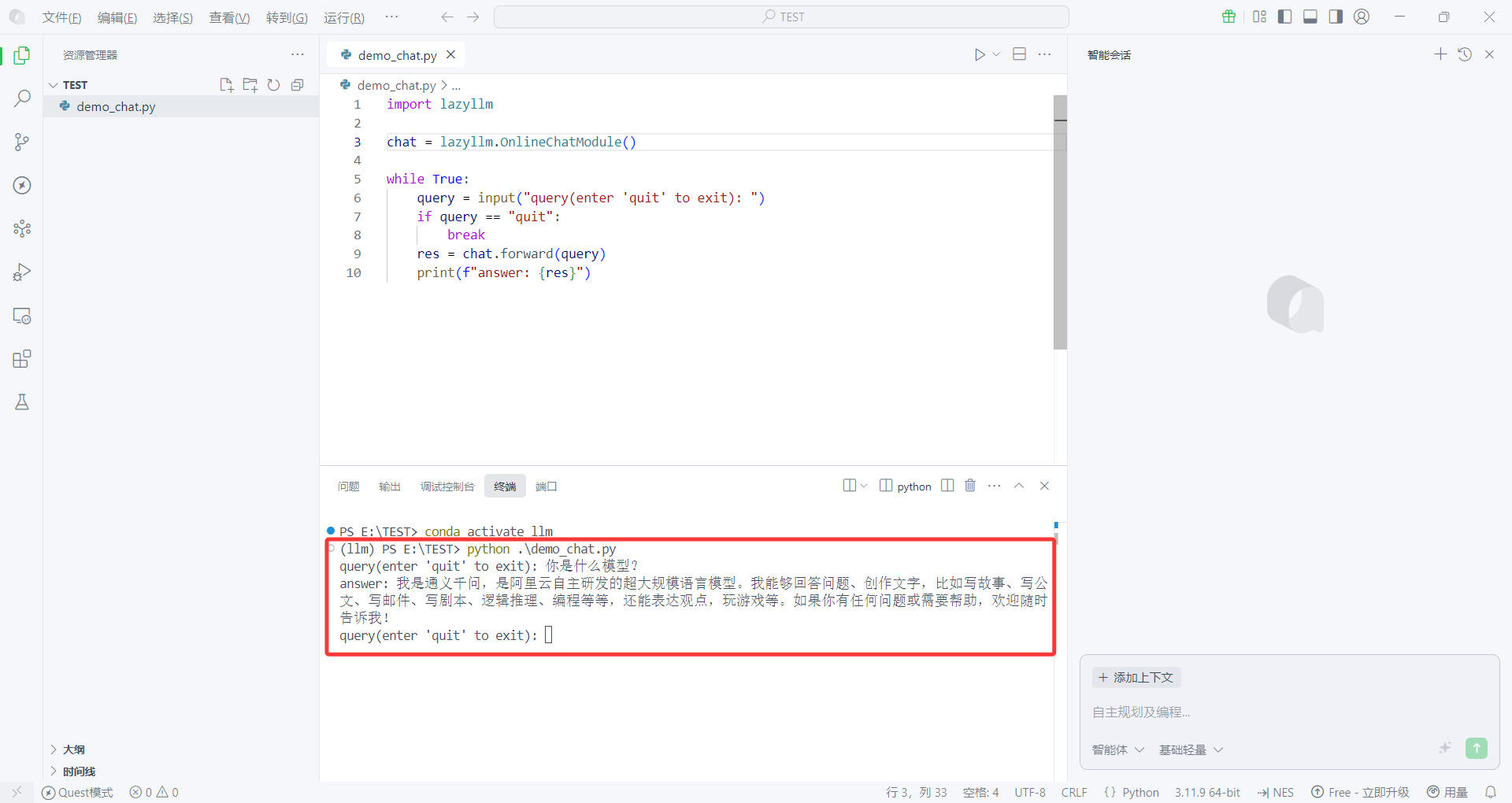

- 创建一个

demo_chat.py脚本,填入以下代码。

import lazyllm

chat = lazyllm.OnlineChatModule()

while True:

query = input("query(enter 'quit' to exit): ")

if query == "quit":

break

res = chat.forward(query)

print(f"answer: {res}")

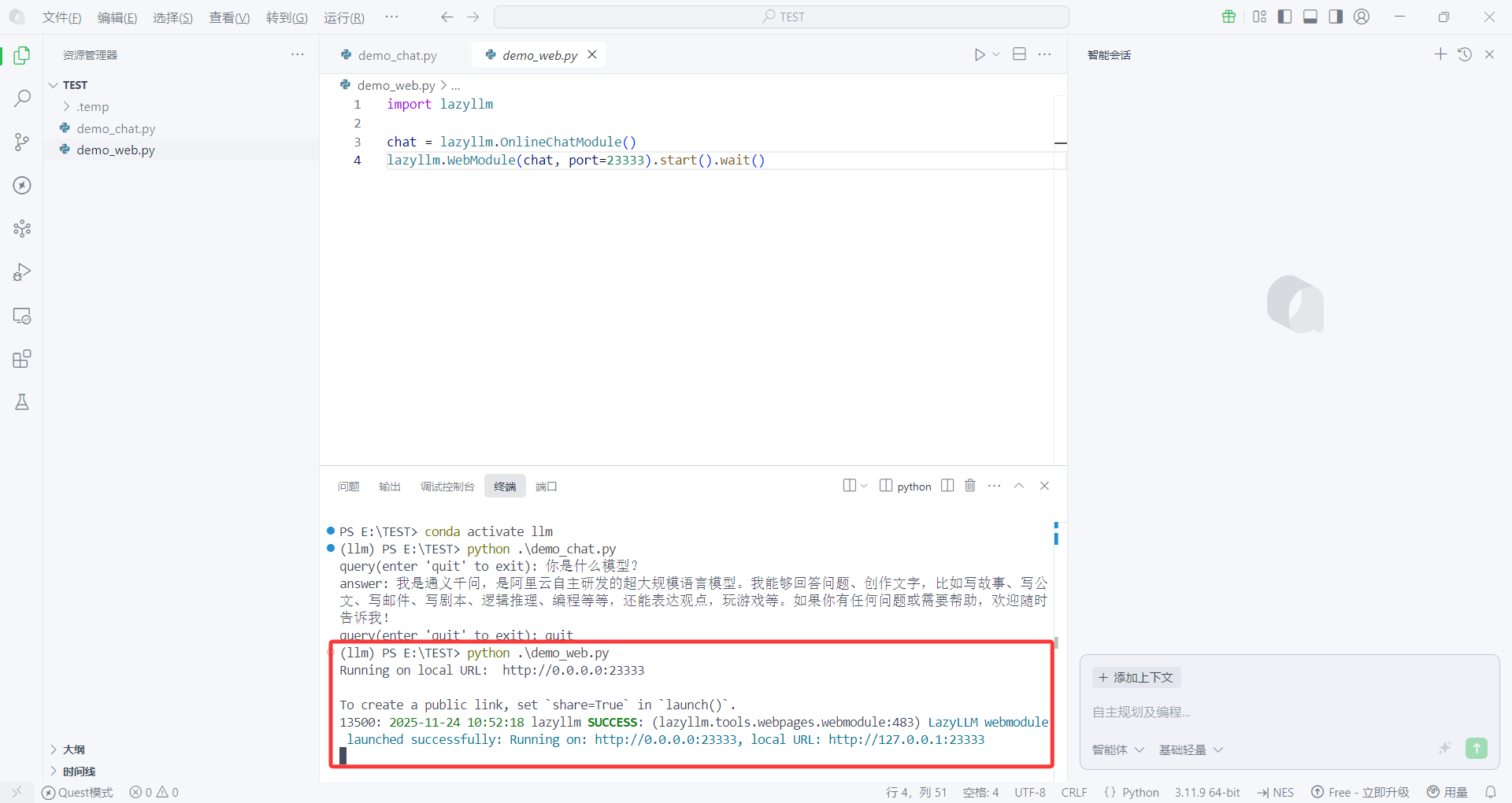

- 然后执行代码,程序运行结果如下图所示:

成功调用qwen大模型,整个过程不到3分钟。这个简单的示例展示了LazyLLM调用大模型的基本流程,只需要几行代码就能实现与大模型的交互。

Web应用

利用LazyLLM,仅需3行代码,即可启动一个Web应用!

- 创建一个

demo_web.py脚本,填入以下代码,然后执行代码。

import lazyllm

chat = lazyllm.OnlineChatModule()

lazyllm.WebModule(chat, port=23333).start().wait()

- 访问 http://localhost:23333,和大模型进行对话。

通过这个示例可以看出,LazyLLM不仅简化了大模型调用的代码,还提供了便捷的Web应用部署功能,使得开发者能够快速将模型功能以Web服务的形式提供给用户使用。

知识库检索

利用LazyLLM调用大模型,结合知识库进行回复。

- 创建脚本

demo_rag.py,填入以下代码。

import lazyllm

# Part0

documents = lazyllm.Document(dataset_path="knowledge_base",

embed=lazyllm.OnlineEmbeddingModule(),

manager=False)

documents.create_node_group(name="sentences",

transform=lambda s: '。'.split(s))

prompt = '你将扮演一个人工智能问答助手的角色,完成一项对话任务。在这个任务中,你需要根据给定的上下文以及问题,给出你的回答。'

# Part1

with lazyllm.pipeline() as ppl:

with lazyllm.parallel().sum as ppl.prl:

prl.retriever1 = lazyllm.Retriever(doc=documents,

group_name="CoarseChunk",

similarity="bm25_chinese",

topk=3)

prl.retriever2 = lazyllm.Retriever(doc=documents,

group_name="sentences",

similarity="cosine",

topk=3)

ppl.reranker = lazyllm.Reranker(name='ModuleReranker',

model=lazyllm.OnlineEmbeddingModule(type="rerank"),

topk=1) | bind(query=ppl.input)

ppl.formatter = (

lambda nodes, query: dict(

context_str = "".join([node.get_content() for node in nodes]),

query = query,

)

) | bind(query=ppl.input)

ppl.llm = lazyllm.OnlineChatModule().prompt(

lazyllm.ChatPrompter(instruction=prompt, extra_keys=['context_str']))

# Part2

rag = lazyllm.ActionModule(ppl)

rag.start()

query = input("query(enter 'quit' to exit): ")

if query == "quit":

exit(0)

res = rag(query)

print(f"answer: {res}")

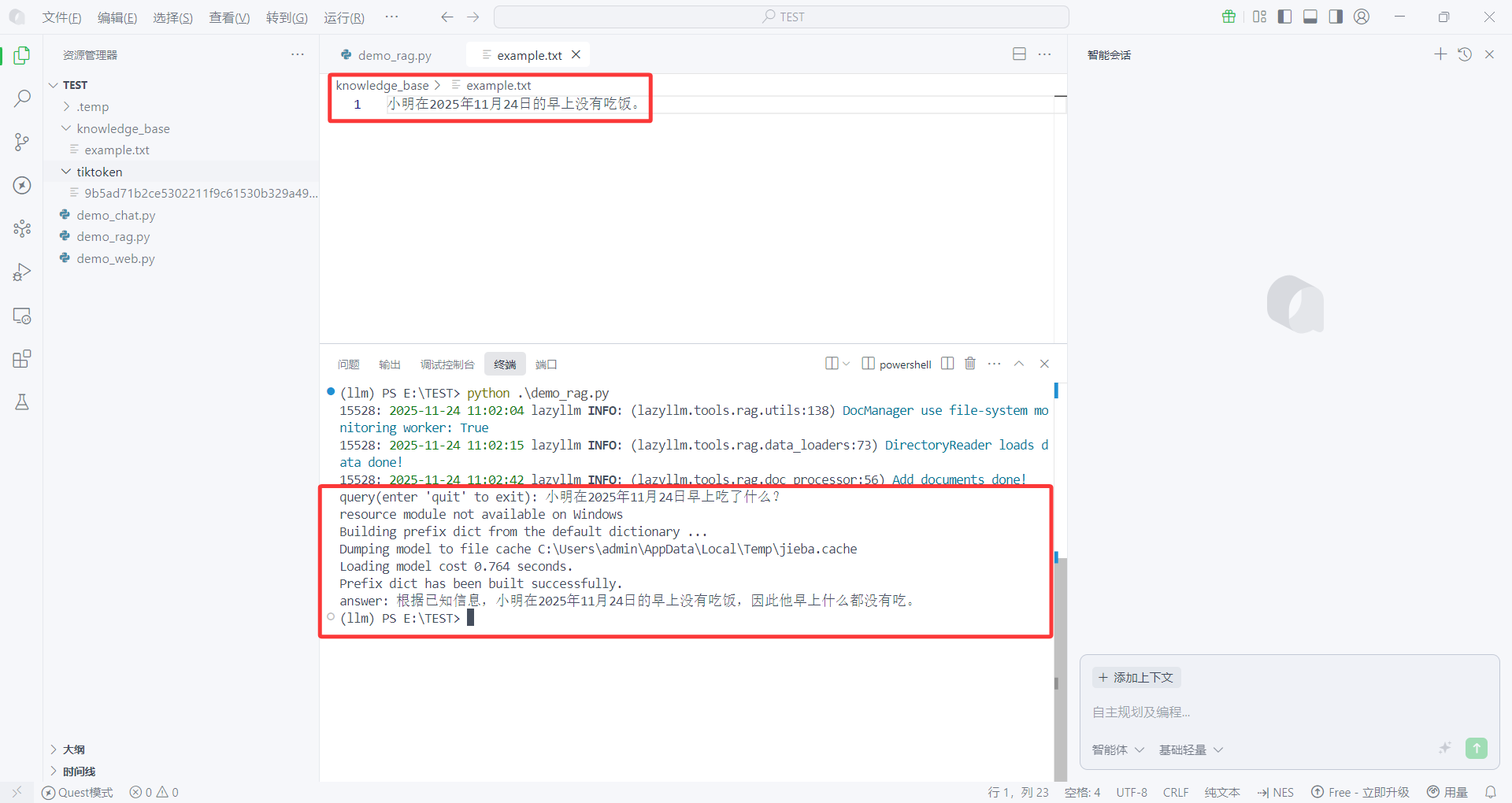

- 在同级目录下创建一个文件夹

konwledge_base,然后在该文件夹下创建文件example.txt并填入以下内容。

小明在2025年11月24日的早上没有吃饭。

- 运行代码,与大模型交互。

从大模型的回复可以看出,其检索了知识库中的内容,然后再回复用户。

这个示例展示了LazyLLM在RAG(Retrieval-Augmented Generation)应用中的强大能力。通过文档处理、检索器、重排序器等模块的组合,LazyLLM能够轻松实现基于知识库的问答功能。

构建个人知识库助手

需求分析

在实际应用中,我们往往需要一个更加完整的解决方案,不仅能够进行智能对话和知识库检索,还需要提供友好的用户界面和便捷的知识库管理功能。因此,我们计划构建一个个人知识库助手,具备以下功能特性:

- Web界面:提供直观易用的Web界面,用户可以通过浏览器访问

- 文件上传:支持用户上传本地文件到知识库目录

- 知识库管理:能够查看和管理知识库中的文件

- 智能问答:基于知识库内容进行智能问答

- 对话历史:保存和显示对话历史记录

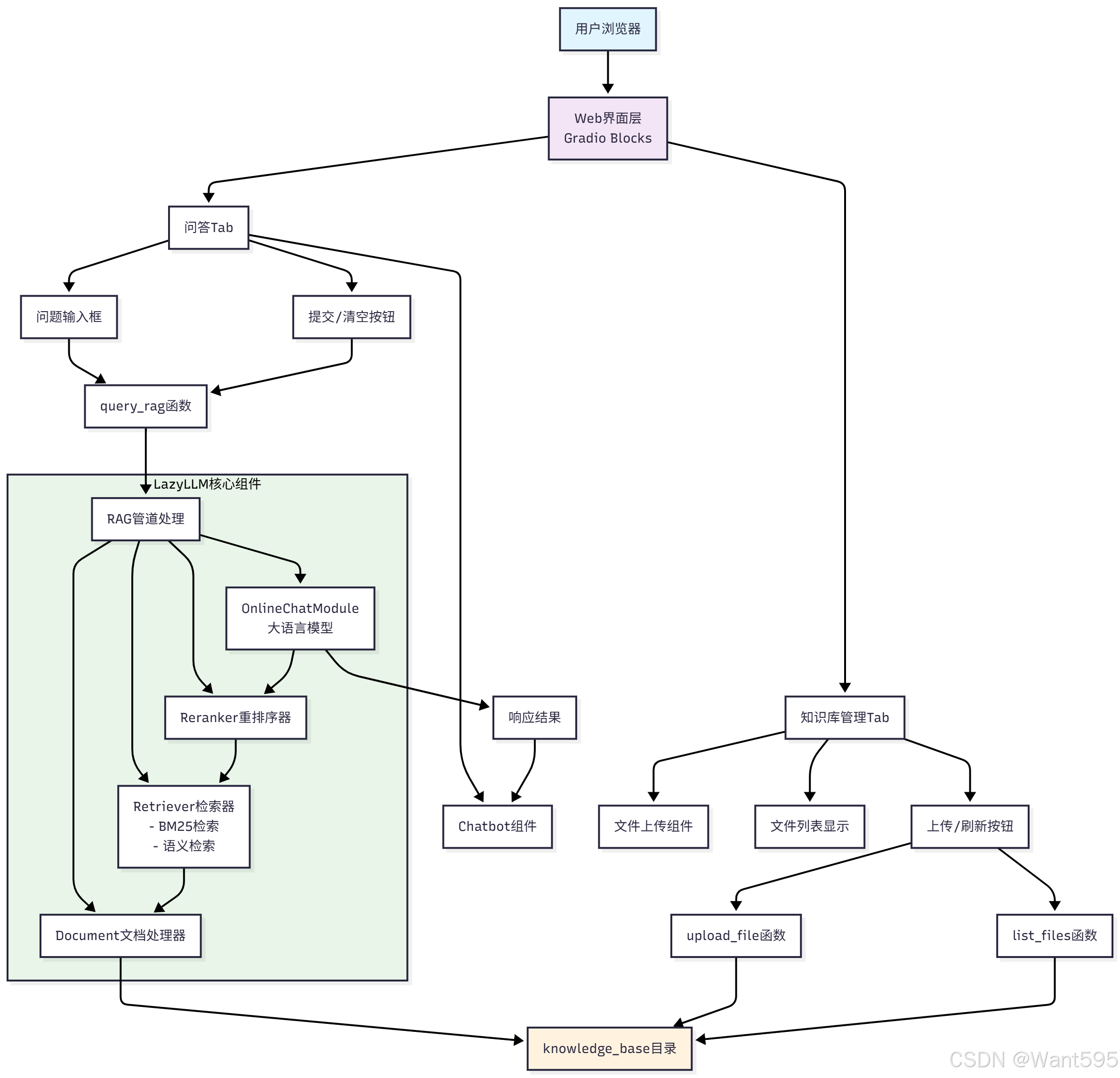

项目架构

项目开发

为了构建一个功能完整的个人知识库助手,我们需要将前面演示的两个核心功能——Web应用和RAG检索增强——进行整合。通过巧妙地结合LazyLLM提供的各种模块,我们可以创建一个既具备友好用户界面又拥有强大知识检索能力的应用。

首先,我们将demo_rag.py和demo_web.py中的核心代码进行整合,创建一个名为web_rag.py的新脚本。该脚本将实现一个知识库助手,启动后用户可以访问 http://0.0.0.0:23333,上传本地文件到知识库目录,然后向大模型提出问题,大模型将基于知识库的内容进行回复。

整合后的脚本具有以下功能特性:

- 启动后会在 http://0.0.0.0:23333 提供Web界面

- 左侧提供了文件上传功能,用户可以上传本地文件到知识库目录

- 右侧提供了聊天界面,用户可以提出问题

- 系统会基于上传到知识库的文件内容来回答问题

主要技术特点包括:

- 自动创建知识库目录

- 支持文件上传并自动更新知识库

- 使用RAG技术实现基于知识库的问答

- 左右分栏布局,提供良好的用户体验

- 支持BM25和语义检索相结合的方式

在开发过程中,我们遇到了一些技术挑战,特别是在Gradio Chatbot组件的数据格式处理上。错误信息显示:'Data incompatible with tuples format. Each message should be a list of length 2.',这表明Chatbot组件期望接收元组列表格式[(user_msg, bot_msg), ...],但原来的实现只是返回了一个简单的字符串。

为了解决这个问题,我们对 web_rag.py 文件进行了两处关键修改:

-

修改了

query_rag函数,使其返回正确的格式:def query_rag(query, history=[]): if not query: return history + [("", "请输入您的问题")] res = rag(query) # 返回正确的格式:[(user_msg, bot_msg), ...] history.append((query, res)) return history -

更新了Gradio界面中按钮点击事件的输入参数,以传递聊天历史记录:

query_input.submit(fn=query_rag, inputs=[query_input, chatbot], outputs=chatbot) submit_btn.click(fn=query_rag, inputs=[query_input, chatbot], outputs=chatbot)

这些修改确保了Chatbot组件接收到符合预期格式的数据,从而解决了之前的问题。

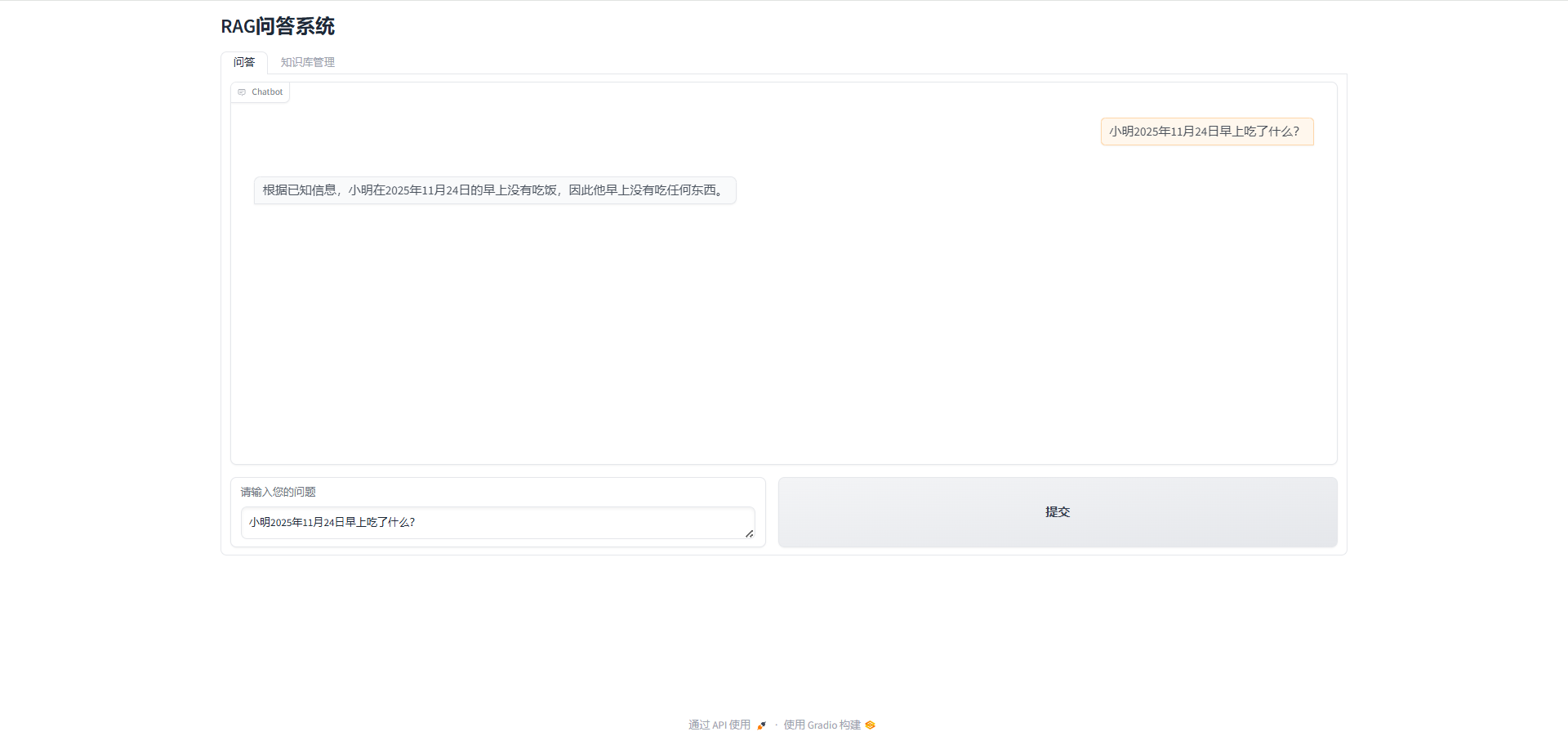

最后可以访问 http://localhost:23333 ,与个人知识库助手进行交互。

项目测试

在完成项目开发后,我们进行了全面的功能测试以验证LazyLLM框架的实际效果。测试过程主要包括以下几个步骤:

-

上传测试文档到知识库:我们将一份名为example_upload.txt的测试文档上传到知识库目录,LazyLLM的文档管理模块能够自动识别并处理新上传的文件,将其纳入检索范围。

-

知识库问答测试:通过向系统提出与测试文档内容相关的问题,我们验证了LazyLLM的RAG管道能否准确检索相关信息并生成高质量的回答。测试结果表明,系统能够精准定位文档内容并给出满意的答复。

项目优化

为了提升用户体验,我们对基于LazyLLM构建的Web界面进行了细致的优化工作:

-

界面布局调整:我们重新设计了界面元素的排列方式,使文件上传区域和聊天交互区域更加清晰分明,用户可以更直观地进行操作。

-

交互体验改进:针对用户反馈的操作流畅性问题,我们优化了页面响应速度和交互逻辑,确保在文件上传和问答过程中都能提供顺畅的体验。

-

视觉效果增强:通过调整颜色搭配和字体大小,使整体界面更加美观且易于阅读,提升了产品的专业感。

项目部署

利用LazyLLM优秀的部署能力,我们将个人知识库助手快速部署到了魔搭创空间平台:

-

应用创建:在魔搭创空间平台上填写应用基本信息,包括名称、描述等,然后一键创建应用实例。

-

代码部署:将开发完成的

web_rag.py及相关依赖文件打包上传至平台,LazyLLM的轻量化设计使得部署过程非常简便。 -

在线发布:经过简单的配置后,应用即可正式上线运行,用户可以通过生成的URL随时随地访问个人知识库助手。

整个部署过程充分体现了LazyLLM框架在工程化方面的优势,大大降低了AI应用从开发到上线的门槛。

LazyLLM框架深度解析

核心组件分析

LazyLLM框架的核心组件包括以下几个部分:

- OnlineChatModule:在线聊天模块,用于与大语言模型进行交互

- Document:文档处理模块,用于处理和管理知识库文档

- Retriever:检索器模块,用于从知识库中检索相关信息

- Reranker:重排序器模块,用于对检索结果进行重新排序

- WebModule:Web应用模块,用于将模型功能部署为Web服务

RAG流程详解

在我们的个人知识库助手中,RAG流程是核心功能之一。具体流程如下:

- 文档处理:使用Document模块加载和处理知识库中的文档

- 节点分组:将文档内容按句子进行分组,便于后续检索

- 并行检索:使用两个不同的检索器并行检索相关信息

- 基于BM25算法的粗粒度检索

- 基于语义相似度的细粒度检索

- 结果重排序:使用重排序器对检索结果进行重新排序,提高准确性

- 上下文构建:将检索到的相关信息构建成上下文

- 大模型问答:将上下文和用户问题一起发送给大语言模型,生成回答

懒加载机制优势

LazyLLM的懒加载机制带来了显著的优势:

- 性能优化:只有在真正需要时才执行计算操作,避免不必要的资源消耗

- 内存效率:按需加载数据和模型,减少内存占用

- 执行顺序优化:框架可以智能地优化执行顺序,提高整体效率

- 错误处理:在执行过程中出现错误时,可以更精确地定位问题

应用场景

- 企业知识管理

对于企业而言,LazyLLM可以帮助构建企业级知识管理系统,将企业内部的文档、报告、会议记录等知识资产整合起来,通过智能问答的方式提高知识获取效率。

- 个人学习助手

个人用户可以将自己的学习笔记、读书心得、研究资料等上传到知识库中,构建个性化的学习助手,帮助整理和回顾知识内容。

- 技术文档查询

开发团队可以将项目的技术文档、API说明、代码示例等整合到知识库中,方便团队成员快速查询和学习相关技术内容。

- 客服系统优化

企业可以将常见问题解答、产品说明、操作指南等整合到知识库中,构建智能客服系统,提高客服效率和用户满意度。

总结与展望

通过对LazyLLM框架的深度解析和实践应用,我们可以清晰地看到它在大模型应用开发领域的独特优势。LazyLLM不仅显著简化了复杂的RAG系统构建过程,还通过其创新的懒加载机制和模块化设计,极大地提升了开发效率和系统性能。

在本文构建的个人知识库AI助手项目中,LazyLLM展现了以下几个核心价值:

- 极简的开发体验:开发者无需深入了解复杂的底层技术细节,即可快速搭建功能完备的AI应用。

- 高效的资源利用:懒加载机制确保系统只在需要时加载相应模块,有效降低资源消耗。

- 灵活的扩展能力:模块化架构使得功能扩展和定制变得异常简单。

- 无缝的部署集成:内置的Web部署能力让应用从开发到上线的过程变得异常流畅。

展望未来,随着大模型技术的不断演进,LazyLLM有望在更多领域发挥重要作用,它不仅适用于个人知识库这样的小型应用,同样可以在企业级解决方案、智能客服、教育培训等场景中大显身手。我们期待LazyLLM社区能够持续壮大,为AI应用开发带来更多的可能性和创新机遇。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)