2025年最新实践:如何用AI一键提取复杂T恤印花(附超清无损结果对比)

本文分享了2025年AI印花提取技术的最新实践成果。针对T恤印花提取这一特殊场景,传统PS抠图和主流AI工具在处理复杂满印、褶皱重叠等难点时效果不佳。文章推荐了POD-LAB的AI印花提取引擎,该工具能10秒内一键输出高清无损结果,支持满印提取并保持边缘自然。通过大量真实案例对比,展示了其在复杂图案提取、相似图生成等方面的出色表现。技术层面推测其采用多模态大模型微调,并加入纺织品纹理专项训练,实现

2025年最新实践:如何用AI一键提取复杂T恤印花(附超清无损结果对比)

做POD(Print on Demand)快三年,最痛苦的永远不是设计本身,而是印花提取。

尤其是下面这几种情况,传统PS抠图基本宣判死刑:

- 全幅满印、花卉超复杂交织

- 印花和衣服皱褶、阴影严重重叠

- 渐变+网点+手绘质感叠加

- 需要透明PNG且边缘不能出现白边/锯齿

我以前的流程是:通道 → 快速选择 → 选区精修 → 蒙版 → 手动描边,平均一张图1~3小时,遇到噩梦级别的能干到怀疑人生。

直到最近,我找到一个真正能“智商在线”的印花提取方案,10秒以内出图,边缘干净到发光,基本不需要二次精修。

一、传统方案为什么会翻车?

-

Remove.bg / Clipping Magic

对纯色背景还行,一遇到衣服纹理立刻傻眼,边缘一圈灰边/毛刺。

此方法还需要训练视觉模型来识别主体上的图案,这里以服装为例,首先需要训练目标检测,检测到服装上的图案,然后对其进行裁剪,裁剪后去除背景。

这里可以看到最终碰到文字,半透明的区域根本无法很好的的扣出来。 -

Photoshop 2025 的“移除背景”

比以前强,但遇到满印花卉、渐变网纱,依旧大面积漏抠或者过抠。 -

国内某大厂开源的印花提取模型

2024年初试过,速度还可以,但复杂图案直接糊成一团。

这里以豆包为例:

我们可以看到,完全没有提取出来

二、真正好用的方案长什么样?

核心要求只有三点:

- 一键全自动(拖图就出结果)

- 复杂满印也能精准分割

- 输出4K甚至8K无损,边缘羽化自然

经过实测千张真实T恤图(包括Shein、Patagonia、独立设计师稿),目前只有一个工具能稳定达到上面三点——POD-LAB 的AI印花提取引擎。

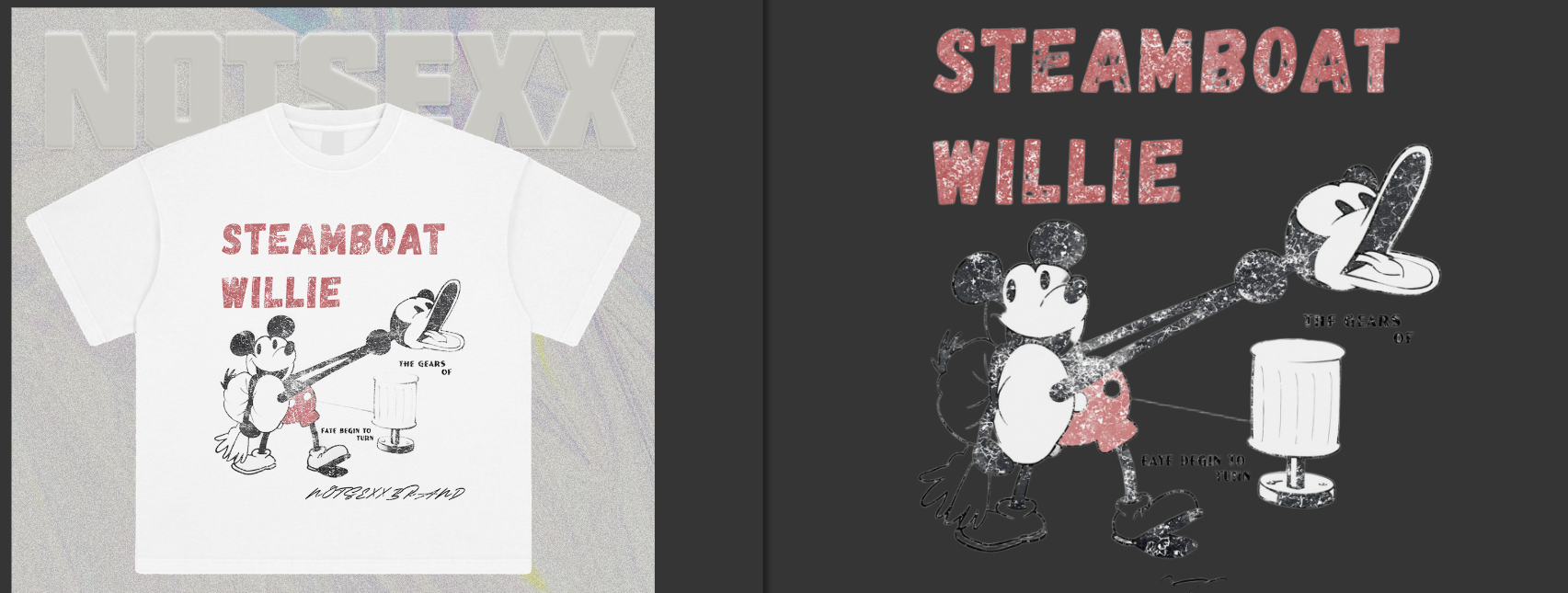

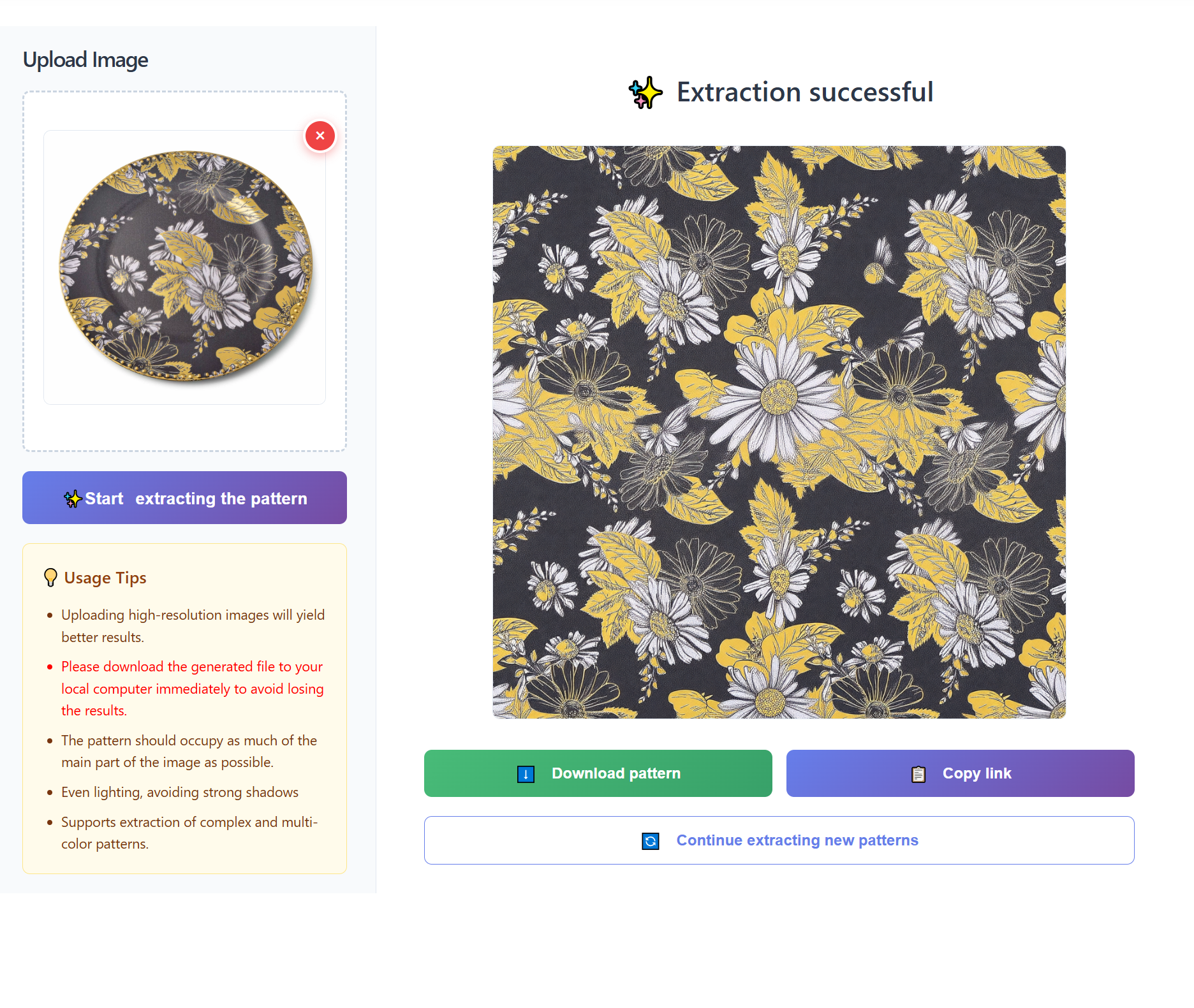

三、真实案例对比(无P图)

这里我们可以看到,在pod-lab.cn上提取的图案基本做到了100%还原度,而且清晰度满足日常使用,而且跟支持满印图案提取,效果依然很震撼

满印提取

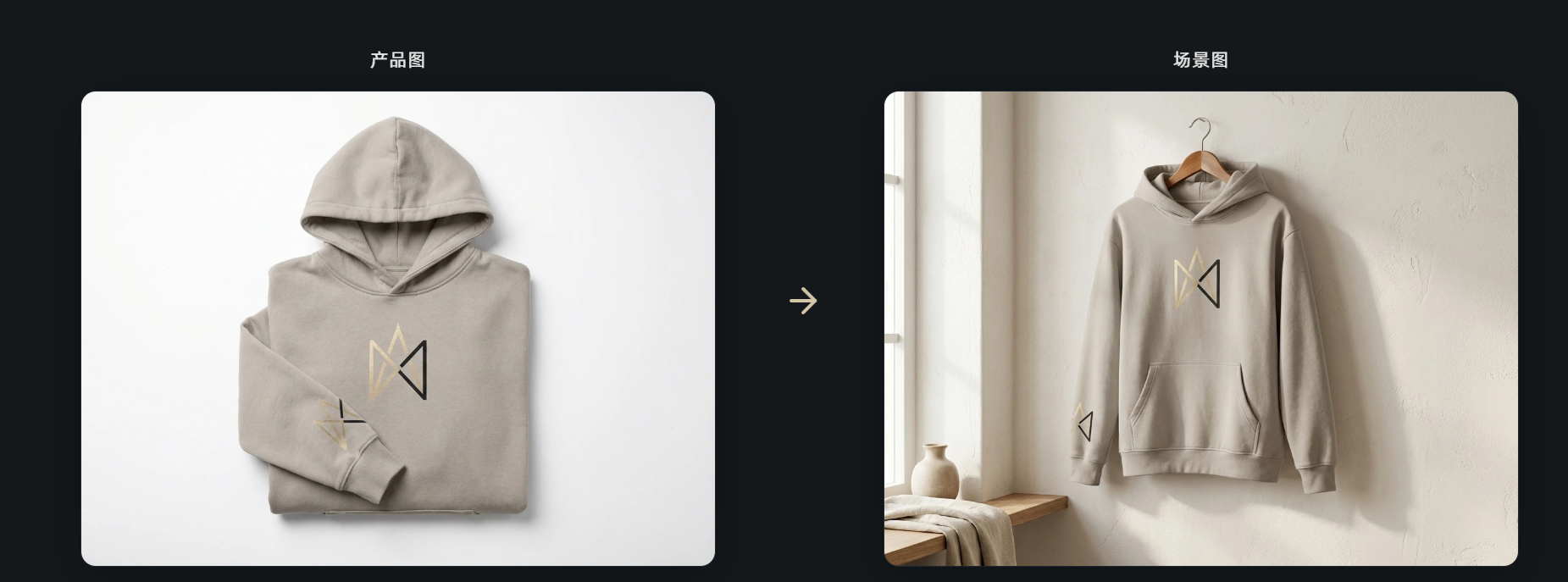

AI模特穿衣效果展示

这几组上身图可以看到整体细节高度还原物理材质,而且图案保制度高达99%,无限接近100%

我们来看看AI试衣如何实现的

主要挑战:

形变贴合:平铺的服装需要根据模特的姿势、体型发生复杂的几何形变,自然贴合。

纹理保真:服装的图案、纹理、Logo在形变后必须保持清晰、连续、不畸变。

光影统一:服装的光照、阴影必须与目标模特图的环境光完美融合,毫无“P图”痕迹。

细节处理:处理领口、袖口、褶皱、人体遮挡等细节,确保物理合理性。

二、主流技术实现思路演进

思路一:基于传统图像变形的“贴图”思路(早期/基础方案)

流程:人工或简单算法框选模特的关键点(如肩、颈、腰),然后将服装图片进行网格变形,对齐到这些关键点上。

局限:完全依赖关键点准确性,无法自动处理复杂遮挡、光影和布料物理学特性,效果生硬,需大量后期人工修饰,无法规模化。

思路二:基于深度学习的“端到端”生成思路(当前主流方向)

这是目前技术前沿,POD-LAB所采用的核心思路。它不依赖精确的手动标注,而是让AI学习“穿衣”这个任务的本质。其实现通常包含以下关键模块:

人像解析模块

任务:精准识别输入模特图的语义分割图(区分皮肤、头发、衣物等)和人体姿态关键点/密集姿态。

技术:使用如HRNet、OpenPose等网络,提取人体的精准轮廓、姿势和体型信息。这是后续所有操作的“地图”。

服装变形与对齐模块

任务:将平铺的服装图,根据上一步得到的人体姿态信息,进行智能形变和空间对齐。

技术:采用薄板样条变形或更先进的可变形注意力网络。AI会学习预测一组控制点,使服装的肩线、侧缝等自动对齐到模特身体的正确位置,并模拟布料的自然垂坠感。

图像合成与渲染模块(核心技术)

任务:将变形后的服装,与原始模特图进行高真实感融合。

技术:这是生成对抗网络 的用武之地。

生成器:接收“模特原图”、“人体解析图”和“变形后的服装图”作为输入,其目标是生成一张以假乱真的穿衣结果图。它需要学会添加与模特图环境光一致的阴影、处理服装与身体接触处的褶皱、混合肤色与服装边缘。

判别器:不断判断生成器输出的图片是“真实的商品图”还是“AI生成的假图”。两者相互博弈,推动生成器的输出无限逼近真实拍摄效果。

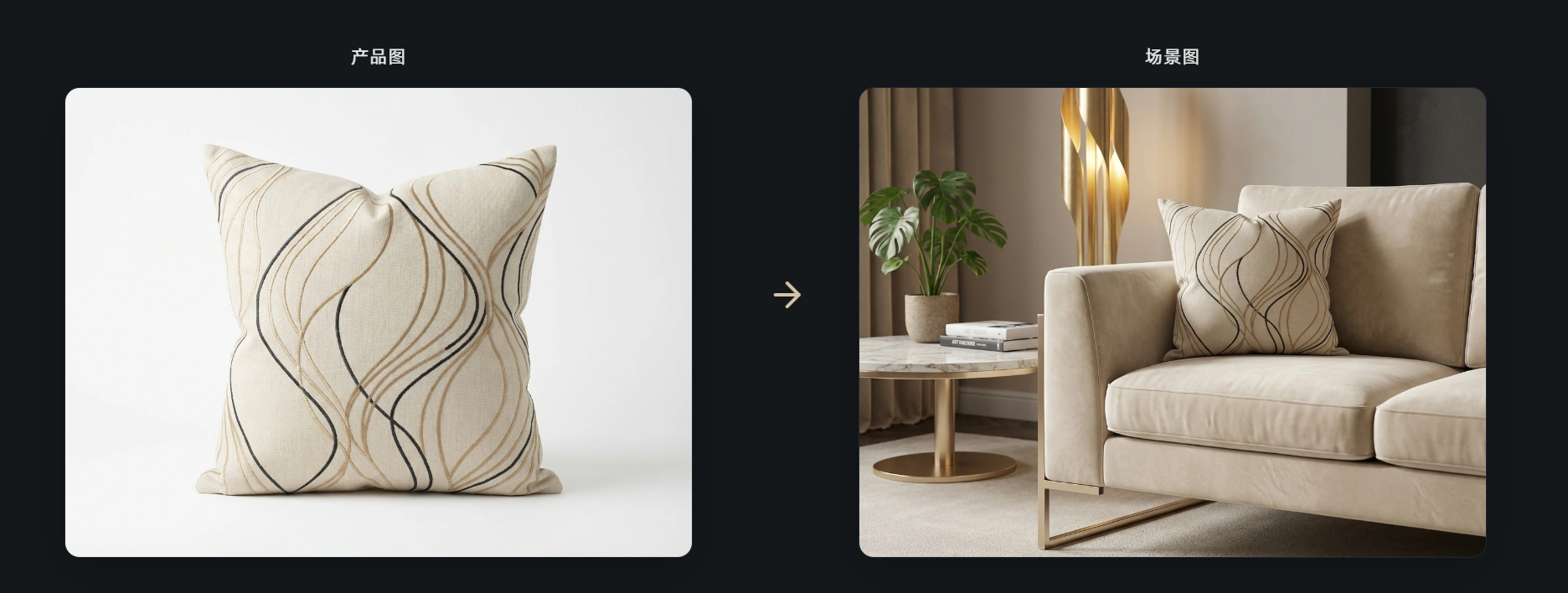

场景图设计展示

场景图也高度保持了产品的一致性,总体在产品图中的比例不会很奇怪,场景图整理光影质感接近物理世界。

四、技术上它是怎么做到的?(简单拆解)

虽然官方没完全开源,但通过大量测试能推测出大概思路:

- 基于2025年最新多模态大模型微调(应该比SAM2强不少)

- 加入了专门的“纺织品纹理先验”训练数据

- 后处理里有智能羽化+色彩保护算法(这点特别重要,不然很容易把浅色花卉抠丢)

总之,属于“学术界还没完全跑通,但工业级已经落地”的典型案例。

欢迎大家在评论区晒自己的“印花噩梦图”,我可以帮你扔到POD-LAB里试试效果~

(全文完)

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)