介绍AI音乐生成技术

AI音乐生成技术正从实验阶段迈向专业应用,主要涵盖四大方向:符号级MIDI生成、高保真音频合成(扩散模型为主流)、AI歌声克隆及多轨音乐制作。核心技术包括音频分词、序列建模、提示控制和音频解码。当前领先模型如Suno v3和Udio已能生成完整歌曲,而开源方案如MusicGen结合DiffSinger也可实现基础功能。应用场景覆盖创作辅助、商业配乐、虚拟歌手等,未来趋势将向"AI制作人&

一、AI 音乐生成技术是什么?

AI 音乐生成(AI Music Generation)指的是利用深度学习模型自动生成音乐,包括:

-

旋律(melody)

-

和声(harmony)

-

伴奏(accompaniment)

-

歌声(vocals)

-

歌词(lyrics)

-

音色合成(timbre synthesis)

-

多轨音乐(multi-track composition)

-

情绪控制、风格控制、结构控制

从最早的 RNN/LSTM,到 Transformer,再到今天的 Diffusion、VAE、Token Mixer、Large Audio Models(LAM),音乐生成已经从“玩具 Demo”进入“专业制作”时代。

二、AI 音乐生成技术的四大核心方向

1️⃣ symbolic-level 生成(符号级,如 MIDI / 乐谱)

模型输出 音符、节拍、力度、和弦。

特点:结构强、适合作曲,但没有真实音频。

代表技术:

-

MuseNet(OpenAI)

-

Music Transformer(Google Magenta)

-

LakhNES、BachBot 等

它们用 Transformer 直接学习 MIDI token 序列。

2️⃣ audio-level 生成(音频级,如 WAV)

模型直接生成 高保真音频(24k–48k Hz)。

三条路线:

⭐(1)扩散模型(Diffusion)

通过噪声逐步反推生成声音,是目前行业主流。

代表:

-

Stable Audio(Stability AI)

-

AudioLDM / AudioLDM2

-

Riffusion(Stable Diffusion 改进版)

-

AudioGen(Meta)

优势:

✔ 可控性强(prompt、节奏、风格)

✔ 高保真,多风格

⭐(2)VAE / GAN 音频生成

较早期,现在被 diffusion 取代。

代表:

-

Jukebox(OpenAI)→ 生成带人声的长音乐

-

GANSynth(音色生成)

特点:可生成非常逼真的 timbre,但结构性弱。

⭐(3)Token-based 音频生成(语音/音频 Tokenizer → Transformer)

类似 GPT 生成“音频 token”,再解码成音频。

代表:

-

Meta EnCodec(音频 tokenizer)

-

MusicLM(Google)→ 直接生成长时间音乐

-

Google's MusicCaps + MuLAN

这是 文本音乐描述 → 音频 token → 高保真音频 的路线。

3️⃣ AI 歌声与音色克隆(Voice/Timbre Clone)

目标:模仿某个歌手的音色唱歌。

主流技术:

-

Diffusion 歌声模型(如 DiffSinger)

-

RVC(Retrieval-based Voice Conversion)

-

So-Vits-SVC(基于 VITS 的 voice conversion)

-

BigVGAN(高保真 vocoder)

适合:

-

Cover 翻唱

-

AI 歌手

-

自定义虚拟人声音

4️⃣ AI 多轨与“制作人级生成”

让 AI 新生:

-

鼓

-

贝斯

-

和声

-

pad

-

lead

-

效果器(reverb, delay)

-

混音

代表产品:

-

Suno AI(最强商用)

-

Udio(最强开放生成)

-

Meta MusicGen + EnCodec(伴奏/多轨)

-

AIVA(配乐)

-

BandLab SongStarter

现在可以一句 prompt 自动生成:

“来一首带弦乐的电影配乐,从低沉到高潮,2 分钟,悲壮风格。”

三、AI 音乐生成的核心技术原理

✔ 1. Tokenization(音频/音符分词)

类似语言模型,但要解决音频的复杂结构。

常见 token:

-

音符 token(MIDI)

-

音频码本(codebook)token:用 EnCodec/Descript Audio Codec 压缩

-

节奏 token

-

乐段 token

✔ 2. 高维序列建模(Transformer / Diffusion)

音乐比语言更长、结构性更强,所以模型设计重点是:

-

长序列建模(旋律 + 和声 + 节奏 + 段落)

-

分层结构(intro, verse, chorus)

-

多模态 alignment(text ↔ music)

✔ 3. Conditioning(提示控制)

输入指令可能包括:

-

风格(Rock、EDM、Jazz…)

-

BPM(速度)

-

和弦走向

-

乐器编制

-

歌词

-

节奏 pattern

-

情绪(sad, epic, dreamy…)

大型模型(如 Suno v3、MusicLM)类似 ChatGPT 的 function-calling 机制,能根据 prompt 自动规划音乐结构。

✔ 4. Vocoder / Decoder(解码器)

将 token → 音频。

代表:

-

EnCodec

-

BigVGAN

-

HiFi-GAN

-

WaveRNN

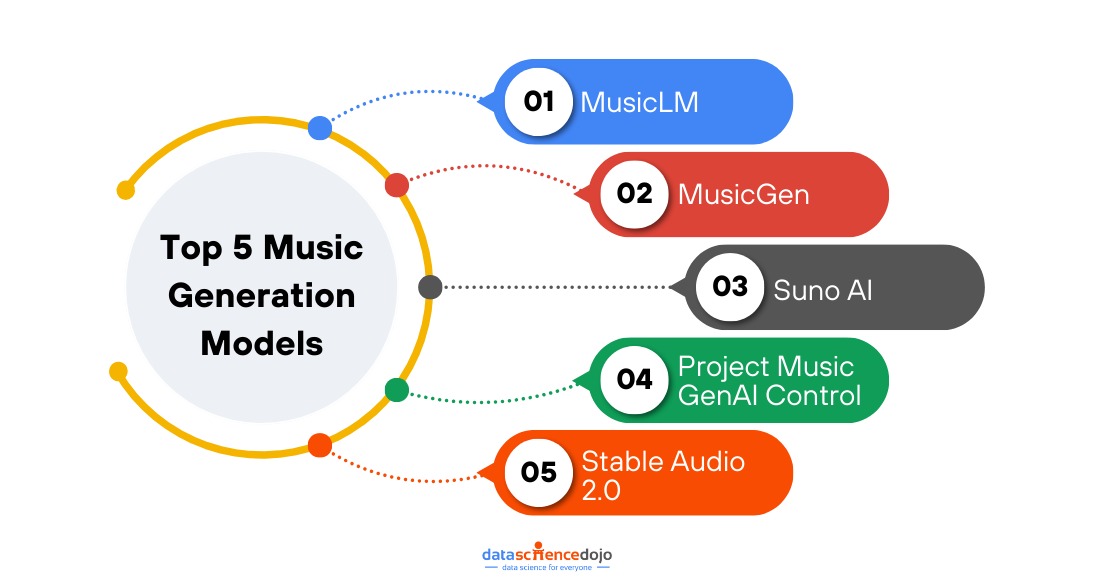

四、主流 AI 音乐生成模型对比(2024–2025)

| 模型 | 类型 | 优点 | 缺点 |

|---|---|---|---|

| Suno v3 | 多轨 + 歌声生成 | 效果最强,结构完整,可生成整首歌 | 不开源 |

| Udio | 歌曲生成 | 人声自然、混音专业 | 不开源 |

| MusicLM(Google) | Token-based | 长音乐质量非常高 | 数据版权问题,未完全公开 |

| MusicGen(Meta) | Diffusion-free Token 模型 | 开源,稳定 | 音频质量略低于商业版本 |

| AudioLDM2 | Diffusion | 开源,prompt 可控性强 | 混音欠专业 |

| Jukebox(OpenAI) | VQ-VAE | 可生成逼真歌声 | 模型巨大,难训练 |

五、AI 音乐生成的主要应用场景

1️⃣ 创作者工具

-

AI 伴奏生成

-

和弦自动填充

-

自动鼓点生成

-

人声增强/修音

2️⃣ 商业音乐制作

-

广告配乐

-

游戏 BGM

-

影视旁白音乐

3️⃣ 虚拟歌手 / AI Idol

-

可训练自己的人声风格

-

AI 歌曲直播

-

UGC 音乐创作

4️⃣ 音频修复

-

去噪、声音增强

-

乐器轨道分离(你使用的 Demucs)

-

多源分离(VOC / 鼓 / 贝斯)

5️⃣ 游戏/元宇宙

-

自动生成背景音乐随场景变化

-

互动式 adaptive music

六、从技术演进看趋势(2025–2027)

1. AI = “音乐制作人”而不是“音乐插件”

模型会:

-

规划歌曲结构

-

写歌词

-

布局 verse / hook

-

多轨编排 + 混音

-

自动母带

像 Suno v3 已经做到 70%。

2. AI 歌手将成为主流

音色模型 + 情感控制(哭、喊、气声、假声)

虚拟人会真正“唱”出专业级歌曲。

3. 开源社区将出现“开源 Suno”

MusicGen + DiffSinger + BigVGAN → 完整 pipeline

4. 未来将出现“音乐 LLM”

类似 GPT-5 的结构:

-

长上下文 → 支持 10 分钟歌曲

-

多轨 token → 精准控制

-

style adapter → 自定义风格

-

记忆你喜欢的乐器/和弦

你可以说一句:

“做一首像久石让 + Hans Zimmer 混合的交响乐,高潮要更宏大一些。”

AI 会自动生成三个版本让你挑。

七、要自己做一个 AI 音乐生成器,要怎么做?

一套 真实可落地方案。

✔ Minimal Version(3 周可完成)

-

使用 Meta MusicGen(开源)生成伴奏

-

使用 DiffSinger / RVC 生成歌声

-

使用 BigVGAN 解码高质量音频

-

前端用 Gradio 做页面

即可做一个“输入歌词 → 输出带人声的歌曲”的 Demo。

✔ Advanced Version(1–3 个月)

模块:

-

Text2Music(音频 token 生成)

-

Voice Clone(SoVits-SVC 4.1)

-

Music Structure Planning(Transformer 分段生成)

-

多轨编排(鼓、和弦、旋律、主旋律)

-

自动混音(动态 EQ、压缩、Limiter)

训练数据:

-

多轨 stems(如 Slakh2100)

-

歌声数据

-

风格 MIDI 数据库

可以产出一个类似“开源 Suno”的系统。

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)