坤擎智能体:企业级AI模型管理的革命性实践与深度解析

坤擎智能体平台推出革命性模型管理模块,解决企业AI应用中的"模型债"问题。该模块采用四层架构设计,提供统一配置管理、智能调试器和推理过程分离等核心技术特性,支持AES256加密存储API密钥和多种模型提供商。通过插件化架构和性能优化策略,实现高并发支持与成本控制。实际应用案例显示,金融风控场景准确率提升15%,客服场景解决率提升至92%。平台还构建了全方位监控告警体系,未来将向

系列文章目录

当模型数量从几个增长到几十个,当API密钥散落在各处,当调试成本成为技术团队的噩梦——我们决定彻底改变这一切。今天,我将向您揭秘坤擎智能体平台如何通过模型管理模块,为企业AI应用带来革命性的变革。

引言:AI时代的"模型债"

在AI技术快速发展的今天,企业面临着前所未有的挑战。我们接触过一家中型科技公司,他们的情况颇具代表性:

-

3个团队使用5种不同的大语言模型

-

12个独立项目中散落着47个API密钥

-

每月因模型调用失败造成的直接损失超过5万元

-

新员工需要2周时间才能熟悉现有的模型调用方式

这正是我们常说的"模型债"——技术债务在AI领域的具体体现。坤擎智能体平台的模型管理模块,正是在这样的背景下应运而生。

一、模型管理:从混乱到秩序的跨越

1.1 传统模型使用的四大痛点

在坤擎智能体平台开发之初,我们总结了企业使用AI模型的四个核心痛点:

-

配置混乱:模型配置信息分散在各个配置文件中

-

成本失控:无法统一监控和管理API调用成本

-

调试困难:没有统一的调试界面,问题排查耗时耗力

-

安全风险:API密钥以明文形式存储,安全风险极高

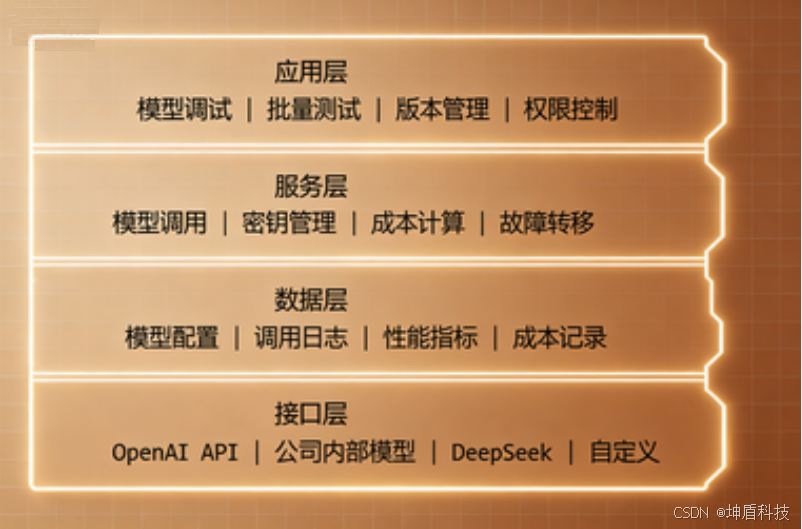

1.2 坤擎的解决方案:四层架构设计

坤擎模型管理模块采用创新的四层架构设计:

二、核心技术特性深度解析

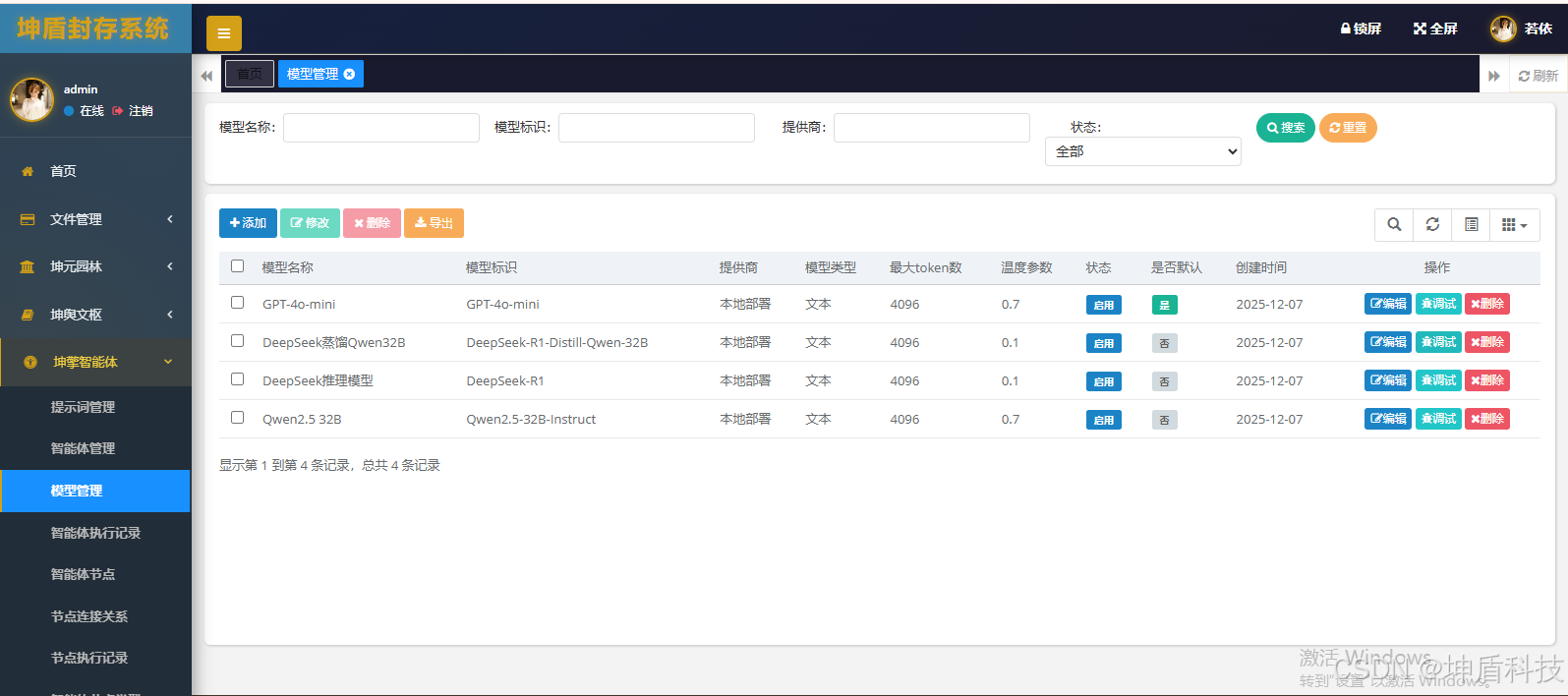

2.1 统一的模型配置管理

痛点解决:告别散落的配置文件

我们设计了一套完整的模型配置管理体系:

@Entity

@Table(name = "ai_model")

public class AiModel {

@Id

@GeneratedValue(strategy = GenerationType.IDENTITY)

private Long id;

@Column(name = "model_name", nullable = false)

private String modelName; // 模型显示名称

@Column(name = "model_alias", unique = true)

private String modelAlias; // 模型技术标识

@Column(name = "model_endpoint", nullable = false)

private String modelEndpoint; // API端点

@Column(name = "api_key", length = 1000)

private String apiKey; // 加密存储的API密钥

@Column(name = "provider")

private String provider; // 提供商

@Column(name = "model_type")

private String modelType; // 模型类型

@Column(name = "max_tokens")

private Integer maxTokens; // 最大token数

@Column(name = "temperature")

private BigDecimal temperature; // 温度参数

@Column(name = "status")

private Integer status = 1; // 状态

@Column(name = "is_default")

private Boolean isDefault = false; // 是否默认模型

}创新点:

-

API密钥AES256加密存储,前端仅显示掩码

-

支持多种提供商的统一配置格式

-

内置模型类型分类,便于筛选和管理

2.2 智能模型调试器

痛点解决:告别繁琐的命令行调试

坤擎模型调试器提供了企业级的调试体验:

@Service

public class ModelInvokeServiceImpl implements IModelInvokeService {

/**

* 统一模型调用接口

*/

public ModelResponse invokeModel(Long modelId, Long promptId, String userInput) {

// 1. 获取模型配置

AiModel model = aiModelService.selectAiModelById(modelId);

// 2. 构建消息(支持提示词模板)

String finalMessage = buildFinalMessage(promptId, userInput);

// 3. 根据提供商调用对应API

String provider = model.getProvider();

ModelResponse response = null;

if ("公司内部".equals(provider)) {

response = callInternalModel(model, finalMessage);

} else if ("OpenAI".equals(provider)) {

response = callOpenAIModel(model, finalMessage);

} else if ("DeepSeek".equals(provider)) {

response = callDeepSeekModel(model, finalMessage);

}

// 4. 解析并分离推理过程与最终答案

return parseModelResponse(response);

}

}核心特性:

-

实时对话界面:支持多轮对话调试

-

推理过程可视化:自动分离并展示模型的思考过程

-

性能监控:实时显示token消耗和响应时间

-

历史记录:完整保存调试会话,便于回溯分析

2.3 推理过程分离技术

针对当前流行的推理模型(如DeepSeek-R1),我们实现了智能的推理过程分离:

private ModelResponse parseModelResponse(String responseBody) {

JSONObject jsonResponse = JSON.parseObject(responseBody);

JSONArray choices = jsonResponse.getJSONArray("choices");

if (choices != null && !choices.isEmpty()) {

JSONObject message = choices.getJSONObject(0).getJSONObject("message");

String content = message.getString("content");

String reasoningContent = message.getString("reasoning_content");

// 分离推理过程和最终答案

String reasoning = "";

String answer = "";

if (reasoningContent != null && !reasoningContent.isEmpty()) {

// 优先使用reasoning_content字段

reasoning = reasoningContent;

answer = extractAnswerFromContent(content);

} else if (content.contains("<think>") && content.contains("</think>")) {

// 从<think>标签提取

reasoning = extractBetweenTags(content, "<think>", "</think>");

answer = content.replaceAll("(?s)<think>.*?</think>", "").trim();

} else {

// 直接作为答案

answer = content;

}

return new ModelResponse(reasoning, answer, content);

}

return null;

}技术亮点:

-

支持多种推理格式(reasoning_content字段、<think>标签)

-

智能内容清洗,确保最终答案的纯净度

-

完整的原始内容保留,便于审计和分析

三、安全架构:企业级保护策略

3.1 多重安全防护机制

在安全方面,我们实施了四级防护:

-

传输层安全:全链路HTTPS加密

-

存储层安全:API密钥AES256加密存储

-

访问层安全:基于角色的权限控制(RBAC)

-

操作层安全:完整的操作日志审计

3.2 API密钥安全管理

@Component

public class ApiKeyEncryptor {

@Value("${encryption.aes.key}")

private String aesKey;

@Value("${encryption.aes.iv}")

private String aesIv;

/**

* 加密API密钥

*/

public String encrypt(String plainText) {

try {

Cipher cipher = Cipher.getInstance("AES/CBC/PKCS5Padding");

SecretKeySpec keySpec = new SecretKeySpec(aesKey.getBytes(), "AES");

IvParameterSpec ivSpec = new IvParameterSpec(aesIv.getBytes());

cipher.init(Cipher.ENCRYPT_MODE, keySpec, ivSpec);

byte[] encrypted = cipher.doFinal(plainText.getBytes(StandardCharsets.UTF_8));

return Base64.getEncoder().encodeToString(encrypted);

} catch (Exception e) {

throw new RuntimeException("API密钥加密失败", e);

}

}

/**

* 生成密钥掩码用于显示

*/

public String generateMask(String apiKey) {

if (apiKey == null || apiKey.length() <= 8) {

return "***";

}

return apiKey.substring(0, 8) + "******" + apiKey.substring(apiKey.length() - 4);

}

}四、可扩展性设计:支持未来无限可能

4.1 插件化模型提供商支持

我们设计了可插拔的架构,支持快速接入新的模型提供商:

public interface ModelProviderPlugin {

String getProviderName();

boolean supports(String provider);

ModelResponse callModel(AiModel model, String message);

Map<String, Object> validateConfig(Map<String, Object> config);

}

// 注册中心管理所有插件

@Component

public class ModelPluginRegistry {

private Map<String, ModelProviderPlugin> plugins = new ConcurrentHashMap<>();

public void registerPlugin(ModelProviderPlugin plugin) {

plugins.put(plugin.getProviderName(), plugin);

}

public ModelResponse invokeByProvider(String provider, AiModel model, String message) {

ModelProviderPlugin plugin = plugins.get(provider);

if (plugin == null) {

throw new IllegalArgumentException("不支持的模型提供商: " + provider);

}

return plugin.callModel(model, message);

}

}4.2 配置驱动的模型管理

通过JSON配置支持复杂的模型参数:

{

"model": {

"retry_policy": {

"max_retries": 3,

"backoff_factor": 1.5,

"retryable_errors": ["timeout", "rate_limit"]

},

"fallback_config": {

"enabled": true,

"fallback_model_id": 2,

"conditions": ["timeout", "api_error"]

},

"cost_optimization": {

"strategy": "performance_cost_balance",

"preferred_models": [1, 3],

"budget_limit": 1000

}

}

}五、性能优化:企业级高并发支持

5.1 多级缓存策略

@Service

@CacheConfig(cacheNames = "modelConfig")

public class AiModelServiceImpl implements IAiModelService {

@Cacheable(key = "'model:' + #id", unless = "#result == null")

public AiModel selectAiModelById(Long id) {

return aiModelMapper.selectAiModelById(id);

}

@Cacheable(key = "'active_models'")

public List<AiModel> selectActiveModels() {

AiModel query = new AiModel();

query.setStatus(1); // 只缓存启用状态模型

return aiModelMapper.selectAiModelList(query);

}

@CacheEvict(key = "'active_models'")

public int updateAiModel(AiModel aiModel) {

return aiModelMapper.updateAiModel(aiModel);

}

}5.2 连接池与限流策略

@Configuration

public class ModelInvokeConfig {

@Bean

public RestTemplate modelRestTemplate() {

// 连接池配置

PoolingHttpClientConnectionManager connectionManager =

new PoolingHttpClientConnectionManager();

connectionManager.setMaxTotal(100);

connectionManager.setDefaultMaxPerRoute(20);

// 超时配置

RequestConfig requestConfig = RequestConfig.custom()

.setConnectTimeout(30000)

.setSocketTimeout(120000)

.setConnectionRequestTimeout(5000)

.build();

// 构建HttpClient

CloseableHttpClient httpClient = HttpClients.custom()

.setConnectionManager(connectionManager)

.setDefaultRequestConfig(requestConfig)

.build();

HttpComponentsClientHttpRequestFactory factory =

new HttpComponentsClientHttpRequestFactory(httpClient);

return new RestTemplate(factory);

}

}六、实际应用场景案例

6.1 金融风控场景

某金融机构使用坤擎模型管理模块,实现了:

-

多模型A/B测试:同时测试GPT-4和Claude在风险识别任务上的表现

-

智能故障转移:主模型故障时自动切换到备用模型

-

成本优化:根据任务复杂度自动选择性价比最高的模型

效果:风险识别准确率提升15%,模型调用成本降低40%

6.2 客服智能辅助场景

某电商平台利用坤擎的调试功能:

-

提示词优化:通过实时调试找到最优的客服提示词

-

多轮对话测试:模拟完整客服对话流程

-

性能对比:对比不同模型在客服场景下的表现

成果:客服问题解决率从78%提升到92%,单次对话成本降低60%

七、监控与告警体系

7.1 全方位的监控指标

我们建立了完整的监控体系,覆盖:

-

性能指标:响应时间、成功率、token消耗

-

成本指标:API调用成本、token成本分析

-

业务指标:模型使用频率、用户满意度

-

健康指标:服务可用性、错误率、延迟分布

7.2 智能告警机制

@Component

public class ModelMonitoringService {

@Scheduled(fixedDelay = 60000) // 每分钟检查一次

public void checkModelHealth() {

List<AiModel> activeModels = aiModelService.selectActiveModels();

for (AiModel model : activeModels) {

ModelHealthStatus status = checkSingleModel(model);

if (status.getErrorRate() > 0.1) { // 错误率超过10%

sendAlert("模型错误率过高",

String.format("模型%s错误率达%.2f%%,建议检查",

model.getModelName(), status.getErrorRate() * 100));

}

if (status.getAvgResponseTime() > 30000) { // 平均响应超过30秒

sendAlert("模型响应过慢",

String.format("模型%s平均响应时间%.1f秒",

model.getModelName(), status.getAvgResponseTime() / 1000.0));

}

}

}

}八、未来展望:AI模型管理的演进方向

8.1 智能化模型推荐

未来的坤擎模型管理将引入:

-

智能模型选择:根据任务类型自动推荐最合适的模型

-

成本预测:预估不同模型的调用成本

-

性能预测:预测模型的响应时间和质量

8.2 联邦学习支持

计划支持分布式模型训练和管理:

-

模型版本管理:完整的模型生命周期管理

-

A/B测试框架:科学的模型效果对比

-

灰度发布:安全的模型更新机制

8.3 生态体系建设

构建完整的AI模型生态系统:

-

模型市场:企业内部分享和交易模型

-

插件市场:第三方开发的模型插件

-

社区支持:用户间的经验分享和问题互助

结语:开启企业AI管理的新篇章

坤擎智能体平台的模型管理模块,不仅仅是一个技术产品,更是我们对企业AI应用未来的一次探索。通过统一的平台、智能的调试、安全的架构和强大的扩展性,我们希望能够:

-

降低AI使用门槛:让非技术背景的业务人员也能轻松使用AI

-

提升开发效率:让AI工程师专注于业务逻辑而非基础设施

-

控制运营成本:通过智能优化降低AI应用的总拥有成本

-

保障应用安全:为企业AI应用提供可靠的安全保障

在这个AI技术快速发展的时代,真正的竞争优势不在于拥有多少模型,而在于如何高效、安全、经济地使用这些模型。坤擎智能体平台的模型管理模块,正是我们为此目标而迈出的坚实一步。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)