大语言模型(LLM)在软件测试中的应用与挑战

摘要:大语言模型(LLM)正在深刻变革软件测试领域,预计到2026年80%以上测试活动将整合AI技术。LLM在测试需求生成、用例设计、代码生成和缺陷分析等环节展现出强大能力,如自动解析需求、智能生成测试场景和脚本、优化用例优先级、加速缺陷根因定位等。然而仍面临领域知识缺失、测试Oracle问题、代码幻觉等技术挑战,以及工程化集成、技能转型和安全伦理等实践问题。测试人员需向LLM"指挥家&

随着人工智能技术的飞速发展,大语言模型(LLM)正以前所未有的深度渗透到软件测试领域。根据Gartner最新预测,到2026年,超过80%的软件测试活动将整合AI技术辅助完成。作为软件测试从业者,我们正站在技术变革的前沿,亟需深入理解LLM如何重塑测试需求生成、用例设计、代码生成与Bug分析等核心环节,同时清醒认识其应用边界与挑战。

一、LLM在测试需求生成中的革新应用

1.1 自然语言需求解析与转化

传统测试需求分析高度依赖人工解读产品文档和用户故事,而LLM凭借其强大的自然语言理解能力,能够自动解析非结构化的需求描述。测试工程师只需输入产品需求文档,LLM即可识别关键功能点、性能指标和业务规则,生成结构化的测试需求清单。例如,当输入“用户应能通过手机号快速注册账户并设置安全密码”的需求描述时,LLM可自动输出包括手机号格式验证、短信验证码校验、密码复杂度规则等具体测试要点。

1.2 需求完整性验证与冲突检测

LLM通过比对历史项目数据和行业最佳实践,能够识别需求文档中的模糊表述、遗漏场景和潜在矛盾。在实际应用中,某金融科技团队的测试人员使用LLM分析支付系统需求,成功识别出3处未明确定义的异常处理流程和1个跨境支付币种限制的逻辑冲突,将需求缺陷发现阶段从测试执行提前至需求评审,显著降低了后期修复成本。

1.3 个性化测试策略推荐

基于项目特征(如技术栈、业务领域、质量要求),LLM能够生成针对性的测试策略建议。对于安全性要求高的金融应用,LLM会重点强调渗透测试和数据加密验证;而对于用户体验导向的电商平台,则优先推荐兼容性测试和性能基准测试。

二、LLM驱动的智能化测试用例设计

2.1 多维度测试场景生成

LLM突破了传统测试用例设计的思维局限,能够基于需求规格自动生成正反向用例、边界值分析和错误猜测场景。以登录功能为例,LLM不仅生成用户名密码正确的基本流用例,还会系统性地设计包括账号锁定、密码过期、异地登录预警等28种异常流场景,覆盖了经验不足的测试工程师容易忽略的角落。

2.2 测试数据智能化构建

测试数据的准备一直是测试准备的痛点。LLM能够根据字段类型和业务规则生成符合要求的测试数据,如生成符合特定地区格式的身份信息、保持引用完整性的关联数据,甚至模拟真实业务环境的数据分布,大大减轻了测试数据构造的工作量。

2.3 用例优化与优先级排序

通过分析代码变更历史和缺陷分布模式,LLM能够识别测试用例集中的冗余项和覆盖盲区,并为测试用例提供风险驱动的优先级建议。某互联网企业的实践表明,引入LLM优化后,测试用例数量减少23%的同时,缺陷检出率提升了15%,测试资源分配更加精准高效。

三、LLM在测试代码生成与自动化中的实践

3.1 自动化脚本智能生成

LLM支持将自然语言描述的测试场景直接转化为可执行的自动化脚本。测试人员只需输入“测试用户登录成功后跳转到首页的功能”,LLM即可生成相应的Selenium、Cypress或Appium脚本代码,显著降低了自动化测试的技术门槛。同时,LLM能够根据项目已有的代码规范和框架要求,保持生成代码的风格一致性。

3.2 测试代码优化与重构

对于现有的自动化测试代码,LLM能够识别冗余操作、脆弱定位器和低效等待策略,并提供优化建议。更重要的是,LLM能够自动为测试代码添加详细的注释和文档,改善测试代码的可维护性。

3.3 跨平台脚本适配

面对多终端(Web、iOS、Android)的测试需求,LLM能够基于同一测试逻辑生成适应不同平台的自动化脚本,确保测试场景的一致实现,大幅减少了针对不同平台重复设计测试脚本的工作量。

四、LLM在缺陷分析与根因定位中的突破

4.1 智能化缺陷报告增强

LLM能够自动分析测试工具输出的原始错误信息,将其转化为技术与非技术人员都能理解的清晰描述。当接收到“NullPointerException at line 156”这样的基础错误时,LLM会补充可能的业务场景上下文、相关代码模块的变更历史,甚至提供类似的已解决缺陷参考,加速开发人员的调试过程。

4.2 缺陷模式识别与预测

通过分析项目历史缺陷数据,LLM能够识别特定代码模式、开发人员或业务模块与缺陷类型的关联关系,建立缺陷预测模型。这使得测试团队可以针对高风险区域提前部署专项测试,实现缺陷预防而不仅仅是检测。

4.3 自动化根因分析

当测试失败时,LLM能够综合分析测试日志、代码变更、环境配置等多源信息,快速定位问题根源。在实际案例中,某团队使用LLM将平均根因分析时间从2小时缩短至15分钟,特别是对于难以复现的偶发问题,LLM的数据关联分析能力展现出明显优势。

五、现实挑战与应对策略

5.1 技术局限性挑战

领域知识缺失:通用LLM缺乏特定业务领域的专业知识,可能导致测试场景设计偏离实际业务逻辑。解决方案是建立领域知识库,并通过微调提升LLM的领域适应性。

测试Oracle问题:LLM无法根本解决“如何判断测试结果正确性”这一经典测试难题,特别是在预期结果难以明确量化的场景(如用户体验测试)。需要结合规则引擎和人类专家验证建立混合判断机制。

代码幻觉风险:LLM生成的测试代码可能存在语法正确但逻辑错误的情况,必须通过代码审查和静态分析工具进行二次验证。

5.2 工程化实践挑战

提示工程复杂度:获取高质量输出需要精心设计的提示词,不同测试场景需要不同的提示策略。建立组织内部的提示词库和最佳实践指南是必要的基础建设。

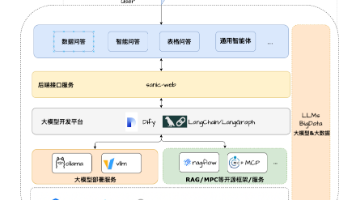

集成与维护成本:将LLM集成到现有测试工具链需要解决API集成、数据安全、响应延迟等工程问题,同时需要持续更新知识库以跟上技术演变。

技能转型压力:测试人员需要从单纯的测试执行者转变为LLM提示设计师、输出验证者和测试策略设计师,这对团队技能结构提出了新的要求。

5.3 安全与伦理考量

测试数据隐私保护、模型输出的责任归属、避免训练数据的版权风险等都是组织引入LLM时必须面对的严肃问题。建立明确的使用规范、数据脱敏机制和审计流程是必不可少的保障措施。

结论

大语言模型正在重塑软件测试的工作范式,将测试从业者从重复性任务中解放出来,转而专注于更高价值的测试策略设计和复杂问题解决。然而,技术的引入不是一蹴而就的,需要我们在热情拥抱创新的同时保持清醒的技术判断,通过渐进式实践、技能提升和合理期望,稳步推进测试智能化的深入发展。未来的测试工程师将是LLM的“指挥家”而非“演奏者”,驾驭AI工具创造更高效、全面的质量保障体系。

精选文章

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)