Ollama:本地大模型的真正“平替神器”——从入门到实战,一篇就够了

Ollama是一款本地大模型运行工具,被称作"AI时代的Docker",用户可通过简单命令快速启动Llama、Qwen、DeepSeek等模型。其优势包括无需复杂环境配置、支持多平台和多种模型、提供CPU/GPU推理以及Python API接口。文章详细介绍了Ollama的安装方法、模型运行指令、Python调用方式,以及如何通过Modelfile自定义模型。Ollama让大模

如果你最近在研究大模型应用,尤其是想让大模型在本地无网运行、随开随用、成本为零,那你一定已经听过——或者马上就会听到一个名字:Ollama

这玩意儿为什么这么火?一句话:

Ollama = 本地大模型的 Docker

你一句命令就能拉起一个 Llama、Qwen、DeepSeek……堪称 AI 时代的“apt-get install”。

今天,我将用一篇文章,把所有你可能想知道的问题一次说清楚:

- Ollama 是什么?

- 支持哪些大模型?为什么 DeepSeek 都能跑?

- 三分钟安装与运行方法(Windows / Mac / Linux)

- 如何用一行命令拉取并启动本地模型?

- Python 如何调用 Ollama 做推理?

- 如何自定义模型 Modelfile?

1. Ollama 是什么?为什么人人都在用?

如果你接触过 Docker,你会发现 Ollama 的设计理念几乎一模一样。

只需要一句命令即可在本地运行大模型:

ollama run llama3

Ollama 的优势:

- 无需配置环境(不用装 CUDA、不用装 Transformers、连 Python 都不用)

- 支持超多模型(并持续更新),包括:Llama 3 全系列、Qwen、DeepSeek等

- 跨平台:Windows / macOS / Linux 全支持

- 同时支持 CPU / GPU 推理

- 提供 HTTP API & Python SDK,你完全可以把它当成自己的“本地 OpenAI API”。

2. Ollama下载安装

2.1 下载Ollama

在Ollama官网(https://ollama.com/download )按需下载:

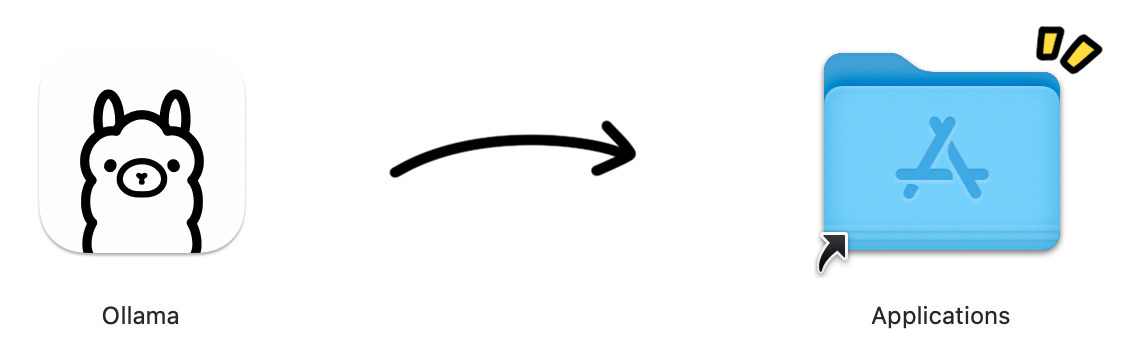

2.2 安装Ollama

我是在MacOS中安装,直接打开Ollama.dmg把应用拖动到Applications中即可安装完成。

MacOS中,也可以通过brew install ollama安装。安装后可以通过ollama --version验证是否安装成功。

3. 下载并运行一个本地模型(例如:Llama3 / DeepSeek)

Ollama 的使用体验就是:你想用哪个模型?直接拉!

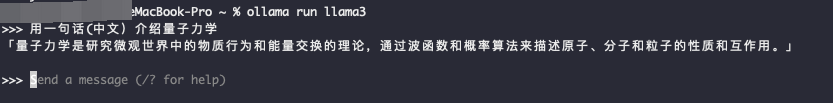

运行指定模型(第一次运行会自动下载,速度会慢一些),比如这里运行llama3(也可以运行deepseek-r1:1.5b、deepseek-r1:7b等模型,所有支持的模型列表见官网https://ollama.com/search):

ollama run llama3

启动成功后,就可以进行问答了:

其他常用命令:

退出:在会话中输入 /bye 或使用快捷组合键盘 Ctrl+d

查询当前本地模型列表:ollama list

删除模型:ollama rm llama3

4. Python API 调用(本地等于自建 OpenAI)

4.1 安装Python SDK

pip install ollama

4.2 调用 Ollama 生成回答(阻塞输出)

import ollama

response = ollama.chat(

model='deepseek-r1:1.5b',

messages=[

{

'role': 'user',

'content': '为什么天空是蓝色的?',

},

])

print(response['message']['content'])

4.3 调用 Ollama 生成回答(stream 流式输出)

import ollama

stream = ollama.chat(

model='deepseek-r1:1.5b',

messages=[{'role': 'user', 'content': '为什么天空是蓝色的?'}],

stream=True,

)

for chunk in stream:

print(chunk['message']['content'], end='', flush=True)

5. 进阶:如何自定义自己的模型(Modelfile)

如果你想对模型做微调(比如加系统提示、合并 LoRA 权重等),创建一个 Modelfile:

FROM deepseek-r1

SYSTEM """

你是一个专业数据分析助手,回答要简洁精炼。

"""

然后构建:

ollama create my-deepseek -f Modelfile

运行:

ollama run my-deepseek

是不是很像【Dockerfile → Image → 容器】的流程?

转载请注明出处《Ollama:本地大模型的真正“平替神器”——从入门到实战,一篇就够了》 https://blog.csdn.net/huyuyang6688/article/details/155612503

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)