大模型Agent落地必知:做减法才是王道

本文强调Agent业务落地的核心是"做减法",而非盲目追求更大的上下文、更全的工具或更复杂的流程。通过精准的信息检索、工具选择、流程优化,以及将长材料卸载到外部系统,可有效避免上下文中毒、干扰等问题。文章提供了六个可落地的"减字"策略和渐进式实施路线,帮助开发者构建更稳定、高效、经济的AI Agent,实现更好的业务留存与复用。

本文强调Agent业务落地的核心是"做减法",而非盲目追求更大的上下文、更全的工具或更复杂的流程。通过精准的信息检索、工具选择、流程优化,以及将长材料卸载到外部系统,可有效避免上下文中毒、干扰等问题。文章提供了六个可落地的"减字"策略和渐进式实施路线,帮助开发者构建更稳定、高效、经济的AI Agent,实现更好的业务留存与复用。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

做 agent 业务落地一定要做减法(图解版)

一句话结论:不要沉迷“更大的上下文、更全的工具、更复杂的流程”。Agent 落地的核心是做减法——只保留完成当前任务“必要且充分”的信息、工具与步骤。

核心挑战

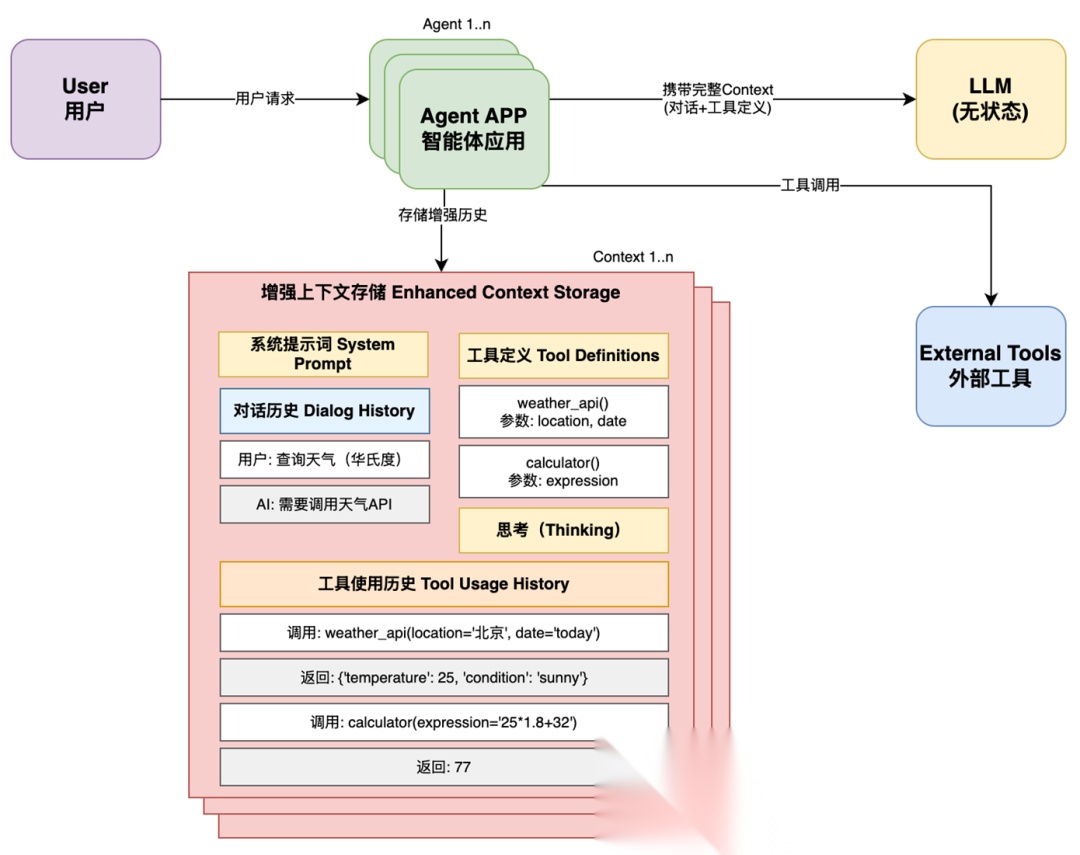

上下文工程视角

- “上下文工程是一种精妙的艺术与科学——在上下文窗口中填充恰到好处的信息,以支持下一步。”

- “从这个视角看,智能体的上下文工程可能以多种方式‘失效’:”

- “如果智能体所需要的上下文不在其可用的总上下文中,智能体就无法成功。”

- “如果智能体检索到的上下文并不包含所需的上下文,智能体就无法正确作答。”

- “如果智能体检索到的上下文远大于所需的上下文,那么它就是在浪费(时间、tokens,或两者)。”

- “在尝试隔离合适的上下文时,会出现一些具体挑战:”

- “Token 过多(检索到的上下文 ≫ 必要上下文)”——“几次网页搜索就可能让会话历史膨胀到数万 token……账单上涨且性能下降。”

- “需要大量上下文(必要上下文 > 支持的窗口)”——“上下文很快增长到无法装入窗口。”

- “查找小众信息(检索到的上下文 ≠ 必要上下文)”——“信息埋在上百/上千个文件中。”

- “随时间学习(可用总上下文 ≠ 必要上下文)”——“是否有办法把交互中的关键信息加入到后续可用上下文?”

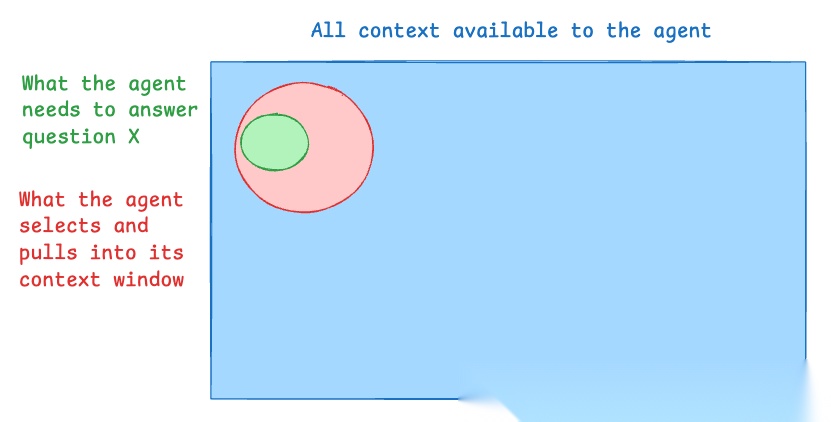

视觉总览

上下文工程方法总览

要点:上下文不是越多越好,目标是让“检索到的上下文”尽量贴近“真正需要的上下文”,并尽可能小的超集。

为什么必须做减法(图解)

更长的上下文窗口、更多的工具定义、更多轮的推理链,并不会自然带来更好的效果。常见失效模式:

- 上下文中毒:早期的幻觉/错误被反复引用并固化。

- 上下文干扰:窗口够大也会“过度依赖历史”,忽略训练知识,策略更新变慢。

- 上下文混淆:给太多工具/资料,模型会尝试“用上它们”,导致跑偏。

- 上下文冲突:多来源信息自相矛盾,平均性能明显下滑。

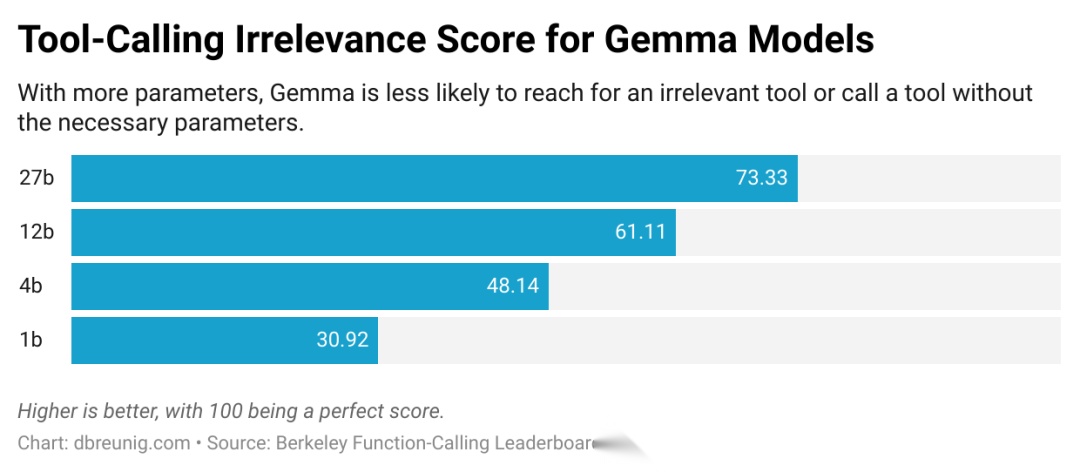

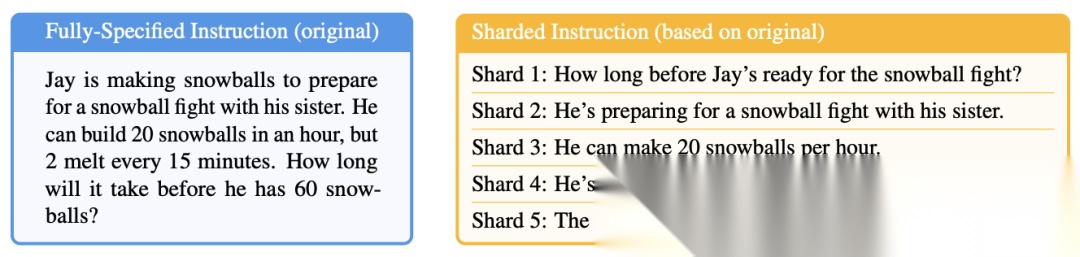

参考图 1(无关信息导致误用):

工具无关性干扰

参考图 2(分片对话引发冲突):

分片提示导致性能崩塌

来自工程一线的证据也在支持“做减法”:

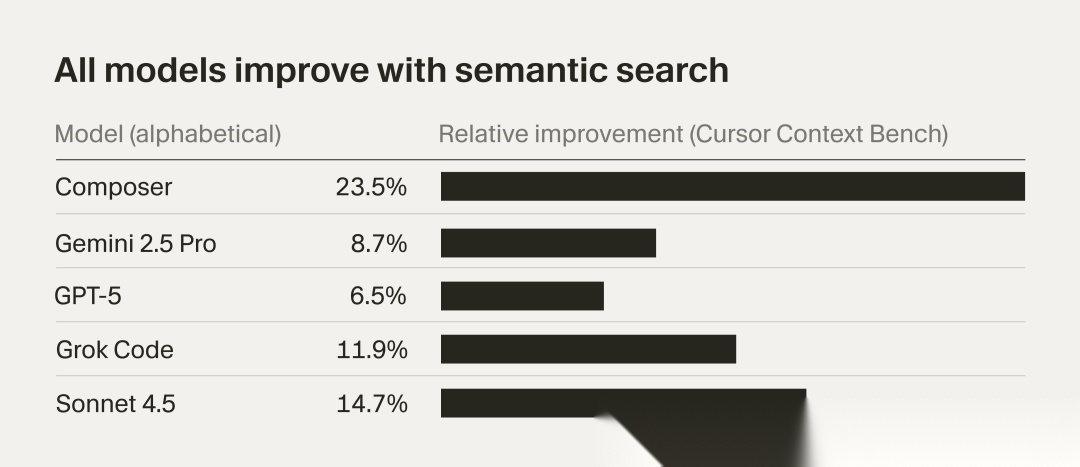

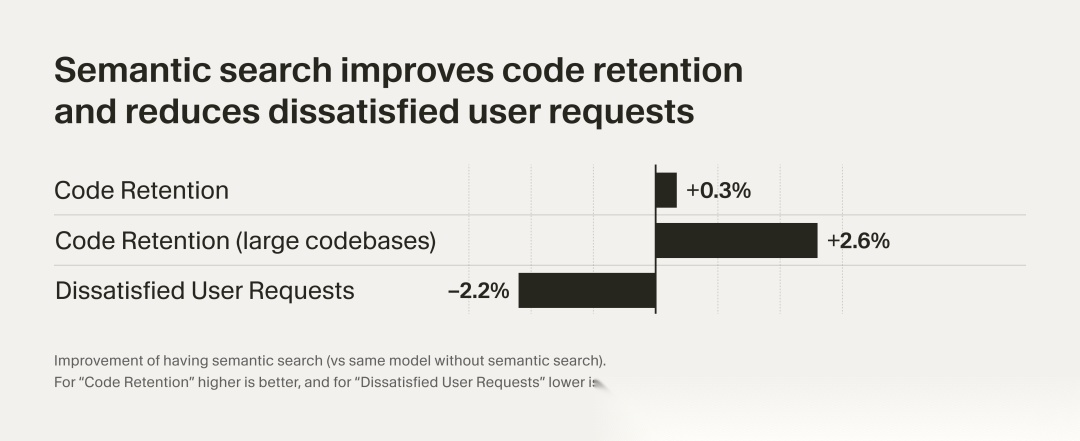

- [Cursor] 语义搜索显著提升工程可用性。未启用语义搜索时,不满意的后续用户请求增加约 2.2%;启用后代码留存率整体 +0.3%,在 ≥1000 文件的大型代码库中提升至 +2.6%。

- [Cursor] grep + 语义搜索的混合检索在大型代码库效果最佳:先精确定位(grep),再语义扩展(embedding 检索)。

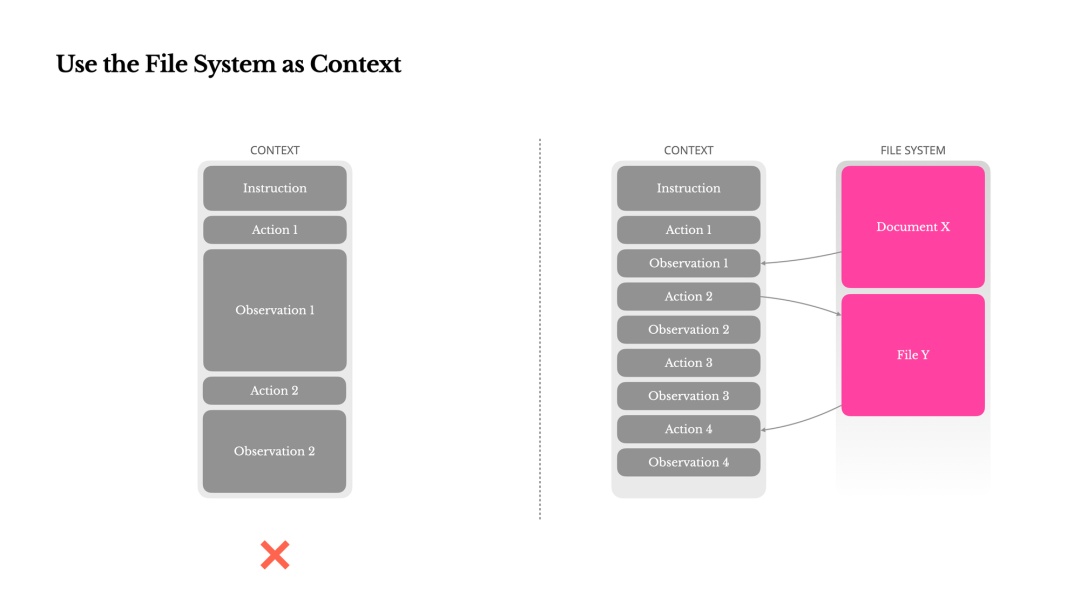

- [LangChain] 文件系统是极佳的上下文“外部化”接口:把中间结果、长文本、工作笔记写入磁盘,主对话只携带必要摘要,显著降低 token 与干扰成本。

三个层面的“减法”原则(速记卡)

- 信息做减法:只取相关片段;定期修剪与摘要;把中间态卸载到对话之外。

- 工具做减法:只暴露与当前任务相关的少量工具,限制说明长度,避免描述重叠。

- 流程做减法:能单体就别多体;多体要“隔离上下文、专注分工、最终汇总”。

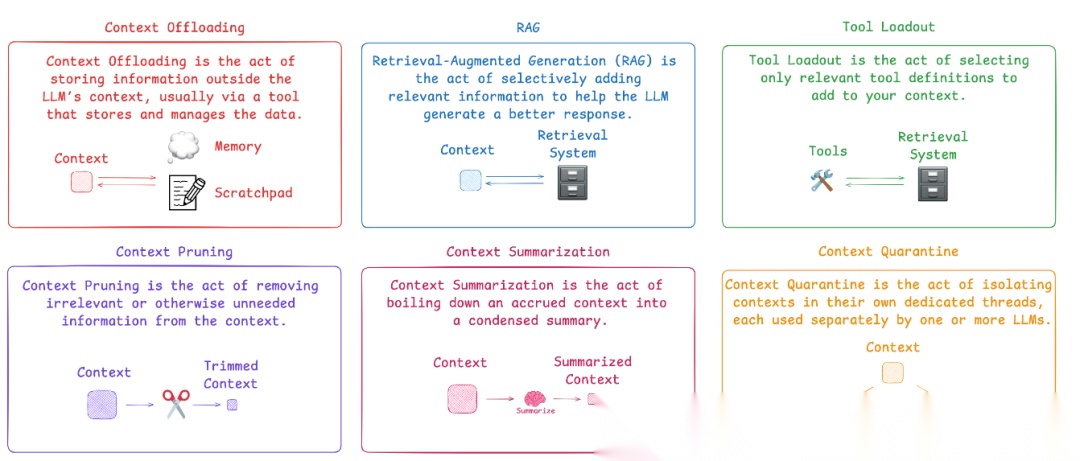

六个可落地的“减法动作”(配图版|[LangChain])

- RAG 精准检索(信息选择)

- 做什么:先界定检索范围,再从向量库取少量、干净的片段。不要把“所有资料”塞进上下文。

- 怎么控量:k=3~5 起步;严格控制 chunk 长度与重叠;必要时加 rerank。

- 落地要点:复杂查询可以接受 20k~25k token 的一次性成本,但回答阶段要只用“被证实相关”的片段。

RAG

- 工具装载(Tool Loadout,工具选择)

- 做什么:面向任务动态挑选少量工具再绑定给 Agent,避免 30+ 工具并发污染上下文。

- 参考做法:用向量库索引“工具描述”,先由小模型做“需要哪些能力”的草判,再语义检索出 top-5~10 工具装载。

- 经验阈值:≤10 个通常最稳;≥30 容易描述重叠与误用。

Tool Loadout

- 上下文隔离(Context Quarantine,流程解耦)

- 做什么:把可并行的子任务丢到各自的“独立上下文线程”里,最后再由 Supervisor 汇总。

- 好处:关注点分离、降低路径依赖;实际案例表明多智能体并行可带来显著性能提升。

- 注意:非并行任务不必强上多体,保持单体更稳定。

Context Quarantine

- 上下文修剪(Context Pruning,信息减重)

- 做什么:定期把无关/过期/重复的片段从上下文里清掉,保护核心指令与目标。

- 工具建议:轻量 reranker(如小模型或专用 rerank 模型)先过滤 80% 的冗余,再交给主模型。

- 指标:RAG 阶段 25k → 修剪到 ~11k,答案质量不降是理想上限。

Context Pruning

- 上下文摘要(Context Summarization,信息压缩)

- 做什么:把“都相关但太长”的材料,交给便宜模型做结构化摘要(保留要点、数据、结论)。

- 策略:先修剪后摘要;摘要目标压缩 50%~70%。

- 工程化:把摘要做成独立节点,便于离线评估与持续调优。

Context Summarization

- 上下文卸载(Context Offloading,信息外置)

- 做什么:把长链路工具输出、思考草稿、会话记忆写入“文件系统/外部存储”,主对话只带短提示与必要引用。

- 推荐形态:

- scratchpad(草稿本):记录推理/中间态,不进入主上下文;

- persistent store(持久化):跨会话的知识库与用户偏好。

- 与文件系统结合:以“单一接口”读/写/更新无限量上下文,查询时只把命中的小片段回填进对话。

Context Offload

最小可行架构(MVP|图解)

把“做减法”的策略固化到一条轻量流水线里:

- 接收请求 → 解析“任务类型、所需能力、信息范围”。

- 工具装载 → 语义检索出 ≤8 个相关工具再绑定。

- 检索阶段 → 先精确(grep/结构化索引),再语义拓展(embedding + rerank)。

- 修剪阶段 → 基于原始问题做针对性过滤,丢弃明显无关/重复片段。

- 摘要阶段 → 把仍然很长的材料交给便宜模型做 50%~70% 压缩。

- 生成阶段 → 主模型回答,严格引用检索/摘要材料。

- 卸载阶段 → 把中间结果、长文本、可复用知识写入文件系统,保存最小“引用指纹”。

注意:以上 7 步并非每次全跑。默认只启用 1/2/3/6,随着任务复杂度再“按需打开”4/5/7。

文件系统如何帮到 Agent(图解|[LangChain])

要点:把工具调用结果、长文档、推理草稿落盘;主上下文只保留必要摘要与引用指纹。检索时按需读回相关片段,避免上下文泛滥。

挑战→解法一览(文件系统路径|[LangChain])

补充图解:

细分来看,其分别想解决的点:

- Token 过多(retrieved context >> necessary context)

- 传统方式将工具调用结果、笔记全部存入对话历史,导致令牌冗余(如 10k token 的网页搜索结果全程占用对话资源)。

- 文件系统方案将大量工具结果写入文件系统,仅在需要时通过 grep 搜索关键词、读取必要上下文,本质是将文件系统作为“大型上下文草稿本”,降低费用与干扰。

- 需要大量上下文(necessary context > supported window)

- 存储长期任务计划:通过复述操控注意力的计划写入文件,后续随取随用。

- 存储子智能体知识:子体执行时将所学写入文件而非仅反馈主体,减少“电话游戏”式失真。

- 存储指令文件:把大量操作指令放入文件而非系统提示,避免提示臃肿。

- 查找小众信息(retrieved context ≠ necessary context)

- 借助 ls/glob/grep 进行结构化定位与全文检索,精确命中相关片段。

- 当前模型可理解文件系统遍历逻辑;文件系统按目录结构化存储,逻辑清晰。

- glob/grep 可定位特定文件、行、字符;read_file 可按行范围读取。

- 随时间学习(total context ≠ necessary context)

- 将“指令/技能”视为可编辑的上下文,存入文件系统并可更新。

- 用户反馈后,立即把关键信息(如姓名、邮箱、偏好)落盘,供后续会话使用。

渐进式落地路线(从“能用”到“好用”|看图做事)

Stage 0 基线:

- 单体 Agent + 少量手选工具(≤10)。

- 直接 RAG 检索 k=3~5;不做摘要/修剪;对话内引用片段原文。

Stage 1 做减法:

- 加入工具装载:动态选择工具并限制描述长度。

- 加入修剪:把明显无关的检索结果剔除。

- tokens 与时延即刻下降,稳定性提升。

Stage 2 降本增效:

- 在长材料上引入摘要节点(小模型),压缩 50%~70%。

- 引入文件系统卸载:工具长输出与草稿本不进主上下文。

Stage 3 并行加速(可选):

- 可并行任务引入上下文隔离的多体结构(Supervisor 汇总)。

- 严格控制每个子体工具/上下文规模,做到“并行不并乱”。

实证数据与量化指标(图表|[Cursor])

实证图 1(语义搜索与留存):

实证图 2(不满意追问下降):

来源:Cursor 语义搜索 A/B 实验与工程报告(https://cursor.com/cn/blog/semsearch)。

指标与报警建议:

- token 成本:按阶段与会话维度统计;设置软/硬阈值(如 8k/16k)。

- 工具面板规模:单次绑定工具数 ≤10;超过报警并落盘分析。

- 检索有效率:被最终引用的片段占检索结果比例 ≥50%。

- 语义搜索开关 A/B:观察代码留存率、不满意请求率变化(目标:留存↑,不满意↓)。

- 回答一致性:跨多轮是否自洽,无自我矛盾与目标漂移。

常见反模式(看到就删)

- “窗口大=一次性全塞”:容易中毒、干扰、混淆、冲突并发作。

- “工具越多越聪明”:≥30 个工具常引发描述重叠与误用。

- “链越长越强大”:长链路更应把中间态卸载到外部;主对话只带摘要。

- “全部在线推”:摘要/修剪/重排可以异步或缓存,别把延迟都放一条链里。

结语

做 Agent 不是“加法竞赛”,而是“减法艺术”。

把信息、工具、流程都减到“必要且充分”,再用文件系统把“长材料与中间态”卸载到对话之外——你的 Agent 会更稳、更快、更省,也更容易在真实业务里长期留存与复用。

Less, but better. 先做减法,再谈进化。

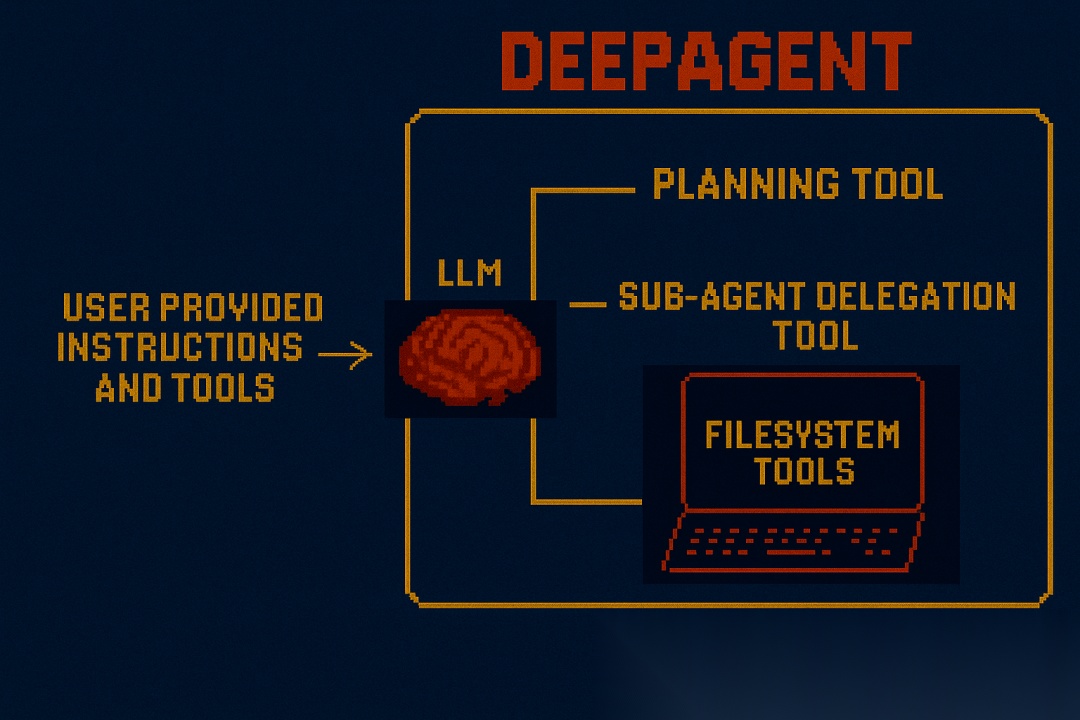

开源项目(索引|[LangChain])

-

DeepAgents:https://github.com/langchain-ai/deepagents

-

how_to_fix_your_context(实践 Notebook 合集):https://github.com/langchain-ai/how_to_fix_your_context

-

DeepAgents 工具示意:

DeepAgents 工具示意

如何学习AI大模型 ?

“最先掌握AI的人,将会晚掌握AI的人有竞争优势,晚掌握AI的人比完全不会AI的人竞争优势更大”。 在这个技术日新月异的时代,不会新技能或者说落后就要挨打。

老蓝我作为一名在一线互联网企业(保密不方便透露)工作十余年,指导过不少同行后辈。帮助很多人得到了学习和成长。

我是非常希望可以把知识和技术分享给大家,但苦于传播途径有限,很多互联网行业的朋友无法获得正确的籽料得到学习的提升,所以也是整理了一份AI大模型籽料包括:AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、落地项目实战等 免费分享出来。

- AI大模型学习路线图

- 100套AI大模型商业化落地方案

- 100集大模型视频教程

- 200本大模型PDF书籍

- LLM面试题合集

- AI产品经理资源合集

大模型学习路线

想要学习一门新技术,你最先应该开始看的就是学习路线图,而下方这张超详细的学习路线图,按照这个路线进行学习,学完成为一名大模型算法工程师,拿个20k、15薪那是轻轻松松!

视频教程

首先是建议零基础的小伙伴通过视频教程来学习,其中这里给大家分享一份与上面成长路线&学习计划相对应的视频教程。文末有整合包的领取方式

技术书籍籽料

当然,当你入门之后,仅仅是视频教程已经不能满足你的需求了,这里也分享一份我学习期间整理的大模型入门书籍籽料。文末有整合包的领取方式

大模型实际应用报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。文末有整合包的领取方式

大模型落地应用案例PPT

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。文末有整合包的领取方式

大模型面试题&答案

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。文末有整合包的领取方式

领取方式

这份完整版的 AI大模型学习籽料我已经上传CSDN,需要的同学可以微⭐扫描下方CSDN官方认证二维码免费领取!

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)