一文通透大模型微调 (Fine-Tuning)

模型微调不仅是模型“听懂你”的第一步,更是企业打造私有智能体的核心环节。懂得 Prompt 是入门,会微调,才是真正走向 AI 工程师的开始。大模型微调技术已经成为人工智能领域的核心技术之一,它使预训练模型能够更好地适应各种特定任务和领域。从全量微调到参数高效微调,再到指令微调,技术的不断进步使我们能够在资源有限的情况下获得更好的模型性能。在实际应用中,选择合适的微调技术需要综合考虑模型大小、数据

一文通透大模型微调 (Fine-Tuning)

懂得 Prompt 是入门,会微调,才是真正走向 AI 工程师的开始。

一、引言

在人工智能领域,大模型(如 GPT、Llama、BERT 等)的出现标志着自然语言处理技术的重大突破。然而,这些预训练模型往往需要针对特定任务或领域进行调整才能发挥最佳性能,这就引出了我们今天的核心主题 —— 大模型微调 (Fine-Tuning)。

1.1 为什么需要微调?

虽然像 GPT-4、LLaMA、Baichuan、ChatGLM 这样的预训练大语言模型(LLMs)已经拥有通用知识和语言能力,但在企业实际的业务中还面临以下挑战:

- 知识更新不及时:模型参数中未包含特定领域的新知识。

- 指令不符合业务语境:通用模型不懂企业内部“特有问法”。

- 交互风格无法控制:需要特定语气、格式、术语。

- 推理逻辑不完整:复杂任务需要多轮/多步业务逻辑支持。

✅ 微调的目的:让通用大模型专注你企业的业务语义、行为风格、决策逻辑。

通俗来说,就是预训练模型虽然强大,但它们通常是在通用语料库上训练的,无法直接满足企业的特定需求。例如:

- 医疗领域需要处理专业术语和病历数据

- 金融行业需要分析市场动态和财报文本

- 客服场景需要理解特定领域的用户问题

通过微调,我们可以将预训练模型的知识迁移到这些特定领域,大幅提高模型在目标任务上的表现。

1.2 微调技术的发展历程

微调技术从最初的全量微调逐渐发展到参数高效微调 (PEFT),经历了多个阶段:

- 全量微调:早期方法,更新模型的所有参数,但计算成本高

- 指令微调(Instruction tuning):通过指令数据让模型理解并执行各种任务

- 参数高效微调 (PEFT):只更新少量参数,大幅降低计算成本

- Adapter Tuning:添加小型适配器模块进行微调

- Prefix Tuning/P-Tuning:在输入前添加可训练的前缀或提示

- LoRA:低秩适应,通过低秩矩阵更新权重矩阵

┌────────────┐

│ 原始大模型 │

└─────┬──────┘

▼

┌───────────────┐

│ 全量微调 (Full)│ 🚨最耗资源

└──────┬────────┘

▼

┌────────────────────────────┐

│ 指令微调 (Instruction tuning) │ 🤖对话、RAG推荐使用

└──────┬─────────────────────┘

▼

┌────────────────────────────────────┐

│ 参数高效微调(PEFT) │

└──────────────┬────────────────────┘

▼

┌────────────┬────────────┬──────────────┐

│ P-Tuning │ Prefix-Tuning│ LoRA │

└────────────┴────────────┴──────────────┘

二、大模型微调的理论基础

2.1 微调的基本原理

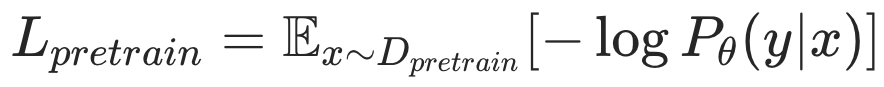

大模型微调的核心思想是在预训练模型的基础上,使用特定领域或任务的数据进一步训练模型。从数学角度看,预训练阶段优化的是通用语料库上的损失函数:

而微调阶段则优化特定任务或领域的损失函数:

其中, θ θ θ是模型参数, x x x和 y y y分别是输入和输出, D p r e t r a i n D_{pretrain} Dpretrain 和 D f i n e t u n e D_{finetune} Dfinetune 分别是预训练和微调数据集。

2.2 微调中的关键挑战

尽管微调技术很有效,但也面临一些挑战:

- 灾难性遗忘:模型在微调过程中可能会忘记预训练阶段学到的知识

- 过拟合:如果微调数据集较小,模型可能会过拟合

- 计算资源需求:全量微调需要大量 GPU 资源和时间

- 参数效率:如何用最少的参数调整获得最佳性能

2.3 Huggingface PEFT 统一框架示意图

我们在本文后续部分内容的实现上基于Huggingface提供的框架。框架的封装方式如下:

┌───────────────┐

│ Base Model │

└──────┬────────┘

▼

┌────────────┬────────────┬───────────────┐

│ P-Tuning │ PrefixTune │ LoRA │

└────────────┴────────────┴───────────────┘

▼

HuggingFace PEFT框架统一封装

三、重要论文推荐

在深入学习微调技术之前,让我们先看看为这些技术提供理论支撑的重要论文,这些论文涵盖了大模型和微调技术的关键发展,建议大家深入研读以建立扎实的理论基础:

| 论文标题 | 简介 | 论文地址 |

|---|---|---|

| 《Attention Is All You Need》 | 提出 Transformer 架构,是现代大模型的基础 | https://arxiv.org/abs/1706.03762 |

| 《Language Models are Few-Shot Learners》 | GPT-3 开山之作,提出Few-shot Prompting | https://arxiv.org/abs/2005.14165 |

| Fine-Tuning Language Models from Human Preferences | RLHF思路提出,用人类反馈微调模型行为 | https://arxiv.org/abs/1909.08593 |

| Scaling Instruction-Finetuned Language Models | FLAN-T5微调全景指南,指令微调重要基础 | https://arxiv.org/abs/2210.11416 |

| 《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》 | 介绍 BERT 模型和预训练 - 微调范式 | https://arxiv.org/abs/1810.04805 |

| 《GPT: Improving Language Understanding by Generative Pre-Training》 | GPT 系列的首篇论文,引入生成式预训练 | https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf |

| 《LoRA: Low-Rank Adaptation of Large Language Models》 | 提出低秩适应方法,大幅降低微调成本 | https://arxiv.org/abs/2106.09685 |

| 《Prefix-Tuning: Optimizing Continuous Prompts for Generation》 | 介绍 Prefix Tuning 方法,通过优化前缀提示微调模型 | https://arxiv.org/abs/2101.00190 |

| 《P-Tuning: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks》 | 提出 P-tuning 方法,使用可训练的连续提示 | https://arxiv.org/abs/2110.07602 |

| P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning | 腾讯提出的新型轻量微调方法,效果优越 | https://arxiv.org/abs/2110.07602 |

| 《Scaling Instruction-Finetuned Language Models》 | 探讨指令微调的扩展性和有效性 | https://arxiv.org/abs/2210.11416 |

| 《Parameter-Efficient Transfer Learning for NLP》 | 提出 Adapter Tuning 方法,通过添加小型适配器模块进行微调 | https://arxiv.org/abs/1902.00751 |

| 《QLoRA: Efficient Finetuning of Quantized LLMs》 | 结合量化和 LoRA,进一步降低微调成本 | https://arxiv.org/abs/2305.14314 |

四、全量微调 (Full Fine-Tuning)

4.1 原理与特点

全量微调是最直接的微调方法,它更新预训练模型的所有参数。这种方法的优点是可以充分利用预训练模型的知识,通常能获得最好的性能。然而,它也有明显的缺点:

- 需要大量计算资源和内存

- 训练时间长

- 容易过拟合,特别是在小数据集上

4.2 实现示例

下面我们用一个简单的例子来演示如何使用 PyTorch 和 Transformers 库进行全量微调。我们将使用 BERT 模型进行文本分类任务。

首先,让我们安装必要的库:

pip install transformers datasets torch

接下来是完整的实现代码:

import torch

from torch.utils.data import DataLoader, Dataset

from transformers import BertTokenizer, BertForSequenceClassification, AdamW

from datasets import load_dataset

from tqdm import tqdm

import numpy as np

from sklearn.metrics import accuracy_score

# 设置设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载数据集

def load_data():

# 加载IMDB影评数据集,这是一个情感分类任务

dataset = load_dataset("imdb")

return dataset

# 数据预处理

class IMDBDataset(Dataset):

def __init__(self, texts, labels, tokenizer, max_length=128):

self.texts = texts

self.labels = labels

self.tokenizer = tokenizer

self.max_length = max_length

def __len__(self):

return len(self.texts)

def __getitem__(self, idx):

text = self.texts[idx]

label = self.labels[idx]

# 使用tokenizer对文本进行编码

encoding = self.tokenizer.encode_plus(

text,

add_special_tokens=True,

max_length=self.max_length,

padding="max_length",

truncation=True,

return_tensors="pt"

)

# 返回编码后的输入和标签

return {

'input_ids': encoding['input_ids'].flatten(),

'attention_mask': encoding['attention_mask'].flatten(),

'label': torch.tensor(label, dtype=torch.long)

}

# 训练函数

def train(model, train_dataloader, optimizer, device, epochs):

model.train()

for epoch in range(epochs):

total_loss = 0

progress_bar = tqdm(enumerate(train_dataloader), total=len(train_dataloader))

for step, batch in progress_bar:

# 将数据移到设备上

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['label'].to(device)

# 前向传播

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

total_loss += loss.item()

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 更新进度条

progress_bar.set_description(f'Epoch {epoch+1}/{epochs}, Loss: {total_loss/(step+1):.4f}')

return model

# 评估函数

def evaluate(model, dataloader, device):

model.eval()

predictions = []

true_labels = []

with torch.no_grad():

for batch in dataloader:

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['label'].to(device)

outputs = model(input_ids, attention_mask=attention_mask)

logits = outputs.logits

preds = torch.argmax(logits, dim=1)

predictions.extend(preds.cpu().numpy())

true_labels.extend(labels.cpu().numpy())

# 计算准确率

accuracy = accuracy_score(true_labels, predictions)

print(f'Accuracy: {accuracy:.4f}')

return accuracy

# 主函数

def main():

# 加载预训练模型和tokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(

model_name,

num_labels=2 # 二分类任务

)

model.to(device)

# 加载数据

dataset = load_data()

# 准备训练和验证数据集

train_dataset = IMDBDataset(

dataset['train']['text'],

dataset['train']['label'],

tokenizer

)

val_dataset = IMDBDataset(

dataset['test']['text'],

dataset['test']['label'],

tokenizer

)

# 创建数据加载器

train_dataloader = DataLoader(train_dataset, batch_size=16, shuffle=True)

val_dataloader = DataLoader(val_dataset, batch_size=16)

# 定义优化器

optimizer = AdamW(model.parameters(), lr=2e-5)

# 训练模型

model = train(model, train_dataloader, optimizer, device, epochs=3)

# 评估模型

evaluate(model, val_dataloader, device)

# 保存微调后的模型

model.save_pretrained('fine-tuned-bert-imdb')

tokenizer.save_pretrained('fine-tuned-bert-imdb')

if __name__ == "__main__":

main()

4.3 代码解释

上面的代码实现了一个完整的 BERT 模型全量微调过程:

- 数据加载:使用 Hugging Face 的 datasets 库加载 IMDB 影评数据集,这是一个经典的情感分类任务

- 数据预处理:创建一个自定义数据集类,使用 BERT tokenizer 对文本进行编码,添加特殊标记,截断和填充文本到固定长度

- 模型初始化:加载预训练的 BERT 模型和 tokenizer,并为分类任务添加一个输出层

- 训练循环:实现标准的训练循环,包括前向传播、计算损失、反向传播和参数更新

- 模型评估:在验证集上评估模型性能

- 模型保存:保存微调后的模型和 tokenizer,以便后续使用

全量微调虽然简单直接,但在处理大型模型时会面临严重的资源限制。接下来,我们将介绍几种参数高效的微调方法,它们可以在大幅减少计算资源需求的情况下取得接近全量微调的性能。

五、参数高效微调 (PEFT) 技术

5.1 为什么需要参数高效微调?

全量微调的主要问题是需要更新模型的所有参数,这对于数十亿甚至数万亿参数的大型模型来说是不可行的。参数高效微调 (Parameter-Efficient Fine-Tuning, PEFT) 技术通过只更新少量参数来解决这个问题,大幅降低了计算和存储成本。

5.2 LoRA (Low-Rank Adaptation)

5.2.1 原理

LoRA 是一种流行的参数高效微调方法,由微软研究院在 2021 年提出。其核心思想是通过低秩矩阵分解来近似权重矩阵的变化,从而大幅减少可训练参数的数量。

具体来说,LoRA 不直接更新原始权重矩阵W,而是引入两个低秩矩阵A和B,使得权重更新为:

W ′ = W + Δ W = W + B A W′=W+ΔW=W+BA W′=W+ΔW=W+BA

其中, B B B的形状为 ( d × r ) (d×r) (d×r), A A A的形状为 ( r × k ) (r×k) (r×k), r r r是秩参数,通常远小于 d d d和 k k k。这样,可训练参数的数量从 d × k d×k d×k减少到 r × ( d + k ) r×(d+k) r×(d+k),大大降低了计算成本。

5.2.2 实现示例

下面是使用 Hugging Face 的 PEFT 库实现 LoRA 微调的示例代码:

import os

import torch

from datasets import load_dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

TrainingArguments,

Trainer,

DataCollatorForLanguageModeling,

)

from peft import LoraConfig, get_peft_model, prepare_model_for_kbit_training

# 设置设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载数据集

def load_data():

# 加载一个小的文本数据集用于演示

dataset = load_dataset("wikitext", "wikitext-2-raw-v1")

return dataset

# 数据预处理

def preprocess_data(dataset, tokenizer):

def tokenize_function(examples):

return tokenizer(examples["text"], padding="max_length", truncation=True, max_length=128)

tokenized_datasets = dataset.map(tokenize_function, batched=True)

tokenized_datasets = tokenized_datasets.remove_columns(["text"])

tokenized_datasets.set_format("torch")

return tokenized_datasets

# 主函数

def main():

# 加载预训练模型和tokenizer

model_name = "gpt2" # 使用较小的GPT-2模型进行演示

tokenizer = AutoTokenizer.from_pretrained(model_name)

tokenizer.pad_token = tokenizer.eos_token

# 加载模型

model = AutoModelForCausalLM.from_pretrained(

model_name,

load_in_8bit=True, # 使用8位量化以减少内存使用

device_map="auto",

)

# 准备模型进行训练

model = prepare_model_for_kbit_training(model)

# 定义LoRA配置

lora_config = LoraConfig(

r=8, # 低秩矩阵的秩

lora_alpha=32, # LoRA缩放因子

target_modules=["c_attn", "c_proj"], # 要应用LoRA的模块名称

lora_dropout=0.1, # Dropout概率

bias="none", # 是否训练偏置

task_type="CAUSAL_LM", # 任务类型

)

# 将模型转换为LoRA模型

model = get_peft_model(model, lora_config)

# 打印可训练参数

model.print_trainable_parameters()

# 加载和预处理数据

dataset = load_data()

tokenized_datasets = preprocess_data(dataset, tokenizer)

# 定义训练参数

training_args = TrainingArguments(

output_dir="./results",

learning_rate=3e-4,

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=3,

weight_decay=0.01,

evaluation_strategy="epoch",

save_strategy="epoch",

logging_dir="./logs",

)

# 创建数据收集器

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False)

# 创建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

data_collator=data_collator,

)

# 训练模型

trainer.train()

# 保存模型

model.save_pretrained("lora-gpt2")

if __name__ == "__main__":

main()

5.2.3 代码解释

上面的代码展示了如何使用 LoRA 对 GPT-2 模型进行微调:

- 模型加载:加载预训练的 GPT-2 模型,并使用 8 位量化减少内存使用

- LoRA 配置:定义 LoRA 参数,包括秩 (r=8)、缩放因子 (alpha=32) 和要应用 LoRA 的目标模块

- 模型转换:使用

get_peft_model将原始模型转换为 LoRA 模型 - 数据处理:加载 WikiText 数据集并进行分词处理

- 训练过程:使用 Hugging Face 的 Trainer API 进行训练

- 模型保存:保存微调后的 LoRA 模型,注意这里只保存了 LoRA 参数,原始模型参数可以在推理时复用

5.3 Prefix Tuning

5.3.1 原理

Prefix Tuning 是另一种参数高效微调方法,由 Google 在 2021 年提出。与 LoRA 不同,Prefix Tuning 不直接修改模型权重,而是在输入序列前添加可训练的连续向量 (prefix),让模型学习特定任务的提示。

对于 Transformer 模型,Prefix Tuning 只训练这些 prefix 向量,而保持模型的其他参数不变。这大大减少了可训练参数的数量,同时保持了模型的表达能力。

5.3.2 实现示例

下面是使用 PEFT 库实现 Prefix Tuning 的示例代码:

import os

import torch

from datasets import load_dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

TrainingArguments,

Trainer,

DataCollatorForLanguageModeling,

)

from peft import PrefixTuningConfig, get_peft_model

# 设置设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载数据集

def load_data():

# 加载一个小的文本数据集用于演示

dataset = load_dataset("wikitext", "wikitext-2-raw-v1")

return dataset

# 数据预处理

def preprocess_data(dataset, tokenizer):

def tokenize_function(examples):

return tokenizer(examples["text"], padding="max_length", truncation=True, max_length=128)

tokenized_datasets = dataset.map(tokenize_function, batched=True)

tokenized_datasets = tokenized_datasets.remove_columns(["text"])

tokenized_datasets.set_format("torch")

return tokenized_datasets

# 主函数

def main():

# 加载预训练模型和tokenizer

model_name = "gpt2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

tokenizer.pad_token = tokenizer.eos_token

# 加载模型

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

)

# 定义Prefix Tuning配置

config = PrefixTuningConfig(

task_type="CAUSAL_LM",

num_virtual_tokens=30, # 前缀token的数量

encoder_hidden_size=768, # 隐藏层大小

prefix_projection=True, # 是否使用投影层

projection_hidden_size=512, # 投影层隐藏大小

)

# 将模型转换为Prefix Tuning模型

model = get_peft_model(model, config)

# 打印可训练参数

model.print_trainable_parameters()

# 加载和预处理数据

dataset = load_data()

tokenized_datasets = preprocess_data(dataset, tokenizer)

# 定义训练参数

training_args = TrainingArguments(

output_dir="./results_prefix",

learning_rate=3e-4,

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=3,

weight_decay=0.01,

evaluation_strategy="epoch",

save_strategy="epoch",

logging_dir="./logs_prefix",

)

# 创建数据收集器

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False)

# 创建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

data_collator=data_collator,

)

# 训练模型

trainer.train()

# 保存模型

model.save_pretrained("prefix-tuning-gpt2")

if __name__ == "__main__":

main()

5.3.3 代码解释

这个 Prefix Tuning 实现与 LoRA 类似,但有几个关键区别:

- 配置不同:使用

PrefixTuningConfig定义前缀的参数,包括虚拟 token 数量和是否使用投影层 - 训练方式:只训练添加的前缀参数,而保持模型主体不变

- 应用场景:Prefix Tuning 特别适合生成任务,因为它通过修改输入提示来引导模型生成

5.4 Adapter Tuning

5.4.1 原理

Adapter Tuning 是由 Houlsby 等人在 2019 年提出的一种参数高效微调方法。其核心思想是在 Transformer 的每一层添加小型的 “adapter” 模块,只训练这些 adapter 而保持原始模型参数不变。

每个 adapter 通常由两个全连接层组成:一个降维层和一个升维层,中间插入一个非线性激活函数。这种结构允许模型在保持预训练知识的同时学习特定任务的表示。

5.4.2 实现示例

下面是使用 AdapterHub 库实现 Adapter Tuning 的示例代码:

import torch

from datasets import load_dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

TrainingArguments,

AdapterTrainer,

DataCollatorForLanguageModeling,

)

# 设置设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载数据集

def load_data():

dataset = load_dataset("wikitext", "wikitext-2-raw-v1")

return dataset

# 数据预处理

def preprocess_data(dataset, tokenizer):

def tokenize_function(examples):

return tokenizer(examples["text"], padding="max_length", truncation=True, max_length=128)

tokenized_datasets = dataset.map(tokenize_function, batched=True)

tokenized_datasets = tokenized_datasets.remove_columns(["text"])

tokenized_datasets.set_format("torch")

return tokenized_datasets

# 主函数

def main():

# 加载预训练模型和tokenizer

model_name = "gpt2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

tokenizer.pad_token = tokenizer.eos_token

# 加载模型

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

)

# 添加语言建模适配器

model.add_adapter("language_modeling")

# 设置适配器为活动适配器

model.train_adapter("language_modeling")

# 加载和预处理数据

dataset = load_data()

tokenized_datasets = preprocess_data(dataset, tokenizer)

# 定义训练参数

training_args = TrainingArguments(

output_dir="./results_adapter",

learning_rate=3e-4,

per_device_train_batch_size=4,

per_device_eval_batch_size=4,

num_train_epochs=3,

weight_decay=0.01,

evaluation_strategy="epoch",

save_strategy="epoch",

logging_dir="./logs_adapter",

)

# 创建数据收集器

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False)

# 创建AdapterTrainer

trainer = AdapterTrainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

data_collator=data_collator,

)

# 训练模型

trainer.train()

# 保存适配器

model.save_adapter("./adapter_gpt2", "language_modeling")

if __name__ == "__main__":

main()

5.4.3 代码解释

Adapter Tuning 的实现相对简单:

- 添加适配器:使用

add_adapter方法在模型中添加适配器 - 设置训练模式:使用

train_adapter方法设置只训练适配器参数 - 训练和保存:使用 AdapterTrainer 进行训练,并单独保存适配器参数

Adapter Tuning 的优点是可以为不同任务保存多个适配器,而共享同一个基础模型,大大节省了存储空间。

六、指令微调 (Instruction Tuning)

6.1 原理

指令微调是一种特殊的微调技术,它使用包含任务指令的数据集来训练模型,使模型能够理解并执行各种自然语言指令。这种方法在提高模型的泛化能力和多任务处理能力方面非常有效。

指令微调的关键思想是将各种任务转换为指令 - 响应格式,例如:

- 指令:“将下面的文本翻译成法语”

- 输入:“Hello, how are you?”

- 输出:“Bonjour, comment ça va?”

通过这种方式,模型可以学习到如何遵循指令并执行各种任务,而不仅仅是特定类型的任务。

6.2 实现示例

下面是一个简单的指令微调实现示例:

import os

import torch

from datasets import load_dataset, Dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

TrainingArguments,

Trainer,

DataCollatorForLanguageModeling,

)

from peft import LoraConfig, get_peft_model

# 设置设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 创建指令数据集

def create_instruction_dataset():

# 这里我们创建一个简单的指令数据集示例

# 实际应用中,你可能需要收集或下载更大的指令数据集

data = [

{

"instruction": "将下面的文本翻译成法语",

"input": "Hello, how are you?",

"output": "Bonjour, comment ça va?"

},

{

"instruction": "总结下面的文本",

"input": "Natural language processing (NLP) is a subfield of artificial intelligence...",

"output": "NLP是人工智能的一个子领域,专注于使计算机能够理解和生成人类语言。"

},

{

"instruction": "生成一个描述猫的段落",

"input": "",

"output": "猫是小型哺乳动物,通常作为宠物饲养。它们以其独立性、敏捷性和好奇心而闻名..."

},

{

"instruction": "回答问题",

"input": "什么是机器学习?",

"output": "机器学习是人工智能的一个分支,它使用统计技术使计算机系统能够从数据中学习..."

}

]

# 创建数据集

dataset = Dataset.from_list(data)

return dataset

# 数据预处理

def preprocess_instructions(dataset, tokenizer, max_length=512):

def tokenize_function(examples):

# 构建指令+输入文本

texts = []

for instruction, input_text in zip(examples["instruction"], examples["input"]):

if input_text:

text = f"指令: {instruction}\n输入: {input_text}\n输出: "

else:

text = f"指令: {instruction}\n输出: "

texts.append(text)

# 编码指令文本

model_inputs = tokenizer(texts, max_length=max_length, truncation=True)

# 编码目标文本(输出)

labels = tokenizer(examples["output"], max_length=max_length, truncation=True)

model_inputs["labels"] = labels["input_ids"]

return model_inputs

tokenized_datasets = dataset.map(tokenize_function, batched=True)

return tokenized_datasets

# 主函数

def main():

# 加载预训练模型和tokenizer

model_name = "gpt2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

tokenizer.pad_token = tokenizer.eos_token

# 加载模型

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

)

# 定义LoRA配置(用于参数高效微调)

lora_config = LoraConfig(

r=8,

lora_alpha=32,

target_modules=["c_attn", "c_proj"],

lora_dropout=0.1,

bias="none",

task_type="CAUSAL_LM",

)

# 将模型转换为LoRA模型

model = get_peft_model(model, lora_config)

# 创建和预处理指令数据集

instruction_dataset = create_instruction_dataset()

tokenized_dataset = preprocess_instructions(instruction_dataset, tokenizer)

# 定义训练参数

training_args = TrainingArguments(

output_dir="./results_instruction",

learning_rate=3e-4,

per_device_train_batch_size=4,

num_train_epochs=10, # 由于数据集小,增加训练轮次

weight_decay=0.01,

logging_dir="./logs_instruction",

logging_steps=1,

save_strategy="no", # 由于数据集小,不保存中间检查点

)

# 创建数据收集器

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False)

# 创建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset,

data_collator=data_collator,

)

# 训练模型

trainer.train()

# 保存微调后的模型

model.save_pretrained("instruction-tuned-gpt2")

if __name__ == "__main__":

main()

6.3 代码解释

这个指令微调实现有几个关键部分:

- 指令数据集创建:我们创建了一个包含多种任务的小型指令数据集,每个样本包含指令、输入和输出

- 数据预处理:将指令和输入组合成模型输入,同时准备目标输出

- 模型微调:使用 LoRA 进行参数高效微调,使模型能够学习遵循指令

- 推理使用:微调后的模型可以通过提供指令来执行各种任务,例如翻译、摘要、问答等

指令微调是当前大模型研究的热点之一,它使模型能够更加灵活地应用于各种场景,而不需要为每个任务单独训练模型。

七、微调技术对比与选择

7.1 不同微调技术的性能对比

不同的微调技术在参数效率、性能和计算成本方面各有优劣。根据最近的研究,我们可以总结出以下对比:

| 技术 | 可训练参数比例 | 计算成本 | 性能 | 适用场景 |

|---|---|---|---|---|

| 全量微调 | 100% | 高 | 最佳 | 数据充足、资源充足的场景 |

| LoRA | 0.01%-0.1% | 低 | 接近全量微调 | 大多数场景,特别是大型模型 |

| Prefix Tuning | 0.01%-0.1% | 低 | 良好 | 生成任务 |

| Adapter Tuning | 0.1%-1% | 中 | 良好 | 多任务学习,需要保存多个适配器 |

| 指令微调 | 可变 | 可变 | 提高泛化能力 | 需要模型执行多种任务的场景 |

7.2 如何选择合适的微调技术

在实际应用中,选择合适的微调技术需要考虑以下因素:

- 模型大小:对于大型模型(数十亿参数以上),推荐使用参数高效方法如 LoRA 或 Prefix Tuning

- 数据量:如果数据量有限,全量微调可能导致过拟合,考虑使用参数高效方法

- 任务类型:生成任务可能更适合 Prefix Tuning,而分类任务可能更适合 LoRA

- 资源限制:如果计算资源有限,优先选择参数高效方法

- 灵活性需求:如果需要模型处理多种任务,考虑使用指令微调

- 存储需求:如果需要为不同任务保存多个模型版本,Adapter Tuning 是一个不错的选择

| 应用场景 | 推荐方式 | 理由 |

|---|---|---|

| 通用对话系统 | 指令微调 + LoRA | 控制语调、风格、响应策略 |

| 结构化文档处理 | Prefix-Tuning / P-Tuning | 微调字段解析、格式抽取能力 |

| 内部RAG系统 | 指令微调 + Retriever优化 | 对接向量数据库,增强知识检索 |

| 私有模型能力增强 | 全量微调 | 控制全部行为,适合小模型 |

| 中英文多语种切换 | LoRA + 语言提示微调 | 插件化管理不同语种适配模块 |

八、企业级应用案例

8.1 智能客服系统

许多企业使用大模型微调来改进其智能客服系统。例如,一家电商公司可能使用指令微调训练一个模型,使其能够:

- 回答产品相关问题

- 处理订单查询和退款请求

- 提供个性化推荐

- 解决常见技术问题

通过微调,模型可以更好地理解和处理特定领域的客户问题,提高客户满意度和服务效率。

8.2 金融文本分析

在金融领域,大模型微调可用于:

- 分析财报和新闻,提取关键信息

- 预测市场趋势

- 进行风险评估

- 自动化报告生成

例如,一家投资公司可能微调一个大型语言模型,使其能够理解金融术语和市场动态,从而辅助投资决策。

8.3 医疗领域应用

医疗行业也开始利用大模型微调技术:

- 分析病历和诊断报告

- 辅助医学研究

- 提供健康咨询

- 药物发现

微调后的模型可以理解医学专业术语,处理复杂的医疗文本,为医生和研究人员提供支持。

8.4 多语言翻译系统

对于全球化企业,多语言支持至关重要。通过微调,企业可以创建高性能的多语言翻译系统,能够处理特定领域的专业术语和表达方式。

例如,一家跨国公司可能微调一个大型语言模型,使其能够准确翻译技术文档、法律合同和营销材料等。

九、总结与展望

模型微调不仅是模型“听懂你”的第一步,更是企业打造私有智能体的核心环节。懂得 Prompt 是入门,会微调,才是真正走向 AI 工程师的开始。

大模型微调技术已经成为人工智能领域的核心技术之一,它使预训练模型能够更好地适应各种特定任务和领域。从全量微调到参数高效微调,再到指令微调,技术的不断进步使我们能够在资源有限的情况下获得更好的模型性能。

在实际应用中,选择合适的微调技术需要综合考虑模型大小、数据量、任务类型和资源限制等因素。企业可以根据自身需求,利用微调技术构建高性能的 AI 系统,解决实际业务问题。

展望未来,大模型微调技术可能会朝着以下方向发展:

- 更高效的微调方法:继续降低计算成本,提高参数效率

- 自动化微调工具:简化微调过程,降低技术门槛

- 多模态微调:扩展到图像、音频等多种模态

- 混合专家模型:结合不同模型的优势,实现更强大的性能

- 个性化微调:根据用户需求,实现模型的个性化定制

十、参考文献

- Vaswani, A., et al. (2017). “Attention Is All You Need.” arXiv:1706.03762.

- Devlin, J., et al. (2018). “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding.” arXiv:1810.04805.

- Radford, A., et al. (2018). “Improving Language Understanding by Generative Pre-Training.”

- Hu, Z., et al. (2021). “LoRA: Low-Rank Adaptation of Large Language Models.” arXiv:2106.09685.

- Li, X., & Liang, P. (2021). “Prefix-Tuning: Optimizing Continuous Prompts for Generation.” arXiv:2101.00190.

- Gao, T., et al. (2021). “P-Tuning: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks.” arXiv:2110.07602.

- Chung, H. W., et al. (2022). “Scaling Instruction-Finetuned Language Models.” arXiv:2210.11416.

- Houlsby, N., et al. (2019). “Parameter-Efficient Transfer Learning for NLP.” arXiv:1902.00751.

- Dou, Z., et al. (2023). “QLoRA: Efficient Finetuning of Quantized LLMs.” arXiv:2305.14314.

- Hugging Face Documentation. (2023). Retrieved fromhttps://huggingface.co/docs

- PEFT Documentation. (2023). Retrieved fromhttps://huggingface.co/docs/peft

- AdapterHub Documentation. (2023). Retrieved fromhttps://docs.adapterhub.ml

🤗 **手写不易,辛苦点赞收藏鼓励一下吧 **🤗

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)