机器人如何“看懂”人类动作:CFG-Bench打开精细动作理解新范式

【摘要】CFG-Bench提出一套四层递进式认知框架,通过极精细标注与反事实测试,系统性评测并提升AI对物理动作的深度理解能力,为具身智能体在真实世界的复杂任务执行奠定基础。

【摘要】CFG-Bench提出一套四层递进式认知框架,通过极精细标注与反事实测试,系统性评测并提升AI对物理动作的深度理解能力,为具身智能体在真实世界的复杂任务执行奠定基础。

引言

在具身智能(Embodied AI)领域,我们长期面对一个核心挑战,即如何让机器真正理解物理世界的动态交互。当前的多模态大模型(MLLMs)在内容识别上取得了显著进展。它们可以轻易地为一个视频片段打上标签,例如“一个人正在切西瓜”。这种能力,本质上是一种分类或描述任务。它回答了“是什么”的问题,却在更深层次的认知维度上显得力不从心。

人类观察一个动作时,认知过程远比识别复杂。我们不仅看到“切西瓜”,还能瞬间解析出操作者的手法(左手如何扶稳,右手如何运刀)、因果逻辑(先稳定瓜体再下刀,防止滚动)、潜在意图(是为了立即食用还是为了雕刻摆盘),甚至能对动作的质量做出评价(这一刀是否干脆利落,是否安全高效)。这种涵盖了“如何做”、“为何做”与“做得好不好”的精细化理解,是当前AI技术与人类智能之间的一道巨大鸿沟。

这个鸿沟直接导致了机器人在物理世界中的“眼高手低”。模型在虚拟环境中或许能生成流畅的文本或图像,但当需要驱动一个机械臂完成精细的物理操作时,其表现往往差强人意。这背后反映的正是人工智能领域一个经典的难题——莫拉维克悖论(Moravec's Paradox)。该悖论指出,对人类而言轻而易举的感知和运动技能,对AI系统来说却极难实现;反之,需要高阶抽象推理能力的任务(如下棋),AI却能轻松超越人类。

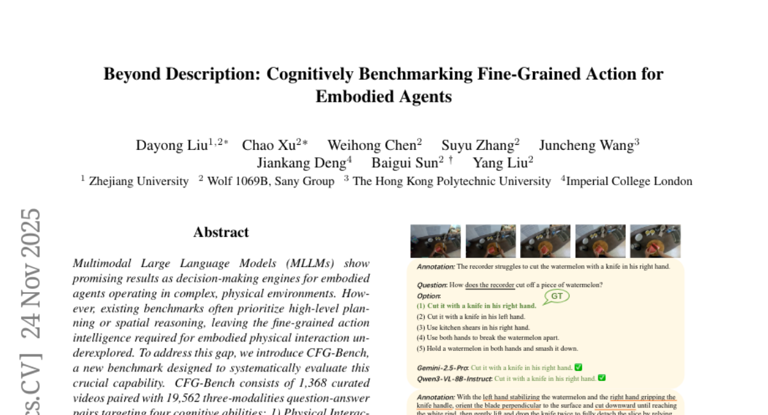

为了系统性地解决这一根本性问题,浙江大学刘大勇教授团队联合三一重工、香港理工大学及伦敦帝国理工学院等机构,共同开发了一套全新的评测基准——CFG-Bench。它并非又一个简单的数据集,而是一套完整的动作理解评测与训练范式。CFG-Bench的设计目标,就是将AI对动作的认知,从表层识别推向深度理解,为构建真正能在物理世界中高效、安全执行任务的智能体提供一把精准的“标尺”和一本实用的“教科书”。

🌀 一、具身智能的认知瓶颈:从“识别”到“理解”的鸿沟

具身智能的目标是让智能体通过与物理世界的交互来学习和执行任务。这一目标的实现,高度依赖于智能体对环境,特别是对人类动作的精准感知与理解。当前技术路径主要依赖于大规模预训练模型,但它们在精细动作理解上普遍存在结构性缺陷。

1.1 多模态大模型的“认知浅表化”

现有的多模态大模型,如GPT-4V、Gemini等,其强大的能力主要源于在海量互联网图文数据上的预训练。这种训练方式使其擅长建立宏观、高层次的语义关联。

-

优势:能够快速识别视频中的主体、客体和基本行为。例如,看到一个人手持网球拍在球场上挥动,模型能准确识别出“打网球”这一行为。

-

局限:这种识别是基于模式匹配的,而非基于对物理规律和动作机理的深层理解。模型知道“打网球”这个标签,但它并不真正“懂”:

-

动力学细节:正手击球时,身体重心的转移、腰腹的转动、手臂的挥拍路径,这些动力学细节模型无法解析。

-

因果关系:为何要先侧身引拍再向前挥击?因为这样能最大化力量传递和击球稳定性。模型缺乏这种对动作步骤间因果链条的理解。

-

意图差异:同样是挥拍,是大力抽杀、是削球还是放小球?这些细微差异背后是完全不同的战术意图,模型难以分辨。

-

这种“认知浅表化”导致模型在面对需要精确物理交互的任务时,其生成的规划或指令往往是模糊且不可执行的。它可能会告诉机器人“拿起杯子倒水”,但无法提供关于“用多大力气握住杯柄”、“杯口倾斜到什么角度”、“何时减缓倒水速度以防溢出”等关键的底层控制参数。

1.2 莫拉维克悖论在AI大模型时代的再现

莫拉维克悖论在早期机器人研究中就已显现。当时的机器人难以完成简单的行走或抓取,但计算机程序却能在国际象棋上战胜世界冠军。如今,这一悖论在大模型时代以新的形式重现。

|

能力维度 |

人类表现 |

当前AI大模型表现 |

悖论体现 |

|---|---|---|---|

|

抽象推理 |

需要长时间学习和训练(如编程、数学、写作) |

表现优异,甚至超越人类平均水平 |

对人类困难的任务,对AI相对容易 |

|

感知-运动 |

与生俱来,毫不费力(如走路、开门、用筷子) |

表现笨拙,难以理解和复现精细动作 |

对人类简单的任务,对AI极其困难 |

CFG-Bench的研究工作,通过量化实验,为这一悖论提供了新的实证依据。它揭示了,即使模型规模和数据量达到前所未有的水平,AI在**物理直觉(Physical Intuition)和具身认知(Embodied Cognition)**方面的短板依然存在。模型可以写出一部关于烹饪的小说,却无法准确描述如何打一个鸡蛋。这种能力的脱节,是阻碍通用人工智能(AGI)走向物理世界的关键障碍。

1.3 现有评测基准的不足

在CFG-Bench出现之前,视频理解领域的评测基准大多集中在以下几个方面:

-

行为分类(Action Classification):如Kinetics、Something-Something数据集,要求模型给视频打上单一的行为标签。

-

时序定位(Temporal Localization):要求模型在长视频中找出特定行为发生的起止时间。

-

视频问答(Video QA):如MSRVTT-QA,问题通常围绕视频中的高层语义内容,较少涉及底层的物理交互细节。

这些基准推动了视频内容识别技术的发展,但它们共同的缺陷在于评测粒度过粗。它们无法衡量模型对动作执行细节、因果逻辑和质量的理解程度。因此,一个能在这些基准上取得高分的模型,在驱动机器人执行实际任务时,仍然可能是一个“理论家”而非“实干家”。行业亟需一个能够弥合这一差距、真正面向物理交互的评测体系。

🌀 二、CFG-Bench 技术范式深度解析

CFG-Bench的构建,是对现有评测体系的一次根本性革新。它不仅仅是一个数据集,更是一套蕴含了深刻认知科学思想的评测框架。其设计哲学、数据构建方法和评测机制共同构成了一个完整的技术范式。

2.1 设计哲学与定位:一本机器人的“动作教科书”

CFG-Bench的定位非常明确,它旨在成为机器人和具身智能体的**“动作理解教科书”与“标准化考试卷”**。

-

作为“教科书”:它提供了一套结构化的学习材料。通过其精细标注的视频和问答对,模型可以学习到人类是如何执行复杂动作的,理解动作背后的物理原理和意图。这为模型的微调和训练提供了高质量的、有监督的信号。

-

作为“考试卷”:它建立了一套标准化的评测流程。研究人员可以利用CFG-Bench来衡量不同模型在精细动作理解上的能力短板,从而指导模型的迭代方向。它让“动作理解”这一模糊概念变得可量化、可比较。

这种双重定位,使得CFG-Bench超越了单纯的数据集范畴,成为推动领域发展的基础设施。

2.2 数据集构建:规模、粒度与场景覆盖

一个评测基准的价值,首先取决于其数据的质量。CFG-Bench在数据构建上投入了巨大的人力成本,确保了其规模、粒度和多样性。

2.2.1 数据集核心参数

|

参数项 |

具体数值/描述 |

说明 |

|---|---|---|

|

视频片段数量 |

1,368 |

经过精心筛选,确保动作清晰、完整且具有代表性 |

|

问答对数量 |

19,562 |

每个视频平均对应约14组问答,进行多维度、深层次的考察 |

|

场景覆盖 |

日常生活、家务劳动、户外活动、工业操作等 |

涵盖了机器人未来可能面临的多种典型应用场景 |

|

标注团队 |

10位专业标注员 |

经过严格培训,确保标注标准统一、质量可靠 |

|

标注周期 |

超过1个月 |

投入大量时间进行逐帧分析和细致描述,确保数据粒度 |

2.2.2 极精细的标注粒度

CFG-Bench的标注标准是其区别于其他数据集的核心特征。它要求标注员像动作分析专家一样,解构每一个动作。

-

身体部位:精确到是哪只手、哪个手指在执行关键操作。例如,不是“用手拿起螺丝刀”,而是“用右手拇指和食指捏住螺丝刀的握柄中上部”。

-

物理交互:描述力的方向、大小和类型。例如,“用指尖轻压西瓜表面进行试探”,而非“触摸西瓜”。

-

时序与节奏:描述动作的速度变化和节奏感。例如,“快速连续地切丁,保持均匀的节奏”,而非“切菜”。

-

工具使用:详细描述工具与物体、身体的交互方式。例如,“刀刃与砧板保持约30度角,以推拉的方式进行切割”。

这种超越常规语义描述的物理级标注,为模型学习真实世界的交互细节提供了前所未有的高质量数据。

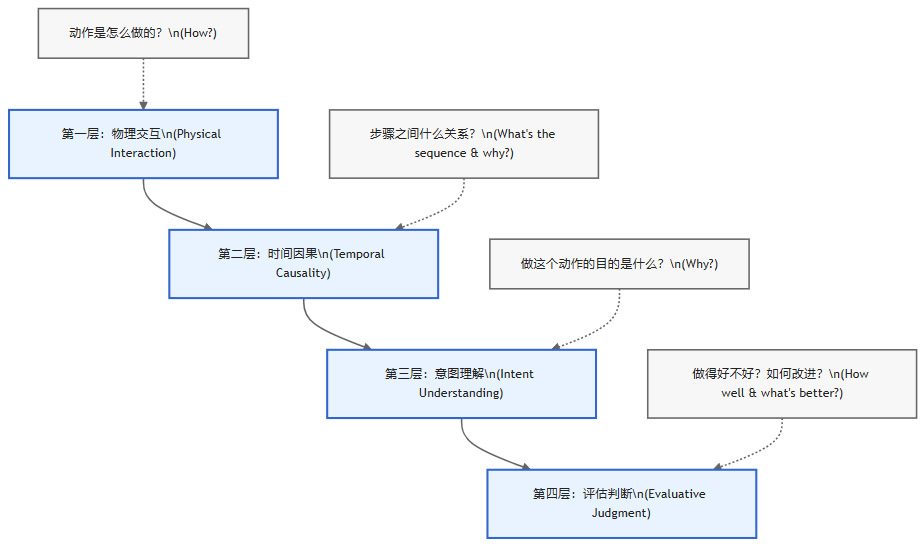

2.3 核心创新:四层递进式认知评测框架

CFG-Bench最核心的创新,是它建立了一套模拟人类认知过程的四层递进式框架。这四层从具体到抽象,系统性地覆盖了动作理解的全部维度。

2.4 评测机制的鲁棒性:反事实问题的设计

为了防止模型通过“耍小聪明”来获得高分,CFG-Bench设计了大量的反事实问题(Counterfactual Questions)。这类问题在题干中故意嵌入与视频内容相悖的错误信息。

-

常规问题:“描述一下视频中是如何用手转动踏板来清洁自行车链条的。”

-

反事实问题:“你是如何用脚踩踏板来刷链条的?”

面对反事实问题,一个只会模式匹配的模型可能会被误导,并尝试基于错误的前提进行回答。而一个真正理解了视频内容的模型,则会首先识别并纠正问题中的错误,然后给出正确的描述。

例如,一个好的回答会是:“问题中的描述不准确。视频中并非用脚踩踏板,而是用右手转动踏板,同时左手持刷子清洁链条。”

这种设计,极大地提升了评测的信度和效度,确保了分数能够真实反映模型的逻辑推理和事实核查能力,而不仅仅是语言生成能力。

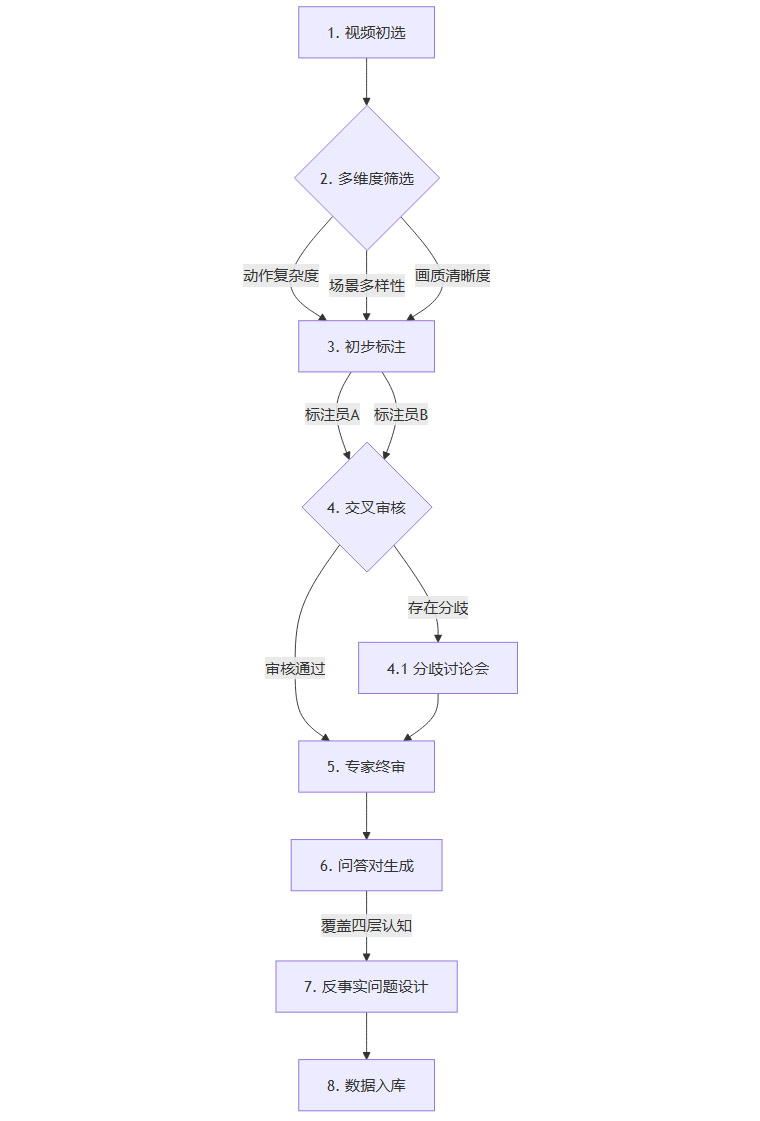

2.5 数据标注工作流与质量控制

为了实现上述四个层级的精细考查,CFG-Bench建立了一套极其严格的数据生产流程,以确保最高的数据质量。

-

交叉审核机制:每个视频由至少两位标注员独立进行标注和问答设计。如果两者结果不一致,将进入分歧讨论环节,由更高级别的专家进行仲裁,确保标注的客观性和一致性。

-

迭代式优化:在标注过程中,团队会定期对已标注数据进行抽样测试,并根据测试结果反馈,不断优化标注指南和培训材料,形成一个持续改进的闭环。

🌀 三、实证分析:主流大模型的能力边界与提升路径

CFG-Bench不仅提出了一个理论框架,更通过详尽的实验,清晰地揭示了当前最先进(SOTA)大模型在精细动作理解方面的真实水平,并验证了其作为训练数据的有效性。

3.1 性能鸿沟:当前 SOTA 模型的表现与人类基准

研究团队使用CFG-Bench对包括Gemini-2.5-Pro在内的多个顶尖多模态大模型进行了全面测试。为了建立一个可靠的参照系,他们也让人类参与了同样的测试。结果 starkly 揭示了巨大的性能差距。

3.1.1 开放式问题得分对比 (满分10分)

|

评测对象 |

平均得分 |

核心结论 |

|---|---|---|

|

人类平均水平 |

9.05 |

人类能够轻松、准确地理解和描述动作的各个维度细节 |

|

Gemini-2.5-Pro (表现最佳模型) |

5.40 |

即使是顶尖模型,得分也仅为及格水平,与人类存在显著差距 |

|

其他开源/商业模型 |

普遍低于5.0 |

大部分模型在精细动作理解上能力严重不足 |

这个数据有力地证明,当前AI在精细动作理解上远未达到可用水平。5.4分这个数字,成为了衡量当前技术边界的一个重要标志。它说明,模型或许能答对一半的简单问题,但在面对更复杂、更细致的提问时,就会频繁出错。

3.2 典型错误模式剖析

通过对模型错误答案的系统性分析,研究团队归纳出了几种普遍存在的、深层次的错误模式。这些模式揭示了模型“思考”方式的缺陷。

3.2.1 细节遗漏 (Detail Omission)

这是最常见的错误。模型能够识别出宏观动作,但会完全忽略掉执行该动作所必需的关键物理细节。

-

模型回答:“机械臂拿起瓶子,把液体倒进杯子。”

-

实际情况:机械臂需要先用特定的夹爪姿态夹住瓶子的把手,然后抬起,再通过一个精确的旋转和倾斜动作来倒水。

-

问题根源:模型缺乏对物理世界交互的“常识”,它不知道“拿起”和“倾倒”这些宏观概念是由一系列精细的微观动作构成的。

3.2.2 多部位协同理解困难 (Difficulty with Coordination)

模型很难理解和描述多个身体部位或工具之间同时进行的、相互协调的动作。

-

场景:一个人左手按住木板,右手用电钻钻孔。

-

模型表现:模型可能会分别描述“手按住木板”和“电钻在钻孔”,但无法解释两者之间的协同关系——左手的按压是为了防止木板在钻孔时滑动,这是一个动态的、对抗性的力平衡过程。

-

问题根源:模型的注意力机制可能难以同时处理视频中的多个动态焦点,并理解它们之间的物理关联。

3.2.3 启发式推断 (Over-simplified Heuristics)

模型倾向于基于表面现象和数据中的常见模式,做出“想当然”的判断,而不是根据视频中的实际证据进行推理。

-

场景:一个人拿着锤子靠近一个钉子。

-

模型推断:模型很可能会直接断定“他要用锤子敲钉子”。

-

实际可能:这个人可能只是想用锤子的羊角部分把钉子拔出来。

-

问题根源:这是预训练数据偏见的一种体现。在训练数据中,“锤子”和“钉子”最常与“敲击”行为关联,导致模型形成了僵化的思维定式。

3.2.4 积极偏见 (Positivity Bias)

在进行评估判断时,模型倾向于只关注任务是否最终完成,而忽略过程中的不规范、不安全或低效操作。

-

场景:一个人成功地举起了一个重箱子,但姿势是危险的弯腰而非屈膝。

-

模型评价:“操作者成功地举起了箱子,完成了任务。”

-

问题根源:模型缺乏关于过程质量的评估标准。它的“价值观”更倾向于结果导向,这在需要确保安全和规范的现实世界应用中是极其危险的。

3.3 从“评测”到“赋能”:微调带来的性能飞跃

CFG-Bench的价值不仅在于“诊断问题”,更在于“解决问题”。研究团队利用其高质量的数据对Qwen2.5-VL等多模态模型进行了微调(Fine-tuning)。实验结果证明,这种针对性的训练能够极大地提升模型在实际机器人任务中的表现。

3.3.1 机器人任务性能提升数据

|

任务类型 |

性能提升幅度 |

能力解读 |

|---|---|---|

|

高层规划任务 |

+106% |

模型能够生成更合理、更详细、更具可执行性的任务步骤序列。 |

|

低层控制任务 |

+59% |

模型生成的指令能够更精确地对应到底层的机器人动作,例如抓取姿态和运动轨迹。 |

这些数字是惊人的。它清晰地表明,精细动作理解能力是机器人规划与控制能力的上游。只有当模型真正“看懂”了人类是如何做的,它才能有效地指导机器人去“做”。

3.3.2 视频描述能力的质变

微调带来的提升,也直观地体现在模型的语言描述能力上。

-

微调前:“机械臂接近玻璃和瓶子。机械臂拿起瓶子。机械臂倾斜瓶子并将液体倒入玻璃。”

-

评价:这是典型的“流水账”式描述,只描述了事件序列,缺乏任何物理细节。

-

-

微调后:“机械手定位在画面左侧,慢慢向桌上的玻璃瓶移动。然后用手指夹住瓶子的把手,稍微抬起瓶子离开桌面。接着逆时针旋转瓶子使瓶嘴对准下方的玻璃,然后倾斜瓶子将液体倒入玻璃。”

-

评价:描述中包含了定位、移动方式、抓取部位、微小动作(抬起、旋转)、相对位置关系等大量关键的物理细节。这种描述已经初步具备了转化为机器人可执行代码的潜力。

-

3.4 性能提升的内在机制

用CFG-Bench数据微调模型后,机器人任务性能为何能获得如此显著的提升?其内在机制可以从模型表征、推理链和策略生成三个层面来理解。

3.4.1 更精细的动作表征空间

传统的动作识别数据集促使模型学习一个相对粗糙的表征空间,相似的动作(如“推”和“抚摸”)在其中可能距离很近。而CFG-Bench的精细标注和问答,迫使模型关注到动作的细微差别,如力度、速度和接触方式。

-

解耦表征 (Disentangled Representation):模型被迫学习将动作分解为多个独立的语义维度(如

动作主体、作用对象、使用工具、施力方式、目标)。这种解耦的表征使得模型在面对新任务时,可以更好地泛化和组合已有的动作知识。

3.4.2 显式推理链的构建

开放式问答,特别是涉及因果和意图的问题,强制模型生成连贯的、符合逻辑的文本解释。这个过程实际上是在训练模型构建一条从“视觉观察”到“语言结论”的显式推理链。

-

从“看到什么”到“为什么”:当模型被问及“为什么他要先摇晃瓶子再打开?”时,它必须激活其内部知识,连接到“混合液体”等功能性概念。这种训练强化了模型进行多步、跨模态推理的能力,并能直接迁移到机器人的高层任务规划中。

3.4.3 更具上下文感知能力的策略生成

机器人的低层控制任务,本质上是根据当前状态生成最优的动作策略。CFG-Bench的训练数据富含上下文信息,极大地提升了模型策略的上下文感知能力。

-

状态评估更精准:通过学习评估人类动作的“好坏”,模型学会了如何评估一个“状态”的优劣。例如,它知道一个“不稳定的抓握”是一个需要立即纠正的坏状态。这使得机器人在执行任务时,能进行更有效的实时反馈和调整。

🌀 四、从评测到实践:构建精细动作理解模型的关键路径

CFG-Bench的发现为开发者和研究者指明了方向。要构建真正具备精细动作理解能力的模型,需要系统性地从数据、模型、训练和评估四个环节进行革新。

4.1 数据驱动:超越标签,拥抱物理细节

高质量的数据是根本。未来的数据构建需要超越简单的语义标签。

-

采集物理属性数据:除了视频,还应采集动作捕捉(MoCap)、力反馈、物体三维模型等数据,为模型提供更丰富的物理世界监督信号。

-

利用合成数据:通过物理仿真引擎生成大规模、多样化且带有完美物理标注的合成数据,可以有效弥补真实世界数据采集成本高、标注难的问题。

4.2 模型设计:引入结构化先验知识

纯粹的端到端模型在物理推理上存在瓶颈。在模型架构中显式地引入结构化先验知识是关键。

-

物理仿真模块:在模型中集成一个可微分的物理引擎,使其能够对动作的后果进行预测和推理。

-

图神经网络(GNNs):使用图结构来表示场景中的物体及其相互关系,帮助模型更好地理解协同操作和复杂的场景动态。

4.3 训练策略:多任务学习与课程学习

精细动作理解是一个多层次的复杂能力,需要精巧的训练策略。

-

课程学习(Curriculum Learning):按照CFG-Bench的四层认知框架来设计训练课程。先让模型学习底层的“物理交互”,再逐步引入“时间因果”、“意图”和“评估”,符合由易到难的认知规律。

-

多任务学习:将动作识别、物理属性预测、因果关系问答等任务联合进行训练,可以促进模型学习到更通用、更鲁棒的特征表示。

4.4 评估范式:闭环迭代与物理仿真

评估不应止于离线的问答。

-

“在环”评估(In-the-Loop Evaluation):将模型的输出(如规划或控制指令)直接输入到物理模拟器或真实机器人上执行,根据任务完成的实际效果来评估模型能力,形成一个“感知-决策-执行-反馈”的闭环。

🌀 五、行业应用和长远意义

CFG-Bench的价值超越了学术研究,为机器人技术在关键行业的落地应用提供了坚实的基础。

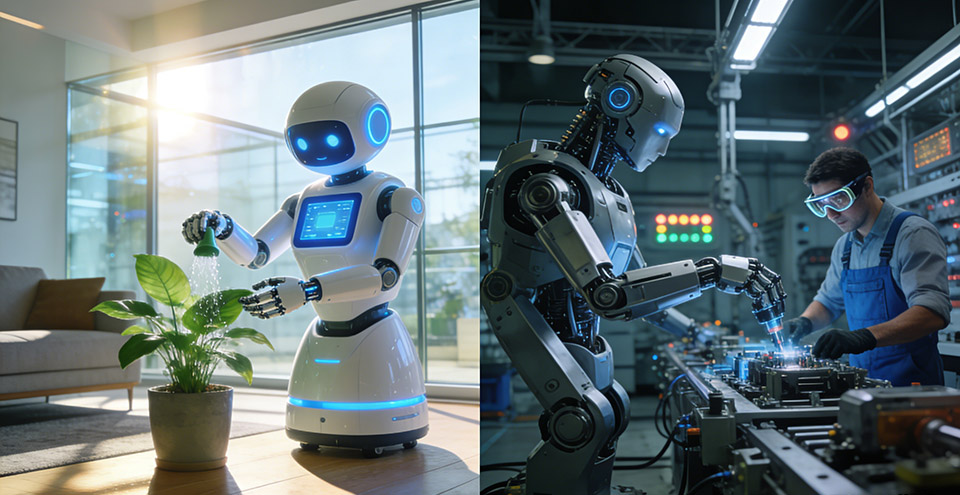

5.1 家庭与服务型机器人

细腻的动作理解是家用机器人实现安全、有效协助人类完成日常任务的基础。

-

家务劳动:在做饭、清洁等任务中,机器人需要理解如何处理不同食材、如何使用各种清洁工具。CFG-Bench为训练机器人掌握这些“家务活”的技巧提供了全新标准。

-

养老照护:在辅助老人起居、喂食等场景,动作的安全性、轻柔度至关重要。具备精细动作理解能力的机器人,才能成为可靠的家庭助手,而非潜在的风险源。

5.2 工业自动化与柔性制造

在现代工业领域,特别是柔性制造和人机协作场景,对机器人的智能水平提出了更高要求。

-

替代固定程序:传统的工业机器人只能执行预编程的刚性动作。而经过CFG-Bench这类数据训练的AI,能让机器人理解并模仿人类工人的复杂操作,适应更多变的生产任务。

-

人机协作:在协作型工业机器人领域,机器人需要实时理解人类同事的动作和意图,以便安全、高效地配合。CFG-Bench为实现这种深度的人机交互提供了评估和训练方法。

🌀 六、对多模态模型架构演进的启示

CFG-Bench的出现也为下一代多模态大模型,特别是面向具身智能的模型架构演进,指明了几个关键方向。

6.1 超越感知,迈向结构化认知

当前主流的多模态模型,如ViT+LLM的架构,本质上仍是一个强大的“感知-语言”映射器。

-

模块化与神经符号结合:未来的模型架构可能会更加模块化,例如,设计专门的物理仿真模块、因果推理模块和意图规划模块。这些模块可以与端到端的神经网络相结合,形成神经符号系统,兼具深度学习的感知能力和符号逻辑的推理能力。

6.2 物理世界模型的隐式构建

一个能在CFG-Bench上取得高分的模型,必然在其内部隐式地构建了一个关于物理世界如何运作的“世界模型”。

-

自监督学习的强化:未来的模型训练将更加依赖于自监督学习,通过预测视频的下一帧、预测动作的物理后果等任务,来让模型自主学习物理规律。CFG-Bench这样的数据集可以作为一种强监督信号,用于“校准”和“微调”通过自监督学习构建起来的物理世界模型。

6.3 深度时空融合与细粒度对齐

要理解精细动作,模型必须能够在时间和空间上对视频和语言进行极其精确的对齐。

-

时空注意力机制的革新:需要发展更先进的时空注意力机制,能够捕捉动作的瞬时动态(如敲击的瞬间)和长期依赖(如组装任务的全过程)。

-

跨模态的层次化对齐:模型需要能将文本中的一个词(如“捏”)精确对齐到视频中特定的像素区域和时间片段,实现从物体、部位到整个动作的层次化理解。

6.4 记忆网络与长程依赖

对于涉及多步骤、长序列的任务,模型的记忆能力至关重要。

-

外部记忆模块的引入:未来的具身智能体架构可能会明确引入外部记忆模块,类似于人脑中的工作记忆。模型可以将关键的中间状态、观察结果和子目标“存入”这个记忆模块,并在后续的决策中“读取”和使用,这对于解决长程时间因果问题至关重要。

🌀 七、局限与展望

任何一项开创性的工作都存在其局限性,CFG-Bench也不例外。坦诚地认识这些局限,是未来发展的前提。

7.1 当前工作的局限性

-

模型覆盖范围:由于资源和API的限制,研究未能覆盖所有顶尖的商业闭源大模型,其在精细动作理解上的真实能力上限仍有待进一步探索。

-

专业领域覆盖:当前数据集主要集中在日常和通用场景,对于外科手术、精密仪器装配等高度专业化的领域覆盖不足。

-

评估方式的单一性:评估主要依赖于语言问答。这可能无法完全区分一个模型是“真的不理解”还是“理解了但表达不出来”。

7.2 未来发展方向

-

数据集的持续扩展:未来,社区可以共同努力,将CFG-Bench扩展到更多专业领域,构建一个覆盖更广、粒度更细的动作理解知识库。

-

多模态评估范式:探索将语言评估与物理仿真、实际机器人执行相结合的综合评估范式,更全面地衡量智能体的具身认知能力。

-

社区生态的构建:随着更多研究团队采纳和使用CFG-Bench,有望形成一个围绕精细动作理解的开放研究社区,共同推动机器人认知水平的飞跃。

结论

CFG-Bench的提出,远不止是发布了一个新的数据集或评测基准。它通过一套系统化、层级化的方法,深刻揭示了当前AI在具身认知领域的“软肋”,并为解决这些问题提供了清晰的路线图。它将研究社区的焦点从宏观的“行为识别”引向了微观的“动作理解”,强调了物理交互、因果逻辑、意图推断和评估判断在构建真正智能体时的核心地位。

通过实证分析和对未来发展路径的探讨,我们看到,精细动作理解能力的提升,能够直接转化为机器人高层规划和低层控制的实际性能。这证实了“认知驱动执行”的技术路径是可行且高效的。

更重要的是,CFG-Bench对未来AI架构的演进提出了明确要求。未来的模型必须超越简单的感知映射,发展出结构化的推理能力,构建起对物理世界的深刻理解,并具备长程记忆和精细的时空对齐能力。这预示着,一个融合了模块化设计、自监督学习和神经符号思想的新一代具身智能模型架构,正在地平线上浮现。

总而言之,CFG-Bench既是当下AI能力的一面“照妖镜”,也是未来技术演进的一座“灯塔”。它为我们衡量和推动机器人从“能看”到“会做”,再到“做得好”的进程,提供了一把不可或缺的标尺。

📢💻 【省心锐评】

CFG-Bench创造动作认知新标杆,推动机器人能力升级,开启智能机器深度理解与物理操作融合新格局。

更多推荐

已为社区贡献420条内容

已为社区贡献420条内容

所有评论(0)