【轻量拓展区】网络 QoS 与带宽、延迟、抖动:AI 推理的性能瓶颈

本文探讨了网络QoS(服务质量)对AI推理性能的影响。在AI推理场景中,带宽、延迟、抖动和丢包等网络因素可能成为主要性能瓶颈,而非计算资源本身。文章详细解析了各项QoS指标的实际影响,并提供Python工具代码用于监测网络质量。同时给出了优化建议,如边缘计算、数据压缩、专用网络通道等。最后指出,理解并优化网络QoS是构建稳定AI系统的关键,尤其在实时性要求高的应用中更为重要。

【轻量拓展区】网络 QoS 与带宽、延迟、抖动:AI 推理的性能瓶颈

在传统网络调试场景中,我们常关注带宽够不够、延迟高不高、丢包严不严重。但当业务涉及 AI 推理、分布式训练、视频识别、AIOps Agent 采集、云边计算协作 时,网络不再只是“通不通”的问题,而是 是否满足实时性与稳定性的质量要求(QoS: Quality of Service)。

一、基础认识:QoS 对 AI 推理究竟影响在哪里?

在 AI 推理链路中,请求最终会变成:

- 输入(图片、特征、时序数据)

- 模型推理(GPU/TPU/加速卡)

- 输出(预测结果)

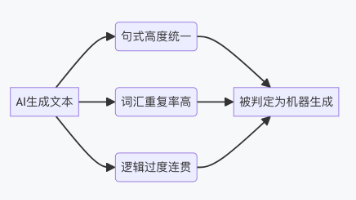

听起来模型才是主角,但网络 QoS 问题常常能“拖死”一套 AI 系统。

正面示例

当延迟从 30ms → 300ms:

- 智能客服响应明显变慢

- 监控系统告警延后数秒

- 视频 AI 推理实时性丢失

- AIOps Agent 上传慢导致异常检测延迟

错误示例

很多人误以为 “只要 GPU 强,推理速度就快”。

但一个真实例子:

模型器推理只要 5ms

→ 网络延迟 200ms

→ 带宽不足导致数据传输耗时 300ms

→ 系统总耗时 505ms

网络落地一刀砍掉 90% 的性能。

调试小技巧:

如果系统总体延迟明显大于模型推理解算时间 5 倍以上,多半不是模型问题,而是 网络 QoS 问题。

二、QoS 指标详解:带宽、延迟、抖动、丢包

2.1 带宽:数据通路有多宽?

带宽决定单位时间最大能传多少数据。

正面示例

上传一张 5MB 图片

带宽为 50 Mbps,理论耗时约:

5MB ≈ 40Mb

40Mb / 50 Mb/s = 0.8s

错误示例

很多人看到“100M 宽带”误以为下载能到 100MB/s,这比现实多了一个数量级。

调试技巧:

使用 iperf3 测试真实带宽:

iperf3 -c 服务器IP

可帮你判断是否真的是“带宽瓶颈”。

2.2 延迟(latency):数据到目的地需要多久?

AI 推理常常需要即时响应,例如工厂检测或云边协同。如果延迟超过 100ms,体验会明显变慢。

正面示例

边缘设备 → 云端推理

延迟 < 30ms:实时感强

延迟 > 150ms:使用体验下降明显

错误示例

把“带宽不足”误识为“延迟高”。

延迟决定的是“第一字节到达速度”,不是速度快慢的根本原因。

调试技巧:

ping -n 20 server_ip

多次测量延迟稳定性,而不是只看一次结果。

2.3 抖动(jitter):延迟波动大不大?

抖动是 “相邻两次延迟之间的差异”。

AI 推理链路中抖动比平均延迟更致命,特别是:

- 语音识别

- 视频推理

- 实时预测

- 时序异常检测

举例

正常延迟:30ms

但抖动:±200ms

意味着某些帧会突然卡住,让系统表现像“间歇性卡顿”。

错误示例

很多人认为只要平均延迟低就行。

但平均延迟 20ms、抖动 300ms 时系统将极不稳定。

2.4 丢包:所有实时系统的终极噩梦

丢包会造成:

- 语音识别数据缺帧

- 视频 AI 推理强制重传

- AIOps Agent 数据上报缺失

- 预测模型的输入序列不完整导致效果下降

调试技巧:

ping -n 50 server_ip

观察是否出现:

请求超时

丢失 = 3(6% 丢包率)

超过 1% 丢包 就会显著影响 AI 推理的稳定性。

三、项目实战:构建一个“QoS 监测器”,专为 AI 推理链路打造

下面给出一个轻量级 Python 工具,用来检测带宽、延迟、抖动和丢包,非常适合 AIOps 方向论文实验。

3.1 qos_monitor.py

import subprocess

import statistics

import time

def ping_test(target="8.8.8.8", count=20):

print("=== 延迟、抖动、丢包测试 ===")

cmd = ["ping", target, "-n", str(count)]

result = subprocess.run(cmd, text=True, capture_output=True).stdout

times = []

for line in result.split("\n"):

if "时间" in line:

ms = int(line.split("时间=")[1].split("ms")[0])

times.append(ms)

if times:

latency = statistics.mean(times)

jitter = statistics.stdev(times) if len(times) > 1 else 0

print(f"平均延迟: {latency:.2f}ms")

print(f"抖动: {jitter:.2f}ms")

print(f"最小/最大延迟: {min(times)} / {max(times)} ms")

else:

print("全部丢包")

def bandwidth_test(server_ip):

print("\n=== 带宽测试(需安装 iperf3)===")

cmd = ["iperf3", "-c", server_ip, "-t", "5"]

print(subprocess.run(cmd, text=True, capture_output=True).stdout)

if __name__ == "__main__":

ping_test("www.baidu.com")

# bandwidth_test("你的服务器IP")

你可以在课程论文中:

- 分别测试校园网、家宽网、热点网

- 测试 AI 推理请求在不同 QoS 下的耗时变化

- 对比不同链路的延迟与抖动分布

- 用数据图展示 QoS 与推理耗时的相关性

非常适合你正在准备的 AIOps 专栏内容。

四、工作高级技巧:如何优化 AI 推理链路的网络 QoS?

4.1 降低延迟:把推理节点放近一点

AI 推理最常见的优化方式不是换显卡,而是:

- 使用边缘推理

- 让推理节点靠近数据来源

- CDN + 模型缓存

真实案例

某企业图像识别从“全云端推理”改为“就近边缘节点推理”,延迟从 160ms 降到 20ms。

4.2 解决带宽瓶颈:数据压缩与特征上传

上传整张图像太慢?

上传模型特征,只要几十 KB。

这是云边协同常见做法:

边缘设备提取特征 → 云端轻量推理。

4.3 降抖动:使用独立网络通道

用于实时推理的网络最好:

- 单独 VLAN

- QoS 优先级调度

- 禁止流量抢占

这在工厂、车间、金融交易场景非常普遍。

4.4 防丢包:采用 TCP/UDP 混合模式

视频推理中:

- 控制信令用 TCP(不丢)

- 视频流用 UDP(不等待)

提高实时性。

五、拓展:QoS 背后的协议原理

5.1 TCP 如何影响 QoS?

TCP 的重传机制会导致:

- 丢包 → 大幅增加延迟

- 抖动 → TCP 慢启动导致速率抖动

尤其影响视频推理与时序推理。

5.2 UDP 天生实时,但不可靠

UDP 没有重传,所以抖动更低、更实时,但丢包会直接影响推理效果。

例如:

- 视频帧缺失

- 语音识别上下文缺块

- AI 模型输入不完整

5.3 MPLS、DiffServ:真正的网络 QoS 技术

运营商级 QoS 主要靠:

- MPLS(多协议标签交换)

- DiffServ(IP TOS 区分服务)

企业内部也能开启 QoS 优先级,实现:

- 推理流量优先

- 控制信令优先

- 视频流优先

非常适合 AIOps 论文的拓展内容。

六、总结

带宽、延迟、抖动和丢包不仅是网络调试的指标,更是 AI 推理系统性能的核心瓶颈。

理解 QoS → 才能优化推理链路 → 才能构建稳定的 AI 系统。

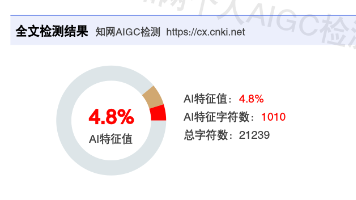

AI 创作声明

本文部分内容由 AI 辅助生成,并经人工整理与验证,仅供参考学习,欢迎指出错误与不足之处。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)