langchain的init_chat_model代理设置

langchain的init_chat_model代理设置

一.背景

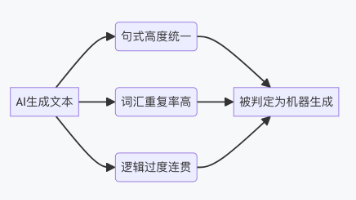

在大模型应用开发与落地的过程中,LangChain 作为主流的大模型应用开发框架,其 init_chat_model 函数(v0.1+ 版本新增的统一聊天模型初始化入口)已成为开发者快速集成各类大模型的核心工具。但在实际企业级场景中,直接对接大模型官方 API 面临诸多现实壁垒,“代理设置” 成为保障大模型应用稳定、合规、高效运行的关键环节,其背景可从以下核心痛点与诉求展开:

1.核心痛点:直接对接大模型官方 API 的局限性

-

网络访问限制部分海外大模型(如 OpenAI、Anthropic 等)的官方 API 部署在境外,企业内网或国内环境往往无法直接访问,导致

init_chat_model初始化模型时频繁出现连接超时、请求失败等问题,无法正常调用模型能力。即便能访问,跨地域网络延迟也会显著降低应用响应速度,影响用户体验。 -

合规与安全管控诉求企业级应用对数据安全、合规性要求严苛:一方面,直接将业务数据(如用户隐私、企业机密)传输至境外 API 节点,可能违反数据出境监管规定;另一方面,官方 API 调用链路无企业级审计、权限管控,无法追溯请求来源和数据流转路径,存在数据泄露风险。此外,部分企业要求所有网络请求必须经过内部代理网关(如防火墙、API 网关),统一管控流量、鉴权和日志,直接调用官方 API 无法适配该管控体系。

-

成本与资源优化需求大规模调用大模型 API 时,企业常通过 “代理网关 + 缓存”“自研代理服务分流” 等方式优化成本:例如代理层缓存高频请求的模型响应,减少重复 API 调用;或通过代理实现多模型服务商的流量分发、降级兜底。直接使用

init_chat_model对接官方 API,无法接入这类成本优化体系,导致调用成本居高不下。 -

私有化 / 自建模型适配需求越来越多企业选择私有化部署大模型(如基于 Llama、Qwen 等开源模型搭建内部服务),或使用第三方提供的大模型代理服务(如企业内部统一的 AI 代理平台)。这类自建 / 代理服务的接口地址、鉴权方式与官方 API 不同,需通过

init_chat_model的代理设置,将请求指向自定义代理地址,而非官方默认地址。

2.代理设置的核心价值:适配企业级落地场景

LangChain init_chat_model 的代理设置能力,本质是为大模型应用搭建 “灵活可控的请求中转层”,解决上述痛点:

- 突破网络壁垒:通过配置代理地址(如企业内网代理、跨境代理网关),让

init_chat_model初始化的模型实例能正常访问目标大模型 API,保障网络连通性,同时降低跨地域访问延迟。 - 满足合规管控:将模型请求路由至企业内部代理网关,可在代理层完成数据脱敏、权限校验、请求审计、日志留存,符合数据安全与出境监管要求,确保业务数据流转全程可管、可控、可追溯。

- 适配成本优化体系:代理层可集成缓存、流量控制、多模型分流等能力,

init_chat_model通过代理调用模型时,能复用这些优化策略,大幅降低 API 调用成本,提升请求处理效率。 - 兼容私有化部署场景:通过代理地址配置,

init_chat_model可无缝对接企业私有化部署的大模型服务(如将base_url指向内部模型服务地址),无需修改核心业务代码,实现 “一套代码适配官方 / 私有模型”。

3.应用场景与落地价值

init_chat_model 代理设置的需求广泛覆盖企业级大模型应用的核心场景:

- 跨境大模型调用:国内企业调用 OpenAI 等境外模型时,通过合规跨境代理配置,保障请求连通性与数据合规;

- 企业内网管控:所有模型请求经内部代理网关转发,统一管控流量、鉴权和日志,适配企业网络安全策略;

- 私有化模型集成:将代理地址指向企业自建的大模型服务,利用

init_chat_model的统一接口快速集成,降低开发适配成本; - 多模型统一调度:通过代理层实现多厂商模型(如 OpenAI、阿里云通义千问、腾讯混元)的流量分发,

init_chat_model只需配置代理地址,即可按需调用不同模型,提升应用的灵活性与容错性。

综上,LangChain init_chat_model 的代理设置,是连接 “通用大模型开发框架” 与 “企业级落地诉求” 的关键桥梁:既保留了 init_chat_model 统一、简洁的模型初始化体验,又通过灵活的代理配置,解决了网络、合规、成本、私有化等企业级场景的核心痛点,为大模型应用从开发测试走向规模化生产落地提供了必要的技术支撑。

二.具体实现

from langchain.tools import tool

from langchain.chat_models import init_chat_model

model_config = {

"model": "xxx", # 模型名称(需与代理支持的模型一致)

"api_key": "", # OpenAI 官方 API Key 或代理服务器分配的密钥

"model_kwargs": {

"base_url": "xxx", # 你的代理地址(必须以 /v1 结尾,与 OpenAI 接口格式一致)

# 可选:其他 OpenAI 模型参数(如温度、超时等)

"temperature": 0.7,

"timeout": 30,

},

"verbose": True, # 可选:开启日志,便于调试代理连接

}

model = init_chat_model(**model_config)更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)