DeepSeek-V3.2:一个“会偷懒“的超级大脑是如何炼成的?

DeepSeek-V3.2:高效智能的突破 DeepSeek-V3.2是中国AI公司2025年发布的超级大脑模型,拥有6710亿参数,媲美GPT-5但更高效。其核心技术包括: MoE混合专家:256个专家中每次仅激活8个,降低95%计算量 MLA记忆压缩:将KV缓存减少93.3%,提升5.76倍速度 DSA稀疏注意力:专注关键内容,使长文本处理成本几乎不增长 GRPO强化学习:三合一训练提升综合能

🧠 DeepSeek-V3.2:一个"会偷懒"的超级大脑是如何炼成的?

一篇写给小白的 AI 技术科普,带你揭秘 2025 年最火的国产大模型

前言:为什么你应该关注 DeepSeek-V3.2?

想象一下,有一个拥有 6710 亿个脑细胞的超级大脑,它能解奥数题拿金牌、能写代码击败全球程序员、还能像人类一样思考和推理——这就是 DeepSeek-V3.2。

2025 年 12 月 1 日,中国 AI 公司 DeepSeek 正式发布了这个"怪物级"模型。它不仅性能媲美 GPT-5,更厉害的是:用更少的钱,办更多的事。

那么问题来了:它是怎么做到的?让我们用最通俗的方式,一层层揭开它的神秘面纱。

第一章:6710 亿参数是个什么概念?

🔢 一个直观的比喻

人类大脑大约有 860 亿个神经元。而 DeepSeek-V3.2 有 6710 亿个参数——相当于把近 8 个人类大脑的"容量"塞进了一台机器里。

但这里有个关键问题:如果每次思考都要调动所有 6710 亿个参数,那计算量会大到令人发指,电费账单能让任何公司破产。

DeepSeek 的天才之处在于:它学会了"偷懒"。

第二章:MoE——"专家会诊"机制

🏥 像医院一样分诊

你去医院看病,不会让所有医生同时给你诊断吧?你会先分诊,然后由对应科室的专家来处理。

DeepSeek-V3.2 用的就是类似的机制,叫做 MoE(Mixture of Experts,混合专家):

┌─────────────────────────────────────────────────────────┐

│ 你的问题进来了 │

└─────────────────────┬───────────────────────────────────┘

▼

┌───────────────┐

│ 智能分诊台 │ ← 路由器(Router)

│ "这题该谁答?" │

└───────┬───────┘

│

┌─────────┬───┴───┬─────────┐

▼ ▼ ▼ ▼

┌──────┐ ┌──────┐ ┌──────┐ ┌──────┐

│数学家│ │程序员│ │作家 │ │科学家│ ← 256个专家

└──────┘ └──────┘ └──────┘ └──────┘

│ │

▼ ▼

只激活 8 个最相关的专家来回答!

📊 数字说话

- 总参数:6710 亿(671B)

- 每次激活:只有 370 亿(37B)

- 效率提升:相当于只用 5.5% 的"脑力"就能完成任务!

这就像你有一个 256 人的超级专家团队,但每次只需要请 8 个最懂行的人开会,其他人可以继续休息。省时省力省电费!

第三章:MLA——"压缩记忆"的艺术

📦 KV 缓存:AI 的"短期记忆"

当 AI 在处理你的长对话时,它需要记住之前说过的所有内容。这个"记忆"在技术上叫 KV 缓存(Key-Value Cache)。

问题是:对话越长,记忆占用的空间就越大,很快就会把显存撑爆。

🗜️ MLA:有损压缩的魔法

MLA(Multi-head Latent Attention,多头潜注意力) 的解决方案非常巧妙:

与其记住原文,不如记住"笔记摘要"。

传统方式:

"今天天气真好,阳光明媚,微风和煦,气温适宜..." → 完整存储 100 字

MLA 方式:

"今天天气真好,阳光明媚,微风和煦,气温适宜..." → 压缩成 → [好天气☀️]

↑

只存一个"潜向量"

🚀 效果惊人

- KV 缓存减少 93.3%

- 生成速度提升 5.76 倍

- 模型性能几乎不受影响

这就像你把一本 1000 页的书压缩成了 67 页的精华笔记,需要时再"脑补"展开——既省空间,又不丢信息。

第四章:DSA——V3.2 的"杀手锏"

🎯 问题:长文本处理的"诅咒"

传统的 Transformer 模型有个致命问题:处理长文本时,计算量会平方级增长。

举个例子:

- 处理 1000 个字:计算量 = 1,000,000

- 处理 10000 个字:计算量 = 100,000,000(暴涨 100 倍!)

- 处理 128000 个字:计算量 = 16,384,000,000,000(天文数字!)

这就是为什么很多 AI 处理长文档时会变得很慢、很贵。

⚡ DSA:只看最重要的

DSA(DeepSeek Sparse Attention,稀疏注意力) 的核心思想是:

并不是每个字都同样重要,只需要关注最相关的 2048 个字就够了。

这就像你在图书馆找资料:

传统方式:把图书馆所有书都翻一遍 📚📚📚📚📚📚📚📚

DSA 方式:

1️⃣ 闪电索引器(Lightning Indexer)

→ 快速扫描书脊,3 秒锁定相关书架

2️⃣ Top-k 选择器

→ 只精读最相关的 2048 本书

结果:从 O(L²) 降到 O(L×k),复杂度大幅降低!

📈 实际效果

| 指标 | 提升幅度 |

|---|---|

| 长文本处理速度 | 提升 2-3 倍 |

| 内存占用 | 降低 30-40% |

| API 调用成本 | 下降超过 50% |

| 128K 长度处理成本 | 几乎不随长度增长 |

这项技术让 DeepSeek-V3.2 在处理超长文档时,成本曲线几乎是平的——而竞品还在随着文本长度线性增长!

第五章:训练的秘密��—“一站式强化学习”

🎮 GRPO:自己跟自己玩

DeepSeek 使用了自研的 GRPO(Group Relative Policy Optimization) 算法来训练模型。

简单来说,这个过程像是:

┌──────────────────────────────────────────────────────────┐

│ 训练循环 │

│ │

│ 1. 给模型一道难题 │

│ ↓ │

│ 2. 模型生成多个候选答案 │

│ ↓ │

│ 3. 评估哪个答案最好 │

│ ↓ │

│ 4. 让模型学习:好答案要多生成,差答案要避免 │

│ ↓ │

│ 5. 重复以上步骤数千次... │

│ │

└──────────────────────────────────────────────────────────┘

🏋️ 训练规模

- 投入超过 10% 的预训练计算资源用于强化学习

- 构建了 1800+ 训练环境

- 设计了 85,000+ 复杂指令

- 覆盖:数学、编程、推理、智能体等多个领域

🎯 创新点:三合一训练

传统做法是分阶段训练:先训推理、再训智能体、最后对齐人类偏好。

DeepSeek 的创新:把这三个阶段合并成一个!

好处:

- 避免"灾难性遗忘"(学了新技能忘了旧技能)

- 不同能力之间可以相互促进

- 训练效率更高

第六章:性能有多强?让数据说话

🏆 竞赛成绩单

DeepSeek-V3.2-Speciale(长思考增强版)在 2025 年斩获了一系列顶级竞赛金牌:

| 竞赛 | 成绩 |

|---|---|

| IMO 2025(国际数学奥林匹克) | 🥇 金牌 |

| CMO 2025(中国数学奥林匹克) | 🥇 金牌 |

| ICPC World Finals(编程世界杯) | 🥇 金牌(人类第 2 名水平) |

| IOI 2025(信息学奥林匹克) | 🥇 金牌(人类第 10 名水平) |

📊 基准测试对比

| 测试项目 | DeepSeek-V3.2 | GPT-5 | 备注 |

|---|---|---|---|

| AIME 2025(数学) | 93.1% | 90.8% | ✅ 超越 |

| SWE-Verified(代码) | 73.1% | - | 顶尖水平 |

| 智能体任务 | 开源最强 | - | 大幅缩小差距 |

💡 独特能力

DeepSeek-V3.2 是首个将思考融入工具使用的模型:

- 可以边思考边调用工具

- 支持思考模式与非思考模式自由切换

- 真正像人类一样"三思而后行"

第七章:技术架构全景图

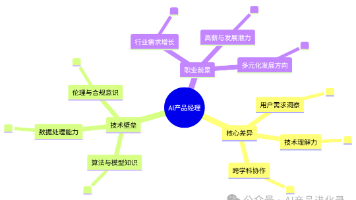

让我们用一张图总结 DeepSeek-V3.2 的核心技术:

DeepSeek-V3.2 技术全景

┌─────────────────────────────────────────────────────────┐

│ │

│ ┌─────────────────┐ ┌─────────────────┐ │

│ │ MoE 混合专家 │ │ MLA 潜注意力 │ │

│ │ │ │ │ │

│ │ • 256个专家 │ │ • KV缓存压缩 │ │

│ │ • 每次激活8个 │ │ • 减少93.3%存储 │ │

│ │ • 效率提升4倍+ │ │ • 速度提升5.76倍│ │

│ └────────┬────────┘ └────────┬────────┘ │

│ │ │ │

│ └──────────┬───────────┘ │

│ ▼ │

│ ┌─────────────────────┐ │

│ │ DSA 稀疏注意力 │ ← V3.2 核心创新 │

│ │ │ │

│ │ • 闪电索引器 │ │

│ │ • Top-2048 选择 │ │

│ │ • 长文本成本平坦化 │ │

│ └──────────┬──────────┘ │

│ ▼ │

│ ┌─────────────────────┐ │

│ │ GRPO 强化学习 │ │

│ │ │ │

│ │ • 三合一训练 │ │

│ │ • 85000+复杂指令 │ │

│ │ • 1800+训练环境 │ │

│ └─────────────────────┘ │

│ │

└─────────────────────────────────────────────────────────┘

第八章:这对普通人意味着什么?

💰 成本大幅下降

DeepSeek-V3.2 的 API 定价:

- 输入成本:低至 $0.07/百万 token(缓存命中时)

- 比同级别模型便宜 50% 以上

这意味着:

- 创业公司可以用得起顶级 AI

- 个人开发者可以随便调用

- AI 应用会越来越便宜、越来越普及

🌍 开源的力量

DeepSeek-V3.2 是开源模型,这意味着:

- 任何人都可以研究它的技术

- 可以在本地部署,数据不出门

- 推动整个 AI 行业进步

🇨🇳 国产 AI 的里程碑

DeepSeek-V3.2 证明了:

- 中国 AI 已经站在世界第一梯队

- 技术创新可以弯道超车

- 效率优化和性能突破可以兼得

结语:AI 的未来,就在眼前

DeepSeek-V3.2 不仅仅是一个更强的模型,它代表了一种新的技术路线:

不是简单地堆参数、堆算力,而是通过精妙的架构设计,让每一分计算都用在刀刃上。

从 MoE 的"专家分工",到 MLA 的"压缩记忆",再到 DSA 的"智能聚焦",DeepSeek 团队展示了:创新,才是 AI 竞赛的真正赛道。

下一次当你使用 AI 助手时,不妨想一想:在你输入问题的那一刻,6710 亿个参数中的 370 亿个正在被精准唤醒,256 个专家中的 8 个正在为你会诊,而一个闪电索引器正在从海量信息中为你筛选出最相关的 2048 个知识点。

这,就是 2025 年 AI 的魔法。✨

参考资料

- DeepSeek V3.2 深度研究报告

- DeepSeek-V3.2-Exp 完整分析 - 博客园

- A Technical Tour of the DeepSeek Models - Sebastian Raschka

- DeepSeek V3/R1 架构与训练技术分析 - 知乎

- 小白读懂DeepSeek:从MoE到MLA - 36氪

- DeepSeek-V3 Technical Report - arXiv

- DeepSeek V3.2 正式版发布 - IT之家

- DSA 稀疏注意力技术解析 - CSDN

📝 作者注:本文力求用最通俗的语言解释复杂的技术概念,如有不严谨之处,欢迎技术大佬指正!

🗓️ 更新日期:2025 年 12 月

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)