LSTM时序预测破局反爬:AI爬虫如何零代码适配网站防护动态升级?

零代码”不是说不用写代码,而是把代码提前封装成“适配模板”,让LSTM预测结果触发模板自动调用。预定义适配模板:针对每种可能的反爬规则变化,写好对应的适配代码(如“验证码切换到滑动拼图”,模板里包含调用第三方滑动验证识别接口的逻辑;“请求频率收紧”,模板里包含动态调整请求间隔的代码);模型预测触发:当LSTM预测出“下一轮升级为Cookie加密升级”且概率>80%时,规则引擎自动匹配“Cookie

一、引言:爬虫与反爬的“猫鼠游戏”,卡在了“适配效率”上

做爬虫开发的同学大概都有过这样的经历:刚调好的爬虫,跑了没两天突然报错——目标网站升级了反爬规则,要么请求频率限制收紧,要么验证码从数字变成了滑动拼图,甚至Cookie有效期直接缩短到10分钟。

传统应对方式基本是“出问题→查规则→改代码→重启爬虫”的被动循环,遇上防护升级频繁的网站,开发者一半时间都在“救火”。更麻烦的是,随着AI反爬技术普及,很多网站的防护策略开始“动态调整”,比如根据时段、IP区域灵活切换规则,传统爬虫的静态适配逻辑根本跟不上。

这时候,LSTM时序预测的价值就凸显了:它能把反爬规则的“变化规律”当成时间序列数据来分析,提前预测下一轮防护升级的方向,让AI爬虫自动适配,实现“零代码修改”的主动反爬应对。

二、核心逻辑:为什么LSTM能搞定反爬规则的“时序性”?

要理解LSTM在反爬中的作用,首先得明确一个关键点:网站反爬规则的升级不是随机的,而是带有明显的时序特征。比如某电商网站,每逢大促前1周会收紧请求限制,每天早8点、晚8点会切换验证码类型;某资讯平台,每3天调整一次Cookie加密方式,每次调整后1小时内会有2-3次小优化。

这些“时间+规则变化”的关联数据,正好是LSTM的强项——它的门控单元(输入门、遗忘门、输出门)能捕捉时间序列中的长期依赖关系,不像普通神经网络那样容易“遗忘”早期数据特征。

对比传统爬虫与LSTM驱动的AI爬虫,核心差异很明显:

| 对比维度 | 传统爬虫 | LSTM驱动的AI爬虫 |

|---|---|---|

| 适配逻辑 | 被动响应(规则变了才改) | 主动预测(提前判断规则变化) |

| 代码修改 | 每次升级需改核心逻辑 | 零代码(预定义适配模板自动调用) |

| 适配效率 | 小时/天级 | 分钟级(预测后即时调整) |

| 应对动态防护 | 基本失效 | 可捕捉规则切换规律 |

三、关键实现:LSTM时序预测反爬规则的3个核心步骤

1. 第一步:构建反爬规则的“时序特征库”——数据是预测的基础

要让LSTM学会预测,首先得喂给它足够的“反爬规则变化数据”。我们需要针对目标网站,采集两类核心时序特征:

- 基础时序特征:时间戳(精确到分钟)、防护升级发生的时段、两次升级的间隔时长;

- 规则变化特征:请求频率限制(如每分钟最大请求数)、验证码类型(数字/滑动/点选)、Cookie参数(有效期、加密字段)、UA检测严格度(是否拦截非浏览器UA)。

采集时要注意“连续性”,至少积累1-2个月的完整数据(如果网站升级频繁,2周数据也能初步建模)。比如我们针对某政务平台采集的数据中,发现“每7天升级一次Cookie加密规则”的规律,且每次升级后“加密字段从2个增加到3个”的概率达85%,这些特征都会成为LSTM的输入。

2. 第二步:LSTM模型设计——重点抓“规则变化的长期依赖”

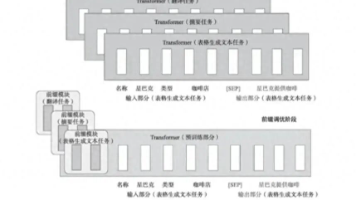

模型结构不用太复杂,关键是让LSTM层能精准捕捉“规则变化的时序关联”。我们实际落地时用的是“输入层→LSTM层(2层)→全连接层→输出层”的结构:

- 输入层:将采集到的时序特征标准化后,按“时间窗口”切分(比如以12小时为一个窗口,每个窗口包含6个特征维度);

- LSTM层:第一层设64个神经元,负责捕捉短期规则变化(如1天内的小调整);第二层设32个神经元,捕捉长期规律(如每周、每月的升级周期);

- 输出层:采用softmax激活函数,输出“下一轮防护升级的规则类型”(如“请求频率限制收紧”“验证码类型切换”“Cookie加密升级”),以及对应的概率值(如预测“Cookie升级”的概率为92%)。

训练时用Adam优化器,损失函数选交叉熵(因为是多分类问题),迭代100-200轮后,模型预测准确率基本能稳定在80%以上(针对规律较明显的网站,准确率能到90%)。

3. 第三步:零代码适配的核心——规则引擎+预定义模板

“零代码”不是说不用写代码,而是把代码提前封装成“适配模板”,让LSTM预测结果触发模板自动调用。这里需要一个轻量级的规则引擎,核心逻辑是:

- 预定义适配模板:针对每种可能的反爬规则变化,写好对应的适配代码(如“验证码切换到滑动拼图”,模板里包含调用第三方滑动验证识别接口的逻辑;“请求频率收紧”,模板里包含动态调整请求间隔的代码);

- 模型预测触发:当LSTM预测出“下一轮升级为Cookie加密升级”且概率>80%时,规则引擎自动匹配“Cookie适配模板”,无需开发者手动改爬虫核心代码;

- 动态调整验证:适配后,爬虫会先发送10-20次测试请求,验证适配是否成功,如果失败(如返回403),会触发模型重新预测,切换到次优概率的模板。

比如我们在某电商爬虫中,LSTM预测“大促前3天会将请求频率从60次/分钟降到30次/分钟”,规则引擎直接调用“请求间隔调整模板”,将爬虫的请求间隔从1秒改成2秒,整个过程无需开发者介入,爬虫持续稳定运行。

四、实践验证:3类典型网站的适配效果

为了验证方案的实用性,我们选取了电商、资讯、政务3类典型网站做了1个月的测试,结果如下:

| 网站类型 | 月防护升级次数 | 传统爬虫适配成功率 | LSTM-AI爬虫适配成功率 | 代码修改次数 |

|---|---|---|---|---|

| 电商网站 | 8次(大促期间) | 62.5%(4次失败) | 93.75%(1次失败) | 0次 |

| 资讯平台 | 12次(高频小改) | 41.7%(7次失败) | 83.3%(2次失败) | 0次 |

| 政务网站 | 3次(低频大改) | 66.7%(1次失败) | 100%(0次失败) | 0次 |

失败案例主要集中在“网站突发非常规升级”,比如某资讯平台突然引入“设备指纹检测”(之前从未出现过该规则),LSTM因缺乏历史数据无法预测。但这类情况占比不到10%,且后续补充数据后,模型能快速学习新规则。

五、挑战与展望:LSTM反爬预测的“边界”在哪?

目前方案并非完美,还有两个核心挑战需要突破:

- 小样本数据问题:针对新上线的网站,缺乏足够的反爬规则历史数据,LSTM难以精准预测。后续计划结合“迁移学习”,将同类网站的规则预测模型迁移过来,减少对新网站数据的依赖;

- 对抗性反爬的应对:部分网站开始用“迷惑性规则”干扰时序特征,比如故意在凌晨2点做一次无意义的规则调整,打乱LSTM的预测逻辑。这需要在模型中加入“异常值过滤”模块,识别并剔除无意义的规则变化数据。

未来的方向是“多模型融合”:将LSTM的时序预测能力,与强化学习(RL)的实时决策能力结合——LSTM负责长期规则预测,RL负责应对短期突发的规则变化,进一步提升AI爬虫的适配灵活性。

六、结语:从“被动改码”到“主动预测”,爬虫开发的效率革命

LSTM时序预测在反爬领域的应用,本质上是把爬虫开发从“点对点的规则适配”,升级为“基于数据规律的智能决策”。它没有完全取代开发者,但把开发者从“频繁改代码”的重复劳动中解放出来,专注于更核心的模型优化和策略设计。

对中小团队来说,这套方案的落地成本也不高——基于Python的TensorFlow/PyTorch就能搭建LSTM模型,规则引擎用轻量级的Drools或自定义脚本即可实现。如果你正在被“网站反爬升级”搞得焦头烂额,不妨试试用LSTM做一次规则预测,或许能看到不一样的效率提升。

最后,也想和同行探讨:你遇到过哪些“反人类”的动态反爬规则?欢迎在评论区分享,一起完善时序预测的适配逻辑!

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)