AI知识科普

人工智能(AI)是计算机科学的分支,旨在让机器模仿人类思维与行为,具备感知、推理和学习能力。其发展经历了多个阶段:早期理论奠基(1941-1956)、专家系统应用(1980-1993)、深度学习崛起(1993至今)。关键突破包括图灵测试、神经网络模型、GPU算力支持以及Transformer架构的诞生。ChatGPT等大语言模型的出现标志着AI技术的成熟。尽管AI在编程等领域展现出替代潜力,但完全

目录

1. 人工智能概念

人工智能,即ArtificialIntelligence,简称Al,是计算机科学的一个分支,旨在让计算机或机器能模仿人类的思维和行为,能看、能听、能说、能学习、能决策,从一个简单的命令执行者,变成一个可以感知、理解、推理、学习等服务与人类的“智慧"伙伴。

为了让机器具有人工智能的能力,需要先让机器看更多的资料去学习,自己总结规律,最后具备预测的能力。

比如想要教计算机智能地识别狗。

可以按照下面步骤来:

人工提取特征:你需要像一个老师一样,先告诉机器,“要看一只狗,你主要检查是否有一个湿润

的、突出的黑色或棕色的鼻子、耳朵的形状和位置、尾巴的长度和姿态(翘起、摇摆、卷起)、有没有胡须、眼睛的形状、毛发的长度和纹理”等特征

选择模型:选择一个合适的机器学习模

训练:把准备好的"狗"和"非狗"的图片喂给模型,每张图片都用定义好的特征(湿鼻子、胡须等)描述好

预测:模型学习后,看到新图片,就会去检查这些预设的特征,然后判断,如果符合狗的特征则就

是狗。

上面的方式就是机器学习,给模型看图片让它自己学。但有一定局限性,因为模型是基于人工提取的特征学习的,如果一张狗的图片是侧面的看不到胡须,或者耳朵折起来了,机器可能就认不出来。

那如果不用人工提取特征,而是:

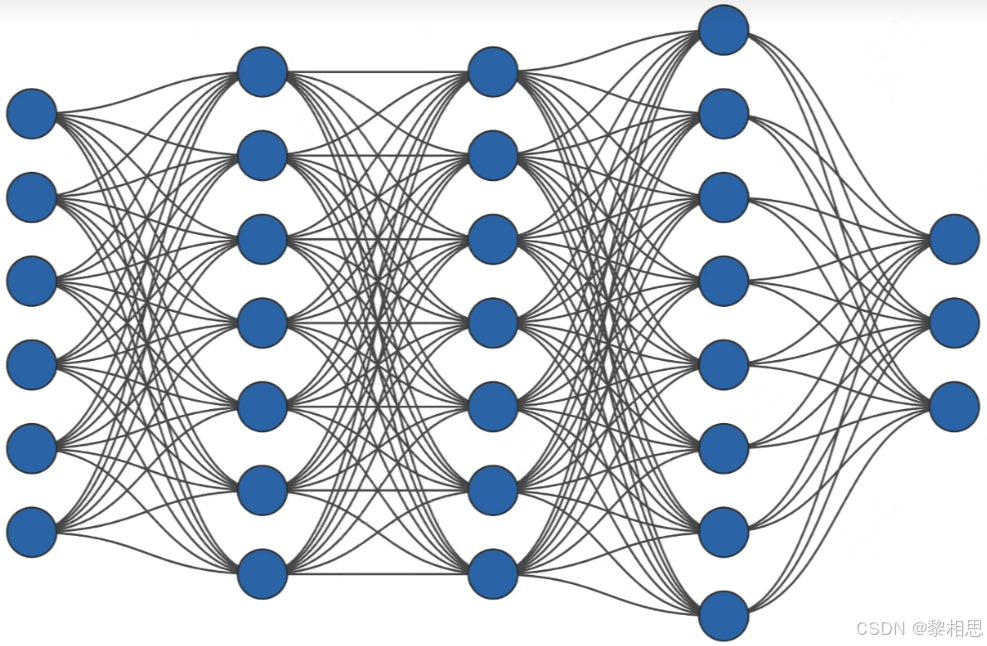

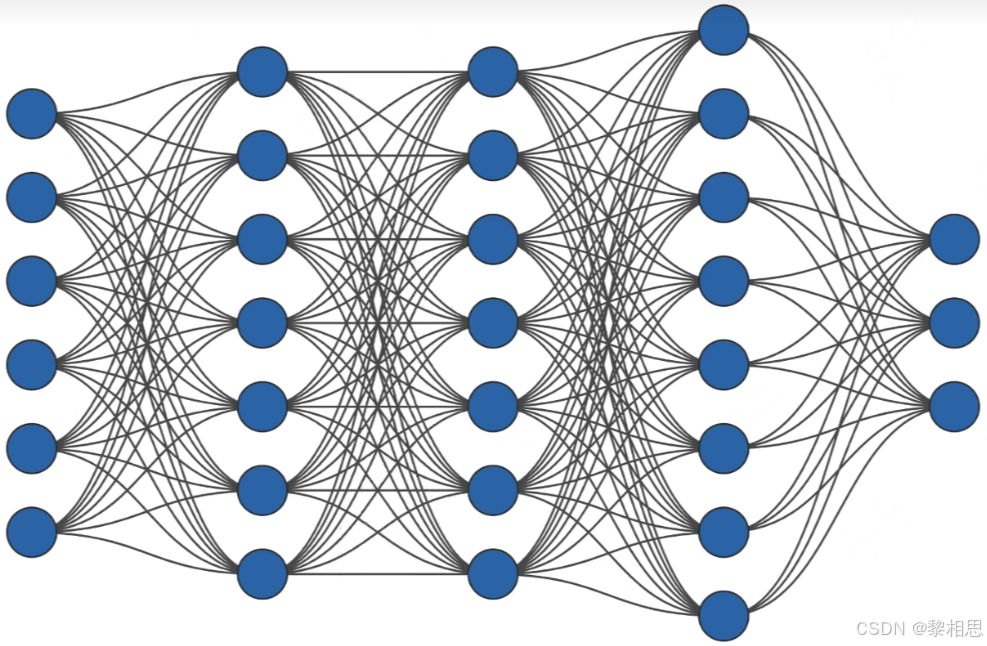

- 端到端学习:把最原始的像素数据(即图片本身)和标签("这是狗"、“这不是狗)直接扔给一个叫做神经网络模型

- 自动提取特征:神经网络结构非常复杂,有很多层(深度),它会自己从像素中,由低到高、由抽象到具体地自动学习出狗的特征:

1、底层:选学会认识一些边缘、角落、颜色

2、中层:组合底层特征,学会识别纹理、形状、眼睛、耳朵

3、高层:结合中层特征,最终形成”狗脸"、"狗的身体”等抽象概念

- 预测:训练好后,它看到新的图片,就会动用自己学到的这一套从简单到复杂的特征(层级体系)来进行判断

这个就是深度学习。对于侧面、遮挡、奇怪姿势的狗,深度学习模型因为它自己学习的特征更丰富、更本质,所以识别能力通常远强于传统机器学习方法。

所以,想要让机器像人一样去识别狗的图片,可以通过看海量图片学习,即机器学习,而完成这个任务最有效的方式就是深度学习。现在大家所看到的酷炫的AI应用,比如人脸识别、语音助手、自动驾驶等,背后都是AI-->ML->DL的技术在发挥作用。

因此一个机器,如果学习大量的数据之后,具备推理预测能力时,我们就可以认为该机器具备人工智能的能力。

而现在ChatGPT、DeepSeek等,都是基于Transformer架构的神经网络模型,投喂海量的数据(网页、书籍、文章)等供模型学习,让模型构建自己的知识库,并具备思考、推理、决策能力,最终成为现在ChatGPT、DeepSeek等人工智能大语言模型产品。

2. 人工智能发展史

在更早的时期,在人类的想象和对机器的向往中,已经埋下了人工智能的影子和思想萌芽。比如战国时期《列子汤问》中就收录了一片文章《偃师献技》

偃师带来了一个他制造的“倡者”(即歌舞艺人)。这个假人能够自如地唱歌跳舞,动作姿态与真人无异。甚至在对周穆王的妃子眉目传情时,惹得穆王大怒,认为偃师用真人欺骗他。偃师为了证明,立刻将这个假人拆解,展示其内部完全是由皮革、木头、胶漆、以及黑、白、丹、青等颜料构成的机关人偶。周穆王这才惊叹道:“人之巧乃可与造化者同功乎?”

AI兴起(1941-1956):人工智能诞生

- 1936年:阿兰·图灵(AlanTuring)发表了《论可计算数及其在判定问题中的应用》,为人工智能的理论基础莫定了重要一步。

- 1943年,神经学家沃伦·麦卡洛克和数学家沃尔特·皮茨在1943年提出了人工神经元模型,用数学方法模拟生物神经元网络,证明简单的神经网络可以实现基本的逻辑功能

假设你现在是一名大二或大三的学生,已经将比特一个方向的课程系统学完,并做出一两个项目,老师推你找实习,而你感觉自己没有复习好,知识点忘记了,在犹豫是否要找实习。假设将催同学找实习的事情交给人工神经网络模型决策,那就需要先输入给模型一些信号(X)和权重(W),比如:

- x1=知识储备现状:同学学完【C语言+数据结构+C+++操作系统+网络+数据库,且还做过小项

权重w1=+7,极强正权重,因为这些技能是企业所需要的,能够找实习的资本 - x2=实习经历:同学找实习欲望不高,但实习经历非常重要

权重w2=+8,实习经历企业非常认可,尤其是大厂实习经历,能大大提高简历通过率 - x3=时间窗口优势:大二或大三,正是找暑期实习的黄金阶段

权重w3=+9,暑期实习表现好很容易转正,直接解决就业,避免挤秋招 - x4=自我怀疑、情性拖延阻力:感觉自己没有复习好,知识点忘记

权重w4=-5,拖延是行动最大的敌人,知识点忘记是正常的,而通过面试检测自己成长是非常快

激活函数阀值设定为15。将所有输入权值求和后,总分超过15,这个神经元就被激活,输出去找实习的决定。

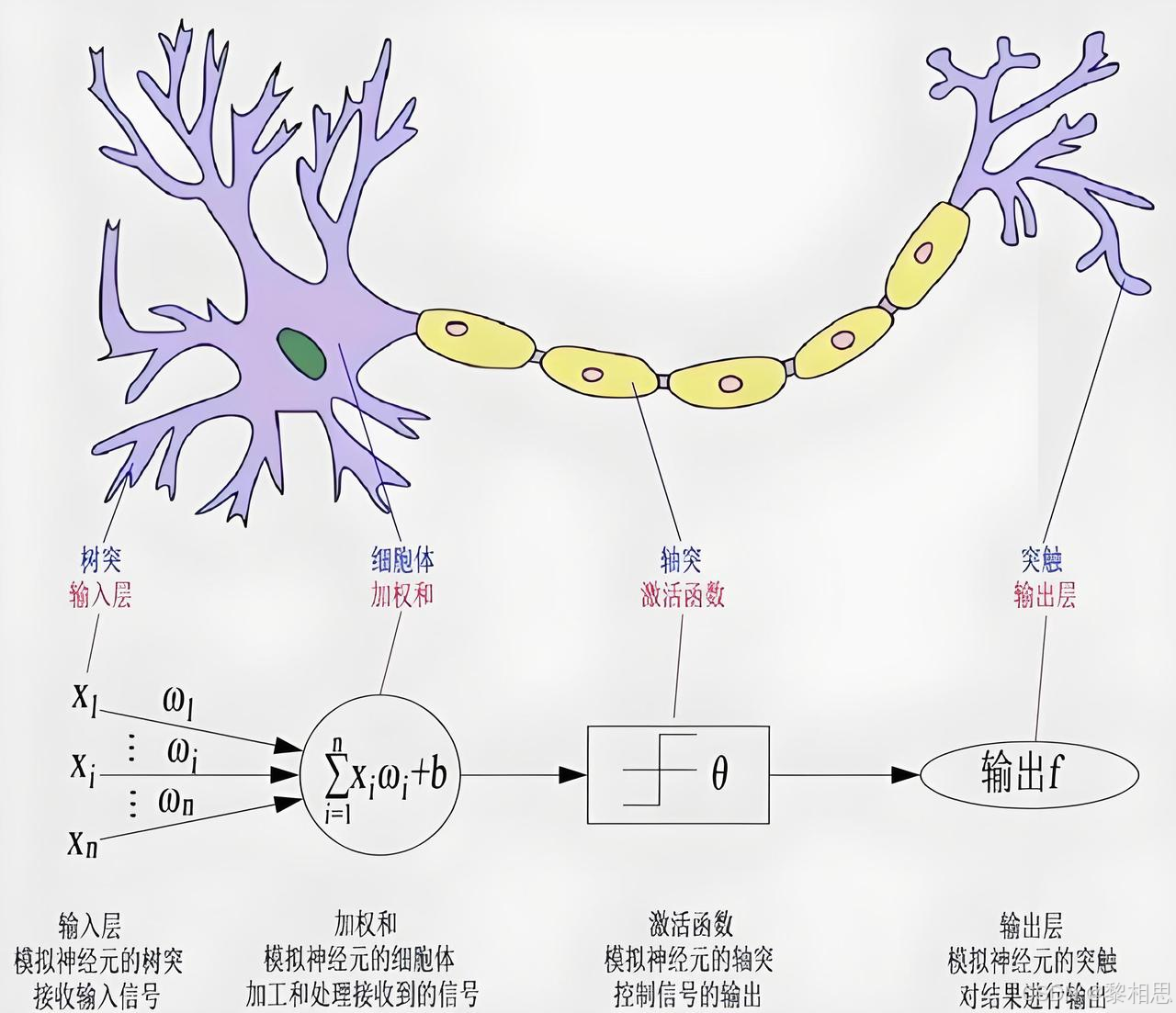

人工神经元模型的核心部分

- 输入:就像树突,接收来自外界或其他神经元的信息

- 权重:每个输入都有一个权重,代表这个输入的重要程度。学习的过程,主要就是调整这些权重大小的过程。

- 求和:把每个输入对应权值全部加起来

- 激活函数:检查求和后的总值是否超过某个”阈值",超过就产生响应;否则就不响应,以实现”开关“特性。

- 输出:就向轴突,将决策结果(0或1)传递出去,给下一个神经元

这个模型成为了后来所有人工神经网络和深度学习的基石

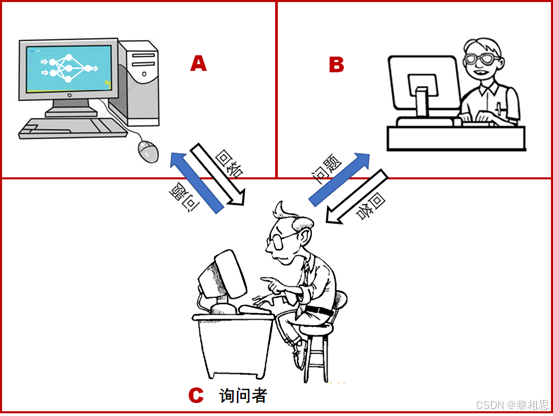

1、1950年,艾伦图灵在其《计算机与智能》论文中提出注明的"图灵测试"

- 场景设置:有一个测试者(人类),和两个被测试对象,其中一个被测试对象是真人,另一个是一个计算机程序(AI)。这两个对象在一个看不见的房间里,测试者测试者只能通过电脑屏幕与他们用文字交流。

- 游戏目标:测试者的任务就是通过一系列提问和对话,最终判断出哪个是真的人,哪个是机器。

- 获胜条件:如果测试者经常错误地将机器判断为人,或者说机器成功“欺骗”了测试者,那么我们就说这台机器通过了图灵测试

比如:你向两个房间提问1234567+7654321等于多少?

A房间会话你:等于8888888

B房间回答你:我现在不想算

你现在能区分清那个房间时机器,哪个房间时真人吗?如果无法区分,那这台机器就通过了图灵测试。

图灵的想法很实用:别管它内部是怎么运作的,只要它的行为表现得和人一样智能,我们就当它是智能的。

1956年图灵的这篇文章以“机器能够思考吗?”为题重新发表

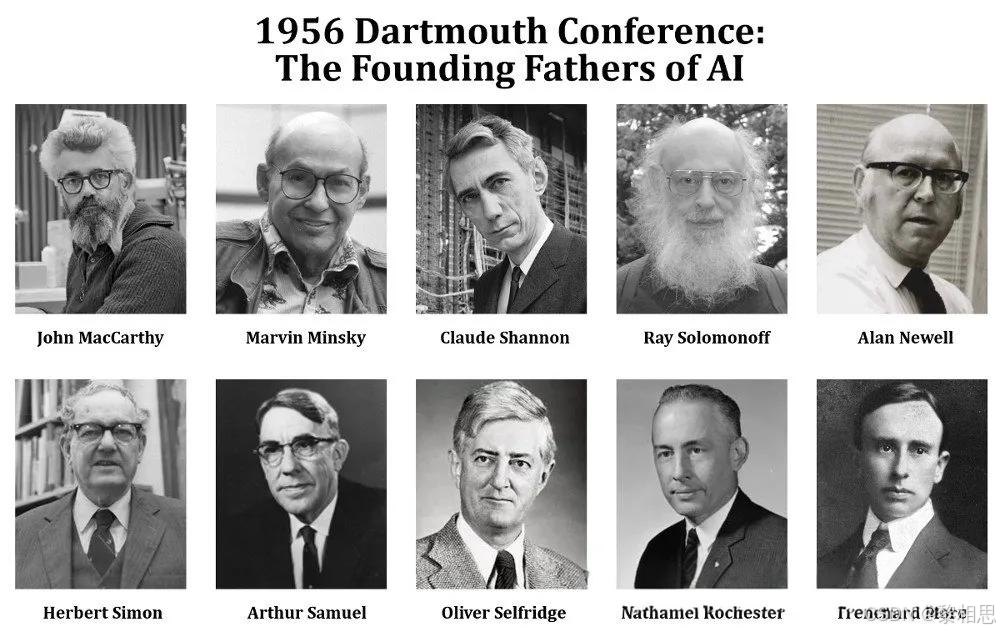

2、1956年,在美国达特茅斯学院汇聚了那个时代最聪明的一批人,他们坐在一起开了个会,会议主题是“试图让机器精确模拟学习或其他智能行为",该次会议也被称作”AI的宪法会议”,约翰·麦卡锡首次提出“人工智能”一词。

AI早期成功(1956-1974)

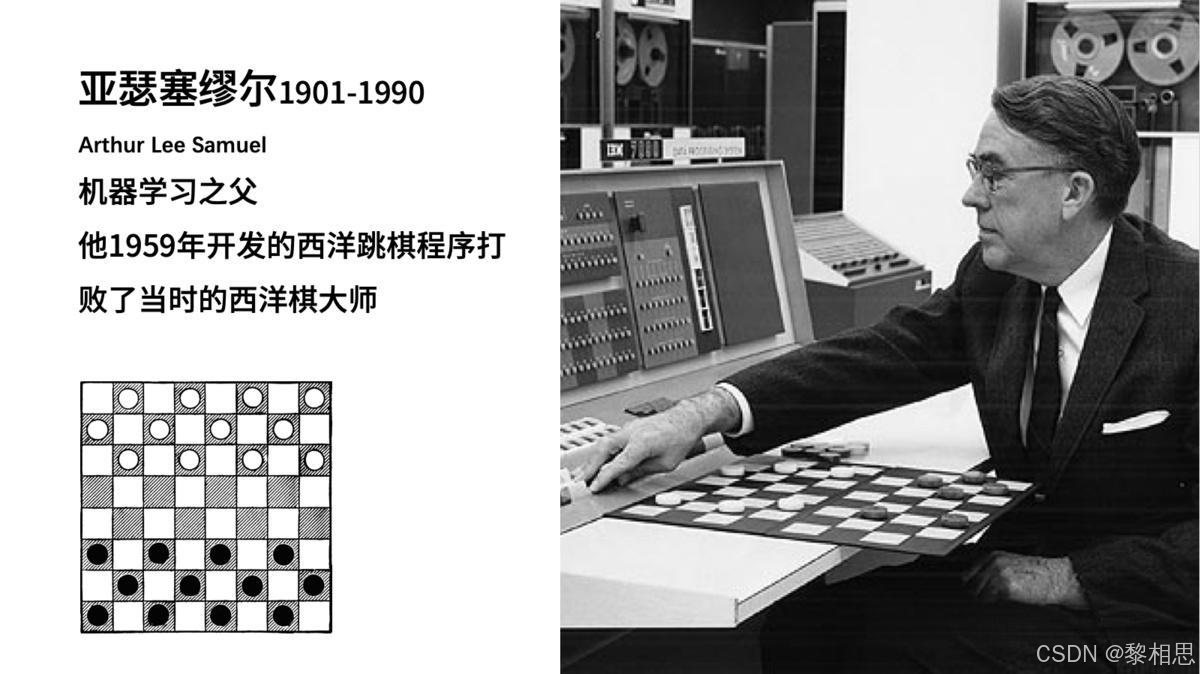

- 1959年,亚瑟·塞缪尔开发了首个自学习程序-西洋跳棋程序,并引入了“机器学习”这一概念

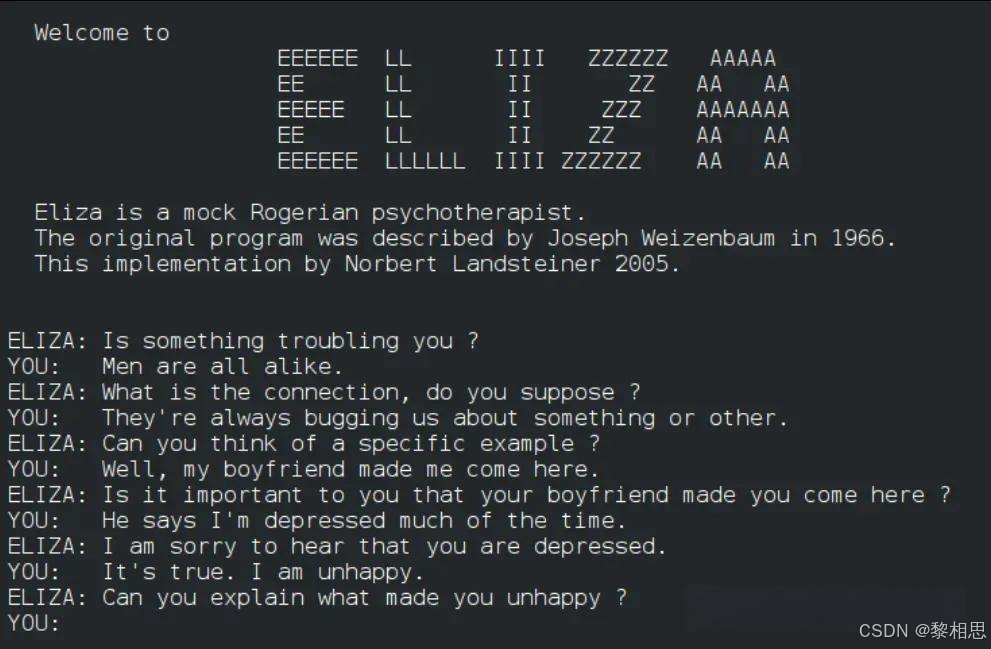

- 1966年,约瑟夫·魏岑保姆开发了一个能力处理自然语言的聊天程序ELIZA,据说是第一个能够尝试图灵测试的程序,展示了机器和人类自然语言交流的可能性。

号称心理治疗师,比如:

你说:我很烦恼

ELIZA:你会经常烦恼吗?

ELIZA用程序的方式模拟提问,形成一种心理咨询的效果,其实就是模式匹配,号称心理治疗师。虽然简单,但是给人感觉机器很懂我。

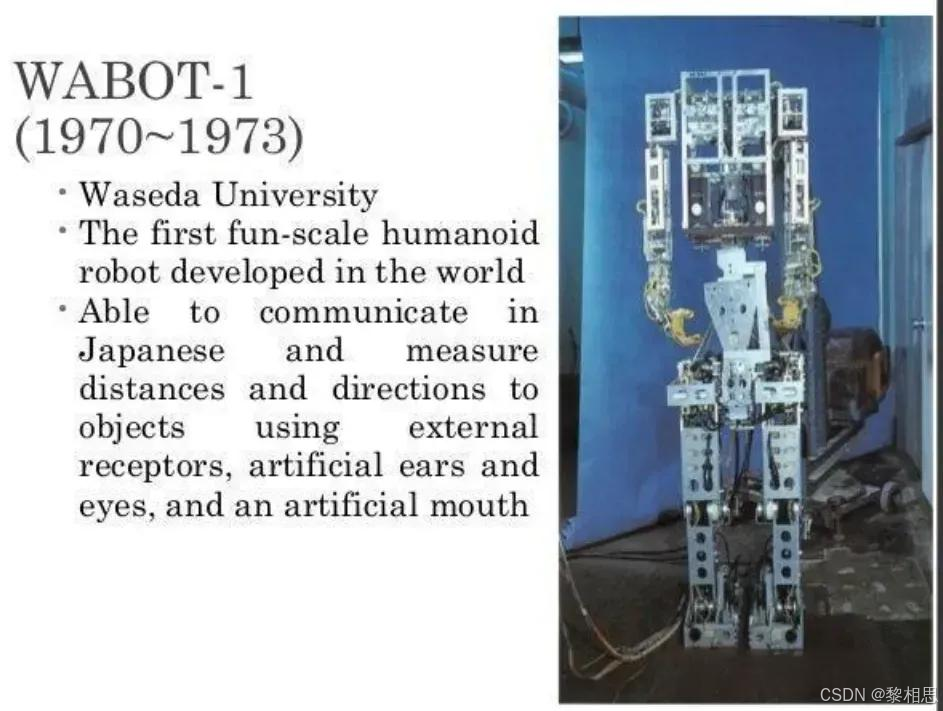

- 1970年,第一个拟人机器人WABOT-1在日本早稻田大学建成。它由一个肢体控制系统、视觉系统和一个对话系统组成。

首次将视觉、触觉、移动和对话能力整合到一个拟人化的平台上。它确立了“人形机器人”作为一个综合性研究领域的地位。

AI第一次寒冬:神经网络预冷,研究经费减少(1974-1980)

上世纪60年代末到70年代初,人工智能开始从高峰走向低估,因为早起雄心勃勃的AI项目没有兑现,政府和资方对AI的耐心逐渐耗尽,大笔研究经费被削减甚至叫停:

- 机器翻译碰壁

- 大西洋彼岸质疑

- 军方撤资

- 学术批评

上述原因交织在一起,导致70年代中期AI研究陷入停滞,AI项目被砍,研究经费锐减,年轻人才专项爱过你别的领域,只有少数学者在坚守阵地。

AI复兴与第二次寒冬(1980-1993)

AI领域出现复苏的迹象主要是由于:

- 专家系统在工业界的成功应用

- 机器学习思想兴起

专家系统就是模拟人类专家决策的计算机系统,它把专家的知识和经验编程规则存进电脑里,然后向专家一样分析问题并给出建议。

专家系统的核心组成:

- 知识库:类似专家的大脑,里面存储了许多“如果-那么"的规则和专业知识

- 推理机:类似专家的思维过程。它负责提问、根据用户回答去知识库查找匹配规则,进行逻辑推理并得出答案

- 用户界面:和系统对话的窗口

但好景不长专家系统的局限性逐渐暴露,他们的开发和维护成本高,需要专家不断提供规则,无法自动学习新知识;其次系统脆弱,一旦遇到超出规则范围的情况可能犯荒唐的错误。

随着微型计算机性能提升,性能逐渐超越运行专家系统的AI工作站,大量AI创业公司在短时间内破产或被收购,免子人兴趣转移,到1993年前后超过300加A1公司关门,迎来了AI的第二次寒冬。

庆幸的是AI技术并未止步不前,而在其他领域悄然发展,比如:数据挖掘、工业机器人、语音识别、搜索引擎都在90年代获得突破性进展。

1991年,互联网的出现使在线连接和数据共享成为可能,无论你是谁,无论你在哪里。由于数据是人工智能的燃料,这在以后将被理解为人工智能的一个关键时刻。

AI崛起:深度学习理论和工程突破(1993年至今)

- 1997年,IBM的深蓝(DeepBlue)战胜了国际象棋冠军卡斯帕罗夫,成为首个在标准比赛时限内击败国际象棋世界冠军的电脑系统。

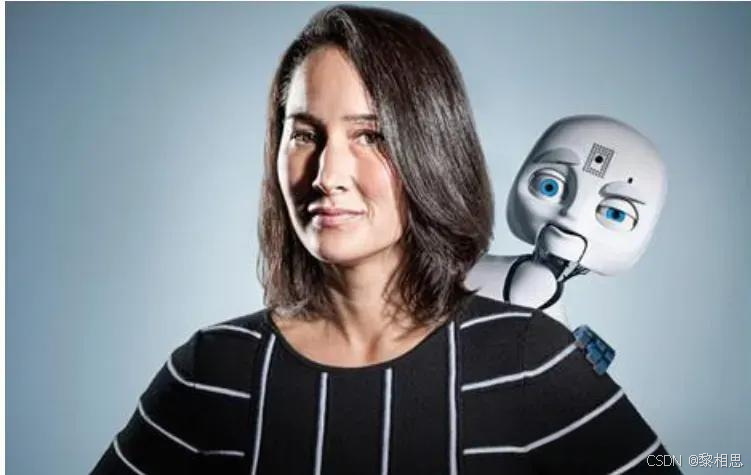

- 2000年,麻省理工学院的辛西娅-布雷泽尔开发了Kismet,一种能够识别并模拟人类情绪的机器人。

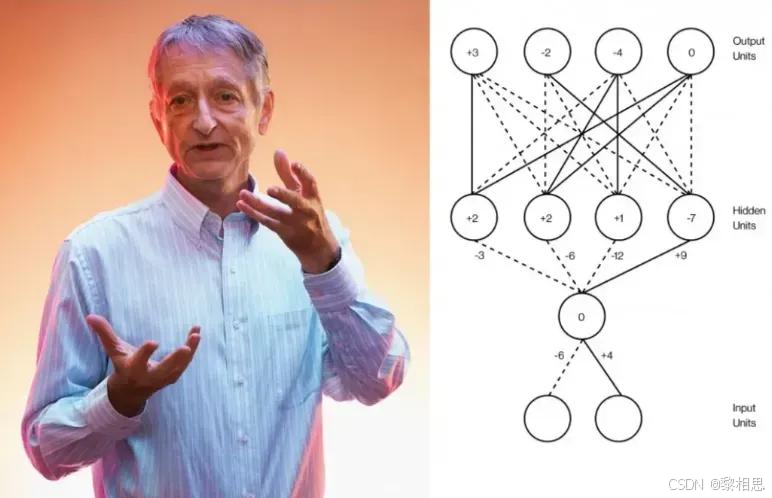

2006年,杰弗里·辛顿等人发表重要论文《Reducingthedimensionality of data with neural networks(用神经网络降低数据维数)》,提出了深度置信网络(DeepBeliefNetwork),为深度学习的发展莫定了基础。杰弗里·辛顿也被称为深度学习教父。

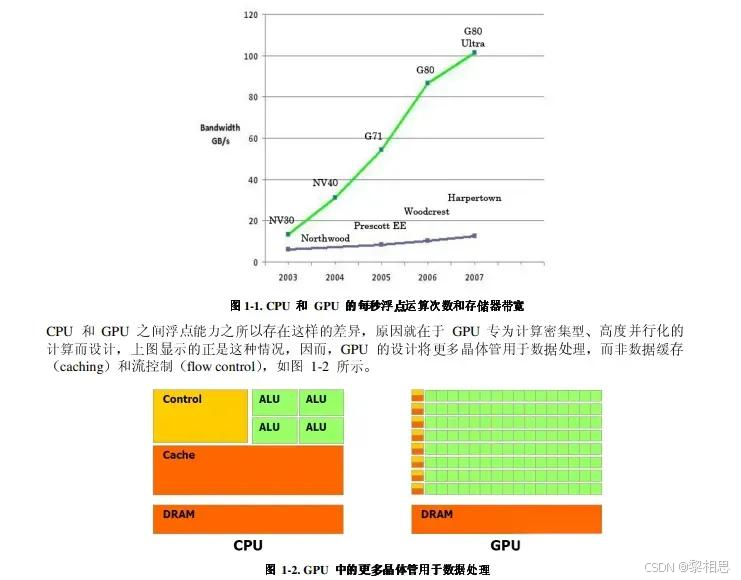

- 2006年,英伟达推出CUDA(统一计算架构),GPU开始用于解决商业、工业以及科学方面的复杂计算,GPU与深度学习结合,模型的训练速度有了数量级的提升

- CPU(中央处理器):像是一个博学的老教授。他非常聪明,什么复杂任务都能处理,比如操作系统、办公软件,但一次只能处理一两件事(核心数少)。让他去数一亿粒米,他会数得很精确,但速度非常慢。

- GPU(图形处理器):最初是为游戏和图形渲染设计的。它像是一万名小学生。每个小学生都不如老教授聪明,只能执行非常简单的指令(比如算术题)。但让他们同时去数一亿粒米,每人分一点,瞬间就数完了。

AI计算(优其是深度学习)的本质是什么?

就是海量的、高度重复的矩阵乘法和加法。比如,识别一张猫的图片,需要将数百万个像素值与神经网络中数百万个参数进行乘法和加法运算。这个过程不需要一个”老教授”去深度思考,恰恰需要"一万名小学生“同时进行简单的计算。GPU的并行计算架构完美匹配了AI计算的需求。

更重要的是英伟达还发明了CUDA(ComputerUnified DeviceArchitecture,统一计算机架构),构建了一整个AI生态系统。CUDA是一个软件平台,它允许程序员和研究人员用熟悉的编程语言(如C++、Python)直接调用GPU的强大算力来进行通用计算。

今天所有震撼世界的AI产品,如ChatGPT、Sora等,它们的训l练和运行都完全依赖与数万甚至数十万颗GPU组成的超级计算机,没有这个算力基础,当前的大模型就不可能存在。英伟达是AI时代的“卖铲人”。当全世界都在疯狂淘金(开发A)时,英伟达提供了最好用、几乎是唯一的“铲子”(GPU+CUDA),从而成为了整个浪潮中最大的赢家之一。

- 2012年,谷歌"GoogleBrain"项目的研究人员吴恩达、杰夫·迪恩等人,也捣鼓了一个神经网络(10亿参数),用来训练对猫的识别。他们用16000个CPU核心构建了一个巨大的神经网络,在没有任何先验知识的情况下,仅仅通过观看YouTube视频,就自发地识别出了“猫”。这个实验让工业界第一次大规模地看到了深度学习的惊人潜力。

2015年,GoogleBrain团队正式发布TensorFlow机器学习框架,提供了一整套用户构建和训l练机器学习模型的工具、库和社区资源,由于其通用性和强大功能,被广泛应用于计算机视觉、自然语言处理、语音处理、推荐系统等。TensorFlow作为基础工具基石,其应用领域几乎涵盖了AI的方方面面。

2017年,Google Al团队在论文《Attention Is All YouNeed》中首次提供了Transformer模型架构,论文发布后其参考实现代码页随之公开,并迅速被纳入TensorFlow、PyTorch等框架的官方库和教程中。Transformer的诞生,为后续几乎所有大型语言模型提供了最基础也最关键的架构蓝图。现在DeepSeek、ChatGPT、Gemini基本都是基于Transformer实现的。

- AlphaGo战胜人类顶尖围棋选手

- 2022年11月30日,ChatGPT发布,彻底突破科技圈,它提供了一个及其简单、自然、免费的聊天界面,任何人无需技术背景,都能直接与其互动。它能写诗、写代码、解数学题、编故事,回答各种问题,震惊了无数人。用户们开始在各种社交平台,病毒式分享自己与ChatGPT对话的惊人截图,短短5天内,ChatGPT的用户就图片100万。

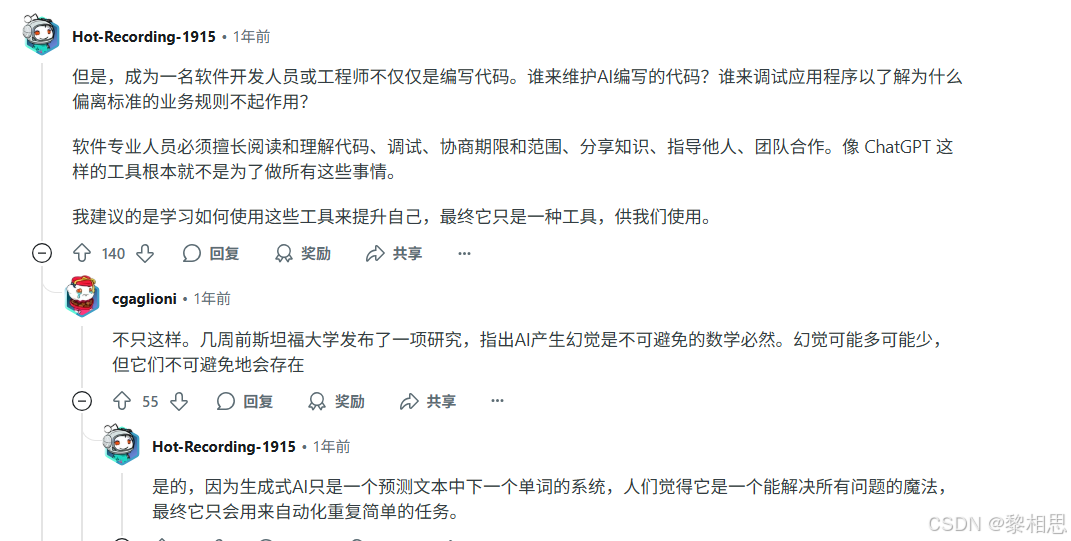

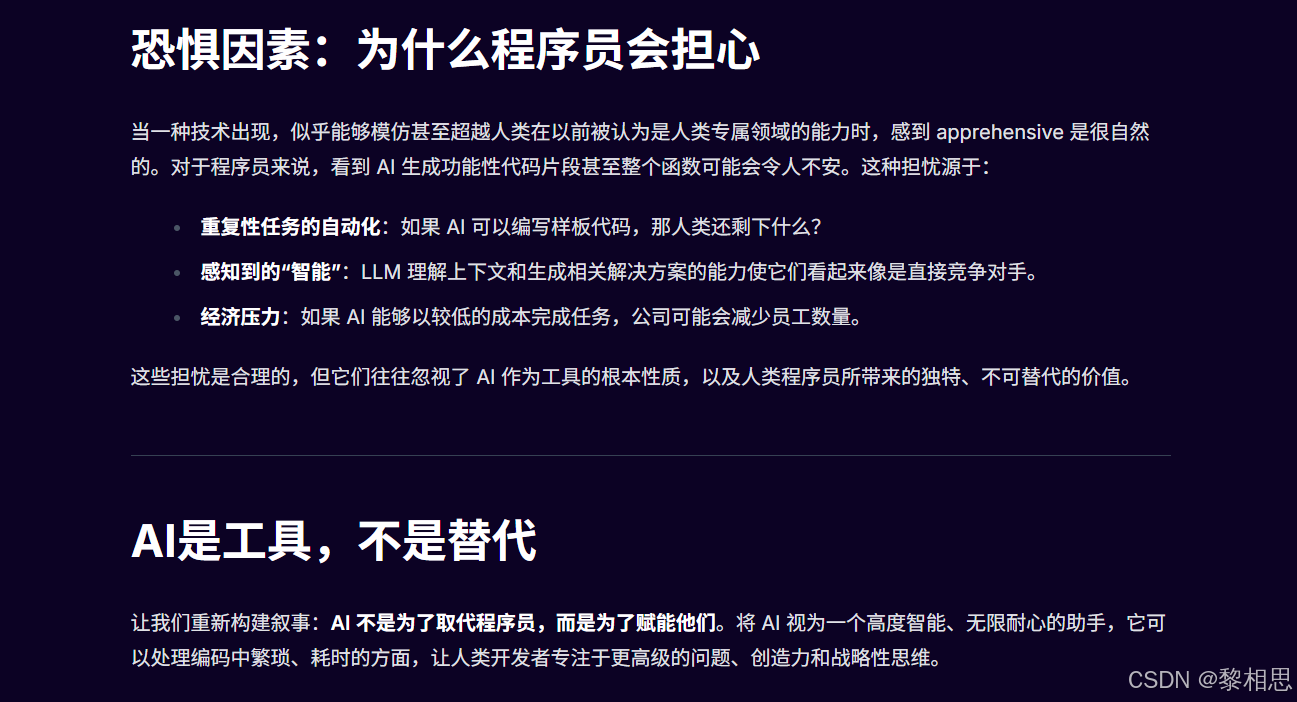

3. 程序员是否会被AI取代

同学们平时在看新闻或刷视频时应该会看到,一些博主在视频中演示说:

- 某款AI编程IDE写代码非常丝滑,自己一行代码不写就完成了某个应用

- 不懂任何代码,通过向AI输入提示词,完成某个应用

- AI替代程序员真的要来了,公司20%的代码已由AI生成,公司计划裁员...

- AI来了,程序员天踏了;AI当立、编程已死...

看到这些帖子或视频之后,不知道同学们是否感觉:还没有毕业,就感觉失业了,渐渐就开始摆烂了

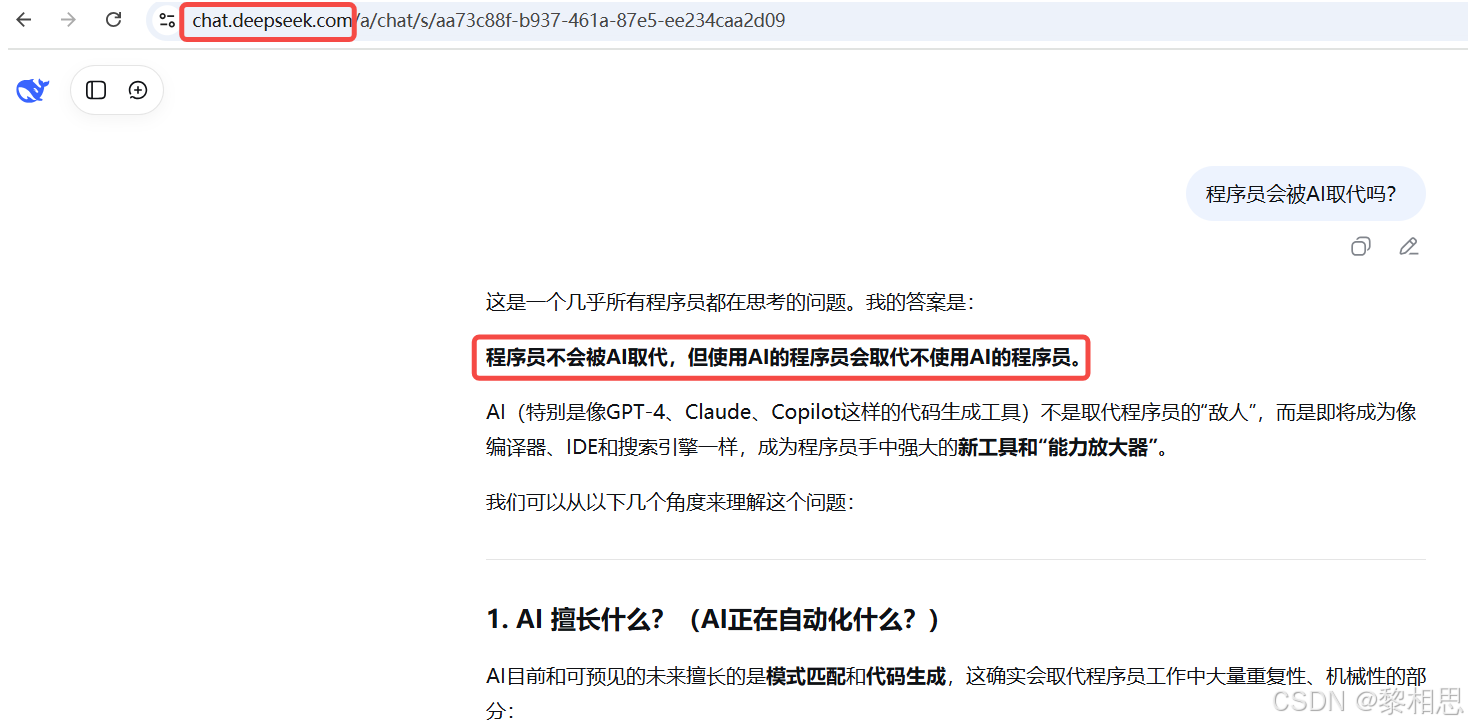

DeepSeek认为:

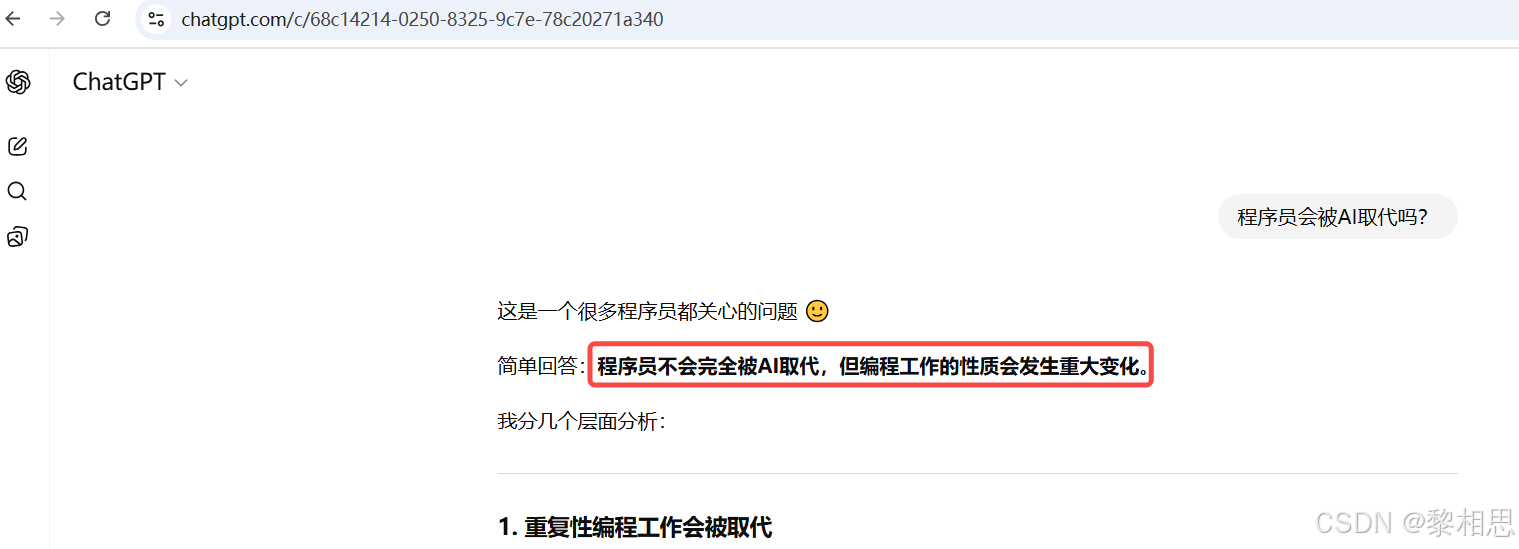

ChatGPT认为:

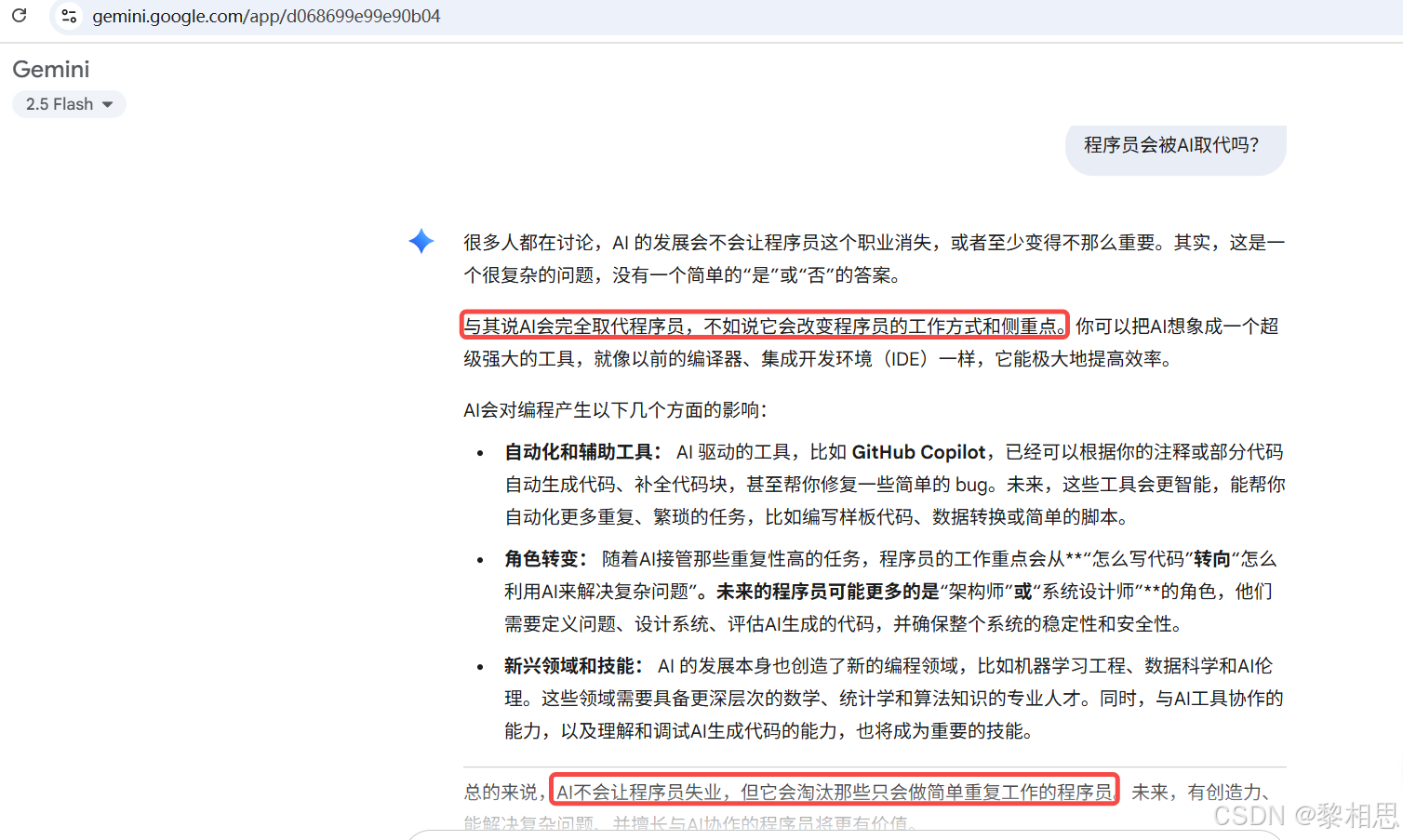

Gemini认为:

中国科普网的一篇文章:AI取代程序员还不太现实 -中国科普网

以后得事情谁也不好说,先顾好眼前少点焦虑:打得过就大,打不过就加入,你可能就业的不是AI相关领域,但是你不能不懂AI相关技术。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)