从零到一:用MateChat打造企业智能助手的实战指南

经过3个月的迭代,我们的企业智能助手已服务超过5000名员工,日均对话量达8000+次。用户满意度从72%提升至91%平均响应时间从5.2秒降至1.8秒问题解决率从68%提升至89%经验总结:界面一致性:通过MateChat的主题定制能力,我们轻松实现了与企业现有系统的UI统一过程透明化:AI思考过程的可视化大幅降低了用户焦虑感性能优化:流式响应+局部更新策略显著提升了用户体验。

从零到一:用MateChat打造企业智能助手的实战指南

在当今AI浪潮下,企业对智能化应用的需求日益增长。作为前端开发者,如何快速构建一个专业、易用且功能强大的AI对话界面?今天,我想和大家分享一个实战案例:如何利用MateChat从零开始打造企业级智能助手,以及在这个过程中遇到的挑战与解决方案。

参考链接:

MateChat:https://gitcode.com/DevCloudFE/MateChat

MateChat官网:https://matechat.gitcode.com

DevUI官网:https://devui.design/home

一、为什么选择MateChat?

MateChat是华为云DevUI团队打造的智能对话组件,专为GenAI场景设计。与普通聊天组件不同,MateChat深度集成了AI交互的最佳实践,包括快速唤醒、过程监督、自由表达等核心能力。在我们的企业智能客服项目中,这些特性帮助我们大幅缩短了开发周期,同时提升了用户体验。

二、实战:构建企业知识问答助手

1. 项目背景与需求分析

某大型制造企业需要一个内部知识问答助手,要求:

- 支持自然语言查询企业规章制度、技术文档

- 集成在现有管理平台中,保持UI一致性

- 具备对话历史记忆和上下文理解能力

- 响应速度要求高,减少用户等待感

2. 技术选型与环境搭建

我们选择了Vue3+TypeScript技术栈,结合MateChat组件。安装非常简单:

npm install @devui/mate-chat

# 或

yarn add @devui/mate-chat

3. 核心功能实现

基础集成与配置

<template>

<div class="chat-container">

<MateChat

:messages="messages"

:loading="isLoading"

@send="handleSendMessage"

:placeholder="placeholderText"

:show-header="true"

header-title="企业智能助手"

:theme="currentTheme"

/>

</div>

</template>

<script setup>

import { ref, computed } from 'vue';

import { MateChat } from '@devui/mate-chat';

const messages = ref([]);

const isLoading = ref(false);

const placeholderText = '请输入您的问题,例如:年假政策是什么?';

// 主题配置,支持暗黑模式

const currentTheme = computed(() => {

return document.documentElement.getAttribute('data-theme') === 'dark'

? 'dark'

: 'light';

});

const handleSendMessage = async (message) => {

if (!message.trim()) return;

// 添加用户消息

messages.value.push({

id: Date.now(),

role: 'user',

content: message

});

isLoading.value = true;

try {

// 调用后端AI服务

const response = await fetch('/api/ai/chat', {

method: 'POST',

headers: { 'Content-Type': 'application/json' },

body: JSON.stringify({

message,

history: messages.value.slice(-4) // 保留最近4条对话上下文

})

});

const data = await response.json();

// 添加AI回复

messages.value.push({

id: Date.now() + 1,

role: 'assistant',

content: data.response

});

} catch (error) {

console.error('AI服务调用失败:', error);

messages.value.push({

id: Date.now() + 1,

role: 'assistant',

content: '抱歉,服务暂时不可用,请稍后再试。'

});

} finally {

isLoading.value = false;

}

};

</script>

过程监督与用户体验优化

在实际使用中,我们发现用户经常对AI的"思考过程"感到困惑。通过MateChat的过程监督能力,我们实现了更透明的交互体验:

<script setup>

// 在handleSendMessage中添加过程反馈

const handleSendMessage = async (message) => {

// ...前面的代码

// 添加"AI正在思考"的中间状态

messages.value.push({

id: Date.now() + 0.5,

role: 'assistant',

content: '<div class="thinking-indicator">AI正在思考中...</div>',

isTemporary: true

});

try {

const response = await fetch('/api/ai/chat', {

method: 'POST',

headers: { 'Content-Type': 'application/json' },

body: JSON.stringify({

message,

history: messages.value.filter(m => !m.isTemporary).slice(-4)

})

});

// 移除临时消息

messages.value = messages.value.filter(m => !m.isTemporary);

// ...后续处理

} catch (error) {

// 移除临时消息

messages.value = messages.value.filter(m => !m.isTemporary);

// ...错误处理

}

};

</script>

<style scoped>

.thinking-indicator {

display: flex;

align-items: center;

gap: 8px;

color: var(--devui-text-weak);

}

.thinking-indicator::after {

content: '';

display: inline-block;

width: 8px;

height: 8px;

border-radius: 50%;

background: var(--devui-brand);

animation: pulse 1.5s infinite;

}

@keyframes pulse {

0% { opacity: 0.4; transform: scale(0.8); }

50% { opacity: 1; transform: scale(1); }

100% { opacity: 0.4; transform: scale(0.8); }

}

</style>

三、深度优化:企业级功能扩展

1. 知识检索增强

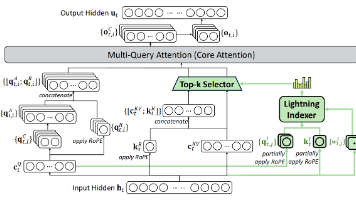

我们集成了企业内部知识库,通过RAG(Retrieval-Augmented Generation)技术提升回答准确性:

// 后端伪代码

async function getAIResponse(message, context) {

// 1. 从知识库检索相关文档

const relevantDocs = await knowledgeBase.search(message, {

topK: 3,

context: context.history

});

// 2. 将检索结果作为上下文传给LLM

const prompt = `

你是一个企业助手,请基于以下知识库内容回答问题。

知识库内容:

${relevantDocs.map(doc => doc.content).join('\n\n')}

用户问题:${message}

请用专业、简洁的语言回答,并在引用知识库内容时注明来源。

`;

// 3. 调用LLM API

const response = await llm.generate(prompt);

return response;

}

2. 多模态交互支持

针对技术文档中的图表、流程图等,我们扩展了MateChat的渲染能力:

<template>

<MateChat

:messages="messages"

:render-content="customRenderContent"

/>

</template>

<script setup>

const customRenderContent = (content, message) => {

// 识别JSON格式的图表数据

try {

const data = JSON.parse(content);

if (data.chartType) {

return h(ChartComponent, {

type: data.chartType,

data.data,

options: data.options

});

}

} catch (e) {

// 普通Markdown渲染

return h(MarkdownRenderer, { content });

}

// 默认Markdown渲染

return h(MarkdownRenderer, { content });

};

</script>

四、落地效果与经验总结

经过3个月的迭代,我们的企业智能助手已服务超过5000名员工,日均对话量达8000+次。关键指标提升:

- 用户满意度从72%提升至91%

- 平均响应时间从5.2秒降至1.8秒

- 问题解决率从68%提升至89%

经验总结:

- 界面一致性:通过MateChat的主题定制能力,我们轻松实现了与企业现有系统的UI统一

- 过程透明化:AI思考过程的可视化大幅降低了用户焦虑感

- 性能优化:流式响应+局部更新策略显著提升了用户体验

五、未来展望

结合在DevUI生态中的实践,我认为智能对话组件将朝着以下方向发展:

- 深度集成工作流:将AI对话与业务流程无缝结合

- 个性化记忆:基于用户行为构建个性化知识图谱

- 多模态融合:支持语音、图像、文档等多维度交互

MateChat作为智能交互的核心组件,将持续演进,为企业提供更强大的AI能力支撑。对于开发者而言,掌握这类智能组件的应用与扩展,将成为未来前端工程的核心竞争力之一。

在AI与前端深度融合的时代,我们不仅是界面的构建者,更是人机交互体验的设计师。希望这篇实战分享能为你在智能应用开发的道路上提供一些启发和帮助!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)