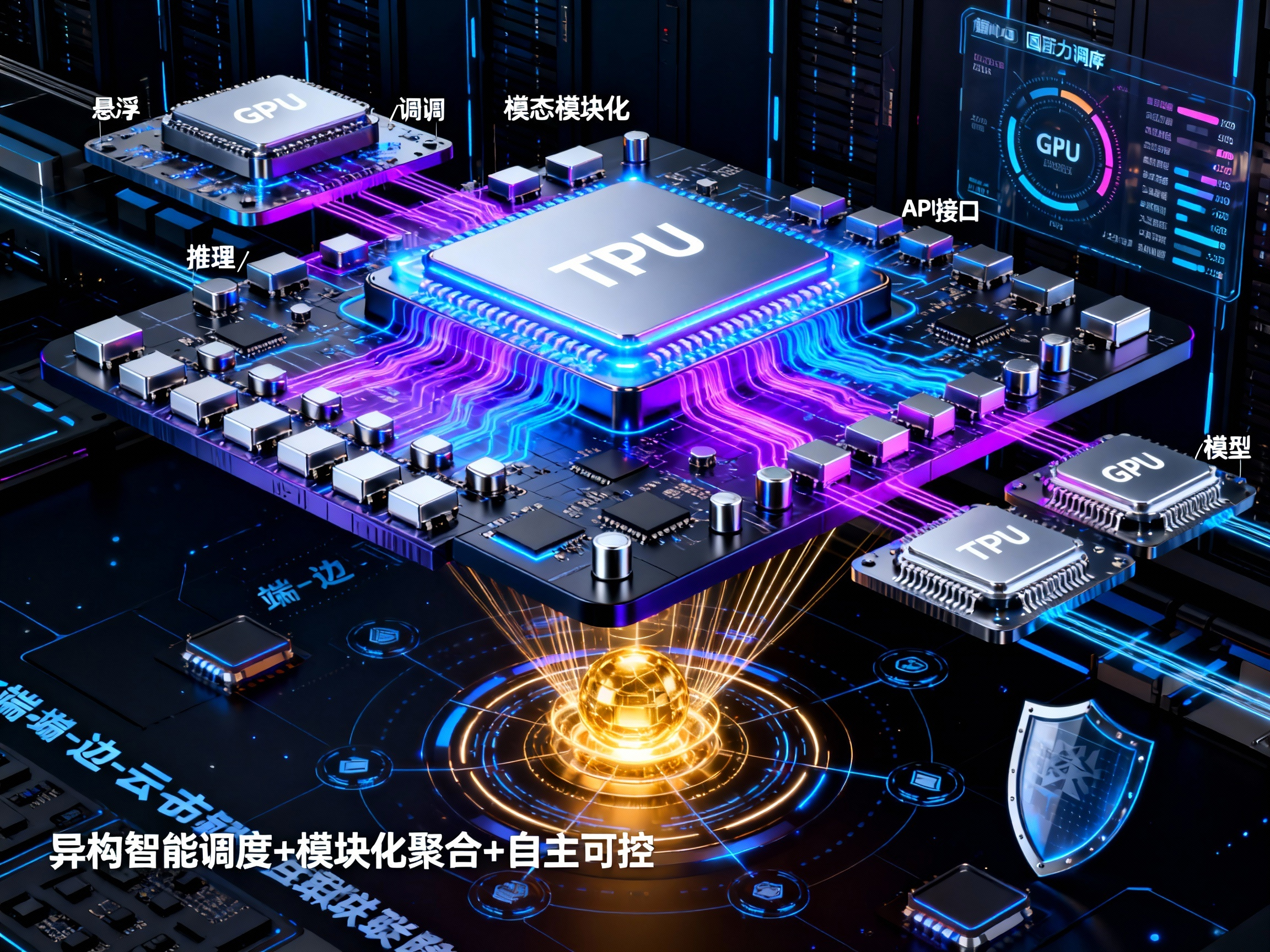

异构共生与自主可控:聚合模型 API 算力平台的三大进化路径

谷歌TPU的崛起推动AI算力进入异构共生时代,聚合模型API平台随之呈现三大趋势:1)算力调度向异构智能升级,实现TPU/GPU/国产芯片的协同优化;2)模型聚合从数量堆砌转向模块化轻量化,支持商业/开源/自研模型混合调用;3)底层技术从依赖第三方转向自主可控,构建调度引擎、安全机制和硬件适配的闭环能力。未来平台需在智能调度、模块聚合和自主创新方面突破,才能真正成为企业AI落地的算力中枢。

随着谷歌 TPU 芯片在 AI 算力领域的强势突围,专用芯片与通用 GPU 的异构共生格局逐渐清晰。这一行业变革不仅重塑了算力硬件的竞争逻辑,更给聚合模型 API 算力平台带来了全新的发展启示。作为连接模型生态与企业需求的核心枢纽,聚合模型 API 算力平台正告别 “单纯模型堆砌” 的初级阶段,朝着更高效、更灵活、更自主的方向演进,其未来发展还将呈现三大关键趋势。

一、算力调度:从 “硬件适配” 到 “异构智能调度”

谷歌 TPU 的成功,核心在于 “专用架构 + 软硬一体优化” 的精准定位 —— 聚焦 AI 推理场景的高吞吐量需求,与英伟达 GPU 形成功能互补。这一逻辑延伸到聚合模型 API 算力平台,将推动算力调度从 “被动适配单一硬件” 向 “主动异构协同” 升级。

未来的聚合平台不再是简单对接 GPU 算力资源,而是构建支持多芯片架构的统一调度体系:既能识别 TPU、AWSTrafium 等专用 ASIC 芯片的优势场景(如大规模并行推理),也能发挥英伟达 GPU 在通用训练、多任务处理中的生态优势,甚至兼容国产自主芯片的算力输出。通过智能任务拆解与资源匹配算法,平台可根据用户的 API 调用需求(如实时推理、批量训练、低延迟响应),自动分配最优算力组合 —— 例如将高频轻量化推理任务导向 TPU 集群,将复杂模型微调任务分配给 GPU 资源,实现 “算力按需分配、效能最大化”。

这种异构调度能力的核心,是平台对底层硬件特性与上层模型需求的深度理解。正如谷歌通过 Gemini 模型与 TPU 的深度适配提升算力利用率,聚合平台也需要建立 “模型 - 硬件” 适配知识库,针对不同架构芯片优化 API 调用的传输协议、计算拆分逻辑,让异构算力真正形成协同效应而非简单叠加。

二、模型聚合:从 “数量堆砌” 到 “模块化轻量化融合”

当前聚合模型 API 平台多以 “支持 N 种模型” 为宣传亮点,但随着模型规模扩大与企业需求精细化,单纯的数量优势已无法满足实际应用场景。借鉴谷歌 “模型与硬件协同优化” 的思路,未来平台的核心竞争力将转向 “模块化聚合与轻量化适配”。

一方面,平台会将大模型拆分为可复用的功能模块(如推理模块、微调模块、多模态转换模块),用户可通过 API 灵活组合调用,无需加载完整模型即可完成特定任务,大幅降低算力消耗与响应延迟。另一方面,平台将针对不同算力硬件进行模型轻量化优化,例如为 TPU 定制低精度推理模型、为边缘 GPU 适配压缩版多模态模型,让 API 调用在各类硬件环境下都能保持高效稳定。

此外,模型生态的 “混合聚合” 也将成为趋势:平台不仅整合主流商业大模型,还会引入优质开源模型,并提供统一的 API 接口标准与适配工具链。企业既能通过 API 快速调用成熟商业模型满足核心需求,也能基于开源模型进行二次开发并接入平台调度,形成 “商业模型 + 开源模型 + 自研模型” 的混合使用场景,兼顾效率与成本控制。

三、底层能力:从 “依赖第三方” 到 “自主可控核心化”

谷歌 TPU 的突围验证了 “自研是终极底气” 的行业逻辑 —— 只有掌握底层核心技术,才能在算力竞争中掌握主动权。这一逻辑同样适用于聚合模型 API 算力平台,未来平台的竞争将下沉到 “自主可控的底层技术能力”。

首先是调度引擎自研化:平台需突破第三方调度工具的限制,自主开发支持异构算力的调度核心,优化任务排队、资源分配、负载均衡算法,提升算力利用率与 API 调用稳定性。例如借鉴谷歌 AlphaChip AI 设计技术,通过算法优化芯片与模型的适配效率,实现算力资源的动态调度与智能扩容。

其次是安全可控能力强化:平台将构建 “端 - 边 - 云” 一体化的混合算力调度体系,支持企业本地算力与云端算力的无缝衔接。通过自研数据加密传输协议、本地算力隔离机制,保障 API 调用过程中的数据安全与合规性,满足金融、医疗等敏感行业的需求。

最后是硬件适配能力自主化:平台将建立专属的硬件适配实验室,针对新推出的算力芯片(如国产自主芯片、新型 ASIC 芯片)快速完成兼容性测试与优化,无需依赖芯片厂商提供的适配工具,缩短新技术落地周期,形成 “硬件 - 软件 - API” 的自主闭环。

结语

聚合模型 API 算力平台的发展,本质是算力生态、模型生态与企业需求的协同进化。谷歌 TPU 与英伟达 GPU 的异构共生格局,为平台提供了 “精准适配、协同高效” 的发展思路;而 “自研可控” 的行业共识,则指明了平台底层能力建设的核心方向。未来,只有那些能够实现异构算力智能调度、模块化模型聚合、底层技术自主可控的平台,才能真正打通 AI 技术落地的 “最后一公里”,成为企业数字化转型的核心算力支撑。随着技术的持续迭代,聚合平台或将迎来更细分的场景化优化,而自主创新与开放协同,将是其穿越行业周期的核心竞争力。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)