数字人又要变天了!魔珐星云:让大模型 “长身体” 的具身智能基建

大模型终于有了‘身体’!”—— 这是每一位接触过魔珐星云的开发者最直观的感受。作为魔珐科技重磅推出的 “具身智能基础设施”,星云彻底颠覆了 3D 数字人 “高成本、高门槛、低适配” 的行业困境:电影级数字人精度、免显卡端渲染 SDK、十行代码即可调用,甚至工业级 demo 全量开源免费下载。今天,我们从技术底层、实操教程、场景落地到性能实测,全方位拆解魔珐星云如何重构具身智能的开发逻辑。

“大模型终于有了‘身体’!”—— 这是每一位接触过魔珐星云的开发者最直观的感受。作为魔珐科技重磅推出的 “具身智能基础设施”,星云彻底颠覆了 3D 数字人 “高成本、高门槛、低适配” 的行业困境:电影级数字人精度、免显卡端渲染 SDK、十行代码即可调用,甚至工业级 demo 全量开源免费下载。今天,我们从技术底层、实操教程、场景落地到性能实测,全方位拆解魔珐星云如何重构具身智能的开发逻辑。

一、从 0 到 1:魔珐星云注册与应用创建全流程

在开始 SDK 调用前,首先要完成平台注册与应用配置,整个过程无需复杂审核,个人开发者也能快速上手:

1. 注册与积分获取:免费开启开发权限

-

第一步:进入注册页面:打开魔珐星云,点击右上角 “登录 / 注册”,选择 “注册” 按钮,输入手机号并获取验证码;

-

第二步:邀请码权益(可选):注册页面可填写邀请码,填写后能额外获得 1000 积分(普通注册默认 100 积分),积分用于数字人渲染、API 调用等场景,后续可通过平台任务获取更多积分;

-

第三步:完成实名认证(可选):若需开发政企场景相关应用,可在 “个人中心” 完成实名认证,解锁信创适配、高并发支持等进阶功能。

2. 具身智能应用创建:3 步完成基础配置

登录开发者后台后,按照以下步骤创建首个数字人应用,全程不超过 5 分钟:

-

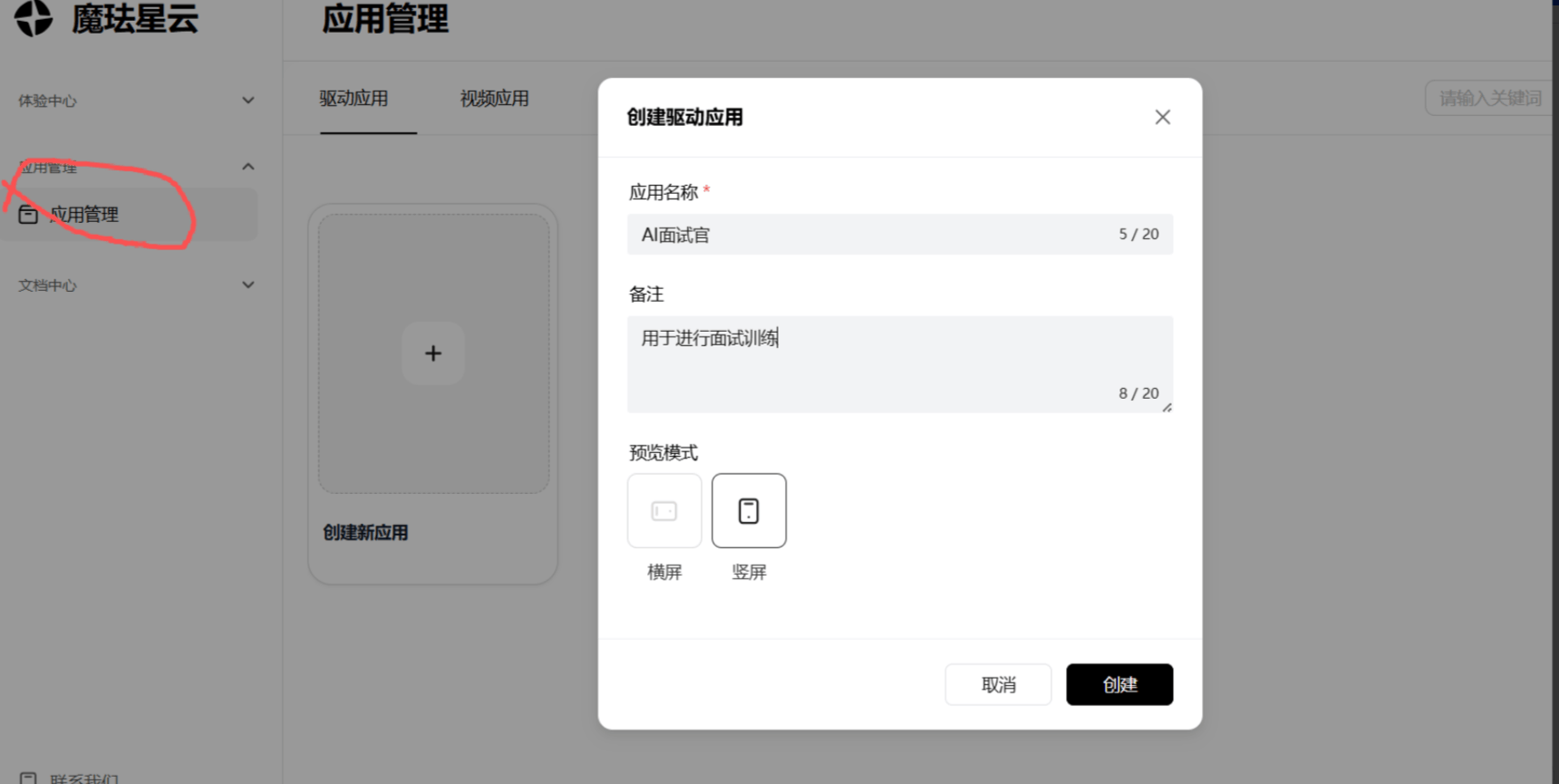

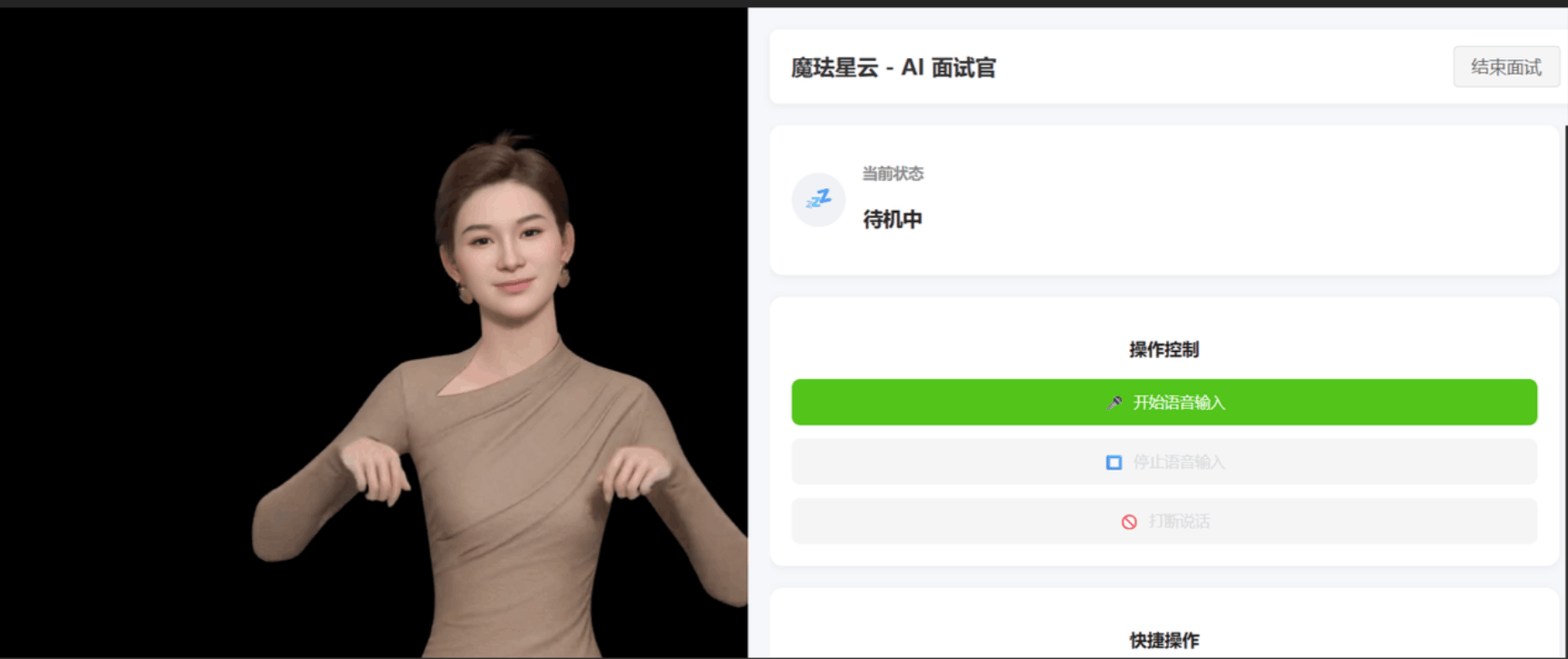

第一步:创建应用:进入 “应用管理” 页面,点击 “创建新应用”,选择 “具身智能应用” 模板,输入应用名称(如 “AI 面试官”“零售导购助手”)和备注(用于区分场景),选择预览模式(横屏 / 竖屏,适配不同终端);

-

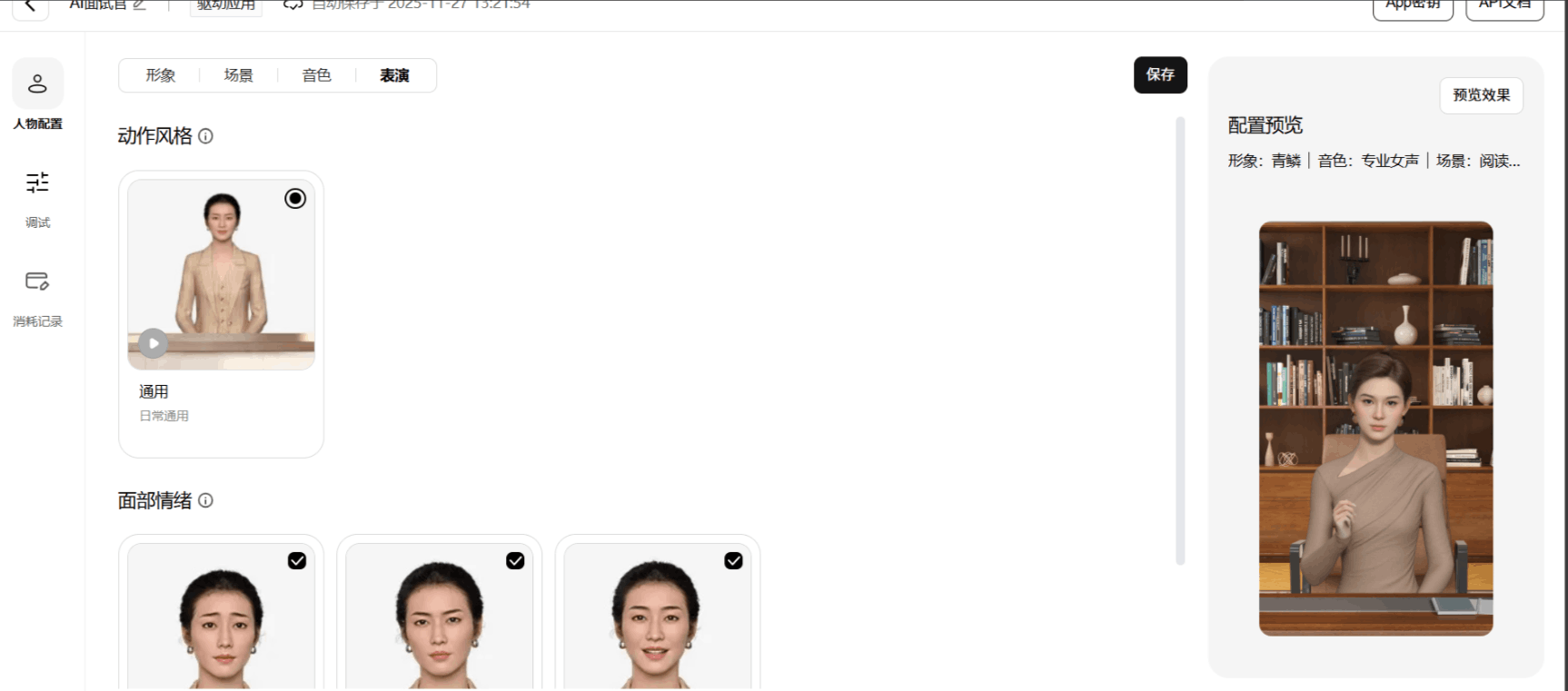

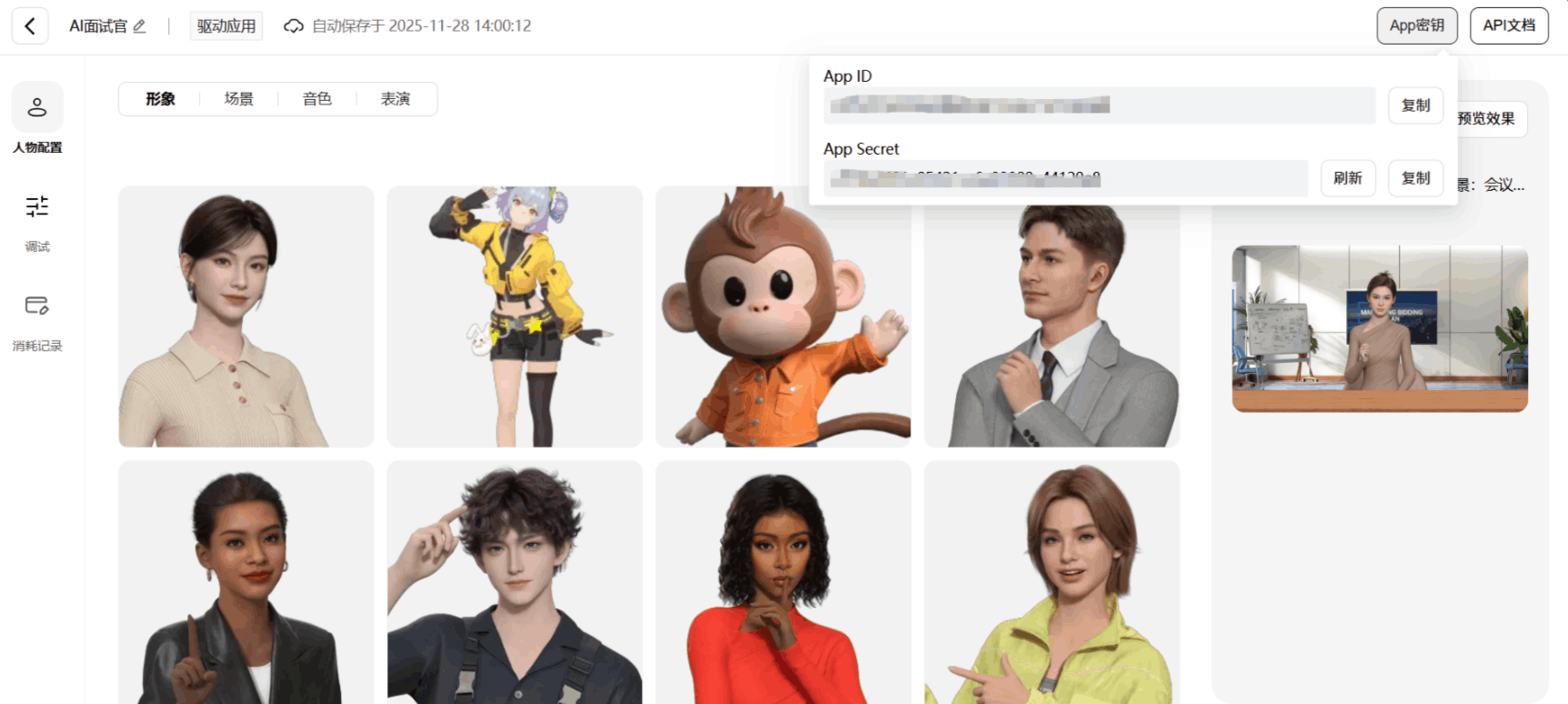

第二步:配置数字人形象:进入 “人物配置” 界面,从素材库选择数字人形象 —— 覆盖超写实、二次元、卡通等多风格,以 “AI 面试官” 场景为例,推荐选择 “青鳞”(着装正式、表情自然)等形象;支持自定义发型、服饰颜色,实时预览数字人静态效果;

-

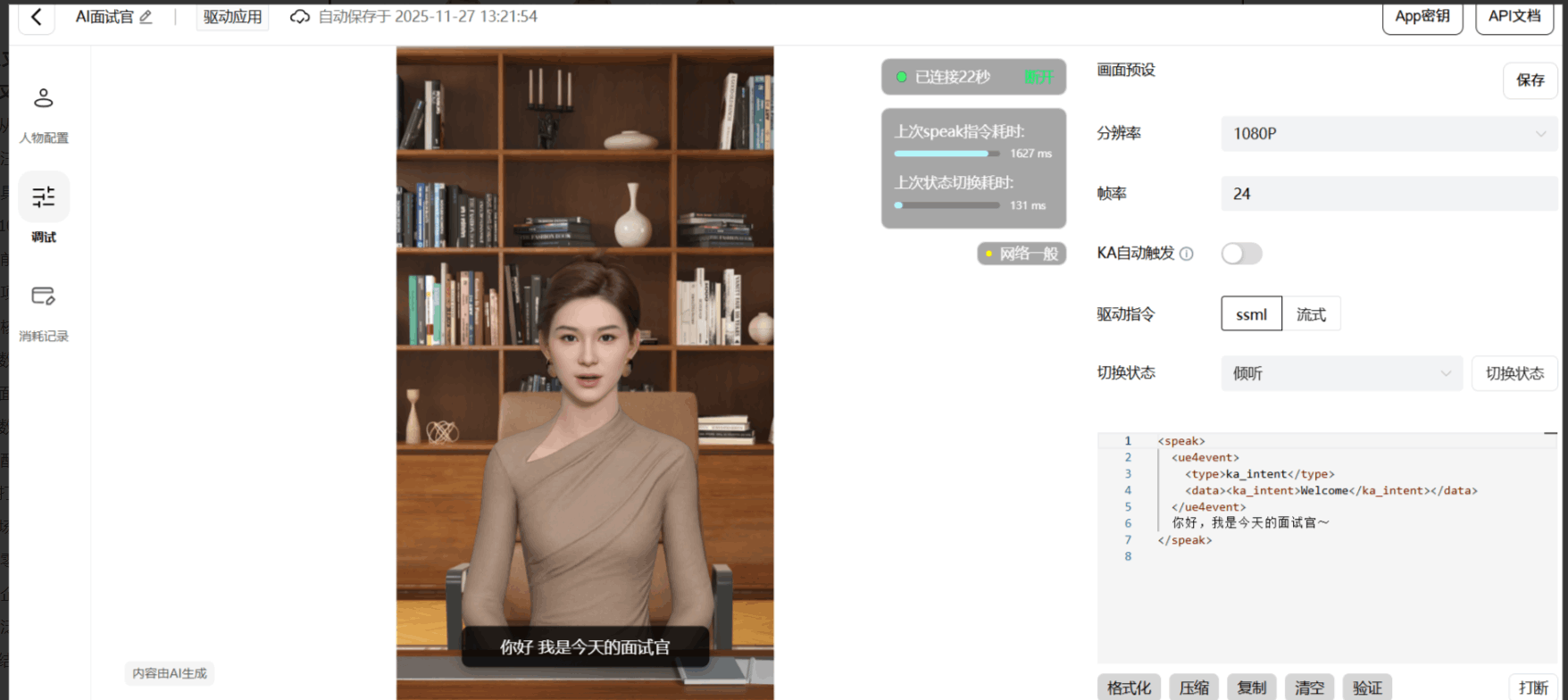

第三步:基础参数调试:在 “调试” 面板选择音色(如 “专业女声”“沉稳男声”)、场景背景(如 “办公场景”“零售门店”),输入测试文本(如 “你好,我是今天的面试官”),点击 “发送” 即可预览数字人语音 + 动作同步效果,确认无误后保存配置。

二、10 分钟上手!魔珐星云简单实操:从环境部署到创建代码运行

本项目是一个基于 Vue 3 + TypeScript 和 星云3D (Xingyun3D) SDK 开发的 AI 面试官应用。

1.前置环境准备

Node.js (推荐 v16+)

npm 或 yarn

然后可先建立个文件夹,终端运行

npm create vite@latest demo -- --template vue-ts 快速创建 Vite 脚手架 + Vue3 + TypeScript 项目。

2.项目结构说明

src/

├── components/

│ ├── DigitalHuman.vue # 数字人核心组件 (封装 SDK)

│ ├── InterviewChat.vue # 聊天记录组件

│ ├── ControlPanel.vue # 操作控制面板

│ └── StatusCard.vue # 状态显示卡片

├── App.vue # 主应用入口 (布局与逻辑编排)

└── main.ts # Vue 入口文件3.核心代码实现

数字人 SDK 初始化 (DigitalHuman.vue)

const initSDK = async () => {

// 检查 SDK 是否加载

if (!window.XmovAvatar) return;

try {

// 创建 SDK 实例

sdkInstance = new window.XmovAvatar({

containerId: '#sdk',

appId: props.appId,

appSecret: props.appSecret,

gatewayServer: 'https://nebula-agent.xingyun3d.com/user/v1/ttsa/session',

// 监听状态变化

onStateChange(state: string) {

emit('statusChange', state);

},

// 监听语音状态 (开始/结束说话)

onVoiceStateChange(status: string) {

if (status === 'start') emit('voiceStart');

else if (status === 'end') emit('voiceEnd');

}

});

// 初始化连接

await sdkInstance.init();

isConnected.value = true;

} catch (error) {

console.error('SDK Init Error:', error);

}

};面试控制 (App.vue)

<template>

<div class="app-container">

<!-- Left Panel: Digital Human -->

<div class="left-panel">

<div class="digital-human-wrapper">

<DigitalHuman

v-if="isStarted"

ref="digitalHumanRef"

:app-id="appId"

:app-secret="appSecret"

@status-change="handleStatusChange"

@voice-start="handleVoiceStart"

@voice-end="handleVoiceEnd"

/>

<div v-else class="placeholder">

<div class="placeholder-content">

<h2>AI 面试官</h2>

<p>请输入配置并开始面试</p>

</div>

</div>

</div>

</div>

<!-- Right Panel: Dashboard -->

<div class="right-panel">

<div class="dashboard-header">

<h1>魔珐星云 - AI 面试官</h1>

<div class="config-controls" v-if="!isStarted">

<input v-model="appId" placeholder="App ID" class="compact-input" />

<input v-model="appSecret" type="password" placeholder="App Secret" class="compact-input" />

<button @click="startInterview" :disabled="!appId || !appSecret" class="primary-btn">开始面试</button>

</div>

<button v-else @click="resetInterview" class="secondary-btn">结束面试</button>

</div>

<div class="dashboard-content" v-if="isStarted">

<!-- Status Section -->

<StatusCard :status="currentStatus" />

<!-- Controls Section -->

<ControlPanel

:is-listening="currentStatus === 'listening'"

:is-speaking="currentStatus === 'speaking'"

@start-voice="manualStartVoice"

@stop-voice="manualStopVoice"

@interrupt="manualInterrupt"

/>

<!-- Quick Actions -->

<div class="quick-actions">

<h3>快捷操作</h3>

<div class="action-grid">

<button @click="sendQuickReply('自我介绍')" :disabled="isSpeaking">自我介绍</button>

<button @click="sendQuickReply('数据分析')" :disabled="isSpeaking">数据分析</button>

<button @click="sendQuickReply('生成报告')" :disabled="isSpeaking">生成报告</button>

<button @click="sendQuickReply('趋势图表')" :disabled="isSpeaking">趋势图表</button>

</div>

</div>

<!-- Chat History (Secondary) -->

<div class="chat-section">

<h3>对话记录</h3>

<InterviewChat

:messages="messages"

:disabled="isSpeaking || !isStarted"

@send-message="handleUserAnswer"

/>

</div>

</div>

<div class="dashboard-empty" v-else>

<p>请在上方输入配置以启动系统</p>

</div>

</div>

</div>

</template>

<script setup lang="ts">

import { ref, computed } from 'vue';

import DigitalHuman from './components/DigitalHuman.vue';

import InterviewChat from './components/InterviewChat.vue';

import StatusCard from './components/StatusCard.vue';

import ControlPanel from './components/ControlPanel.vue';

const appId = ref('');

const appSecret = ref('');

const isStarted = ref(false);

const isSpeaking = ref(false);

const isListening = ref(false); // Simulated state

const digitalHumanRef = ref<InstanceType<typeof DigitalHuman> | null>(null);

interface Message {

role: 'interviewer' | 'candidate';

content: string;

}

const messages = ref<Message[]>([]);

const currentStep = ref(0);

const currentStatus = computed(() => {

if (isSpeaking.value) return 'speaking';

if (isListening.value) return 'listening';

return 'idle';

});

const interviewFlow = [

{ text: "您好,我是您的AI面试官。很高兴见到您。请先做一个简单的自我介绍吧。", type: 'question' },

{ text: "好的,了解了。那么,您觉得您最大的优势是什么?", type: 'question' },

{ text: "非常有意思。在工作中,如果您遇到无法解决的技术难题,您通常会怎么做?", type: 'question' },

{ text: "感谢您的回答。今天的面试就到这里,我们会尽快通知您结果。再见。", type: 'closing' }

];

const startInterview = () => {

isStarted.value = true;

messages.value = [];

currentStep.value = 0;

setTimeout(() => {

askNextQuestion();

}, 3000);

};

const resetInterview = () => {

isStarted.value = false;

messages.value = [];

currentStep.value = 0;

isSpeaking.value = false;

isListening.value = false;

};

const askNextQuestion = () => {

if (currentStep.value < interviewFlow.length) {

const question = interviewFlow[currentStep.value];

addMessage('interviewer', question.text);

if (digitalHumanRef.value) {

digitalHumanRef.value.speak(question.text);

}

}

};

const handleUserAnswer = (text: string) => {

addMessage('candidate', text);

isListening.value = false; // Stop listening when answer sent

setTimeout(() => {

currentStep.value++;

askNextQuestion();

}, 1000);

};

const sendQuickReply = (text: string) => {

handleUserAnswer(text);

};

const addMessage = (role: 'interviewer' | 'candidate', content: string) => {

messages.value.push({ role, content });

};

const handleStatusChange = (state: string) => {

console.log('Status:', state);

};

const handleVoiceStart = () => {

isSpeaking.value = true;

isListening.value = false;

};

const handleVoiceEnd = () => {

isSpeaking.value = false;

if (currentStep.value < interviewFlow.length) {

// Automatically switch to listening mode after speaking

isListening.value = true;

if (digitalHumanRef.value) {

digitalHumanRef.value.listen();

}

}

};

// Manual Controls

const manualStartVoice = () => {

isListening.value = true;

if (digitalHumanRef.value) digitalHumanRef.value.listen();

};

const manualStopVoice = () => {

isListening.value = false;

if (digitalHumanRef.value) digitalHumanRef.value.idle();

};

const manualInterrupt = () => {

if (digitalHumanRef.value) {

// SDK doesn't have explicit stop, but we can try idle or empty speak

digitalHumanRef.value.idle();

isSpeaking.value = false;

}

};

</script>

<style scoped>

.app-container {

display: flex;

height: 100vh;

width: 100vw;

background-color: #f0f2f5;

overflow: hidden;

}

/* Left Panel */

.left-panel {

width: 50%;

height: 100%;

background-color: #000;

position: relative;

}

.digital-human-wrapper {

width: 100%;

height: 100%;

}

.placeholder {

width: 100%;

height: 100%;

display: flex;

justify-content: center;

align-items: center;

background: linear-gradient(135deg, #1f1f1f 0%, #000 100%);

color: white;

}

.placeholder-content {

text-align: center;

}

/* Right Panel */

.right-panel {

width: 50%;

height: 100%;

display: flex;

flex-direction: column;

padding: 20px;

background-color: #f5f7fa;

}

.dashboard-header {

display: flex;

justify-content: space-between;

align-items: center;

margin-bottom: 20px;

background: white;

padding: 15px 20px;

border-radius: 8px;

box-shadow: 0 2px 8px rgba(0,0,0,0.05);

}

.dashboard-header h1 {

font-size: 20px;

color: #333;

margin: 0;

}

.config-controls {

display: flex;

gap: 10px;

}

.compact-input {

padding: 8px;

border: 1px solid #d9d9d9;

border-radius: 4px;

width: 150px;

}

.dashboard-content {

flex: 1;

overflow-y: auto;

padding-right: 5px;

}

/* Quick Actions */

.quick-actions {

background: white;

padding: 20px;

border-radius: 12px;

box-shadow: 0 2px 8px rgba(0,0,0,0.05);

margin-bottom: 20px;

}

.quick-actions h3 {

font-size: 16px;

margin-bottom: 15px;

color: #1f1f1f;

}

.action-grid {

display: grid;

grid-template-columns: repeat(4, 1fr);

gap: 10px;

}

.action-grid button {

padding: 10px;

background: white;

border: 1px solid #d9d9d9;

border-radius: 6px;

cursor: pointer;

transition: all 0.3s;

}

.action-grid button:hover:not(:disabled) {

border-color: #1890ff;

color: #1890ff;

}

/* Chat Section */

.chat-section {

background: white;

padding: 20px;

border-radius: 12px;

box-shadow: 0 2px 8px rgba(0,0,0,0.05);

height: 300px; /* Fixed height for chat area */

display: flex;

flex-direction: column;

}

.chat-section h3 {

font-size: 16px;

margin-bottom: 15px;

color: #1f1f1f;

}

/* Buttons */

.primary-btn {

background-color: #1890ff;

color: white;

border: none;

padding: 8px 16px;

border-radius: 4px;

cursor: pointer;

}

.primary-btn:hover:not(:disabled) {

background-color: #40a9ff;

}

.secondary-btn {

background-color: #f5f5f5;

color: #595959;

border: 1px solid #d9d9d9;

padding: 8px 16px;

border-radius: 4px;

cursor: pointer;

}

.secondary-btn:hover {

background-color: #e6f7ff;

color: #1890ff;

border-color: #1890ff;

}

button:disabled {

opacity: 0.6;

cursor: not-allowed;

}

</style>

数字人控制方法 (DigitalHuman.vue)

// 驱动数字人说话

const speak = (text: string) => {

if (sdkInstance && isConnected.value) {

// is_start=true, is_end=true 表示一次性发送完整文本

sdkInstance.speak(text, true, true);

}

};

// 切换到倾听状态 (通常在用户开始说话时调用)

const listen = () => {

if (sdkInstance && isConnected.value) {

sdkInstance.listen();

}

};

// 切换到待机状态 (停止说话/倾听)

const idle = () => {

if (sdkInstance && isConnected.value) {

sdkInstance.idle();

}

};

// 销毁实例 (组件卸载时调用)

const destroy = () => {

if (sdkInstance) {

sdkInstance.destroy();

sdkInstance = null;

isConnected.value = false;

}

};

// 生命周期管理

onMounted(() => {

// 确保外部 SDK 脚本已加载

if (window.XmovAvatar) {

initSDK();

} else {

// 轮询检查 SDK 是否就绪

const checkInterval = setInterval(() => {

if (window.XmovAvatar) {

clearInterval(checkInterval);

initSDK();

}

}, 100);

}

});

onBeforeUnmount(() => {

destroy();

});代码库链接(完整代码库)

4-配置和测试

安装依赖

在项目根目录 (demo文件夹) 下运行:

npm install启动开发服务器

npm run dev启动后,访问控制台输出的本地地址(通常为 http://localhost:5173)。

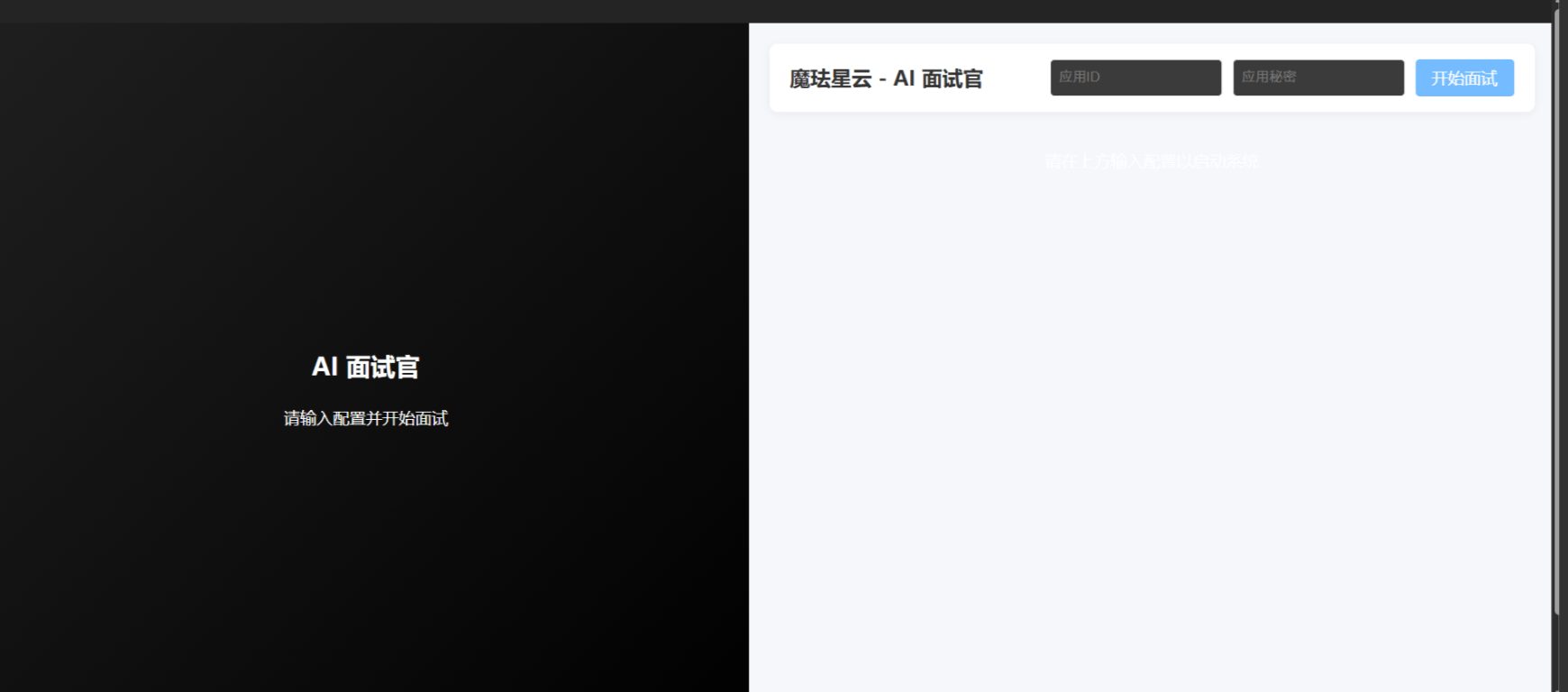

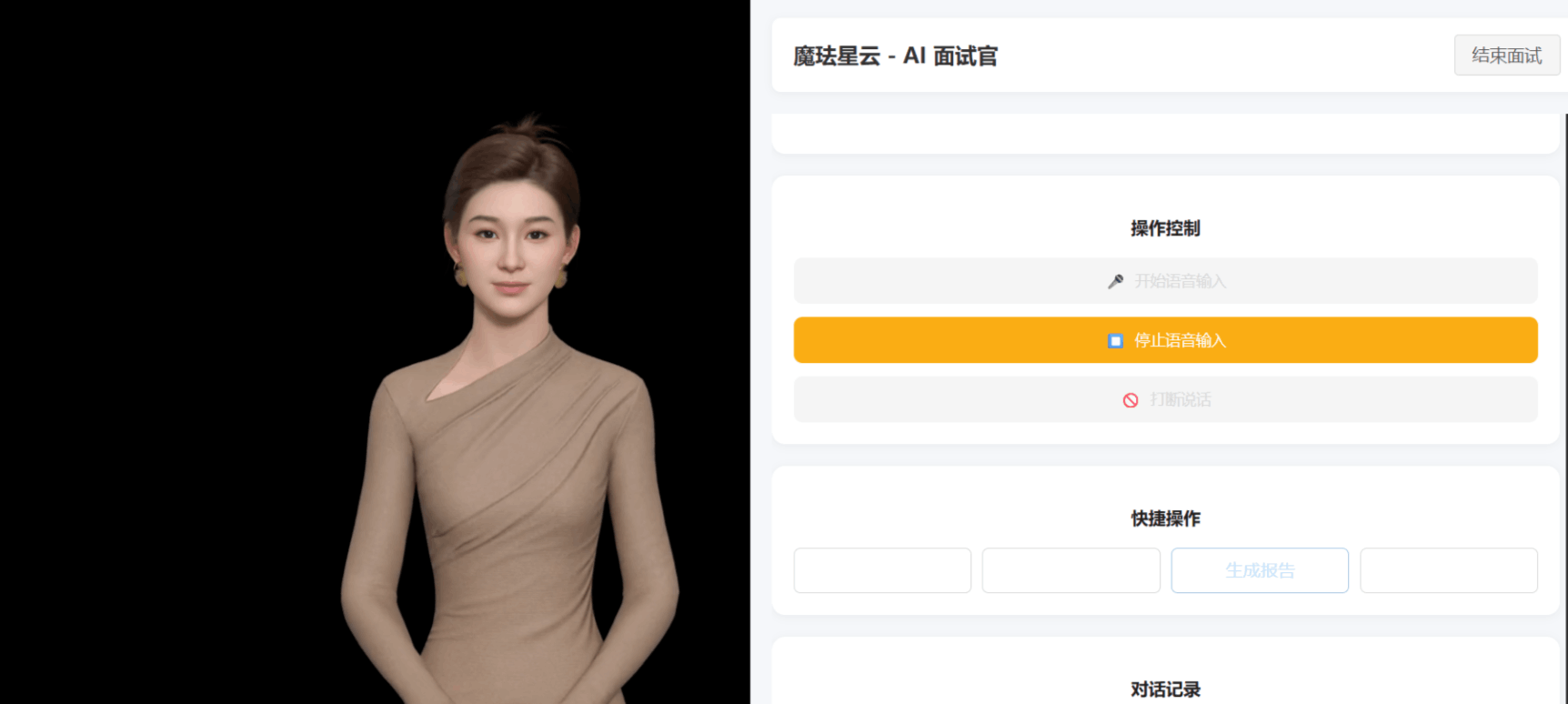

在右侧输入

-

App ID: 您的应用 ID

-

App Secret: 您的应用密钥

可在平台创建应用中右上角的APP密钥复制

输入后点击开始面试,等待来连接数字人之后,可进行交流

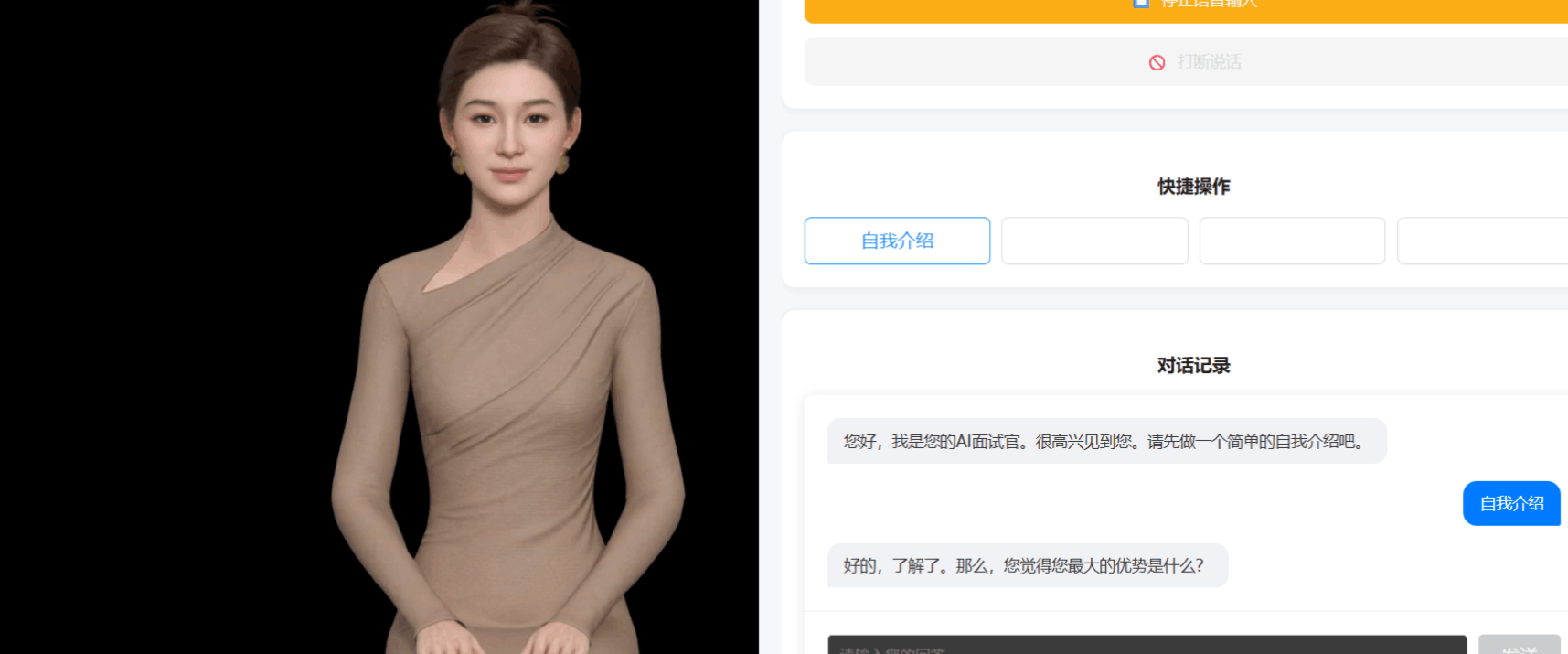

界面操作控制,快捷操作以及对话记录的分栏

鼠标移动到快捷操作区域会显示对应的功能

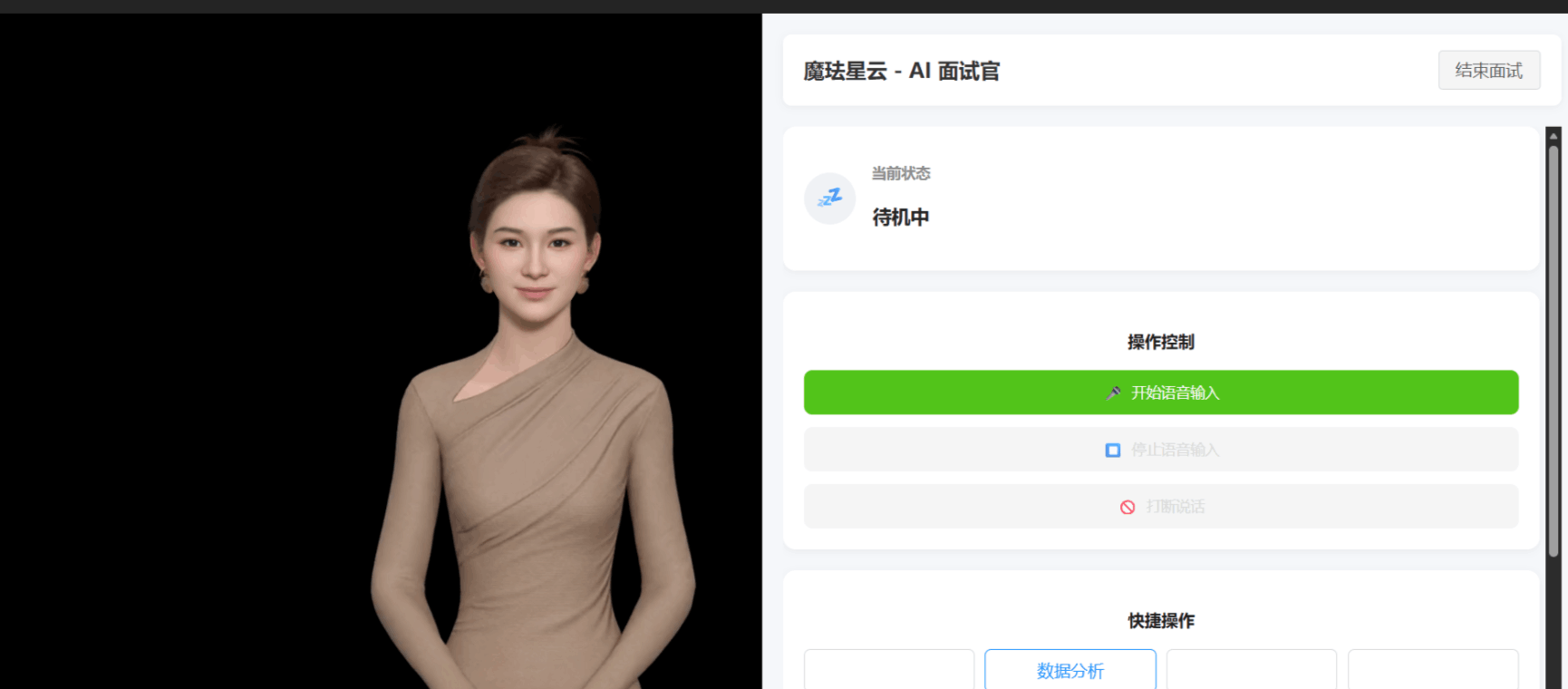

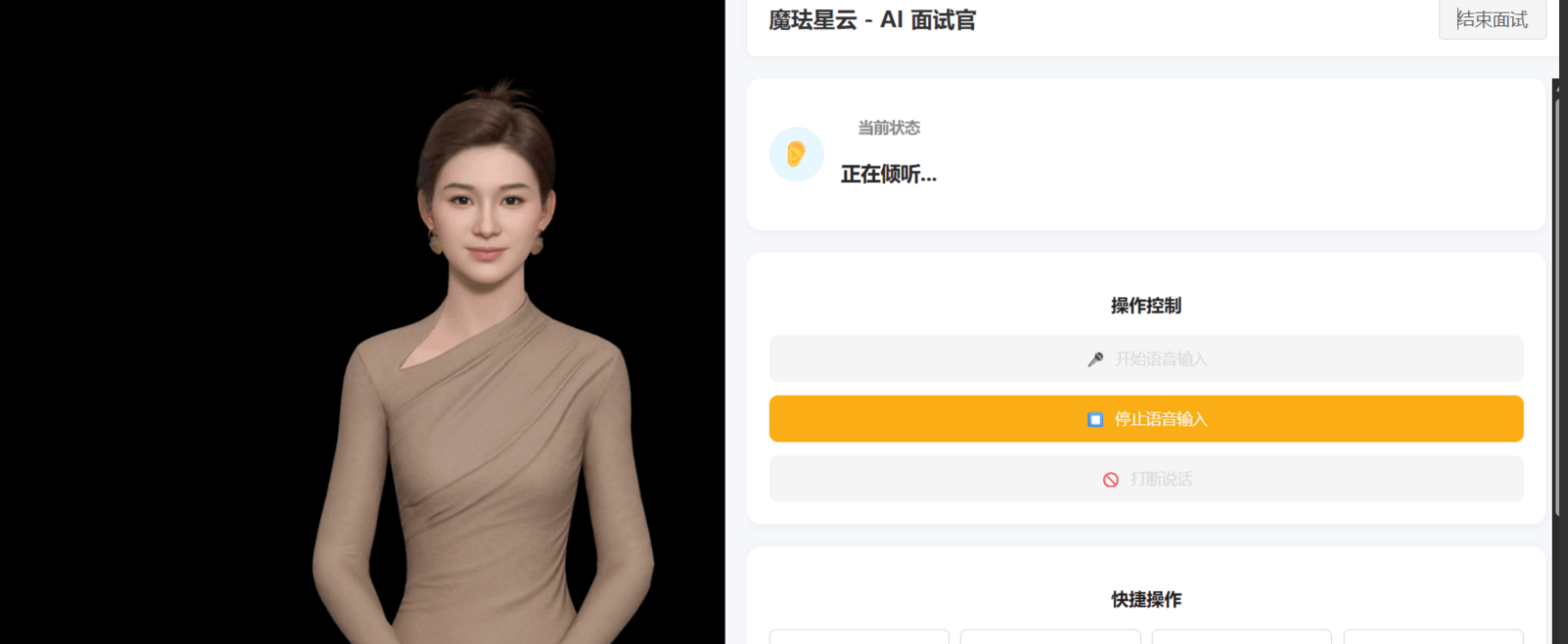

语音交互模拟

-

点击“开始语音输入”按钮。

-

结果: 状态变为“正在倾听”,数字人可能做出倾听动作(视 SDK 行为而定)。

-

点击“停止语音输入”。

-

结果: 状态变回“待机”。

对话流程

-

在“快捷操作”区域点击“自我介绍”。

-

结果:

-

聊天记录中出现“自我介绍”。

-

数字人收到回复后,经过短暂模拟思考,开始说下一句台词(例如询问优势)。

-

状态变为“正在说话”。

-

打断测试

-

当数字人正在说话时,点击“打断说话”按钮。

-

结果: 数字人立即停止说话,状态变回“待机”。

三、打破不可能!魔珐星云的 6 大核心能力拆解

体验下来,星云的优势不仅在于 “易用”,更在于解决了行业长期存在的 “高质量 = 高成本 = 高延时” 痛点:

-

高质量:细节拉满的电影级效果

-

模型精度:面部 1024 级拓扑结构,支持 “微挑眉”“抿嘴” 等微表情,皮肤采用 PBR 物理材质,光线反射符合真实人体肌理;

-

动作生成:内置 10 万 + 专业动捕动作库,结合文生 3D 多模态大模型,输入 “微笑着递传单”,数字人会自动生成手势、肢体角度及表情联动。

-

-

低延时:贴近真人的交互体验

-

驱动响应≤500ms,支持全双工对话(用户可随时打断数字人发言),在政务咨询、面试等场景中,避免 “机械等待” 感;

-

渲染优化:通过 AI 端渲技术,在普通 PC 上实现 30 帧 / 秒实时渲染,延迟比传统 3D 方案降低 60%。

-

-

低成本:百元级设备即可部署

-

硬件成本:无需采购昂贵 GPU,RK3566 等百元级芯片可运行 720P 渲染,服务器部署成本仅为传统方案的 1/10;

-

开发成本:素材库免费复用,个人开发者 1 天可完成 demo,对比 “3 人团队 1 个月” 的传统开发模式,人力成本缩减 90%。

-

-

高并发:支撑千万级设备接入

-

云端架构优化,单服务器可同时驱动 100 + 数字人实例,在电商大促、政务大厅高峰期等场景,仍能保障交互稳定。

-

-

多终端:一次开发全场景适配

-

覆盖手机、车机、Pad、PC、电视大屏、AR 头显等终端,兼容 Android、iOS、鸿蒙、Linux 等系统,无需针对不同设备重构代码。

-

-

信创支持:满足政企合规需求

-

适配鲲鹏 / 飞腾国产芯片、统信 UOS / 麒麟国产系统,在金融、政务等对安全性要求高的场景中,可实现全栈国产化部署。

-

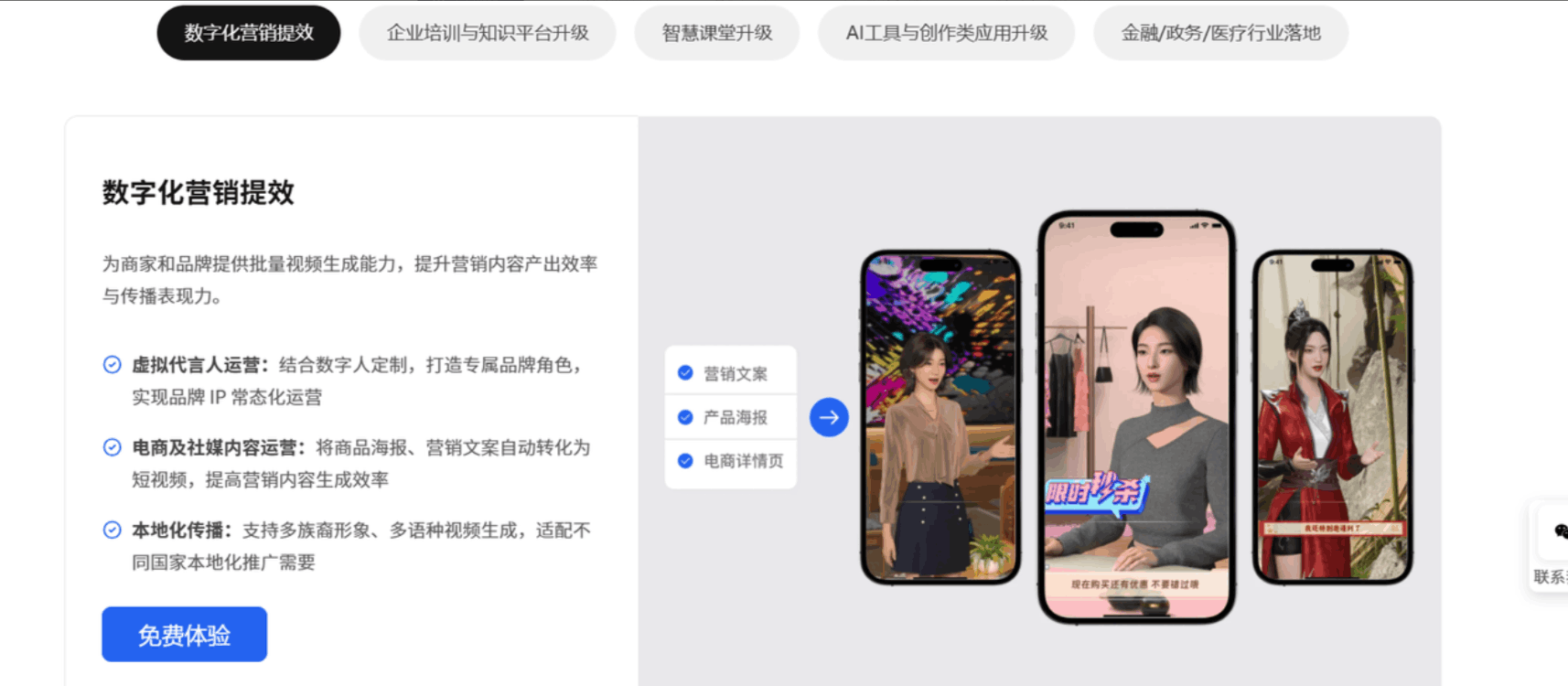

四、场景落地:数字人能 “活” 在哪些地方?

1. 零售屏:让导购屏从 “展示” 变 “拉客”

某美妆连锁品牌在门店部署星云数字人后,实现三大升级:

-

主动交互:顾客靠近时,数字人主动做出 “招手” 动作,说 “欢迎了解新品粉底液,我帮您介绍质地~”;

-

精准推荐:通过摄像头识别顾客停留货架,结合库存数据推荐 “这款口红今天补货了,有您适合的豆沙色”;

-

数据反馈:试运营 3 个月,门店咨询转化率提升 40%,人工导购工作量减少 30%。

2. 企业服务:AI 面试官降本提效

在招聘场景中,数字人面试官可替代初筛环节:

-

标准化提问:根据岗位需求生成面试问题(如产品经理岗问 “如何设计一款老年版 APP”),动作表情自然,避免候选人紧张;

-

实时评估:记录候选人回答时长、关键信息,面试后自动生成评估报告(如 “逻辑清晰,产品思维较强”);

-

成本优势:某互联网公司使用后,初筛成本降低 50%,招聘周期缩短 30%。

3. 泛娱乐:让虚拟 IP “有灵魂”

-

游戏 NPC:告别固定脚本,玩家问 “这个副本怎么打”,NPC 会结合玩家等级,一边 “挠头思考” 一边输出攻略,甚至会吐槽 “上次我也卡在这关啦”;

-

虚拟陪伴:手机端 “AI 男友 / 女友” 能根据用户情绪调整语气,用户说 “今天工作好累”,数字人会做出 “安慰性点头”,回应 “辛苦啦,要不要跟我说说发生了什么?”。

五、结论:具身智能的 “iPhone 时刻” 已来

魔珐星云的本质,是把具身智能从 “大厂专属技术” 变成了 “人人可用的基础设施”—— 它用 SDK 封装了复杂的 3D 渲染、动作生成逻辑,让开发者无需掌握图形学、动捕技术,也能快速构建高质量数字人应用。

如果你是开发者,现在就能行动:

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)