Transformer:现代 AI 的“最强大脑” —— 小白也能看懂的超通俗解读

如果把 AI 发展史看作工业革命,那么Transformer 就是蒸汽机。它抛弃了陈旧的“逐字阅读”模式,用“注意力机制”让机器第一次真正学会了像人类一样,在复杂的上下文中理解语言的精髓。下次当你惊叹于 ChatGPT 的回答如此精准时,请记得,在那个对话框背后,有一个叫 Transformer 的模型,正用它成千上万个“注意力头”,在数据的海洋里疯狂运转,只为读懂你的心。

Transformer:现代 AI 的“最强大脑” —— 小白也能看懂的超通俗解读

1. 引言:ChatGPT 的幕后英雄

大家现在都在用 ChatGPT,觉得它无所不知,能写诗、能写代码、还能陪聊。但你知道它背后的“大脑”是什么吗?

它的名字就藏在 GPT 这个缩写里 —— T 代表 Transformer。

Transformer 并不是变形金刚(虽然它确实改变了世界),而是一种革命性的 AI 模型架构。在它出现之前,AI 处理语言就像一个刚学认字的小学生,读了后面忘前面;而 Transformer 的出现,让 AI 瞬间变成了过目不忘的速读天才。

今天,我们就用最通俗的语言,不带任何复杂的数学公式,带你拆解这个 AI 界的“超级引擎”。

2. 以前的 AI 为什么不够聪明?(RNN 的困境)

在 Transformer 诞生之前,AI 处理翻译或写作任务主要靠一种叫 RNN(循环神经网络) 的模型。

RNN 的工作方式很像人类逐字阅读:

它必须先读第一个词,理解了,再读第二个词,结合第一个词的意思继续往下读……

这就带来两个大问题:

- 效率低:必须一个字一个字排队处理,没法“一目十行”。

- 记性差:如果句子太长,读到最后时,往往已经忘了开头讲什么了。

打个比方:

以前的 AI 就像一个疲惫的翻译官,你跟他说一段长得不得了的话,他听完最后一句时,已经把你第一句说的“主语”是谁给忘了,导致翻译出来驴唇不对马嘴。

3. Transformer 的秘密武器:注意力机制(Attention)

2017 年,Google 的团队说:“我们要换种玩法!”于是 Transformer 诞生了。它最大的绝招叫 Self-Attention(自注意力机制)。

这玩意儿有多神?简单说,它让 AI 拥有了**“上帝视角”**。

Transformer 不再一个字一个字地读,而是一眼把整句话全看进去。在看的时候,它能自动判断哪些词之间关系最紧密。

打个比方:

当你看到句子:“苹果不仅好吃,也是一家伟大的公司。”

- 看到“苹果”这个词时,以前的 AI 可能会懵:是吃的苹果?还是手机那个苹果?

- Transformer 会瞬间“注意”到句子后面的“好吃”和“公司”。

- 如果它更关注“好吃”,它就知道这是水果;如果它更关注“公司”,它就知道这是科技巨头。

这种**“在读一个词时,同时参考句子里所有其他词”**的能力,就是注意力机制。

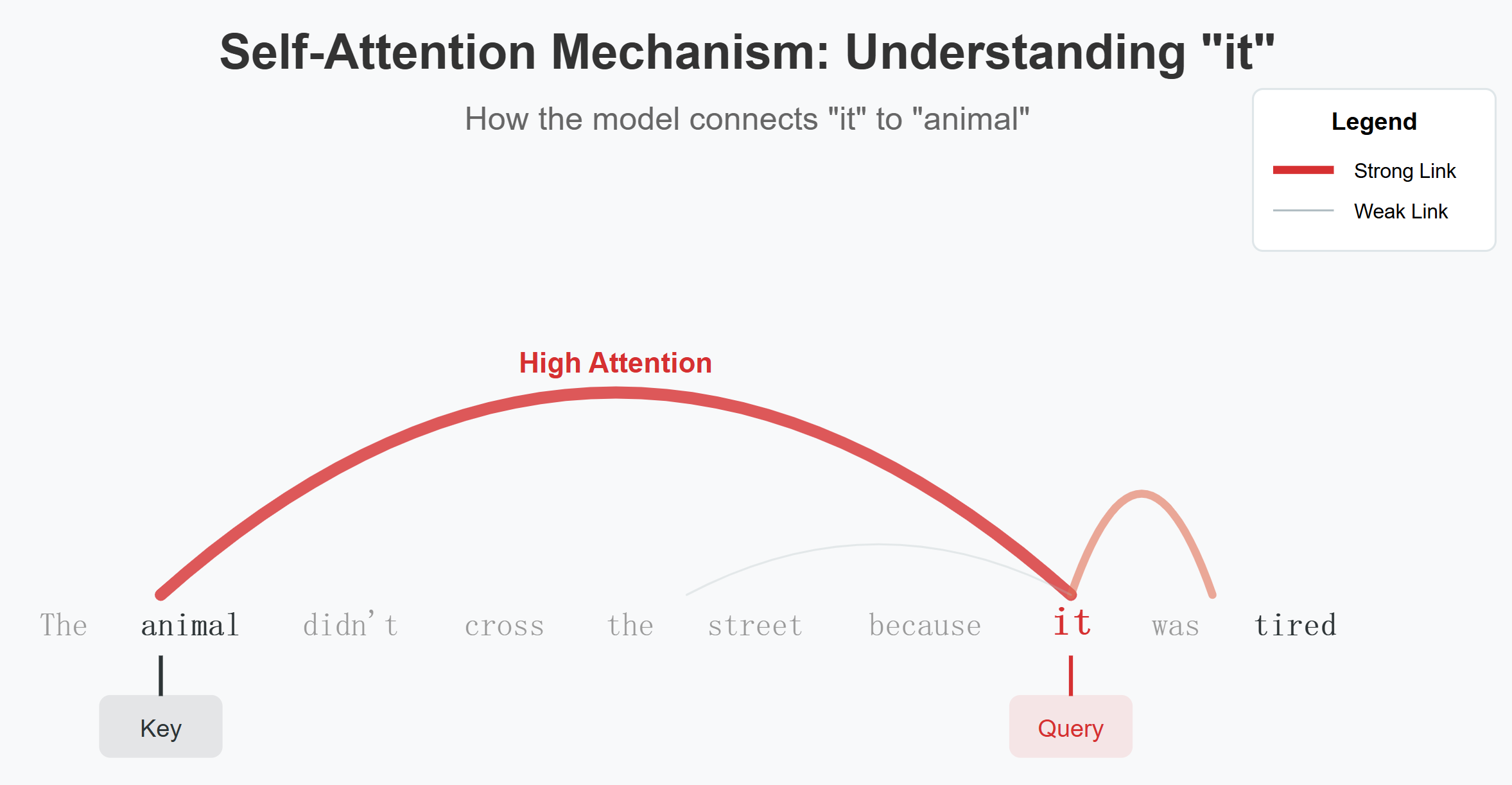

![注意力机制原理图]

图解:当模型读到 “it”(它)时,注意力机制会告诉它,这里的 “it” 指的是 “animal”(动物),而不是 “street”(街道),因为后面说了 “tired”(累了)。

4. 拆解架构:编码器与解码器

Transformer 的身体主要由两部分组成,就像一个完美的搭档组合:

1. 编码器(Encoder):负责“读”与“理解”

它的任务是把输入的文字(比如中文)转化成计算机能懂的深层含义(向量)。它就像一个资深的阅读理解专家,把你的话嚼碎了,提取出精华。

2. 解码器(Decoder):负责“写”与“生成”

它的任务是根据编码器给的精华,生成目标文字(比如英文翻译,或者 ChatGPT 的回答)。它就像一个才思敏捷的作家,根据理解的意思,把字一个个蹦出来。

- BERT(谷歌那个很强的模型)主要用了编码器,所以它特别擅长做阅读理解、填空。

- GPT(ChatGPT 的祖宗)主要用了解码器,所以它特别擅长像接龙一样写文章。

5. 位置编码:给文字排座次

前面说了,Transformer 是“一眼看完全文”的。但这有个小 bug:它既然一起看,怎么知道哪个字在前,哪个字在后呢?

“我爱你”和“你爱我”,字都一样,但意思完全反了啊!

为了解决这个问题,Transformer 引入了 Positional Encoding(位置编码)。

打个比方:

就像给每个进教室的学生发一个座位号。

虽然老师(模型)一眼能看到全班同学(所有单词),但每个人身上都贴着“1号”、“2号”、“3号”的标签。这样,AI 既能同时处理所有词,又永远不会搞乱语序。

6. Transformer 改变了什么?

自从 Transformer 问世,AI 就像开了挂:

- 速度快了:因为可以并行计算(大家一起干活),训练速度比以前快了 N 倍。

- 更懂人话:因为它能记住长距离的上下文,写出来的小说、代码逻辑性极强。

- 万能通用:后来大家发现,这架构不光能处理文字,还能用来识别图片(Vision Transformer)、生成视频(Sora 也是基于类似原理)。

7. 总结

如果把 AI 发展史看作工业革命,那么 Transformer 就是蒸汽机。

它抛弃了陈旧的“逐字阅读”模式,用“注意力机制”让机器第一次真正学会了像人类一样,在复杂的上下文中理解语言的精髓。

下次当你惊叹于 ChatGPT 的回答如此精准时,请记得,在那个对话框背后,有一个叫 Transformer 的模型,正用它成千上万个“注意力头”,在数据的海洋里疯狂运转,只为读懂你的心。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)