OpenStation:10分钟完成大模型部署,一键开启AI应用落地之旅

面对上述那些实实在在的问题,OpenStation一站式大模型部署平台通过全自动化的安装流程与智能环境配置,无论是技术团队还是业务人员,都能在10分钟内完成从环境搭建到服务上线的全流程操作。:提供 在线 / 离线双部署模式,在线模式自动拉取最新依赖,离线模式支持断网环境下的完整部署(离线包已集成 10.1GB 的组件与镜像),从而解决离线部署困难问题。:企业内部生产环境常常严格隔离互联网,手动下载

大模型技术如火如荼,但当我们满怀期待地将它引入企业应用时,部署环节往往成了拦路虎,个人感觉一些现实困境如下:

-

环境配置困难:CUDA版本、驱动兼容性、Python环境、依赖库冲突等等,光是准备环境就让大家焦头烂额,稍有差池就报错连连。

-

跨平台适配困难:不同操作系统(Ubuntu18.04 vs Ubuntu20.04 vs Ubuntu22.04 vs CentOS7)、不同硬件架构(CPU 节点 vs GPU节点),意味着完全不同的依赖库和配置路径。好不容易适配好一个系统,如果换台机器又要重头再来,从头到尾全靠经验摸索,维护成本极高。

-

离线部署困难:企业内部生产环境常常严格隔离互联网,手动下载所有依赖、解决复杂的离线编译和安装问题,耗时耗力且极易出错,从而拉长了大模型落地的部署时间。

-

资源管理困难:分布式节点的时间同步、SSH互信、GPU资源分配、容器环境搭建等等,手动配置不仅繁琐,而且难以保证一致性和可靠性,为后续运维埋下隐患。

-

效率瓶颈:大家如果把时间大量消耗在重复、低效的基础环境搭建上,而非核心的模型调优和应用开发,严重拖慢项目落地节奏。

OpenStation优势:一键部署、分钟级上线

面对上述那些实实在在的问题,OpenStation一站式大模型部署平台通过全自动化的安装流程与智能环境配置,无论是技术团队还是业务人员,都能在10分钟内完成从环境搭建到服务上线的全流程操作。

-

架构兼容:同时支持X86服务器的GPU环境与纯CPU环境,GPU节点自动调用vLLM等高性能推理引擎,CPU节点则通过优化算法实现高效推理,ARM架构暂时是不支持的。

-

网络适配:提供 在线 / 离线双部署模式,在线模式自动拉取最新依赖,离线模式支持断网环境下的完整部署(离线包已集成 10.1GB 的组件与镜像),从而解决离线部署困难问题。

-

系统支持:主流Ubuntu系统全覆盖(22.04/20.04/18.04),CentOS7系列在线部署也同样支持,从而解决跨平台适配困难的问题。

-

分钟级上线:使用OpenStation部署LLM服务只需要10分钟即可完成部署,为大模型服务的落地提供了有力保障。

-

一键化部署:与传统大模型部署需要手动配置 CUDA环境、调试依赖冲突不同,OpenStation提供一键化安装部署方案。无论是在线安装还是离线部署,只需执行一行命令即可自动完成从依赖下载、环境配置到服务启动的全流程操作:

1. 在线安装时,如果服务器已连接互联网,可直接执行以下命令安装 OpenStation:

curl -O https://fastaistack.oss-cn-beijing.aliyuncs.com/openstation/openstation-install-online.sh

#其中,--version latest表示本次安装OpenStation平台的版本

bash openstation-install-online.sh --version latest也可以通过链接直接下载在线安装包openstation-pkg-online-latest.tar.gz,上传到服务器上执行以下安装命令:

tar -xvzf openstation-pkg-online-latest.tar.gz

cd openstation-pkg-online-latest/deploy

bash install.sh true2. 离线安装时,提供了预制的OpenStation离线安装包,下载链接如下:

| 包类型 | 包下载地址 | 内容 | 大小 |

| 离线安装包 | 点击下载 | 平台功能组件+推理引擎镜像 | 10.1GB |

| 安装包SHA256 | 点击下载 | 安装包SHA256校验文件 | 96B |

下载完成后,上传安装包至待部署节点,在部署节点的安装包目录下执行以下命令:

#校验包的完整性

sha256sum -c SHA256SUM-LATEST

#解压安装包,执行安装过程

tar -xvzf openstation-pkg-latest.tar.gz && cd openstation-pkg-latest/deploy && bash install.sh部署全流程解析:从环境准备到服务验证

安装前:两步完成环境校验

-

网络连通性检查 在线安装部署时,一键化安装部署脚本会首先进行网络连通性校验,显示网络连接的状态。

-

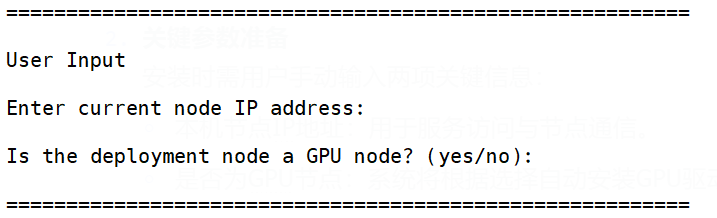

关键参数准备 安装时需用户手动输入两项关键信息:

-

本机节点IP地址:用于服务访问与节点通信。

-

是否为GPU节点:系统将根据选择自动安装GPU驱动。

-

安装中:自动化完成环境构建

-

基础源配置

根据操作系统的不同,自动配置相应的阿里源仓库、Docker官方源仓库加速平台所需软件包的下载。

-

基础服务安装

自动安装chrony时钟同步服务,确保分布式节点时间一致性;配置节点间SSH免密登录,为后续分布式部署奠定基础;安装Docker CE容器运行环境。

-

硬件驱动适配

自动安装550.144.03版本GPU驱动,配置NVIDIA Container Toolkit,该驱动支持市面上常见H20、A100、A800、V100、T4等类型的加速卡。

-

数据库部署

一键部署MariaDB数据库,自动初始化用户管理、服务配置等数据表。

-

推理引擎部署

自动导入vLLM推理引擎镜像及其它推理引擎。

安装后:一分钟完成服务验证

安装完成后,只需在浏览器输入http://节点IP:32206,即可看到 OpenStation登录界面。首次登录后可立即进行:

-

创建API-Key:兼容OpenAI标准接口,可直接对接ChatGPT客户端。

-

模型部署测试:一键启动DeepSeek等主流模型,测试推理效果。

-

资源监控查看:实时查看各节点内存已用、存储已用、GPU显存占用等关键指标。

结语:大模型部署进入“傻瓜式”时代

从依赖资深工程师的手工部署,到脚本、驱动的一键化操作,OpenStation为大模型本地部署提供了有力保障。无论是企业IT部门还是开发者个人,都能通过极简的操作流程,快速构建生产级大模型服务。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)