AI 轻量化部署核心方案:模型量化与算子优化的工程化实现逻辑

在边缘计算、移动终端与嵌入式系统成为 AI 落地主战场的今天,轻量化部署已从 “可选需求” 变为 “刚性约束”。当大模型的参数量从百亿级向千亿级突破时,部署端的资源限制(有限显存、低算力、严格功耗控制)与业务对低延迟、高可用性的需求形成尖锐矛盾。AI 轻量化部署的核心,正是通过与的工程化设计,在不显著损失模型效果的前提下,实现资源占用与计算效率的极致平衡。

在边缘计算、移动终端与嵌入式系统成为 AI 落地主战场的今天,轻量化部署已从 “可选需求” 变为 “刚性约束”。当大模型的参数量从百亿级向千亿级突破时,部署端的资源限制(有限显存、低算力、严格功耗控制)与业务对低延迟、高可用性的需求形成尖锐矛盾。AI 轻量化部署的核心,正是通过模型量化与算子优化的工程化设计,在不显著损失模型效果的前提下,实现资源占用与计算效率的极致平衡。

一、轻量化部署的工程化核心矛盾:资源约束下的性能突围

AI 模型部署的本质,是将训练好的模型转化为可在目标硬件上高效运行的推理程序。而轻量化部署面临的核心约束的是 “资源天花板”—— 边缘设备的显存可能仅为几 GB,CPU 算力不足桌面端的十分之一,且对功耗和发热有严格要求。传统模型(如 FP32 精度的 Transformer)在这类设备上会出现三大问题:一是内存溢出,无法完成加载;二是推理延迟过高,无法满足实时交互需求(如语音识别、自动驾驶感知);三是功耗超标,导致设备续航骤降或硬件损坏。

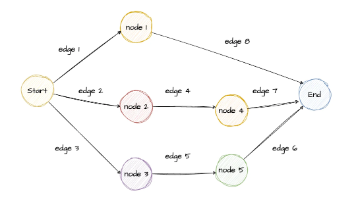

工程化实现的核心目标,就是通过技术手段打破这一 “天花板”:在保证业务可接受精度的前提下,将模型的内存占用降低 50% 以上,推理延迟压缩至毫秒级,同时适配不同硬件架构(CPU/GPU/NPU/ASIC)的兼容性需求。而模型量化与算子优化,正是实现这一目标的两大核心路径。

二、模型量化:用 “数值精简” 换 “资源释放” 的工程化逻辑

模型量化的底层逻辑,是利用 “人类感知对微小精度损失不敏感” 的特性,将模型中权重、激活值的浮点型数据(FP32/FP16)转换为占用内存更少的整型数据(INT8/INT4),从而减少存储开销与计算量。这一过程的核心是 “精度与资源的权衡”,其工程化实现的关键在于 “如何在精简数值的同时,最大限度保留模型的有效信息”。

1. 量化的底层原理:从 “连续浮点” 到 “离散整型” 的映射

浮点型数据(如 FP32)通过符号位、指数位、尾数位的组合,能精准表示大范围的连续数值,但占用 4 字节内存;而整型数据(如 INT8)仅用 1 字节存储 - 128~127 的离散数值,内存占用直接降低 75%。量化的核心是建立浮点型与整型的映射关系:通过计算原始数据的最大值、最小值或统计分布(如均值、方差),确定缩放因子(Scale)和偏移量(Zero Point),将浮点值 x 转换为整型值 q,公式可简化为 q = round (x / Scale + Zero Point)。

工程化实践中,量化粒度的选择直接影响精度与效率:张量级量化(整个张量用同一套 Scale 和 Zero Point)计算简单,但精度损失较大;通道级量化(每个通道单独计算参数)精度更高,但计算量略有增加;层级量化则是两者的折中,是工业界最常用的选择。

2. 两大量化方案的工程化落地路径

量化的工程化实现主要分为 “训练后量化(PTQ)” 与 “量化感知训练(QAT)”,分别对应不同的业务场景:

-

训练后量化(PTQ):无需重新训练,仅通过少量校准数据调整量化参数,适合快速落地、无标注数据的场景。其工程化流程的核心是 “校准”—— 用代表性数据投喂模型,统计权重和激活值的分布特征,选择最优的量化范围(如截断异常值避免溢出),并通过 KL 散度、最小均方误差(MSE)等指标评估量化误差,动态调整 Scale 和 Zero Point。PTQ 的优势是部署成本低、周期短,但精度损失相对明显,适合对精度要求不高的场景(如图像分类、简单 NLP 任务)。

-

量化感知训练(QAT):在模型训练过程中注入量化噪声,让模型提前适应量化带来的精度损失,适合高精度需求场景(如目标检测、语义分割、复杂对话系统)。其工程化逻辑的核心是 “梯度回传”—— 通过伪量化操作(训练时模拟量化过程,推理时执行真实量化),让模型在反向传播中学习到对量化鲁棒的权重分布;同时通过量化误差补偿(如对易损失精度的层采用混合精度),进一步降低效果衰减。QAT 的优势是精度接近原始模型,但需要标注数据和完整的训练流程,部署周期更长。

3. 量化工程化的核心难点与破解思路

量化的最大挑战是 “精度损失不可控” 与 “硬件兼容性差”。工程化实践中,通常通过三大策略破解:一是异常值处理,对权重或激活值中的极端值进行截断或单独处理,避免其拉大量化误差;二是自适应量化参数,根据不同层的分布特征动态调整 Scale 和 Zero Point,而非全局统一设置;三是硬件指令适配,针对不同芯片的量化加速指令(如 CPU 的 AVX-512、GPU 的 Tensor Cores、NPU 的 INT8 专用单元)优化量化流程,避免 “量化后反而变慢” 的问题 —— 例如,某些 CPU 不支持 INT4 指令,强行使用 INT4 量化可能导致推理延迟上升,此时需退化为 INT8 量化。

三、算子优化:用 “计算重构” 提 “运行效率” 的工程化逻辑

如果说量化解决的是 “模型体积” 问题,算子优化解决的则是 “计算速度” 问题。算子是模型计算的基本单元(如卷积、矩阵乘法、激活函数、注意力机制),传统算子的实现往往追求通用性,忽略了硬件特性与计算流程的冗余,导致计算效率低下。算子优化的工程化逻辑,是通过 “计算流程重构” 与 “硬件特性适配”,减少无效计算与内存访问开销,让算子在目标硬件上发挥最大性能。

1. 算子优化的核心方向:从 “通用” 到 “专用” 的适配

算子优化的底层目标是 “降低计算复杂度(FLOPs)” 和 “减少内存访问开销(MAC)”—— 这两者直接决定了推理延迟:计算量越大、内存读写越频繁,延迟越高。工程化实践中,优化方向主要分为三类:

-

算子融合:将多个连续的算子合并为一个复合算子,减少中间结果的存储与读写。例如,卷积(Conv)、偏置加法(Bias)、激活函数(ReLU)是深度学习模型中的常见组合,传统实现会分别执行三个算子,中间结果需多次读写内存;而融合为 “Conv+Bias+ReLU” 复合算子后,仅需一次计算、一次内存读写,延迟可降低 30% 以上。类似地,Transformer 中的层归一化(LayerNorm)与注意力机制(Attention)、FeedForward 网络也可进行融合优化。

-

计算图优化:对模型的计算图进行 “修剪” 与 “重组”,消除冗余计算。例如,常量折叠(将计算图中的常量表达式直接替换为结果)、冗余算子消除(删除无实际作用的算子,如恒等映射)、分支裁剪(根据业务场景删除无用的分支逻辑)。这种优化无需改变模型结构,仅通过调整计算流程即可提升效率,是轻量化部署的 “基础操作”。

-

硬件指令适配:针对目标硬件的架构特性,定制算子的指令执行方式。例如,CPU 的 SIMD(单指令多数据)指令可同时处理多个数据,算子优化需将计算任务拆分为适合 SIMD 指令的批次;GPU 的 CUDA Core 支持并行计算,需优化算子的线程块划分与内存访问模式;NPU(神经网络处理器)有专用的卷积、矩阵乘法单元,需将算子映射到对应的硬件加速单元,避免使用通用计算单元导致的性能浪费。

2. 算子优化的工程化实践:硬件感知与场景适配

算子优化的关键是 “不能脱离硬件谈优化”—— 同样一个算子,在 CPU 上的最优实现的在 GPU 上可能效率极低。例如,CPU 的缓存容量有限,算子优化需注重 “缓存友好性”,通过数据分块让计算数据尽可能留在高速缓存中,减少访问主存的次数;而 GPU 的显存带宽高、并行计算能力强,优化则需注重 “线程并行度”,让更多线程同时执行计算,充分利用硬件资源。

此外,算子优化还需考虑 “场景适配”:对于动态输入场景(如不同长度的文本、不同尺寸的图像),需设计自适应的算子实现,避免固定批次导致的性能波动;对于多任务模型,需针对核心任务的关键算子优先优化,平衡整体性能与开发成本。工程化实践中,通用算子与专用算子的取舍是重要考量:通用算子适配性强,但性能一般;专用算子针对特定场景优化,性能更高,但开发成本高、兼容性差。例如,针对移动端的图像识别模型,可开发专用的轻量化卷积算子;而跨平台部署的模型,则需以通用算子为主,辅以少量硬件专用优化。

四、量化与算子优化的协同工程化设计

量化与算子优化并非孤立存在,而是需要 “协同设计” 才能达到最佳效果。例如,量化后的算子数据类型发生变化(从 FP32 变为 INT8),若仍使用原始的浮点型算子实现,不仅无法发挥量化的优势,还可能因数据类型转换导致性能下降。协同设计的核心逻辑是 “量化参数引导算子优化”:

- 量化后的算子需适配整型计算逻辑,例如,INT8 卷积算子需采用适合整型计算的算法(如 Winograd 算法的整型实现),而非直接复用浮点型卷积的逻辑;

- 算子融合需考虑量化参数的传递,例如,融合 “Conv(INT8)+Bias(INT32)+ReLU(INT8)” 时,需确保 Bias 的整型精度能覆盖 Conv 的输出范围,避免溢出;

- 硬件指令适配需同步支持量化后的数据类型,例如,若目标硬件不支持 INT8 的 SIMD 指令,需调整量化策略(如使用 FP16 量化),或优化算子的指令调度方式。

工程化落地中,协同优化的流程通常是:先通过量化压缩模型体积,再针对量化后的模型进行算子融合、计算图优化与硬件适配,最后通过多轮测试(精度测试、延迟测试、内存测试)调整参数,直至达到 “精度达标、延迟最优、内存可控” 的目标。

五、工程化落地的挑战与未来趋势

AI 轻量化部署的工程化实践,始终面临三大核心挑战:一是精度与资源的平衡临界点难以把握 —— 过度量化或激进的算子优化可能导致精度暴跌,而保守策略又无法满足

编辑分享

生成一篇关于AI轻量化部署核心方案的文章

提供一些AI量化与算子优化的工程化实现案例

介绍一下模型量化和算子优化的未来发展趋势

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)