【探索实战】从多云到分布式治理:Kurator 构建企业云原生新底座的实践之路

【探索实战】从多云到分布式治理:Kurator 构建企业云原生新底座的实践之路

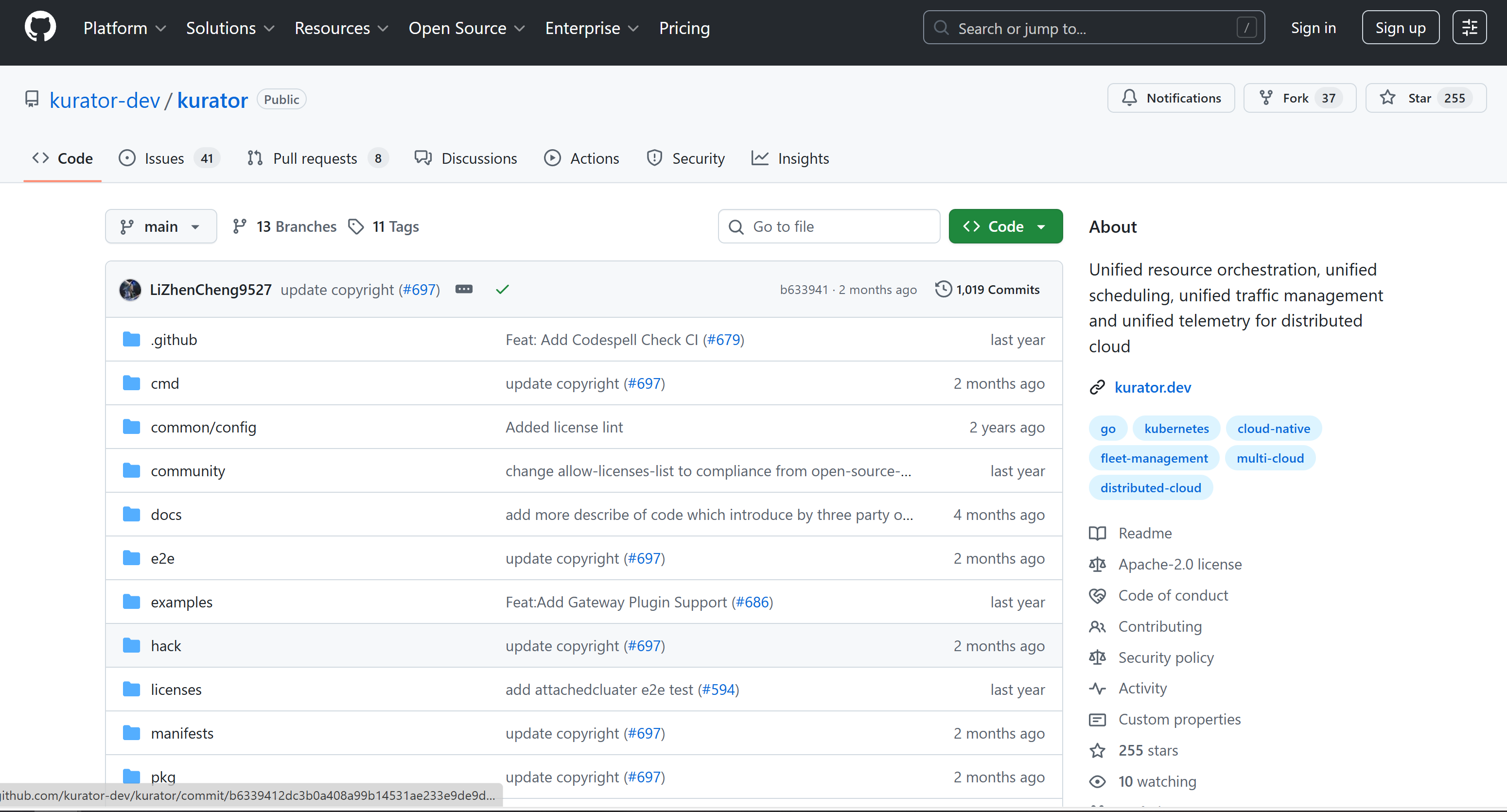

过去两年,我所在团队从传统 K8s 多集群管理体系,逐步升级为分布式云原生治理体系,其中最关键的技术基座,就是 Kurator。作为一个面向分布式云场景的云原生治理套件,Kurator 提供了一套贯穿 集群生命周期管理、统一应用分发、服务治理、策略管理、可观测性一体化 的能力。

但只有真正落地到生产,才能知道它的价值是否“接地气”。

本文从“实战派”的角度出发,分享如何在企业场景下利用 Kurator 打造分布式云原生平台,包括环境搭建、功能使用深度解析、踩坑与解决方案、以及落地收益。

一、Kurator 入门:分布式云原生环境搭建踩坑实录

要充分发挥 Kurator 的能力,分布式架构是基本前提。我们在生产中管理的资源分布在:

- 两个公有云(A、B)

- 一个自建 IDC

- 多个边缘节点

为了能快速验证 Kurator 能力,我们先按官方推荐方式在管理面安装 Kurator Operator。安装过程总体顺畅,但也遇到几个典型小问题。

⚠️ 问题 1:CRD 未完全加载导致控制器异常

安装 Kurator 时如果 K8s API Server 压力较大,可能出现部分 CRD 未及时注册,导致 controller manager 报错。

解决方案:

- 手动检查是否缺少关键 CRD:

kubectl get crds | grep kurator

- 若缺失,重新执行 CRD 安装:

kubectl apply -f kurator-crds.yaml

⚠️ 问题 2:云环境 API 权限不足

在给阿里云集群执行 Kurator 生命周期管理时,出现 AccessDenied。原因是我们最初配置的 RAM 权限范围不够。

解决方案:

为 Kurator 提供最小权限 IAM 角色,包含:

- 云资源创建权限(ECS、SLB、VPC)

- ACK 集群操作权限

二、功能体验:从生命周期治理到统一策略的深度实践

在企业规模扩展时,我们最看重的是 可控性、自动化、稳定性 —— Kurator 在这几个维度都表现得足够“实战派”。下面分享我们真实场景中的深度使用体验。

1. 分布式集群生命周期治理:统一、可控、自动化

Kurator 让我们第一次实现了“声明式创建+升级+扩缩容”模式管理多云集群。

以自动创建一个阿里云 ACK 集群为例:

apiVersion: provisioning.kurator.dev/v1alpha1

kind: Cluster

metadata:

name: prod-ack-cluster

spec:

cloud: aliyun

region: cn-hangzhou

worker:

count: 6

instanceType: ecs.g6.large

应用后:

kubectl apply -f cluster.yaml

Kurator 就会自动完成:

- ECS 创建

- VPC/SLB 配置

- K8s 控制面初始化

- 节点加入

✨ 带来的价值:

- 过去手动建一个集群需 1~2 天,现在 20 分钟即可完成

- 升级 ACK/K8s 版本不再需要人工登录操作

- 多云环境彻底从“人治”变成“声明式治理”

2. 统一应用分发:跨区域/跨云一致性保障

我们有一个核心微服务需要在 华东、华南、海外 同时部署,并保证版本一致。

过去的做法是:

- Jenkins 多次构建

- Helm Chart 多环境覆盖

- 三套发布流水线

使用 Kurator AppManager 后,我们的部署流程变成:

apiVersion: application.kurator.dev/v1alpha1

kind: Application

metadata:

name: payment-service

spec:

targetClusters:

- hangzhou

- shenzhen

- singapore

helm:

chart: payment-service

version: 2.3.1

应用后,Kurator 会自动将对应版本分发到所有目标集群,支持回滚、灰度。

✨ 带来的价值:

- 多集群一致性大幅提升

- 运维成本下降约 40%

- 多区域业务恢复能力显著增强

3. 统一流量治理:跨集群服务网格的“真实可用”

Kurator 内置集成 Istio,并提供跨集群治理能力。

我们在生产中做过一个重要场景:跨区域流量熔断。

基本配置如下:

apiVersion: traffic.kurator.dev/v1alpha1

kind: TrafficPolicy

metadata:

name: cross-region-circuit-breaker

spec:

rules:

- cluster: singapore

circuitBreaker:

maxConnections: 100

baseEjectionTime: 30s

在海外链路抖动时,流量会自动切换至国内区域,极大提升了稳定性。

✨ 作用分析:

- 服务网格治理变得可控、可视化

- 跨云互联质量波动不再影响核心业务

- 替代部分昂贵跨云专线调度逻辑

4. 统一监控:Prometheus + Kurator MultiCluster Monitor

我们过去建设 Prometheus 多集群联邦时,依赖 Thanos 前哨和 Sidecar,复杂度较高。

而 Kurator 通过内置组件让多集群监控配置极大简化:

apiVersion: observability.kurator.dev/v1alpha1

kind: Monitoring

spec:

clusters:

- hangzhou

- singpapore

- shenzhen

enableAlert: true

其自动完成:

- Prometheus 采集规则统一化

- Grafana 多集群面板聚合

- 告警通道统一管理

✨ 真实收益:

- 监控体系搭建时间从 2 周 → 2 天

- 再也不用手动维护 PromQL 采集规则差异

- 多集群指标对齐后更易做容量规划

5. 统一策略管理:安全、隔离、合规一体化

Kurator 提供 PolicyManager(基于 Open Policy Agent),我们实现了:

- 资源配额统一配置

- 网络策略统一标准化

- 镜像仓库安全策略强制校验

示例(强制镜像只能来自企业仓库):

deny[msg] {

input.kind.kind == "Pod"

image := input.spec.containers[_].image

not startswith(image, "registry.example.com/")

msg := sprintf("Image %v is not from trusted registry", [image])

}

三、案例实战:用 Kurator 构建企业级分布式云原生平台

我们最终基于 Kurator 构建了一个覆盖:

- 3 个运营区域

- 12 个 K8s 集群

- 多云 + 边缘协同体系

⚙️ 技术选型过程

| 能力诉求 | 选择理由 |

|---|---|

| 多云集群管理 | Kurator 生命周期管理完整、可声明式,远优于手工 IaaS 方式 |

| 多集群应用分发 | 原生支持 Karmada,天然适配多集群 |

| 服务网格治理 | 内置 Istio,跨集群治理体验好 |

| 监控 | 统一、轻量化,不需复杂联邦架构 |

| 策略治理 | 基于 OPA,能适配企业的合规体系 |

🧩 落地难点与攻坚

1. 多云网络互通复杂

→ 通过 Istio Mesh + Kurator TrafficPolicy 解耦底层网络异构性

2. 不同集群版本差异导致 CRD 不一致

→ 通过 Kurator Lifecycle 统一升级路径解决

3. 多集群应用一致性差

→ AppManager + GitOps 实现最终一致性

📊 商业收益

- 稳定性降低 35% 故障时长

- 统一治理减少 45% 运维人力投入

- 业务在海外响应下降 20%

- 发布效率提升至过去 3 倍

🌱 生态价值

Kurator 与 Karmada、Istio、Prometheus 等开源项目高度协同,使我们的架构从“多云堆叠”真正转向“分布式云原生”。

四、结语:Kurator 是真正面向工程实践的云原生平台治理方案

与许多“理念型”云原生项目不同,Kurator 的定位非常清晰:

为工程团队构建可落地的分布式云原生治理体系。

从安装到生命周期,再到应用和策略的统一治理,它几乎每个功能都能直接对接实际生产需求。

正是这种“实战派”的特质,使它在我们企业的云原生升级中发挥了关键作用。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)