【前瞻创想】从碎片化到一体化:一个实战派视角看Kurator如何重构分布式云原生的管理与应用体验

【前瞻创想】从碎片化到一体化:一个实战派视角看Kurator如何重构分布式云原生的管理与应用体验

【前瞻创想】从碎片化到一体化:一个实战派视角看Kurator如何重构分布式云原生的管理与应用体验

1 直面分布式云原生时代:挑战与破局之道

1.1 当“分布式”成为常态:复杂性与割裂感的双重挑战

在多云、混合云以及边缘计算逐渐成为企业标准基础设施的今天,我们正全面步入“分布式云原生”时代。然而,技术的演进在带来灵活性与弹性优势的同时,也引入了前所未有的管理复杂性。相信很多一线开发者和管理员都有过这样的切身体会:应用需要部署在A云、B云以及自有机房,同时还要管理成百上千的边缘节点。这时,你会发现每一个环境可能运行着不同版本的Kubernetes,使用了不同的服务网格配置,监控数据散落在各处的Prometheus中,调度策略也无法统一。这种**“碎片化”的管理体验**,导致运维效率低下、故障排查困难、资源利用率不均衡,严重消耗着技术团队的精力。

1.2 Kurator的破局思路:不是重复造轮子,而是打造“粘合剂”

面对上述挑战,业界有两种常见的应对思路:一是针对某个具体问题(如流量治理)选择一个强大的单点工具(如Istio),但其他维度的管理依然割裂;二是投入巨大研发资源,尝试自研一个大一统的管理平台,但这往往周期长、风险高。Kurator (kurator-dev) 的出现,则代表了一条更优雅的“第三条道路”。它的核心创想并非从零开始替代Istio、Karmada、Prometheus这些已被验证的优秀开源项目,而是致力于成为它们之间的**“超级粘合剂”。Kurator站在巨人的肩膀上,通过一套统一的API和声明式配置**,将这些离散的工具整合为一个有机协同的整体,旨在为用户提供开箱即用、体验一致的分布式云原生一站式解决方案。

2 庖丁解牛:深度解读Kurator的一体化架构与核心组件

2.1 以Karmada为基石:统一编排的“大脑”

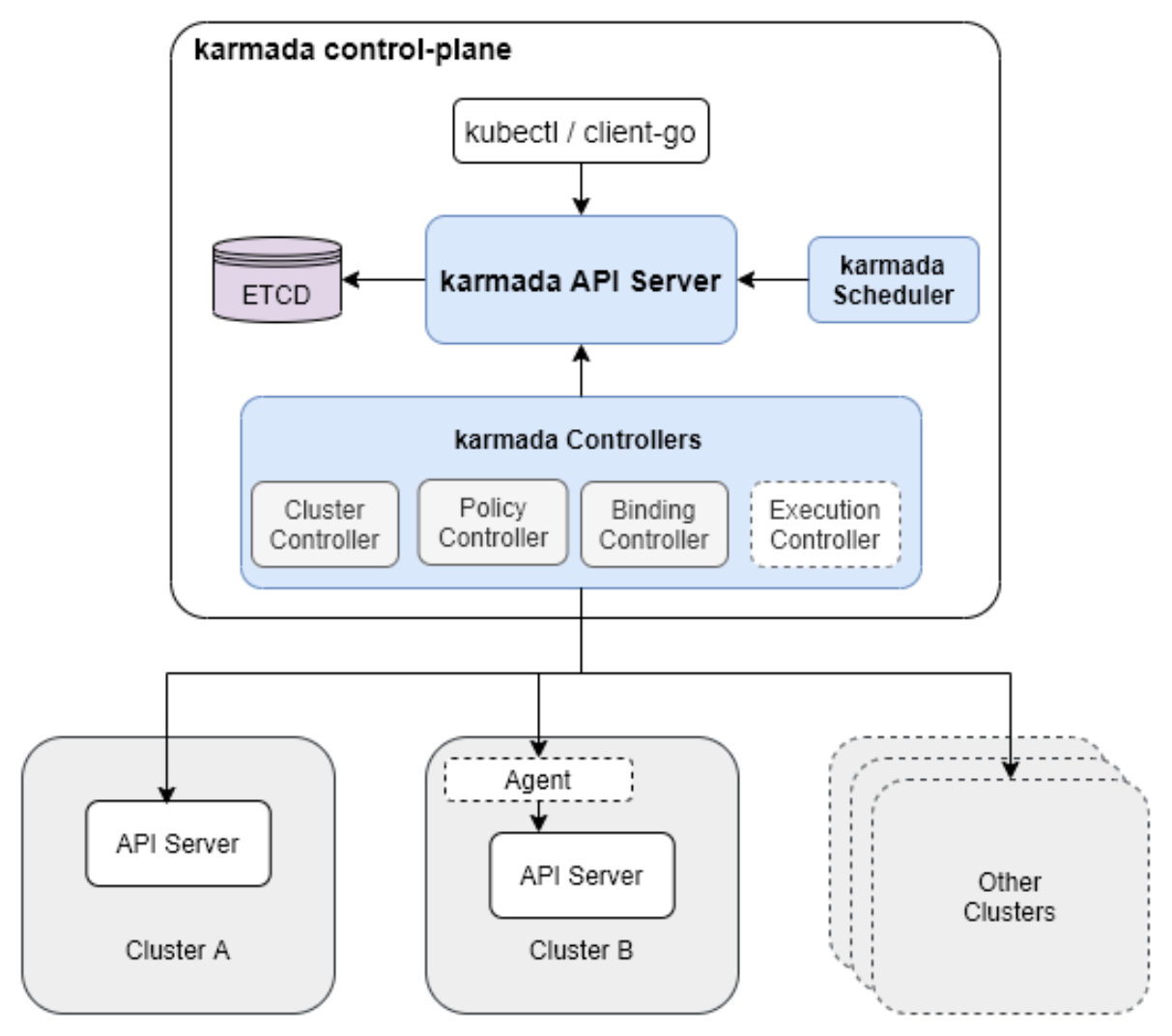

Kurator的架构设计深刻体现了集成与增强的理念。其核心基石是Karmada,一个源自华为云捐献给CNCF的多云容器编排项目。Kurator将Karmada作为其统一资源编排的“大脑”,继承了Karmada强大的多集群应用部署、故障迁移与自动伸缩能力。但Kurator并未止步于此,它在Karmada提供的基础编排层之上,构建了更上层的抽象和管理能力。你可以这样理解:Karmada确保了你的Deployment、Service等资源能被正确分发到目标集群,而Kurator则要确保这些应用在跨集群运行时,其流量、监控、调度和边缘协同也能按照统一的策略工作。

这是Karmada 的总体架构官方参考图,详细部分可以看看这个图:

2.2 四大统一能力:构建完整的管理闭环

基于坚实的编排基础,Kurator着力构建了四大核心统一能力,形成一个完整的管理闭环:

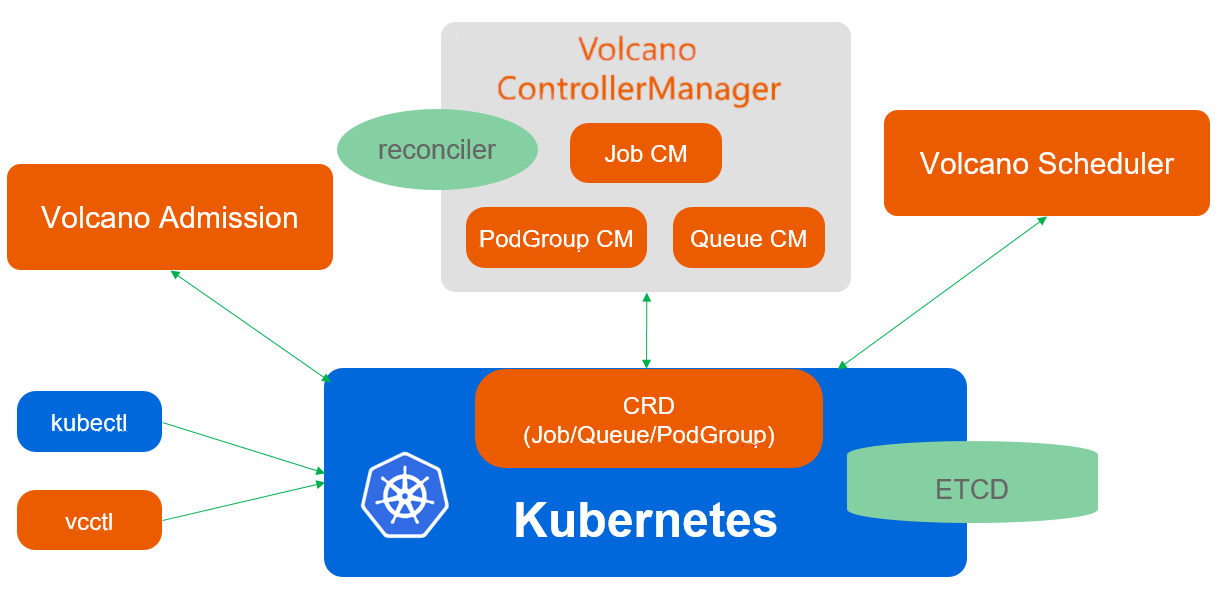

- 统一调度 (Unified Scheduling):这不仅仅是Kubernetes层面的Pod调度,更是跨集群、跨云、跨地域的宏观工作负载调度。Kurator集成了Volcano——一个源自华为云的面向高性能计算场景的批处理调度器。通过集成Volcano,Kurator能够处理有复杂依赖关系、需要队列管理、抢占等高级调度需求的批量计算任务(如AI训练、基因测序),并将这些能力从单集群扩展到整个分布式集群舰队。

- 统一流量治理 (Unified Traffic Management):服务网格Istio是解决微服务间流量管理的利器,但其原生设计主要针对单集群。Kurator通过扩展和整合Istio,实现了跨集群的服务发现与流量治理。这意味着,位于北京AWS集群的Service A可以像调用本地服务一样,无缝、安全且可观测地调用位于上海Azure集群的Service B,打破了集群边界对微服务的束缚。

- 统一可观测性 (Unified Telemetry):监控数据孤岛是分布式运维的噩梦。Kurator原生集成了Prometheus和Thanos。它能够在各个集群中自动化部署和维护一套一致的Prometheus监控体系,并利用Thanos的全局查询能力,让运维人员可以从一个单一的入口,查询和汇聚所有集群的监控指标,轻松实现全局的监控视图和告警。

- 云边端协同 (Multi-cloud, Edge-cloud, Edge-edge Synergy):为了拥抱边缘计算,Kurator集成了KubeEdge,将容器化的应用管理和编排能力延伸至网络边缘和物联网设备。这使得在同一个Kurator控制平面下,你可以同时管理中心的云集群和成千上万的边缘节点,实现应用的统一分发、配置和状态同步。

Kurator的核心价值参考图:

3 实战启航:快速搭建你的第一个Kurator分布式环境

3.1 环境准备与一键安装

理论需要实践来验证。让我们从零开始,亲手搭建一个Kurator环境。首先,你需要一个或多个已经安装好Kubernetes(版本1.20+)的集群,其中一个将作为宿主集群 (Host Cluster),用于安装Kurator的控制平面。

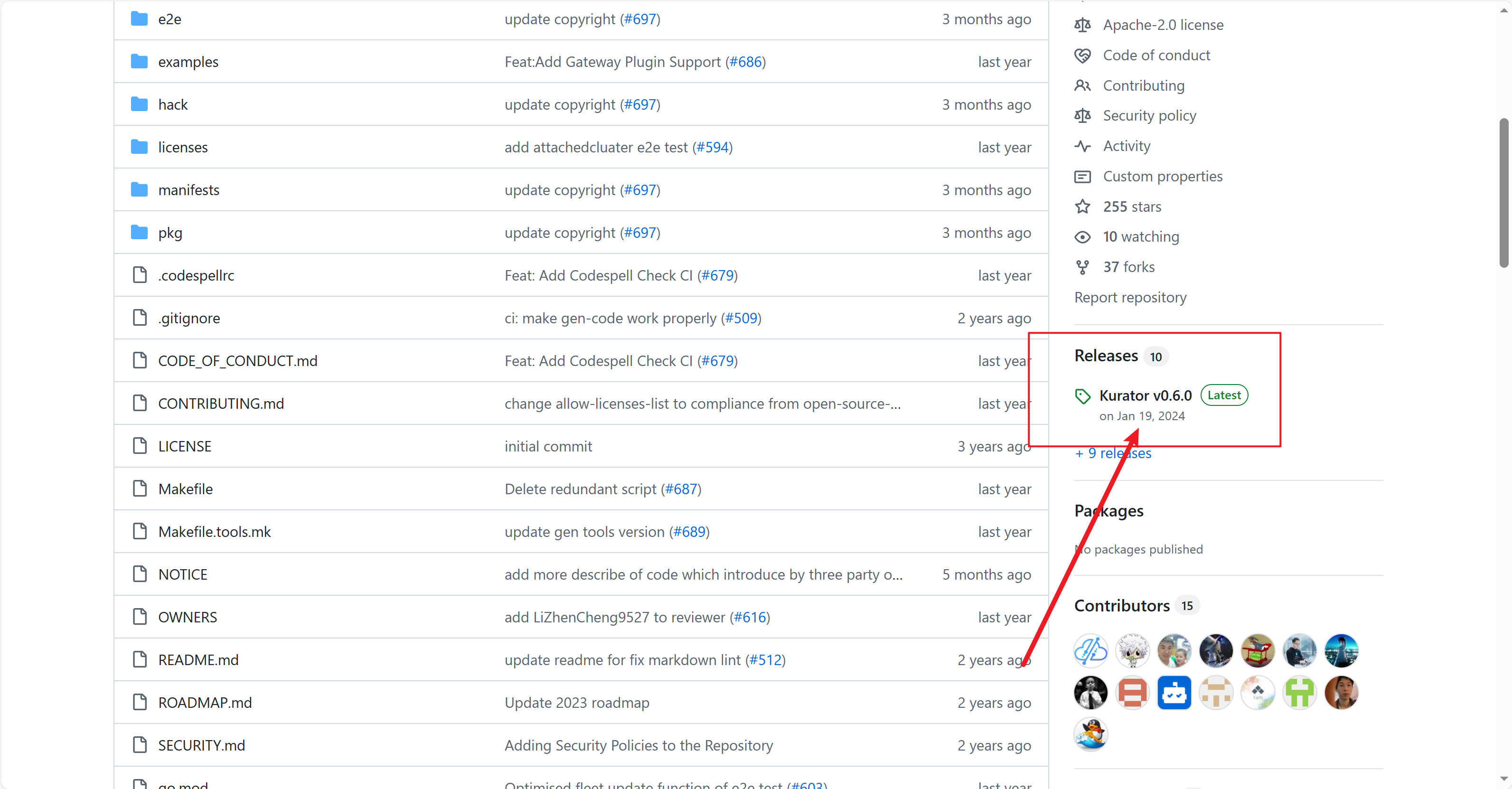

我们可以从github上面下载源码,我把源码标注出来啦

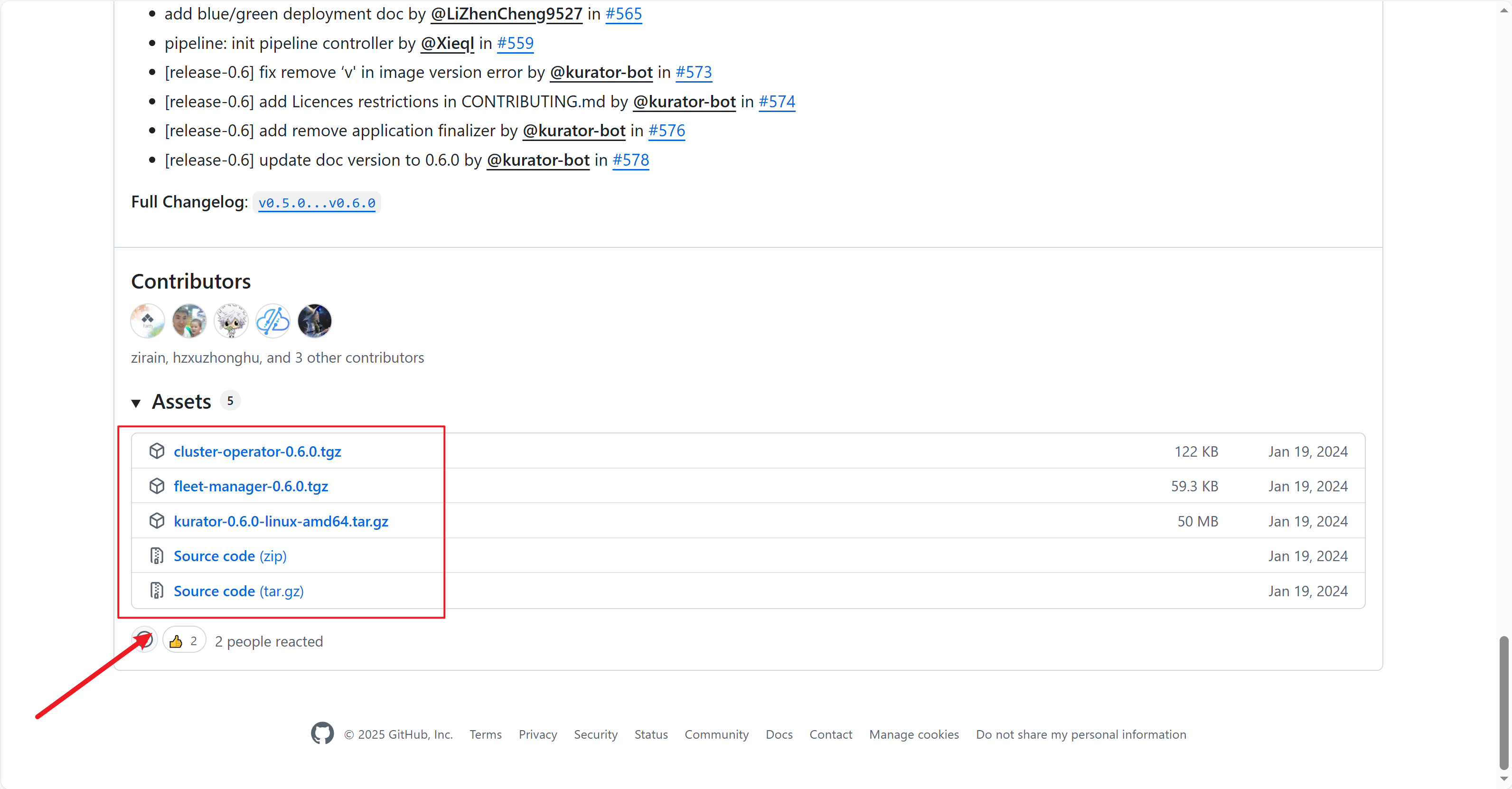

点击后拉到最下面就可以看到源码压缩包啦,不同需求的朋友可以下载不同平台的源码

下载下来解压就可以看到源码文件啦

进入目录后,你会发现Kurator提供了非常清晰的安装脚本。其安装过程本质上是在宿主集群上部署一系列的核心Operator和CRD。运行安装脚本后,你可以通过以下命令验证控制平面的组件是否健康:

kubectl get pods -n kurator-system

如果看到所有Pod状态均为 Running,恭喜你,Kurator的控制平面已经就绪。

3.2 集群舰队(Fleet)的创建与纳管

安装好控制平面后,下一步是将你的其他Kubernetes集群纳入管理,形成一个集群舰队 (Fleet)。这是Kurator的一个关键抽象概念。你只需要准备一个简单的YAML文件,定义你的Fleet,并通过 kubectl apply 提交给Kurator。

在这个Fleet资源中,你会指定要纳管的成员集群的 Kubeconfig信息或接入方式。Kurator的控制平面会自动与这些集群建立连接,完成必要的组件(如Karmada Agent)部署。此后,你就可以以这个Fleet为单位,进行所有后续的应用分发、流量和政策管理操作,而无需再关心底层具体的集群细节。

4 深度场景实践:基于Kurator构建跨云弹性在线应用

4.1 场景描述:一个高可用的在线教育平台

假设我们正在运营一个在线教育平台,业务架构如下:

- 核心服务(用户、课程、订单):部署在阿里云主集群,承载主要业务流量。

- AI互动服务(实时音视频、白板):部署在腾讯云集群,利用了该云特定的GPU资源。

- 边缘缓存节点:遍布全国各地的边缘节点(通过KubeEdge管理),缓存课程视频流,降低骨干网压力,提升学生观看体验。

- 挑战:需要确保核心服务与AI服务能跨云互通;在阿里云主集群故障时,核心服务能自动迁移到腾讯云;全国学生的视频请求能智能路由到最近的边缘节点。

4.2 使用Kurator实施一体化部署与管理

第一步:统一应用分发。 我们不再需要为阿里云、腾讯云分别编写两套部署清单。只需定义一份Kurator的 Workload(其背后是Karmada的PropagationPolicy),并指定分发策略。例如,将核心服务的5个副本部署在阿里云,同时预留3个副本作为“暖备胎”部署在腾讯云。一份配置,全局生效。

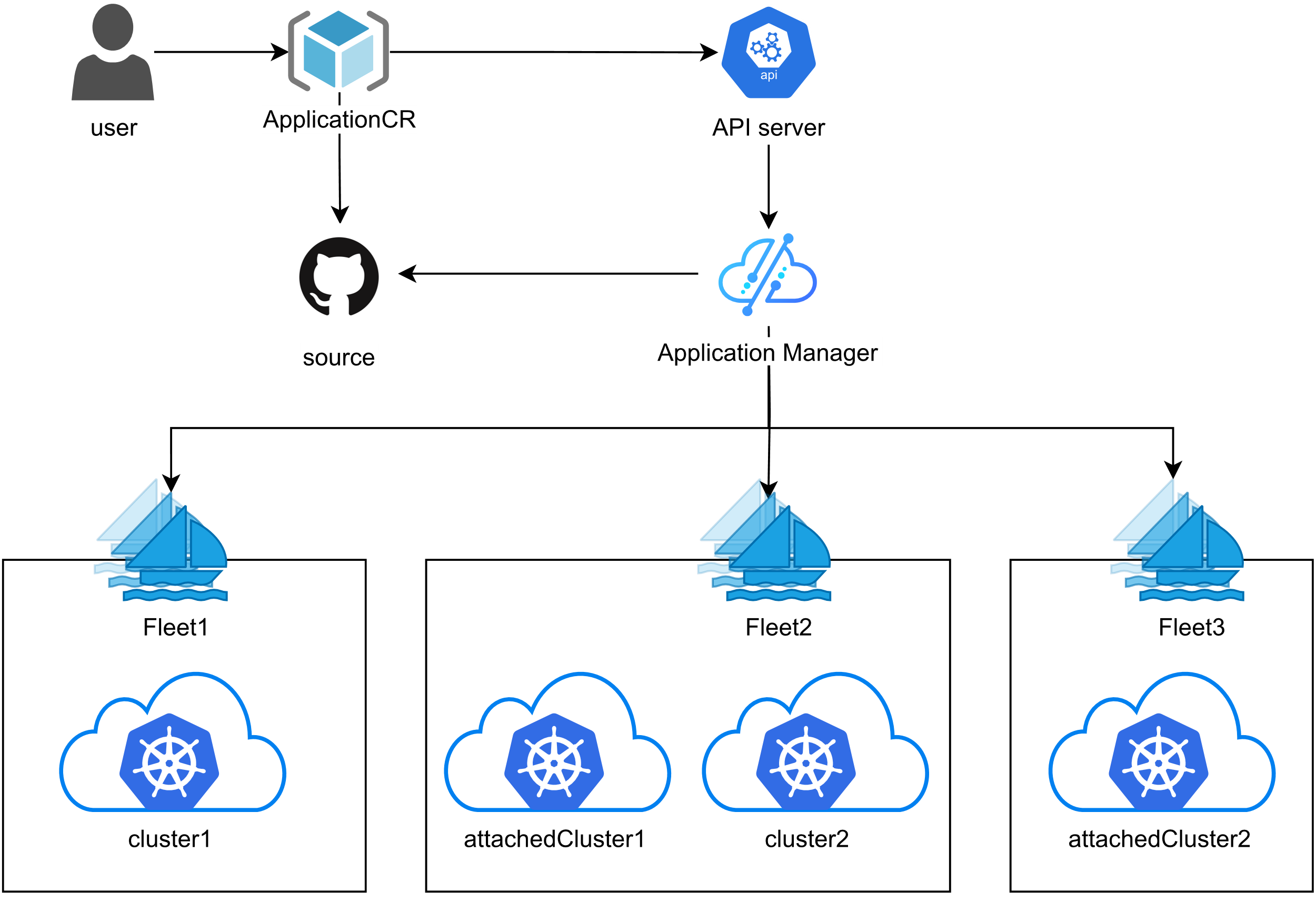

Kurator 统一应用分发流程参考图:

第二步:配置跨云服务网格。 在Kurator的治理平面中,我们为“核心服务”和“AI互动服务”创建一个 ServiceMesh 资源。Kurator会自动在阿里云和腾讯云集群中配置Istio,建立跨集群的mTLS安全通信通道,并配置必要的ServiceEntry和VirtualService,使得两个位于不同云上的服务可以像在同一个集群内一样通过服务名直接调用。

第三步:设置统一的可观测性。 我们在Fleet层面启用监控功能。Kurator自动在所有集群(包括边缘节点)部署Prometheus收集器,并配置Thanos Sidecar和Query Frontend。我们的运维人员只需访问Thanos Query的一个前端地址,就能绘制一张包含阿里云核心服务QPS、腾讯云GPU利用率、各地边缘节点缓存命中率的综合监控大盘。

第四步:定义高级调度策略。 当平台需要进行大规模的离线作业(如夜间批量生成课程学习报告)时,我们创建一个 BatchJob,并引用集成了Volcano能力的调度策略。该策略可以指定作业的优先级队列、在夜间空闲的腾讯云GPU资源上运行、并在早上9点前必须完成,否则进行抢占。Kurator确保这个批处理作业能在整个分布式资源池中被高效、有序地调度。

Volcano调度架构参考图,感兴趣的朋友可以看看:

5 Kurator的创新优势与未来展望

5.1 超越简单集成的核心价值

通过上述实践,我们可以清晰地看到Kurator相较于“手动组合开源栈”或“使用单一功能平台”的独特优势:

- 体验一致性:为用户屏蔽了底层多个组件的复杂配置,提供了一套统一、声明式的API。用户的操作心智从“管理多个集群、多个工具”转变为“管理一个分布式应用”。

- 内聚的协同效应:各组件不是孤立工作。例如,调度器能感知流量策略(避免将频繁通信的服务调度到网络延迟高的集群),监控系统能追踪跨集群的调用链。这种“1+1>2”的协同是手动集成极难实现的。

- 开箱即用的生产就绪性:项目提供了经过验证的默认配置和最佳实践集成方案,如安全的数据面通信、高可用的控制面部署等,让用户能快速获得一个稳定、可用于生产的环境,而非一个脆弱的“演示原型”。

5.2 对分布式云原生技术发展的思考与建议

作为一名云原生社区的参与者,我认为以Kurator为代表的项目指明了分布式云的一个重要发展方向:“体验层”的创新。未来,技术的竞争将不仅限于单点功能的强弱,更在于如何将复杂的技术栈整合为简单、直观、可靠的产品化体验。对此,我提出两点展望:

- 智能化的自治运维:未来的分布式云平台应内置更多AIOps能力。例如,基于全局监控数据,自动诊断出跨集群调用链的瓶颈并给出优化建议(如调整副本分布),甚至能预测边缘节点资源消耗,自动执行弹性伸缩。

- 更开放的解耦与可插拔架构:Kurator以集成主流项目为起点,其成功也依赖于一个活跃的生态。建议其架构继续保持高度模块化,允许用户根据需要替换或升级底层组件(例如选择其他服务网格或调度器),并通过标准的接口与更广阔的开源工具链(如GitOps的Argo CD)深度融合,真正成为用户个性化云原生平台的“乐高底座”。

6 结语:拥抱分布式未来,从Kurator开始

总而言之,Kurator并非又一个孤立的云原生项目,而是应对分布式云原生复杂性的一个系统性答案。它精准地抓住了当前企业从“上云”到“分布式用云”转型过程中的核心痛点,并通过集成、增强和统一现有顶级开源项目的方式,提供了一条平滑的演进路径。对于希望构建跨云、跨边、统一管理能力的企业和团队而言,Kurator是一个非常值得深入研究和实践的起点。它降低了分布式云原生技术的入门门槛,让开发者能更专注于业务价值本身,而非底层基础设施的纷繁复杂。

Kurator分布式云原生开源社区地址:https://gitcode.com/kurator-dev

Kurator分布式云原生项目部署指南:https://kurator.dev/docs/setup/

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)