创新应用玩法:唤醒昇腾NPU中的“神笔马良”——实战Stable Diffusion文生图

AIGC的“神笔”虽好,却像个灵感迸发但不太听话的艺术家。你希望画一个“举手庆祝的女孩”,它却可能给你一个叉腰的;你想要一个“两人深情对望”的场景,它却画成了“你看我我看天”。我们输入的Prompt,更多时候像是一种“许愿”,至于AI最终如何构图、人物如何摆姿势,充满了“开盲盒”般的随机性。

引言:你是否也被AI的“自由发挥”所困扰?

AIGC的“神笔”虽好,却像个灵感迸发但不太听话的艺术家。你希望画一个“举手庆祝的女孩”,它却可能给你一个叉腰的;你想要一个“两人深情对望”的场景,它却画成了“你看我我看天”。我们输入的Prompt,更多时候像是一种“许愿”,至于AI最终如何构图、人物如何摆姿势,充满了“开盲盒”般的随机性。

那么,有没有一种方法,能让我们从一个“许愿者”,变成一个手握“设计图”的“总导演”,让AI一笔一划都严格按照我们的意图来创作?

答案是肯定的,而这,就是本次实战要解锁的、真正激动人心的“创新玩法”——ControlNet。我们将不再满足于简单的文字生成,而是要给AI戴上一个“精准导航仪”,实现对画面构图和人物姿态的像素级掌控。

本次测评,我们将扮演一名“AI导演”,在昇腾AI平台上,为我们“神笔马良”装上ControlNet这双“眼睛”,让它看懂我们的“设计稿”,实现从“随心所欲”到“指哪画哪”的终极进化。

第一章:为“精准操控”而生的创作平台——重解昇腾AI

要驾驭ControlNet这样更精密的应用,我们需要一个更强大的引擎。这里我选择了"昇腾"去充当这强大的引擎。

图1-1:昇腾AI架构图——我们的“高精度制导系统”

-

底层 · Ascend IP**(动力澎湃的引擎):ControlNet的原理是在Stable Diffusion的U-Net结构中,加入了额外的“控制分支”。这意味着每一次生成,计算量都比原来大得多**。昇腾NPU强大的并行计算能力,正是驱动这个“主模型+控制模型”双重计算负载、避免创作过程变成漫长等待的核心动力源。

-

核心 · CANN**(智能调度系统)**:CANN在这里扮演了“智能调度系统”的角色。它需要理解一个更复杂的计算图,不仅要处理文本引导的去噪过程,还要处理来自ControlNet的“空间结构引导”。CANN能够高效地将这些交织在一起的计算任务,合理地分配给NPU的硬件单元,确保整个“制导”流程流畅无卡顿。

-

顶层 · PyTorch & 应用(驾驶舱):PyTorch和我们即将构建的ControlNet应用,就是我们的“驾驶舱”。我们在这里输入指令(Prompt)和“设计图”(控制图像),而昇腾的技术则负责将我们的指令精准、快速地执行。

第二章:一键启动“AI导演工作室”

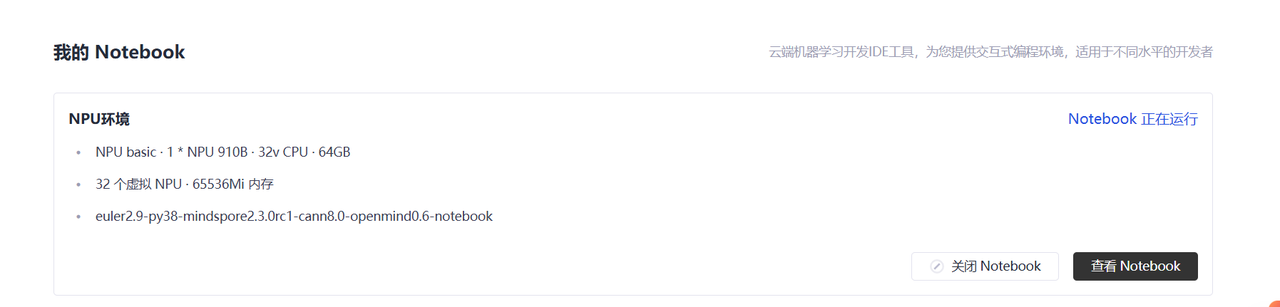

和之前一样,我们首先需要一个无需配置、拎包入住的创作环境。昇腾云端Notebook依旧是我们的不二之选。

图2-1:登录昇腾AI开发平台

图2-2:选择NPU规格和预置了CANN、PyTorch的容器镜像

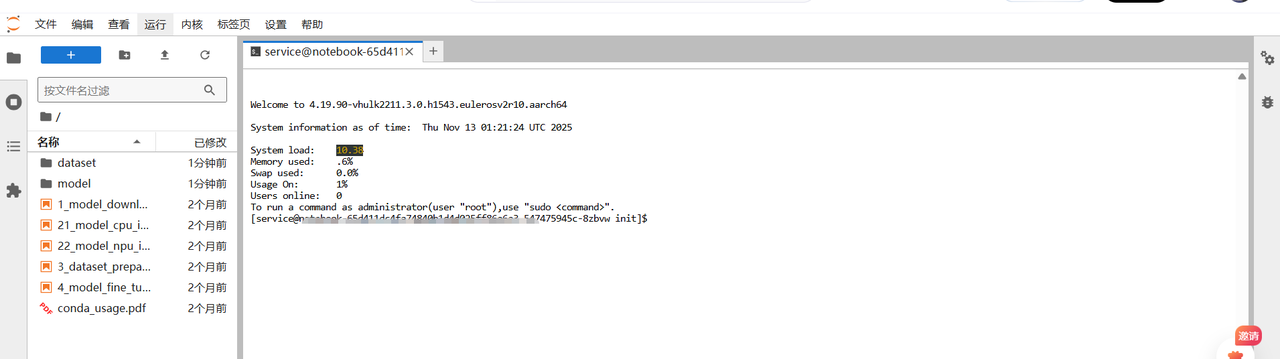

选择好配置后,点击“立刻启动”,我们的专属“AI导演工作室”——JupyterLab,便准备就绪。

图2-3:JupyterLab——我们的创意指挥中心

第三章:实战!三步让AI“看懂”你的设计图

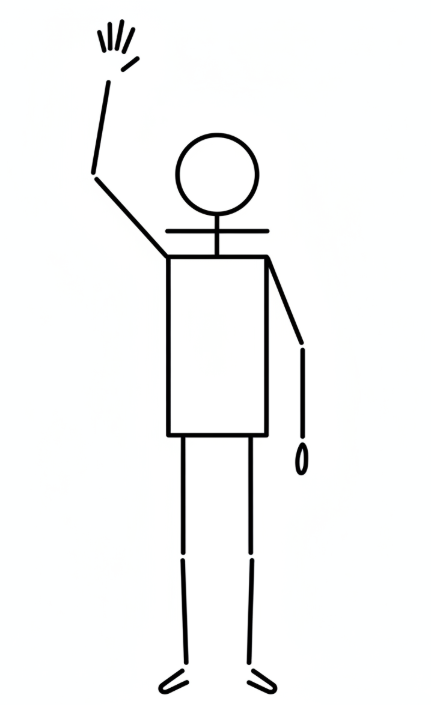

我们的目标是:提供一张简单的“人体姿态骨骼图”(俗称“火柴人”),让AI生成一个与“火柴人”姿势完全一致、但细节丰富、画风精美的真实人物。

第一步:准备“演员”和“剧本” —— 下载核心模型

我们需要三样东西:基础的“演员”(Stable Diffusion模型)、精准的“动作指导”(ControlNet模型)和一本“字典”(一些辅助库)。

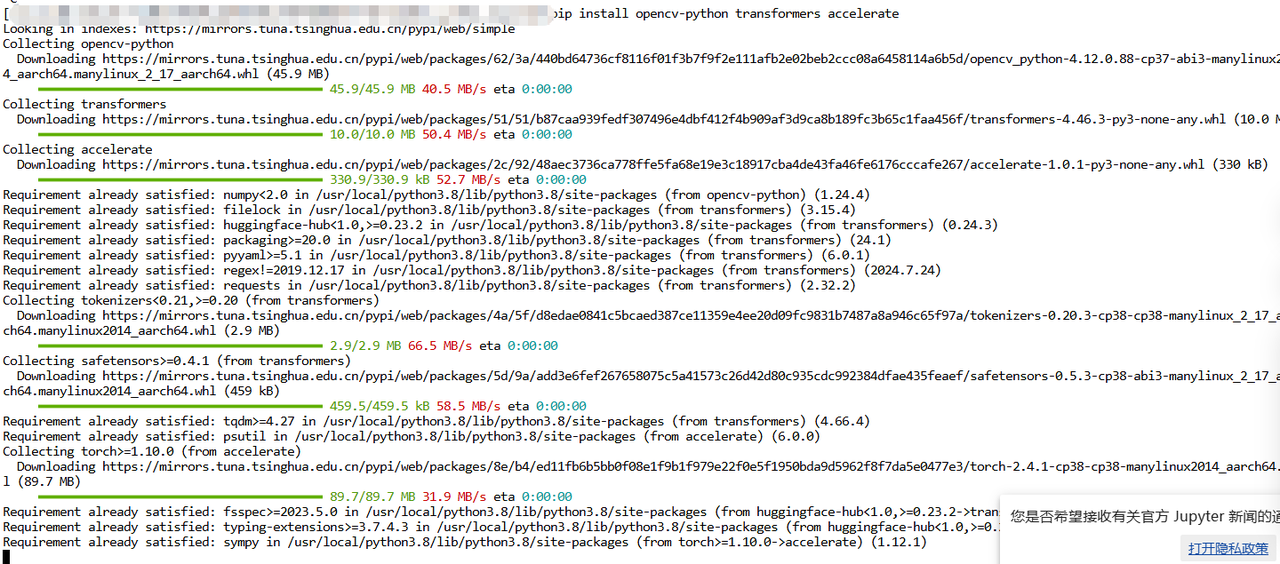

在JupyterLab的终端中,执行以下命令:

# 1. 安装必要的库

pip install opencv-python transformers accelerate

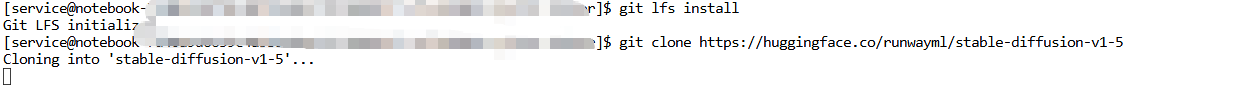

# 2. 下载Stable Diffusion v1.5基础模型 (我们的主演)

git lfs install

git clone https://huggingface.co/runwayml/stable-diffusion-v1-5

# 3. 下载ControlNet OpenPose模型 (我们的动作指导)

# OpenPose专门用于识别人体姿态

git clone https://huggingface.co/lllyasviel/control_v11p_sd15_openpose

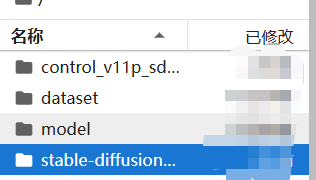

当左侧文件浏览器中出现stable-diffusion-v1-5和control_v11p_sd15_openpose两个文件夹时,我们的“演员”和“动作指导”就都位了。

第二步:绘制“分镜草图” —— 准备姿态控制图

我们需要一张给AI看的“设计稿”。这里我们用一张现成的姿态骨骼图。你可以将下面的图片保存下来,并上传到JupyterLab中,命名为pose.png。

这张简单的“火柴人”图,就是我们给AI下达的最直观、最不容置疑的命令。

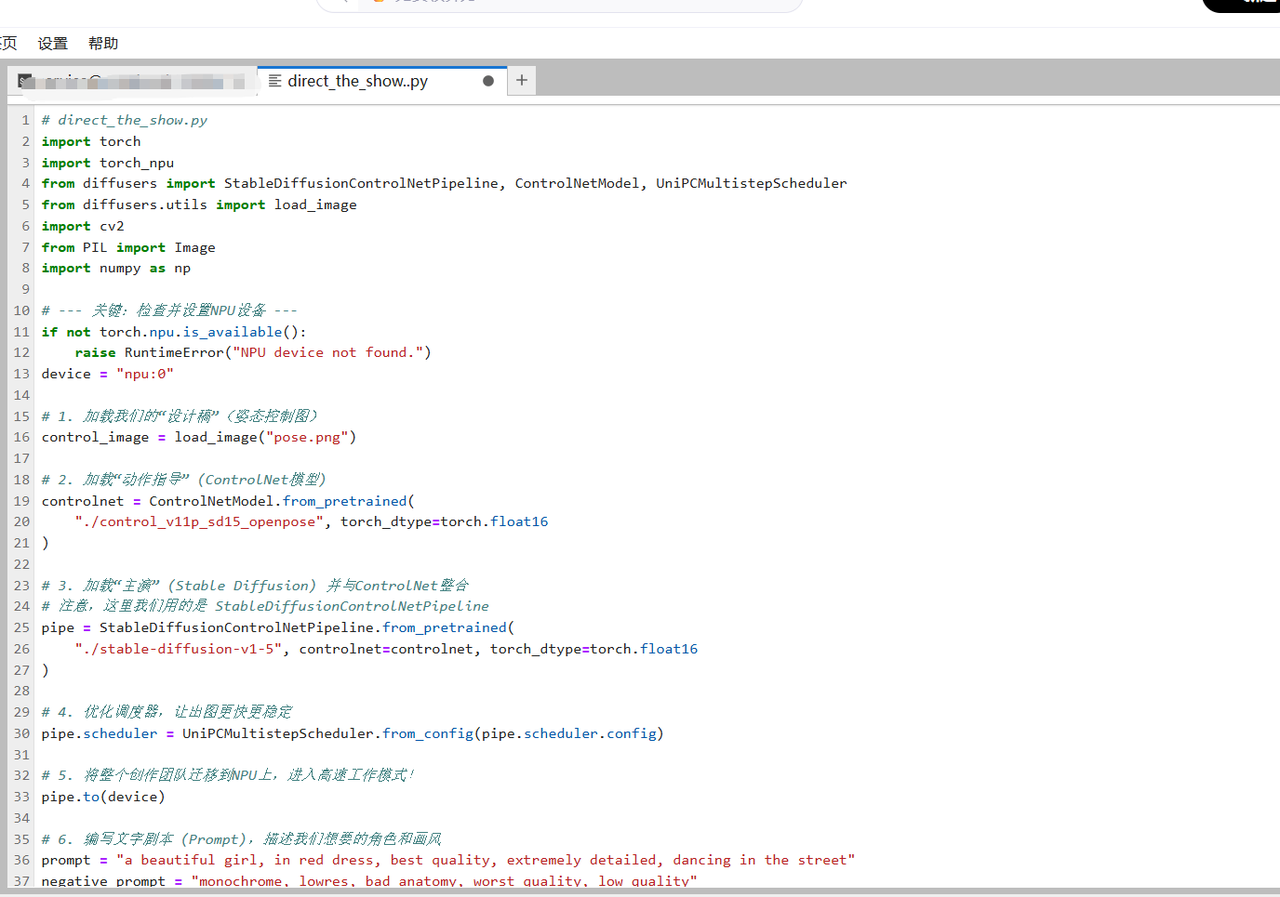

第三步:开拍!编写并运行“导演脚本”

现在,万事俱备。我们来编写一个Python脚本direct_the_show.py,指挥我们的AI团队开始创作。

# direct_the_show.py

import torch

import torch_npu

from diffusers import StableDiffusionControlNetPipeline, ControlNetModel, UniPCMultistepScheduler

from diffusers.utils import load_image

import cv2

from PIL import Image

import numpy as np

# --- 关键:检查并设置NPU设备 ---

if not torch.npu.is_available():

raise RuntimeError("NPU device not found.")

device = "npu:0"

# 1. 加载我们的“设计稿”(姿态控制图)

control_image = load_image("pose.png")

# 2. 加载“动作指导” (ControlNet模型)

controlnet = ControlNetModel.from_pretrained(

"./control_v11p_sd15_openpose", torch_dtype=torch.float16

)

# 3. 加载“主演” (Stable Diffusion) 并与ControlNet整合

# 注意,这里我们用的是 StableDiffusionControlNetPipeline

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"./stable-diffusion-v1-5", controlnet=controlnet, torch_dtype=torch.float16

)

# 4. 优化调度器,让出图更快更稳定

pipe.scheduler = UniPCMultistepScheduler.from_config(pipe.scheduler.config)

# 5. 将整个创作团队迁移到NPU上,进入高速工作模式!

pipe.to(device)

# 6. 编写文字剧本 (Prompt),描述我们想要的角色和画风

prompt = "a beautiful girl, in red dress, best quality, extremely detailed, dancing in the street"

negative_prompt = "monochrome, lowres, bad anatomy, worst quality, low quality"

print("AI Director is shouting 'Action!', please wait...")

# 7. 开拍!同时输入“文字剧本”和“分镜草图”

image = pipe(

prompt,

negative_prompt=negative_prompt,

image=control_image,

num_inference_steps=20,

).images[0]

# 8. 杀青!保存最终大片

image.save("final_masterpiece.png")

print("It's a wrap! Masterpiece saved as final_masterpiece.png")

在终端中运行这个脚本:python direct_the_show.py

几十秒后,见证奇迹的时刻到了!打开生成的final_masterpiece.png,你会看到:与我们输入的那张简单的“火柴人”骨骼图,完美吻合!

效果对比:

我们成功了!我们不再是只能“许愿”的祈祷者,而是手握画笔和剧本,精准掌控全场的“导演”!

第四章:测评总结与玩法展望:这,才是AIGC的未来!

通过这次极具趣味性的ControlNet实战,我们深刻体会到:

-

创新玩法,触手可及:真正的创新不是高不可攀的技术壁垒,而是那些能切实解决用户痛点、提升创作自由度的应用。ControlNet就是最好的例子,它简单、强大,让AIGC的可用性发生了质的飞跃。

-

CANN**,为复杂应用保驾护航**:如果说运行普通SD是让NPU“百米冲刺”,那么运行ControlNet就是让它进行“铁人三项”。更复杂的模型和计算流,更能凸显CANN对算力的极致调度能力和NPU硬件的性能优势。没有强大的算力平台,这种精密的创作体验将无从谈起。

-

玩法无穷,想象无限:

-

姿态模仿:今天我们用了OpenPose,你可以用自己的照片生成骨骼图,让AI模仿你的任何姿势!

-

线稿上色:使用

Canny(边缘检测)ControlNet模型,你可以将一张黑白线稿,变成一张色彩饱满、细节丰富的插画。 -

室内设计:使用

MLSD(直线检测)ControlNet,你可以画出房间的线条布局,让AI为你生成多种风格的装修效果图。 -

终极组合技:你甚至可以结合LoRA和ControlNet!先用LoRA教会AI画一个特定的人物,再用ControlNet控制这个人物的姿态,实现对内容和形式的双重精准控制!

-

结论:掌握了在昇腾平台上驾驭ControlNet的方法,你才算是真正打开了AIGC创作的大门。这不再是简单的“AI绘画”,而是**“AI辅助创意设计”**。这把被你精准制导的“神笔”,将不再有任何“自由发挥”,它的每一笔,都将是你创意的延伸。

希望这篇全新的实战指南,能真正让你“搞得来”,并点燃你在昇腾AI平台上探索更多高级玩法的热情。去创造吧,现在,你是导演!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)