【AI实战】从0到1开发:基于 DeepSeek + Crawlee 的商业情报 AI Agent 系统

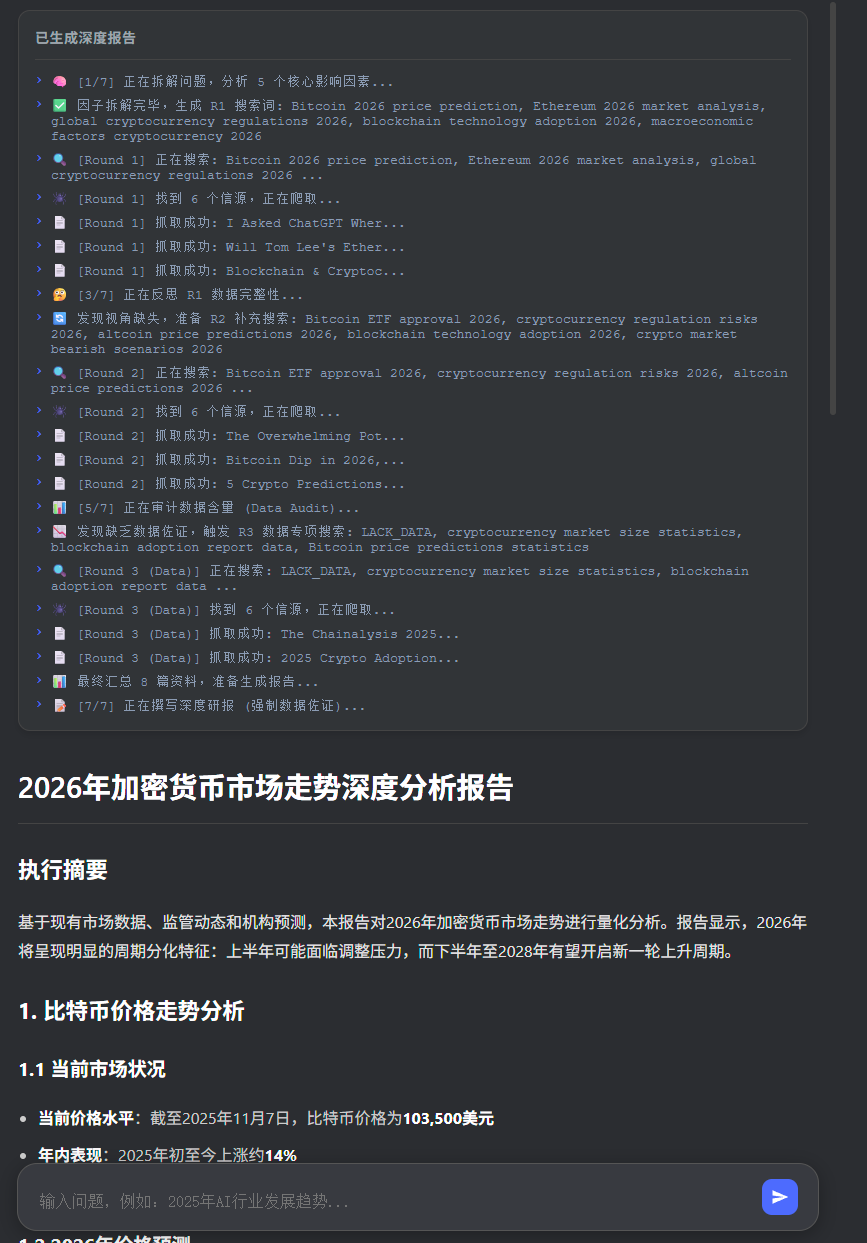

本文介绍了一个AI商业情报Agent系统,通过多轮反思与数据审计机制,将传统搜索升级为闭环分析流程。系统采用7步工作流:问题拆解、广度搜索、逻辑反思、补漏搜索、数据审计、专项数据搜索和研报生成。技术栈选用Node.js+Crawlee实现高效并发爬取,DeepSeek模型进行多轮推理,并采用SSE技术实现实时交互。该系统在2核2G服务器上运行,能自动识别信息缺口并补充数据,最终生成带数据引用的专业

项目背景

目前通用AI不能对一些实时商业事件进行分析,而联网模式得到的回答往往比较宽泛,为了解决这个问题,我利用在上一篇文章介绍的TrendRadar全网热搜聚合项目的工具,独立设计了一个AI商业情报Agent。

它不只是一个搜索工具,它能像人类分析师一样:拆解问题 -> 搜索信息 -> 反思不足 -> 补充搜索 -> 审计数据 -> 输出研报。

🧠 核心工作逻辑(Agent Workflow)

本系统的核心亮点在于引入了“多轮反思与数据审计”机制,将原来单流程搜索过程升级为闭环思考流程。系统运行总共分为 7 个步骤:

-

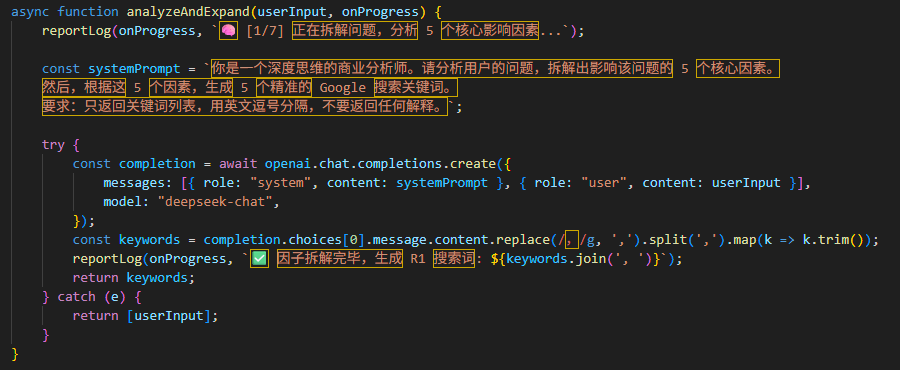

因子拆解 (Factor Analysis):

-

用户输入一个模糊的商业问题(如“2026年美股走势”)。

-

AI 介入,将其拆解为 5 个核心影响因素(如宏观经济、技术面、政策等)。

-

基于因素生成第一组精准搜索关键词。

-

-

第一轮广度搜索 (Round 1):

-

调用 Google Search API 获取链接。

-

使用爬虫并发抓取网页正文,清洗无关标签。

-

-

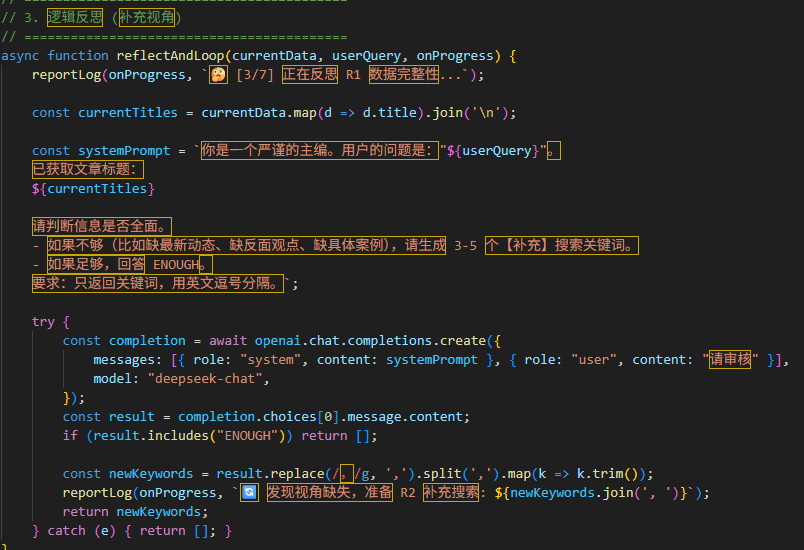

逻辑反思 (Reflection Loop):

-

AI 主编介入,阅读第一轮抓取的文章标题。

-

判断:信息是否全面?是否缺少反面观点或最新动态?

-

决策:如果缺失,生成补充关键词,触发第二轮搜索;如果足够,跳过。

-

-

第二轮补漏搜索 (Round 2):

-

针对缺失的视角进行定向抓取,完善信息拼图。

-

-

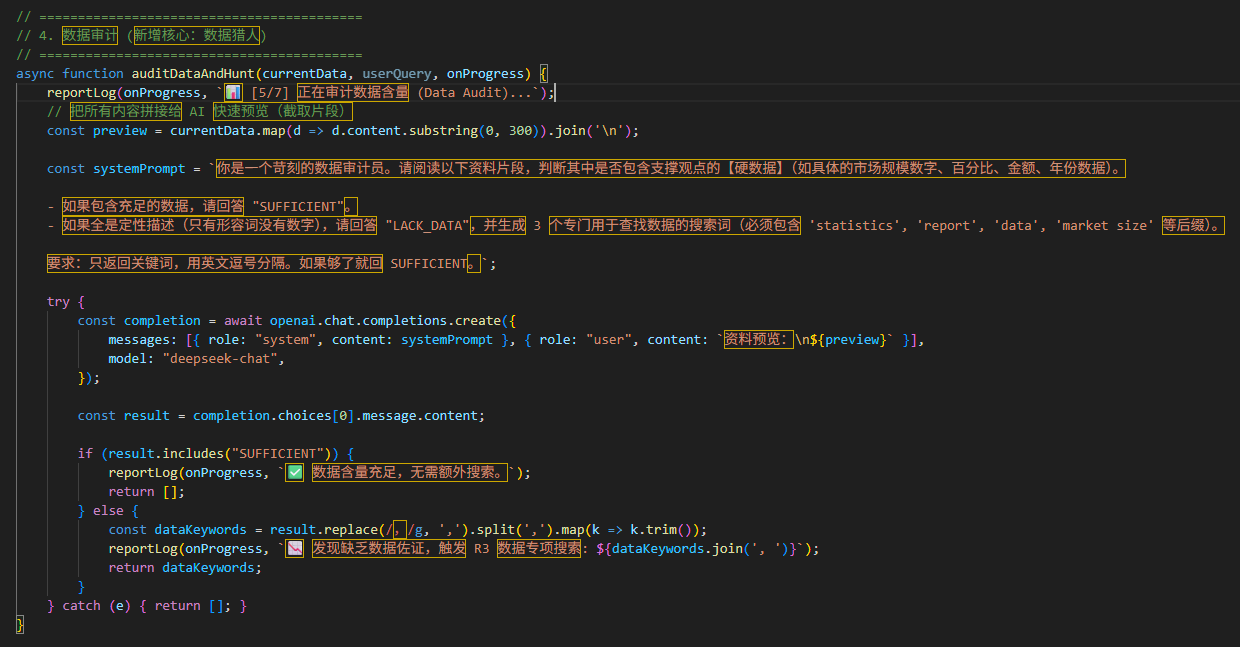

数据审计 (Data Audit - 核心创新):

-

AI 审计员介入,扫描所有已获取的文章内容。

-

判断:文章中是否包含硬核数据(数字、百分比、金额)?

-

决策:如果是“纯定性”描述(全是形容词),触发第三轮“数据猎人”模式,强制生成带

statistics,market size,report后缀的关键词进行专项搜索。

-

-

第三轮数据搜索 (Round 3):

-

专门寻找数据支撑,确保报告“言之有物”。

-

-

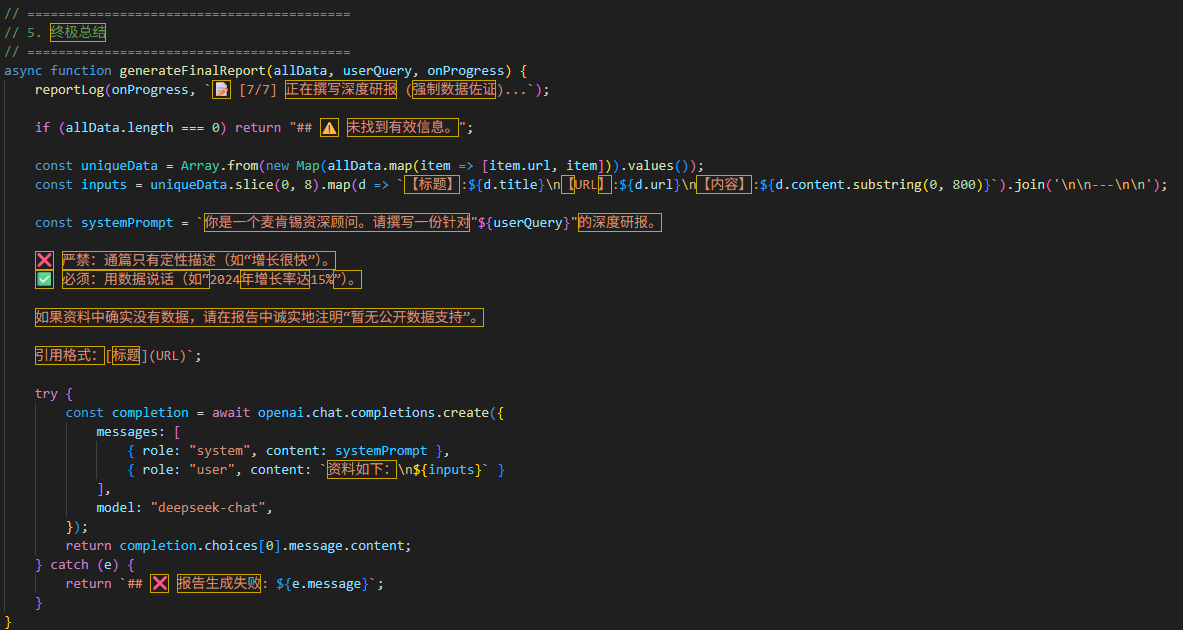

深度研报生成 (Final Report):

-

汇总 3 轮抓取的所有数据(去重)。

-

AI 按照麦肯锡顾问风格撰写报告,强制要求在文中引用数据,并标注来源链接

[标题](URL)。

-

🛠️ 技术栈与工具原

为了在有限的资源(2核 2G 内存服务器)下实现高性能,技术选型极其克制且高效:

1. 后端架构:Node.js + Express

-

选择理由:Node.js 的异步非阻塞特性非常适合处理高并发的 I/O 密集型任务(网络请求、爬虫)。

-

流式传输 (SSE):为了让用户实时感知 AI 的思考过程(类似 DeepSeek 的 UI 体验),后端使用了

Server-Sent Events技术,实时将日志推送到前端,避免 HTTP 超时。

2. 爬虫引擎:Crawlee + Cheerio

-

Crawlee:目前 Node.js 生态最强的爬虫框架,内置了重试机制、反爬策略和并发控制。

-

Cheerio (轻量级):由于服务器内存仅 2GB,我没有使用 Puppeteer (Headless Chrome),而是使用了 Cheerio。它只下载 HTML 源码并解析,内存占用极低,速度极快(毫秒级)。

-

并发控制:将

MAX_CONCURRENCY设为 1,排队抓取,防止内存溢出 (OOM)。

3. 大模型:DeepSeek (via OpenAI SDK)

-

选择理由:DeepSeek V3 在逻辑推理和长文本处理上表现优异,且 API 成本极低,非常适合这种需要多轮调用(Chain of Thought)的 Agent 场景。

-

Prompt Engineering:针对不同步骤设计了 4 套不同的人设(分析师、主编、审计员、顾问)。

4. 搜索源:SerpApi

-

原理:不直接爬取 Google 搜索结果页(容易触发验证码),而是通过 SerpApi 获取结构化的 JSON 数据。

-

网络策略:部署在**阿里云(香港)**服务器,利用其无墙的网络环境,直连全球新闻源。

5. 前端交互:原生 HTML/CSS

-

UI 风格:复刻了 DeepSeek 的深色极客风。

-

实时日志:利用

EventSource监听后端发来的思考步骤,动态渲染折叠式日志卡片。

🛠️ 可进一步完善的点

1、可以加上爬虫工具提供更多的数据支持,尤其是财务的数据

2、目前几轮AI思考都是调用Deepseek,下一步可以扩展不同AI模型

3、优化Prommpt

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)