基于昇腾 AI 处理器的 Ascend C 自定义算子开发实战:从入门到性能调优

Ascend C 为昇腾开发者提供了接近硬件的编程能力,虽有一定学习曲线,但能显著提升算子性能。本文通过两个典型案例,展示了从环境搭建、代码编写到性能调优的完整链路。支持动态 shape 算子(需 Tiling 策略自适应);与 AOE(Ascend Optimization Engine)自动调优结合;构建开源算子库(如 AscendC-Operators)。昇腾生态正快速成熟,掌握 Ascen

一、引言:为何需要自定义算子?

在深度学习框架(如 MindSpore、TensorFlow、PyTorch)中,标准算子库已覆盖大部分常见操作。然而,在以下场景中,自定义算子(Custom Operator)变得不可或缺:

- 模型中包含非标准激活函数或归一化层;

- 需要融合多个小算子以减少 kernel launch 开销;

- 特定领域模型(如科学计算、信号处理)需专用计算逻辑;

- 对性能极度敏感,需针对硬件微架构极致优化。

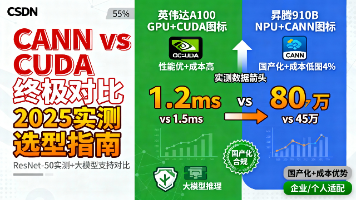

传统方式依赖 CUDA 或 OpenCL 编写 GPU 算子,而在昇腾生态中,Ascend C 成为实现高性能自定义算子的核心工具。它直接映射到达芬奇架构的 AI Core 单元,支持显式控制数据搬运、计算流水与内存布局,是释放昇腾芯片算力的关键技术路径。

本文将基于 CANN 7.0+ 环境,以 Atlas 300I Duo 推理卡 为硬件目标,逐步剖析 Ascend C 算子开发全流程。

二、Ascend C 编程模型基础

2.1 达芬奇架构与 AI Core

昇腾 AI 处理器采用 达芬奇架构(Da Vinci Architecture),其核心计算单元为 AI Core,包含:

- Cube Unit:专用于 INT8/FP16 矩阵乘(如 16×16×16);

- Vector Unit:支持 FP32/FP16/INT32 向量运算(如 Add、Mul、Reduce);

- Scalar Unit:处理控制流与地址计算;

- Unified Buffer (UB):256KB 片上高速缓存,用于暂存中间数据;

- L1/L0 Cache:用于权重或常量缓存。

Ascend C 允许开发者直接操作这些单元,实现计算与数据搬运的精细调度。

2.2 编程范式:Kernel + Tile

Ascend C 采用 单 Kernel 多 Tile 模型:

- Kernel:一个完整的算子执行函数,标注为

__aicore__; - Tile:任务划分的基本单位,每个 Tile 由一个 AI Core 执行;

- 开发者需通过

tile参数指定输入张量的分块策略。

例如,对 shape=[1024] 的向量,可划分为 4 个 tile,每个处理 256 元素。

2.3 内存层级与数据流

Ascend C 要求显式管理三级内存:

| 内存类型 | 容量 | 用途 | 访问方式 |

|---|---|---|---|

| Global Memory | GB 级 | 主存(DDR/HBM) | 通过 DataCopy |

| Unified Buffer | 256 KB | 片上缓存(计算前加载) | LocalTensor |

| Registers | 几 KB | 计算寄存器 | intrinsic 指令 |

典型数据流:Global → UB → Compute → UB → Global

三、开发环境准备

3.1 硬件与软件要求

- 硬件:Atlas 300I/300T/910B 系列(含昇腾 910/310 芯片)

- 操作系统:Ubuntu 22.04 / EulerOS

- CANN 版本:≥ 7.0.RC1(推荐 7.0.Trials 或正式版)

- 开发工具:MindStudio 或命令行(gcc、make、atc)

3.2 环境变量配置(关键)

bash

编辑

export ASCEND_HOME=/usr/local/Ascend

export PATH=$ASCEND_HOME/compiler/ccec_compiler/bin:$PATH

export PYTHONPATH=$ASCEND_HOME/python/site-packages:$PYTHONPATH3.3 项目结构模板

text

编辑

custom_add/

├── src/

│ └── kernel_add.cpp # Ascend C 算子实现

├── host/

│ └── add_op.py # Python 调用接口

├── scripts/

│ ├── build.sh # 编译脚本

│ └── run.sh # 运行脚本

└── CMakeLists.txt四、实战案例一:向量加法(Vector Add)

4.1 算子需求

实现 C = A + B,其中 A、B、C 为一维 FP16 张量,长度 N=1024。

4.2 Ascend C 代码实现(src/kernel_add.cpp)

cpp

编辑

#include "kernel_operator.h"

using namespace AscendC;

constexpr int32_t BUFFER_NUM = 2; // Double buffering

constexpr int32_t BLOCK_LENGTH = 256; // 每个 tile 处理 256 元素

// Kernel 入口函数

extern "C" __global__ __aicore__ void CustomAdd(

uint32_t totalLength,

half* inputA,

half* inputB,

half* outputC)

{

// 初始化 pipe

Pipe pipe;

pipe.InitBuffer(pipe, BUFFER_NUM, BLOCK_LENGTH * sizeof(half));

// 创建 LocalTensor(UB 中的数据视图)

LocalTensor<half> bufA[2], bufB[2], bufC[2];

for (int i = 0; i < BUFFER_NUM; i++) {

bufA[i] = LocalTensor<half>(pipe, BUFFER_NUM, BLOCK_LENGTH);

bufB[i] = LocalTensor<half>(pipe, BUFFER_NUM, BLOCK_LENGTH);

bufC[i] = LocalTensor<half>(pipe, BUFFER_NUM, BLOCK_LENGTH);

}

// 计算当前 tile 的起始偏移

uint32_t blockId = GetBlockId();

uint32_t stride = BLOCK_LENGTH * GetBlockNum();

uint32_t offset = blockId * BLOCK_LENGTH;

// Double Buffering 主循环

for (uint32_t loop = 0; loop < (totalLength + stride - 1) / stride; loop++) {

int32_t processLen = (offset + BLOCK_LENGTH <= totalLength) ? BLOCK_LENGTH : (totalLength - offset);

if (processLen <= 0) break;

// Stage 1: 从 Global 加载 A 和 B 到 UB

DataCopy(bufA[loop % BUFFER_NUM], inputA + offset, processLen);

DataCopy(bufB[loop % BUFFER_NUM], inputB + offset, processLen);

// Stage 2: 执行向量加法(Vector Unit)

Add(bufC[loop % BUFFER_NUM], bufA[loop % BUFFER_NUM], bufB[loop % BUFFER_NUM], processLen);

// Stage 3: 将结果写回 Global

DataCopy(outputC + offset, bufC[loop % BUFFER_NUM], processLen);

offset += stride;

}

}4.3 编译脚本(scripts/build.sh)

bash

编辑

#!/bin/bash

KERNEL_NAME="CustomAdd"

SRC_DIR="../src"

OUT_DIR="../out"

mkdir -p $OUT_DIR

# 使用 aic 编译器生成 .o 文件

aic -S $SRC_DIR/kernel_add.cpp \

-o $OUT_DIR/${KERNEL_NAME}.o \

--target=Ascend910 \

--ccec-options="-O2 -g"

echo "Build success: ${KERNEL_NAME}.o"4.4 Python 调用接口(host/add_op.py)

python

编辑

import numpy as np

from mindspore import ops, Tensor

import acl

# 注册自定义算子(简化版,实际需 .json 描述文件)

def custom_add(a, b):

c = np.empty_like(a)

# 此处省略 ACL 调用细节,实际需使用 acl.rt.memcpy + kernel launch

# 可参考 CANN Samples 中的 custom_op 示例

return Tensor(c)

# 测试

a = Tensor(np.random.rand(1024).astype(np.float16))

b = Tensor(np.random.rand(1024).astype(np.float16))

c = custom_add(a, b)

print("Result shape:", c.shape)💡 注:完整调用需配合

acl.json算子描述文件与 ACL(Ascend Computing Language)API,此处为简化示意。

五、实战案例二:矩阵乘法(GEMM)

5.1 挑战与优化思路

矩阵乘 C = A × B(M×K × K×N)是计算密集型操作。在 Ascend C 中,应优先使用 Cube Unit 实现 FP16 GEMM。

关键策略:

- 分块(Tiling):将大矩阵划分为 16×16 子块;

- 数据预加载:提前将 A、B 块搬入 UB;

- 流水线:计算当前块的同时加载下一块。

5.2 核心代码片段(伪实现)

cpp

编辑

// 在 Kernel 中

LocalTensor<half> a_frag = ...; // 16x16

LocalTensor<half> b_frag = ...; // 16x16

LocalTensor<half> c_frag = ...; // 16x16

// 使用 Cube 指令

MatMul(c_frag, a_frag, b_frag, false, false); // alpha=1, beta=0完整实现较复杂,建议参考官方 GEMM 示例。

六、性能分析与调优

6.1 常见瓶颈

| 瓶颈类型 | 表现 | 解决方案 |

|---|---|---|

| 内存带宽不足 | 计算单元空闲 | 增大 tile size,减少搬运次数 |

| Bank Conflict | UB 访问延迟高 | 数据对齐(128B/256B) |

| 计算利用率低 | Cube/Vector 未满载 | 调整分块策略,避免尾块 |

| 同步开销大 | 多 tile 间等待 | 减少 barrier 使用 |

6.2 使用 msadvisor 分析

bash

编辑

msadvisor --collect=on --output=./profile ./run_custom_add

msadvisor --analyze --input=./profile输出将显示:

- 计算单元利用率(Cube Utilization)

- 内存带宽使用率

- 数据搬运耗时占比

七、调试技巧与常见错误

7.1 调试方法

- 日志输出:Ascend C 不支持

printf,可通过写回特殊内存地址间接输出; - 模拟器运行:使用

sim模式验证逻辑正确性; - 小规模测试:先用 N=16 验证,再扩展到大尺寸。

7.2 典型错误

| 错误现象 | 原因 | 修复建议 |

|---|---|---|

| Segmentation Fault | 越界访问 Global Mem | 检查 offset 与 length |

| 结果全零或 NaN | UB 未初始化或数据类型不匹配 | 确保 half/float 一致 |

| Kernel Hang | 死锁或无限循环 | 检查 loop 条件 |

| 性能远低于预期 | 未启用 Cube 或流水线断裂 | 使用 MatMul intrinsic |

八、与 MindSpore 集成

在 MindSpore 中注册自定义算子需三步:

- 编写

.cc和.cu(此处为.cpp); - 创建

op_info.json描述输入输出、dtype、shape 推导; - 使用

Custom算子在网络中调用:

python

编辑

from mindspore.ops import Custom

add_op = Custom(

"CustomAdd",

out_shape=lambda a, b: a,

out_dtype=lambda a, b: a,

func_type="aot", # Ahead-of-Time 编译

reg_info="./custom_add.json"

)

class Net(nn.Cell):

def construct(self, x, y):

return add_op(x, y)九、总结与展望

Ascend C 为昇腾开发者提供了接近硬件的编程能力,虽有一定学习曲线,但能显著提升算子性能。本文通过两个典型案例,展示了从环境搭建、代码编写到性能调优的完整链路。

未来方向包括:

- 支持动态 shape 算子(需 Tiling 策略自适应);

- 与 AOE(Ascend Optimization Engine)自动调优结合;

- 构建开源算子库(如 AscendC-Operators)。

昇腾生态正快速成熟,掌握 Ascend C 将成为 AI 芯片时代的核心竞争力之一。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

————————————————

版权声明:本文为CSDN博主「锦力了」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/2503_94301521/article/details/155245360

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)