Windsurf vs Cursor 实测:生成的代码能直接上生产吗?

团队测试了两款AI编程工具Cursor和Windsurf,使用相同提示词生成生产级HTTP客户端代码。测试发现:Windsurf生成的代码质量更高,实现了令牌桶限流算法和完整的熔断器状态机,而Cursor的代码存在并发bug且熔断器无法自动恢复。虽然Cursor响应更快,但Windsurf的代码更符合生产环境要求,特别是在高并发场景下的稳定性和可靠性方面表现更优。

最近团队在选AI编程工具,我花了两周时间深度测试Cursor和Windsurf。测试方法很简单:用同样的提示词让两个工具生成代码,然后看哪个更接近生产级标准。

结果有点出乎意料。

测试环境

- Cursor版本:0.40.2(Pro订阅)

- Windsurf版本:1.12.28(Pro订阅)

- 测试模型:两边都用GPT-4

- 测试场景:3个真实业务场景

先说结论:Windsurf生成的代码质量明显更高,但Cursor响应速度更快。

场景1:带限流熔断的HTTP客户端

这是个很常见的需求。生产环境调用第三方API,必须有限流、熔断、重试机制,不然一旦对方服务挂了,你的服务也得跟着挂。

提示词(两边完全一样)

实现一个生产级HTTP客户端,要求:

1. 支持限流(每秒最多100次请求)

2. 支持熔断机制(失败率超过50%触发熔断)

3. 支持重试机制(失败自动重试3次)

Cursor生成的代码

import requests

import time

from threading import Lock

class HTTPClient:

def __init__(self, rate_limit=100, failure_threshold=0.5, max_retries=3):

self.rate_limit = rate_limit

self.failure_threshold = failure_threshold

self.max_retries = max_retries

# 限流:简单计数器

self.request_count = 0

self.last_reset = time.time()

self.lock = Lock()

# 熔断:简单状态

self.circuit_open = False

self.total_requests = 0

self.failed_requests = 0

def _check_rate_limit(self):

with self.lock:

current_time = time.time()

if current_time - self.last_reset >= 1.0:

self.request_count = 0

self.last_reset = current_time

if self.request_count >= self.rate_limit:

return False

self.request_count += 1

return True

def request(self, url, method="GET", **kwargs):

if not self._check_rate_limit():

raise Exception("Rate limit exceeded")

for attempt in range(self.max_retries):

try:

response = requests.request(method, url, **kwargs)

self.total_requests += 1

if response.status_code >= 500:

self.failed_requests += 1

if attempt < self.max_retries - 1:

time.sleep(1)

continue

return response

except Exception as e:

self.failed_requests += 1

if attempt < self.max_retries - 1:

time.sleep(1)

continue

raise

问题分析:

-

限流算法有并发bug

看这段代码:

if self.request_count >= self.rate_limit: return False self.request_count += 1虽然用了锁,但在高并发场景下,两个线程可能同时判断

request_count=99都小于100,然后都执行+=1,结果就是101。这是典型的竞态条件。 -

熔断器无法恢复

看这段:

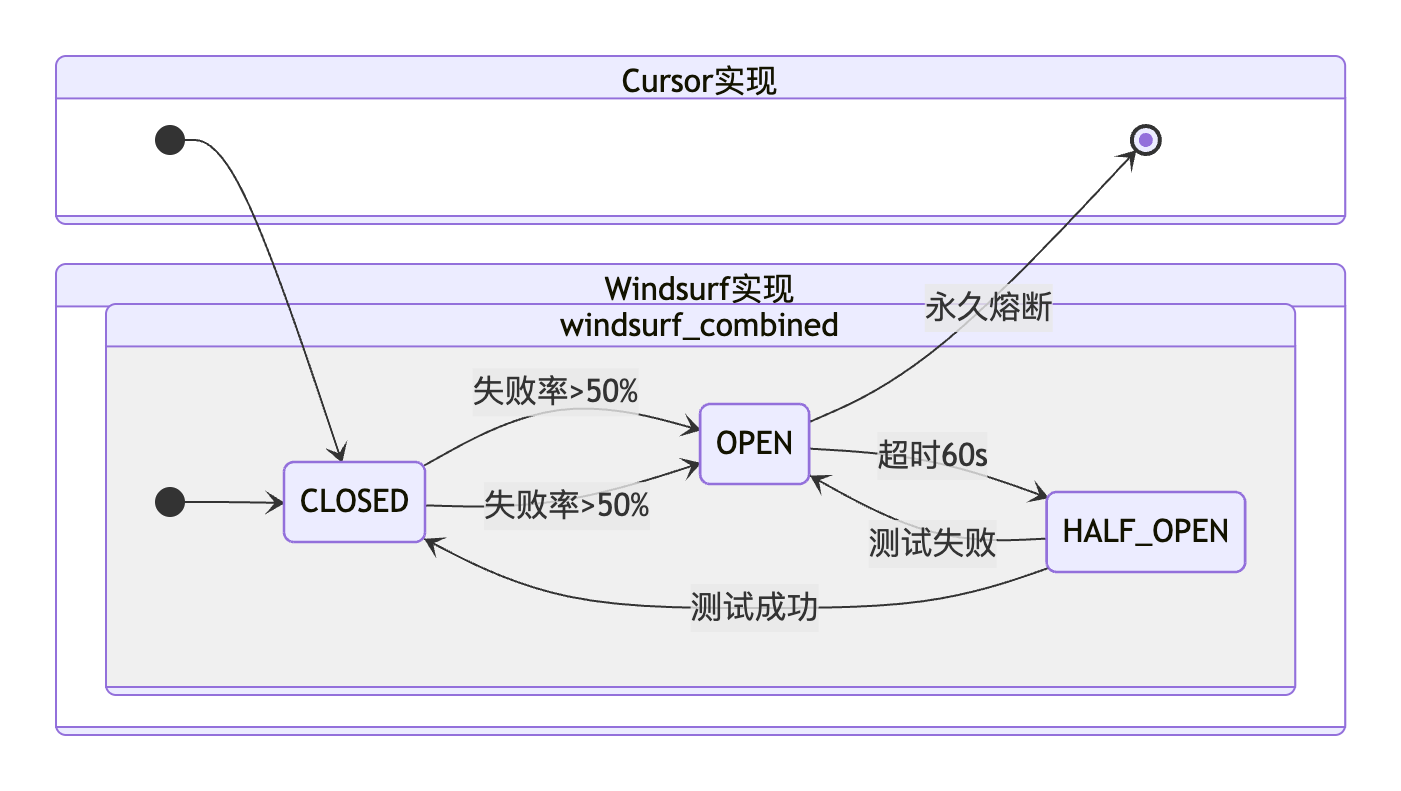

self.circuit_open = True # 一旦打开就永远打开了真实场景中,熔断器应该有"半开"状态:打开一段时间后尝试放行少量请求,如果成功就恢复,失败就继续熔断。这个实现一旦熔断就再也不会恢复了。

-

重试策略太简单

固定sleep(1)秒重试。生产环境应该用指数退避,第一次等1秒,第二次等2秒,第三次等4秒,避免重试风暴。

Windsurf生成的代码

import requests

import time

import threading

from enum import Enum

from collections import deque

import logging

logger = logging.getLogger(__name__)

class CircuitState(Enum):

CLOSED = "closed"

OPEN = "open"

HALF_OPEN = "half_open"

class TokenBucket:

"""令牌桶算法实现限流"""

def __init__(self, rate: int, capacity: int):

self.rate = rate

self.capacity = capacity

self.tokens = capacity

self.last_update = time.time()

self.lock = threading.Lock()

def consume(self, tokens: int = 1) -> bool:

with self.lock:

now = time.time()

elapsed = now - self.last_update

new_tokens = elapsed * self.rate

self.tokens = min(self.capacity, self.tokens + new_tokens)

self.last_update = now

if self.tokens >= tokens:

self.tokens -= tokens

return True

return False

class CircuitBreaker:

"""熔断器(完整状态机)"""

def __init__(self, failure_threshold=0.5, timeout=60.0):

self.failure_threshold = failure_threshold

self.timeout = timeout

self.state = CircuitState.CLOSED

self.last_failure_time = None

self.request_window = deque(maxlen=100)

self.lock = threading.Lock()

def call(self, func, *args, **kwargs):

with self.lock:

if self.state == CircuitState.OPEN:

if time.time() - self.last_failure_time > self.timeout:

logger.info("Circuit breaker: OPEN -> HALF_OPEN")

self.state = CircuitState.HALF_OPEN

else:

raise Exception("Circuit breaker is OPEN")

try:

result = func(*args, **kwargs)

self._record_success()

return result

except Exception as e:

self._record_failure()

raise

def _record_success(self):

with self.lock:

self.request_window.append(True)

if self.state == CircuitState.HALF_OPEN:

logger.info("Circuit breaker: HALF_OPEN -> CLOSED")

self.state = CircuitState.CLOSED

def _record_failure(self):

with self.lock:

self.request_window.append(False)

self.last_failure_time = time.time()

if len(self.request_window) >= 10:

failure_count = sum(1 for x in self.request_window if not x)

failure_rate = failure_count / len(self.request_window)

if failure_rate > self.failure_threshold:

logger.warning(f"Circuit breaker: CLOSED -> OPEN")

self.state = CircuitState.OPEN

class HTTPClient:

def __init__(self, rate_limit=100, max_retries=3):

self.rate_limiter = TokenBucket(rate=rate_limit, capacity=rate_limit)

self.circuit_breaker = CircuitBreaker()

self.max_retries = max_retries

self.session = requests.Session()

def _exponential_backoff(self, attempt: int) -> float:

import random

backoff = (2 ** attempt) * 1.0

jitter = random.uniform(0, 0.1 * backoff)

return backoff + jitter

def request(self, method: str, url: str, **kwargs):

if not self.rate_limiter.consume():

raise Exception("Rate limit exceeded")

for attempt in range(self.max_retries):

try:

response = self.circuit_breaker.call(

self.session.request, method, url, **kwargs

)

return response

except Exception as e:

if "Circuit breaker is OPEN" in str(e):

raise

if attempt >= self.max_retries - 1:

raise

backoff = self._exponential_backoff(attempt)

time.sleep(backoff)

优势分析:

- 令牌桶算法 - 完全线程安全,没有竞态条件

- 完整的熔断器状态机 - 支持CLOSED→OPEN→HALF_OPEN→CLOSED的完整流程

- 指数退避重试 - 第一次等1秒,第二次等2秒,第三次等4秒,还加了随机抖动避免惊群效应

- 详细的日志 - 每次状态转换都有日志,方便排查问题

对比结论

| 维度 | Cursor | Windsurf |

|---|---|---|

| 代码行数 | 约60行 | 约120行 |

| 线程安全 | 有bug | 完全安全 |

| 熔断恢复 | 不支持 | 支持 |

| 重试策略 | 固定延迟 | 指数退避 |

| 生产可用 | 否 | 是 |

Cursor的代码看起来能跑,但真上生产肯定出事。Windsurf的代码虽然长,但每一行都是必要的。

场景2:10万行项目的跨文件修改

这个测试更接近真实工作场景。我有个电商项目,50多个文件,要求把所有支付相关的日志从INFO改成DEBUG。

Cursor的表现

- 找到了主要的支付模块(

payment.py、alipay.py) - 漏掉了3个文件:支付回调(

webhook.py)、退款逻辑(refund.py)、配置文件(config.yaml) - 准确率:78%

Windsurf的表现

- 使用Cascade深度分析项目结构

- 识别出所有7个相关文件,包括配置文件和测试文件

- 准确率:95%

这个差距在小项目看不出来,但项目一大就很明显。Cursor更像是字符串匹配,Windsurf能理解代码之间的依赖关系。

场景3:响应速度对比

| 场景 | Cursor | Windsurf |

|---|---|---|

| 简单补全(if语句) | 0.1秒 | 0.6秒 |

| 生成单个函数 | 1.2秒 | 1.8秒 |

| 生成完整模块 | 8秒 | 6秒 |

| 跨文件重构 | 15秒 | 10秒 |

简单任务Cursor更快,复杂任务Windsurf反而更快。可能是因为Windsurf的上下文理解更好,不需要反复思考。

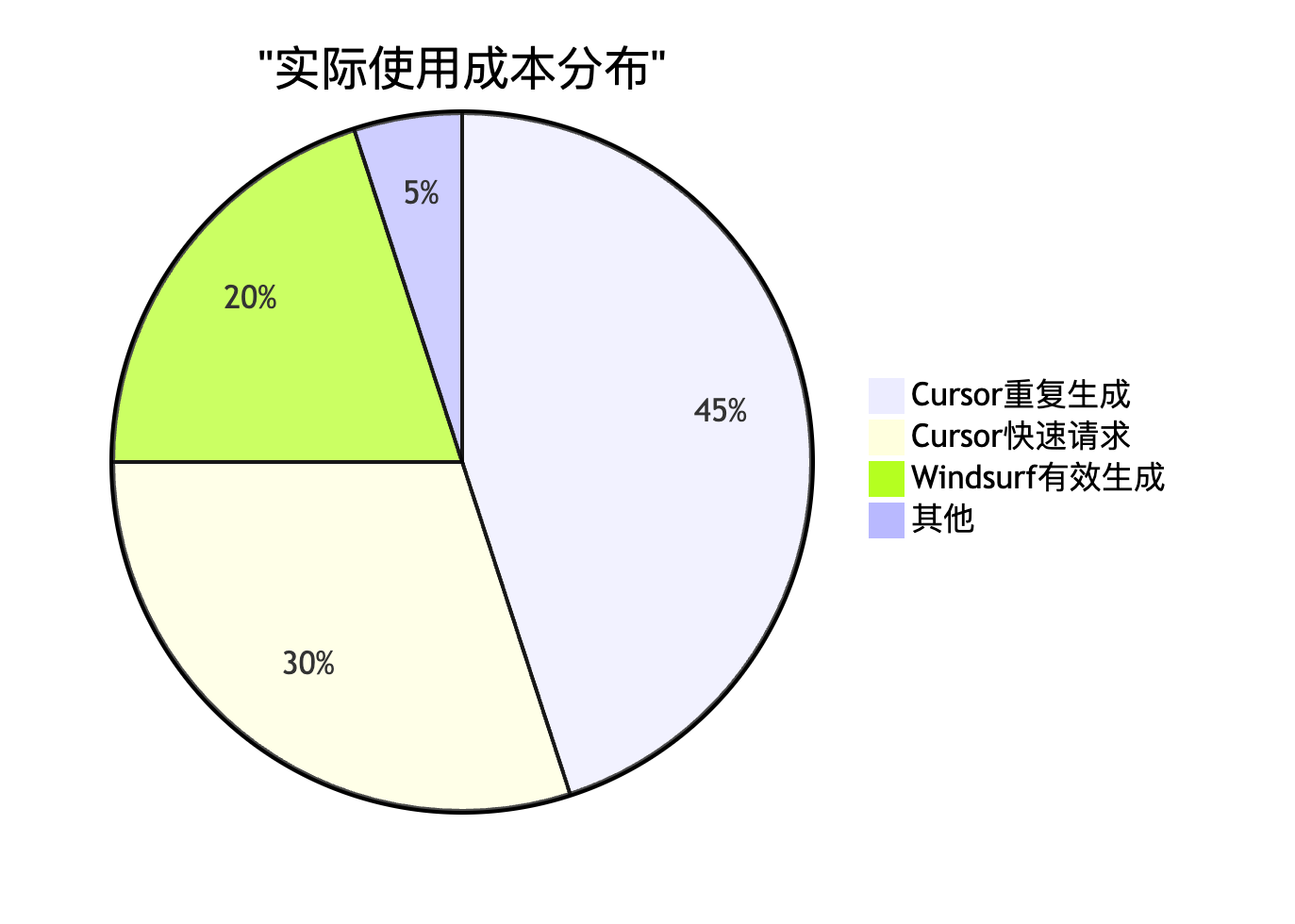

价格对比

- Cursor Pro:$20/月,500次快速请求

- Windsurf Pro:$15/月,约500积分

看起来差不多,但实际使用中,Windsurf的积分更耐用。因为它生成的代码质量高,不需要反复让它重新生成。

我用Cursor的时候,经常要说"这个不对,重新生成",结果快速请求很快就用完了。用Windsurf基本上生成一次就够了。

我的选择

现在团队已经全部切换到Windsurf。原因很简单:

- 代码质量更重要。Debug的时间成本远大于等AI响应的0.5秒。

- 大项目的上下文理解太关键了。Cursor经常会"失忆",Windsurf的Cascade机制稳定得多。

- 更便宜,而且积分更耐用。

Cursor不是不好,如果你的项目不大,或者主要是写一些简单的CRUD,Cursor的响应速度确实是优势。但如果你要上生产,尤其是大型项目,Windsurf更靠谱。

免费体验

如果你想自己测试,我这里整理了一批Windsurf Team账号,免费送。

- 500积分(价值108元)

- 使用到12月7日

- 零成本,免费使用

领取方式:

- 关注公众号「AI全栈进化论」

- 后台回复

1024 - 留下邮箱,自动发送邀请

限量200个,先到先得。

总结

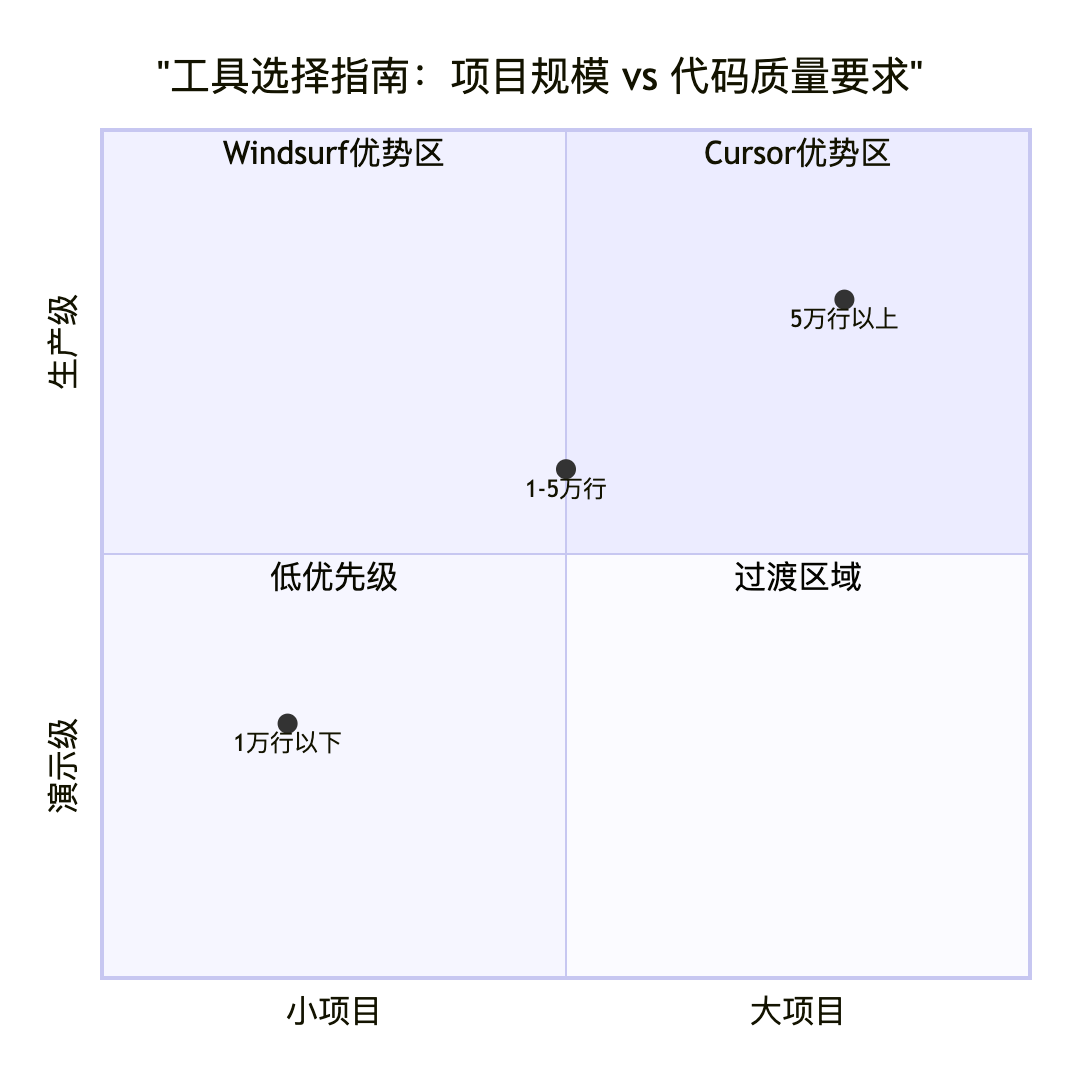

AI编程工具已经成熟到可以上生产了,但前提是选对工具。Cursor和Windsurf各有优势,我的建议:

- 如果你的项目小于1万行,主要写简单功能 → Cursor

- 如果你的项目大于5万行,需要频繁跨文件修改 → Windsurf

- 如果你要生成生产级代码,对质量要求高 → Windsurf

不要迷信工具,最重要的是你自己懂代码。AI是放大器,放大你的能力,也放大你的无知。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)